作者:王顺 Google Cloud AI 专家

美国时间 2021 年 5 月 18-20 日,Google I/O 2021 成功举办。在这次活动中,Google 带来了各种开发者关注的干货内容和产品资讯。同时 Google Cloud 这次也带来了很多创新主题的分享,特别是最新的 AI 技术。本期内容将围绕包括 Vertex AI、TPU v4、LaMDA、MUM 四个技术要点为大家进行深度剖析。

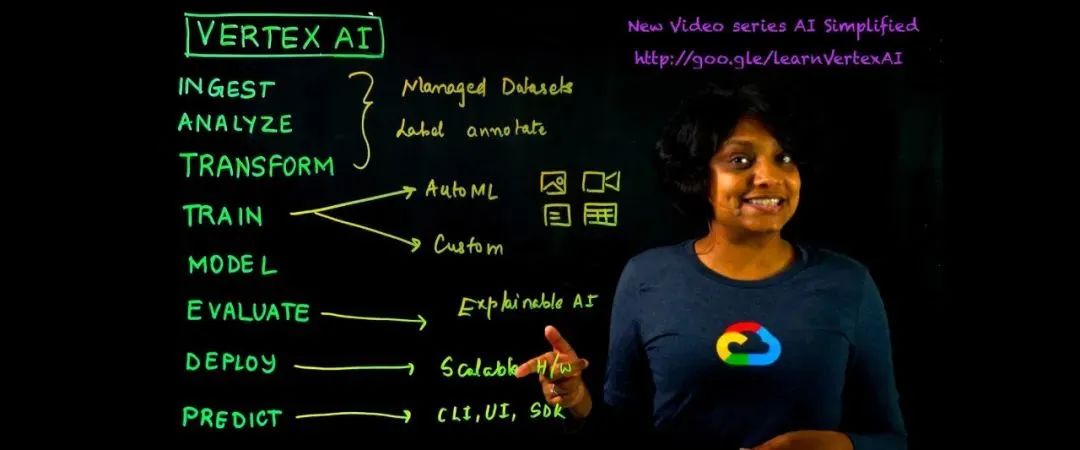

Vertex AI

Vertex AI 是 Google Cloud 上统一的托管机器学习平台,帮助企业进行 AI 训练、多组实验管理和加速模型的部署。

在此之前 Google Cloud 已经提供了用于自定义模型训练的 AI 平台 (AI Platform) 和 AutoML 产品,比如 AutoML Vision,AutoML Tables,AutoML Natural Language 等。但是用户在使用 AutoML 训练和自定义训练需要和两套不同的工具分别进行交互。

Vertex AI 统一了上述的两套工具,通过一套工具即可无缝管理和部署模型,无论是使用 UI、API 还是不同语言的 SDK,这套工具可以帮助您训练、预测、访问 AutoML Tables、AutoML Vision、AutoML Video Intelligence、AutoML Natural Language、可解释 AI 以及数据标注等等服务。上述的这一组服务被作为各种特性被统一到了这次重磅推出的 Vertex AI ——统一的 AI 平台,即 AI Platform(Unified)。

ML Ops

ML Ops 作为一个新兴的领域,在社区中迅速发展,因为它提供了端到端的机器学习开发流程。帮助设计、构建和管理可复用、可测试和可进化的 ML 驱动的软件。Vertex AI 就提供了以下出众的 ML Ops 功能:

● Vertex Experiments——跟踪、分析和发现 ML 实验以加快模型的选择。

● Vertex Vizier——为超参调优提供优化值,以最大化模型预测的精度。

● Vertex Pipelines——简化了 ML 流水线的构建和运行,进而简化 ML Ops。

● Explainable AI——可解释 AI 为您提供详细的模型评估指标和特征属性,帮助了解每个输入特征对于预测的重要性。

端到端的全生命周期管理

Vertex AI 管理 ML 流水线的工作流程可以归纳为以下几个阶段:

● 定义并上传数据

● 使用 AutoML 或指定 GPU 机型进行自定义训练

● 获得模型评估和超参调优

● 使用数据标注服务为自定义训练模型数据集请求人工标注

● 在 Vertex AI 中上传和存储您的模型

● 部署模型并获得用于预测的端点 (endpoint)

● 发送预测请求

● 在端点中指定预测流量的拆分规则

● 管理您的模型和端点

ML 模型只有在您将其实际投入生产时才具有价值。Vertex AI 以开发人员为中心并统一 ML 体验的多种特性的发布,会大大简化流水线的构建和模型的部署与管理进而帮助企业更专注于业务并提高效率。访问 Vertex AI 页面了解新的特性和快速上手。

TPU v4

本文介绍了Google I/O 2021大会上Google Cloud的最新AI技术,包括统一的机器学习平台Vertex AI,新一代TPU v4的性能提升,以及LaMDA和MUM模型在自然语言理解和多模态理解的突破。Vertex AI实现了ML Ops的端到端管理,TPU v4在算力上有了显著增强,LaMDA和MUM则展示了在对话和信息理解上的卓越能力。

本文介绍了Google I/O 2021大会上Google Cloud的最新AI技术,包括统一的机器学习平台Vertex AI,新一代TPU v4的性能提升,以及LaMDA和MUM模型在自然语言理解和多模态理解的突破。Vertex AI实现了ML Ops的端到端管理,TPU v4在算力上有了显著增强,LaMDA和MUM则展示了在对话和信息理解上的卓越能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4257

4257

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?