一.spark的安装与配置

scala的下载

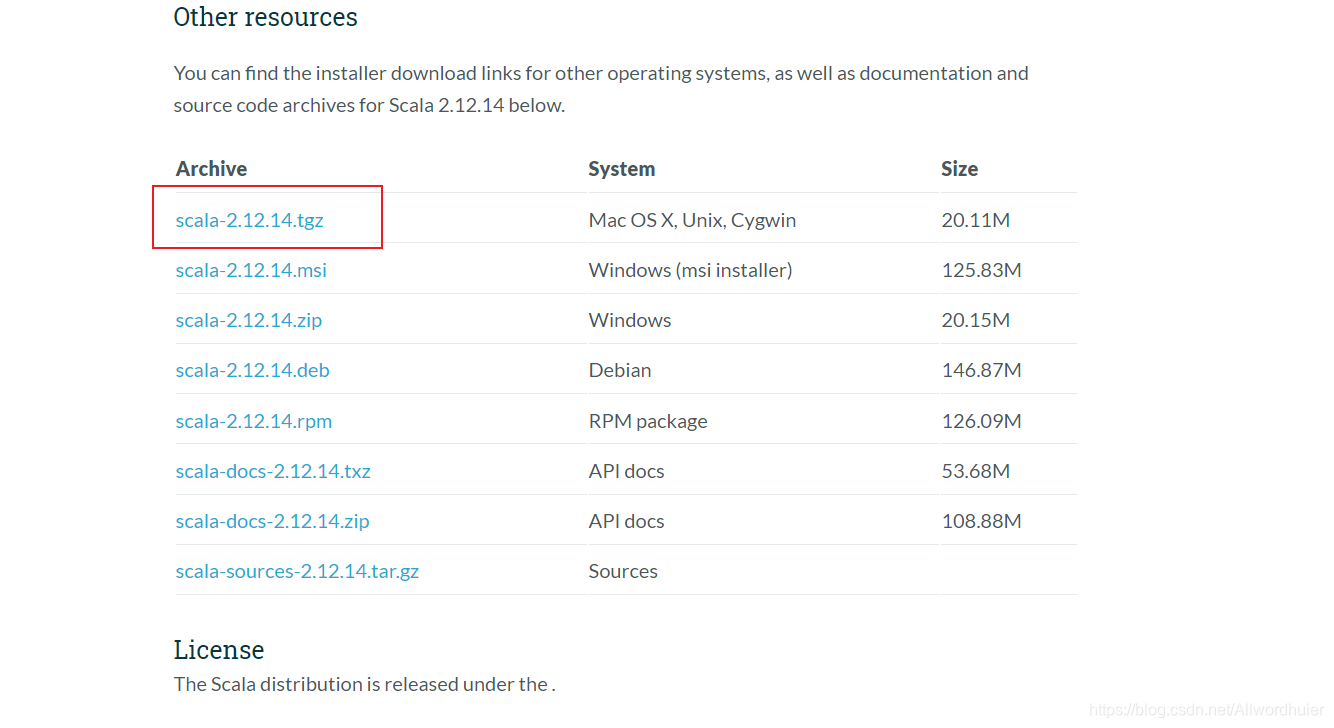

下载地址为:scala下载地址

1.启动hadoop(搭建高可用集群的一起启动

(1)启动Zookeeper(三台虚拟机都进行)

zkServer.sh start

(2)启动journalnode(三台虚拟机都进行)

hadoop-daemon.sh start journalnode

(3)启动Hadoop以及jps查看进程

start-all.sh

jps

2.scala安装与部署

(1)安装包的解压(并移动到指定位置)

[root@hadoop1 ~]# tar -zxvf scala-2.12.14.tgz

[root@hadoop1 ~]# mv scala-2.12.14 /export/software/(2)环境变量的配置

在命令行中输入如下命令,打开profile配置文件

[root@hadoop1 ~]# vi /etc/profile

export SCALA_HOME=/export/software/scala-2.12.14 export PATH=$PATH:$SCALA_HOME/bin:$PATH

然后再命令行中输入source /etc/profile使环境变量生效。

source /etc/profile测试scala安装 scala -version

在命令行输入scala,能进入scala命令行说明安装成功.:quit

二、spark的安装与配置

1.spark的安装

和Scala的安装与配置一样,先进行解压(并移动到指定位置),然后打开profie文件配置环境变量

[root@hadoop1 ~]# tar -zxvf spark-2.1.0-bin-hadoop2.4.tgz

[root@hadoop1 ~]# mv spark-2.1.0-bin-hadoop2.4 /export/software/export SPARK_HOME=/export/software/spark-2.1.0-bin-hadoop2.4

export PATH=$PATH::$SPARK_HOME/bin:$PATH

:wq

source /etc/profile2.配置conf/spark-env.sh 文件

[root@hadoop1 ~]# cd /export/software/spark-2.1.0-bin-hadoop2.4/

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# ls

bin data jars licenses python README.md sbin

conf examples LICENSE NOTICE R RELEASE yarn

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# cd conf/

[root@hadoop1 conf]# ls

docker.properties.template metrics.properties.template spark-env.sh.template

fairscheduler.xml.template slaves.template

log4j.properties.template spark-defaults.conf.template

[root@hadoop1 conf]#

3进入到conf目录下会发现spark-env.sh为临时文件,须重命名为spark-env.sh

[root@hadoop1 conf]# mv spark-env.sh.template spark-env.sh在文件中加入如下内容:

[root@hadoop1 conf]# vi spark-env.shexport SCALA_HOME=/export/software/scala-2.12.14

export JAVA_HOME=/export/software/jdk1.8.0_161

export SPARK_WORK_MEMORY=4g

export SPARK_MASTER_IP=hadoop1

export MASTER=spark://hadoop1:7077

参数解释:

SPARK_WORK_MEMORY 决定在每一个Worker节点上可用的最大内存,增加这个数可以在内存中缓存更多数据,但一定要给Slave的操作系统和其他服务预留足够内存

SPARK_MASTER_IP 参数可以是具体的IP地址也可以是hostname,系统会更具hosts文件进行解析

MASTER 配置端口号

PS:SPARK_MASTER_IP和MASTER必须配置否则会造成Slave无法注册主机错误

配置conf/slaves 文件 将节点的主机名加入到slaves文件中

[root@hadoop1 conf]# mv slaves.template slaves

[root@hadoop1 conf]# vi slaves

hadoop1

hadoop2

hadoop34.启动Spark集群

在启动前,将scala文件、spark文件以及etc目录下的profile文件传给slave1和slave2,并在slave1和slave2命令行中输入source /etc/profile使环境变量生效

进入spark目录下,输入如下命令:

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# scp -r /export/software/spark-2.1.0-bin-hadoop2.4 hadoop2:/export/software/

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# scp -r /export/software/spark-2.1.0-bin-hadoop2.4 hadoop3:/export/software/

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# scp -r /etc/profile hadoop2:/etc/

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# scp -r /etc/profile hadoop3:/etc/

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# sbin/start-all.sh

至此spark的安装结束,也已成功启动,如需停止,输入如下命令:

[root@hadoop1 spark-2.1.0-bin-hadoop2.4]# sbin/stop-all.sh

6132

6132

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?