1 kettle 介绍

kettle(水壶)是一个 免费开源的 Extract-Transform-Load (ETL) 工具 ,被 Pentaho 集团收购,并更名为 Pentaho Data Integration (PDI ) 当中又包含了四大厨房厨具相关的扮演了重要角色的模块,它们分别是Spoon(勺子),Pan(平底锅),Kitchen(厨房),Carte(菜单)

- Spoon.sh 图形化工具,用于快速编辑、维护工作流桌面工具

特点:拖拖拽拽,简单方便,容易上手 - Pan.sh 在开发调试阶段我们常常用Spoon,实际应用中我们常常要用命令行去执行作业或转换, Pan用于执行转换

- Kitchen.sh Kitchen用于执行作业 带时间调度的

- chef.sh 创建任务(Job) 任务通过允许每个转换,任务,脚本等等

- Carte.sh carte是一个轻量级的web容器,用于建立专用、远程的ETL Server,主要是为集群的使用而生,其中一台carte作为主服务器,其他的Carte服务器作为子服务器 共同作业

pan.sh -file=ods_coupon_settle_detail.ktr -level=Detailed

2 认清 kettle

PDI(kettle) 只是 Pentaho service 中的一个组件 ,pentaho 有多个组件

| Tool/Plugin | Location |

|---|---|

| Pentaho 服务器 | pentaho/server/pentaho-server/ |

| 报表设计器 | pentaho/design-tools/report-designer/ |

| 设计工作台 | pentaho/design-tools/schema-workbench/ |

| 数据集成 (Spoon) | pentaho/design-tools/data-integration/ |

| 元数据编辑器 | pentaho/design-tools/metadata-editor/ |

| 聚合设计器r | pentaho/design-tools/aggregation-designer/ |

| 仪表板设计器 | pentaho/server/pentaho-server/pentaho-solutions/system/dashboards/ |

| 分析平台 | pentaho/server/pentaho-server/pentaho-solutions/system/analyzer/ |

| 交互式报告 | pentaho/server/pentaho-server/pentaho-solutions/system/pentaho-interactive-reporting/ |

| 许可证安装程序 | pentaho/license-installer/ |

其中我们 平时用到最多还是 data-integration 数据集成 ,目前最新的应该到了9.3版本

3 与hadoop 集成

以 PDI 9.3为例子

- 下载 KAR驱动 找到对应版本的KAR包下载,例如 Pentaho Hadoop Shims Emr521 KAR

- 下载 Hadoop 相关配置文件到本地 例如 core-site.xml/hdfs-site.xml/hive-site.xml/yarn-site.xml

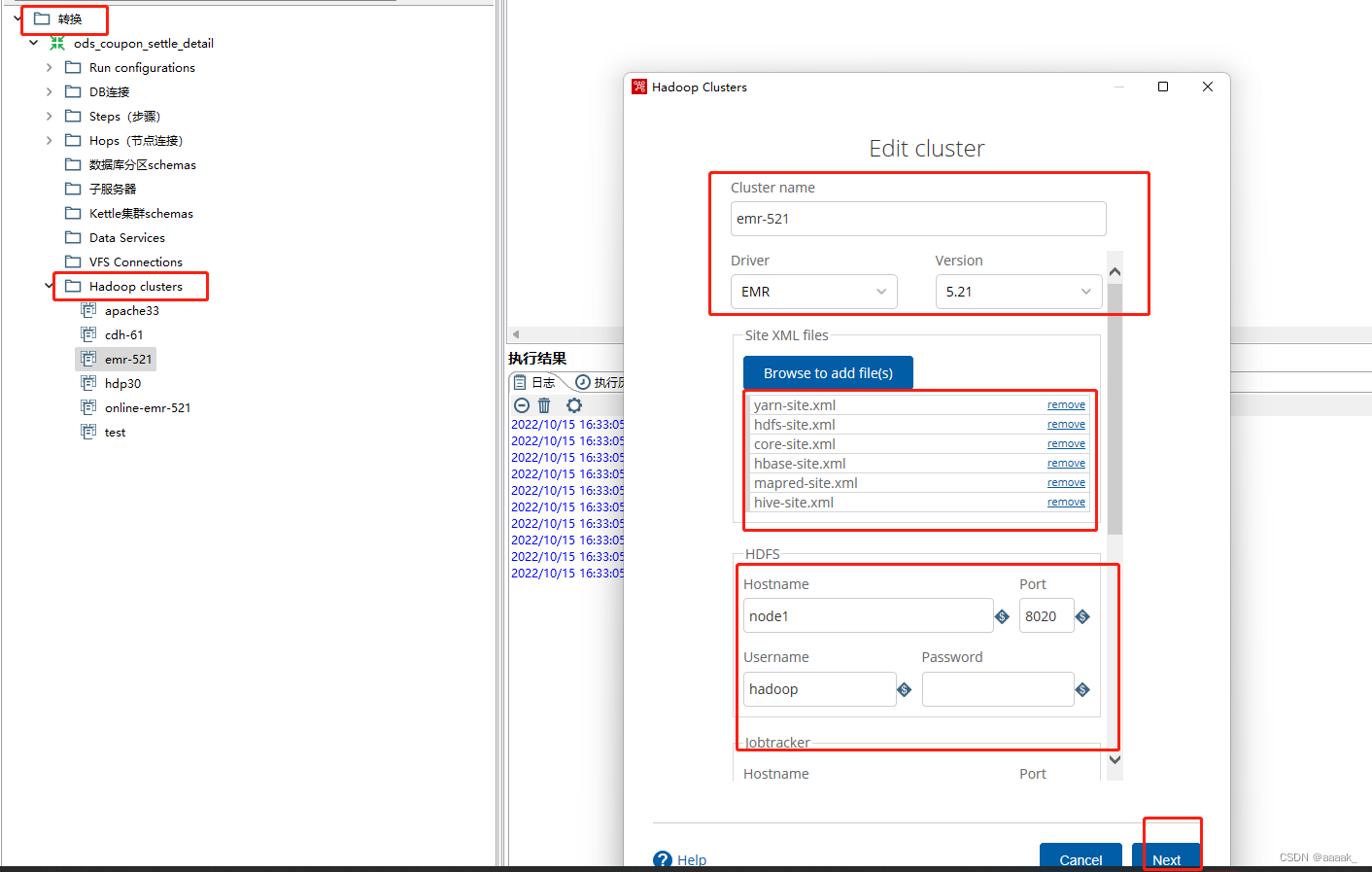

- 在转换下 hadoop clusters 组件 点反键 add driver 载入 我们刚刚下载好的 KAR ,然后重启

- 最后 在转换下 hadoop clusters 组件 点反键 new clusters ,填写相关 点保存就可以连接上了

4 kettle连接mysql

1.在spoon安装目录下的lib文件夹里添加mysql驱动,(附件mysql-connector-java-5.1.48.jar)

2.执行spoon.bat,文件->新建->数据库连接

3.选择mysql并配置连接信息, 点击测试查看是否配置正确.

5 kettle连接hive

1.需在spoon安装目录下的lib文件夹里添加hive驱动,(附件hive-jdbc-standalone.jar)

2.执行spoon.bat,文件->新建->数据库连接

3.选择Hadoop hive2并配置连接信息, 点击测试查看是否配置正确.

6 kettle老版本 连接Hadoop

1.下载hadoop的配置文件 yarn-site.xml、mapred-site.xml、hive-site.xml、hdfs-site.xml、hbase-site.xml、core-site.xml。复制到spoon安装目录下的\plugins\pentaho-big-data-plugin\hadoop-configurations\hdp30并替换文件。

2.返回\plugins\pentaho-big-data-plugin目录,修改plugin.properties文件

修改

active.hadoop.configuration=hdp30

3.执行spoon.bat,新建转换,在主对象树中找到Haddopp clusters右键新增连接

4.配置hadoop连接信息, 点击测试查看是否配置正确.

7 注意事项

- 以上spoon版本为8.2 。

- 编辑spoon.bat文件,在set OPT=%OPT% 行最后加 -DHADOOP_USER_NAME 参数,可以指定hadoop默认的用户名。

- 编辑spoon.bat文件,在"%PENTAHO_DI_JAVA_OPTIONS%" 后添加参数-Dfile.encoding=UTF-8,解决kettle执行乱码报错的问题。

- 若hdfs浏览文件时无法查看文件,则当前hdfs的节点为standby 请修改hdfs的节点为 active的节点

- 使用kettle输出到hive后,在hdfs中可以看到数据到在hive中无法查询到数据时,需在hive中执行以下语句修复表。

msck repair table table_name;

官方文档 https://help.hitachivantara.com/Documentation/Pentaho/9.3/Setup/Pentaho_evaluation

6196

6196

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?