目录

一、FastDFS介绍及原理

1.简介

FastDFS开源地址:happyfish100 (YuQing) · GitHub

FastDFS 是一个开源的高性能分布式文件系统(DFS)。 它的主要功能包括:文件存储,文件同步和文件访问,以及高容量和负载平衡。主要解决了海量数据存储问题,特别适合以中小文件(建议范围:4KB < file_size <500MB)为载体的在线服务。

FastDFS 系统有三个角色:跟踪服务器(Tracker Server)、存储服务器(Storage Server)和客户端(Client),结构图如下:

Tracker Server:Tracker是FastDFS的协调者,负责管理所有的storage server和group,每个storage在启动后会连接Tracker,告知自己所属的group等信息,并保持周期性的心跳,tracker根据storage的心跳信息,建立group==>[storage server list]的映射表。

Tracker需要管理的元信息很少,会全部存储在内存中;另外tracker上的元信息都是由storage汇报的信息生成的,本身不需要持久化任何数据,这样使得tracker非常容易扩展,直接增加tracker机器即可扩展为tracker cluster来服务,cluster里每个tracker之间是完全对等的,所有的tracker都接受storage的心跳信息,生成元数据信息来提供读写服务。

Storage Server:Storage server(后简称storage)以组(卷,group或volume)为单位组织,一个group内包含多台storage机器,数据互为备份,存储空间以group内容量最小的storage为准,所以建议group内的多个storage尽量配置相同,以免造成存储空间的浪费。

以group为单位组织存储能方便的进行应用隔离、负载均衡、副本数定制(group内storage server数量即为该group的副本数),比如将不同应用数据存到不同的group就能隔离应用数据,同时还可根据应用的访问特性来将应用分配到不同的group来做负载均衡;缺点是group的容量受单机存储容量的限制,同时当group内有机器坏掉时,数据恢复只能依赖group内地其他机器,使得恢复时间会很长。

group内每个storage的存储依赖于本地文件系统,storage可配置多个数据存储目录,比如有10块磁盘,分别挂载在/data/disk1-/data/disk10,则可将这10个目录都配置为storage的数据存储目录。

storage接受到写文件请求时,会根据配置好的规则(后面会介绍),选择其中一个存储目录来存储文件。为了避免单个目录下的文件数太多,在storage第一次启动时,会在每个数据存储目录里创建2级子目录,每级256个,总共65536个文件,新写的文件会以hash的方式被路由到其中某个子目录下,然后将文件数据直接作为一个本地文件存储到该目录中。

选择存储的group:

当tracker接收到upload file的请求时,会为该文件分配一个可以存储该文件的group,支持如下选择group的规则:

- Round robin,所有的group间轮询

- Specified group,指定某一个确定的group

- Load balance,剩余存储空间多的group优先

选择Storage Server:

当选定group后,tracker会在group内选择一个storage server给客户端,支持如下选择storage的规则:

- Round robin,在group内的所有storage间轮询

- First server ordered by ip,按ip排序

- First server ordered by priority,按优先级排序(优先级在storage上配置)

选择storage path:

当分配好storage server后,客户端将向storage发送写文件请求,storage将会为文件分配一个数据存储目录,支持如下规则:

- Round robin,多个存储目录间轮询

- 剩余存储空间最多的优先

Client:客户端,上传下载数据的服务器,也就是我们自己的项目所部署在的服务器。

2.FastDFS协议

FastDFS角色间是基于TCP/IP协议进行通信,协议包格式为:header + body。具体结构如图:

3.存储策略

为了支持大容量,存储节点(服务器)采用了分卷(或分组)的组织方式。存储系统由一个或多个卷组成,卷与卷之间的文件是相互独立的,所有卷的文件容量累加就是整个存储系统中的文件容量。一个卷可以由一台或多台存储服务器组成,一个卷下的存储服务器中的文件都是相同的,卷中的多台存储服务器起到了冗余备份和负载均衡的作用。

在卷中增加服务器时,同步已有的文件由系统自动完成,同步完成后,系统自动将新增服务器切换到线上提供服务。当存储空间不足或即将耗尽时,可以动态添加卷。只需要增加一台或多台服务器,并将它们配置为一个新的卷,这样就扩大了存储系统的容量。

4.上传过程

FastDFS向使用者提供基本文件访问接口,比如upload、download、append、delete等,以客户端库的方式提供给用户使用。

Storage Server会定期的向Tracker Server发送自己的存储信息。当Tracker Server Cluster中的Tracker Server不止一个时,各个Tracker之间的关系是对等的,所以客户端上传时可以选择任意一个Tracker。

选择tracker server

当集群中不止一个tracker server时,由于tracker之间是完全对等的关系,客户端在upload文件时可以任意选择一个trakcer。

选择存储的group

当tracker接收到upload file的请求时,会为该文件分配一个可以存储该文件的group,支持如下选择group的规则:

- Round robin,所有的group间轮询

- Specified group,指定某一个确定的group

- Load balance,剩余存储空间多多group优先

选择storage server

当选定group后,tracker会在group内选择一个storage server给客户端,支持如下选择storage的规则:

- Round robin,在group内的所有storage间轮询

- First server ordered by ip,按ip排序

- First server ordered by priority,按优先级排序(优先级在storage上配置)

选择storage path

当分配好storage server后,客户端将向storage发送写文件请求,storage将会为文件分配一个数据存储目录,支持如下规则:

- Round robin,多个存储目录间轮询

- 剩余存储空间最多的优先

生成Fileid

选定存储目录之后,storage会为文件生一个Fileid,由storage server ip、文件创建时间、文件大小、文件crc32和一个随机数拼接而成,然后将这个二进制串进行base64编码,转换为可打印的字符串。

选择两级目录

当选定存储目录之后,storage会为文件分配一个fileid,每个存储目录下有两级256*256的子目录,storage会按文件fileid进行两次hash,路由到其中一个子目录,然后将文件以fileid为文件名存储到该子目录下。

生成文件名

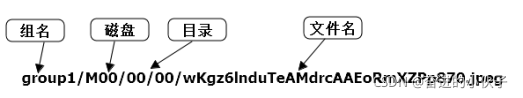

当文件存储到某个子目录后,即认为该文件存储成功,接下来会为该文件生成一个文件名,文件名由group、存储目录、两级子目录、fileid、文件后缀名(由客户端指定,主要用于区分文件类型)拼接而成。

5.文件同步

写文件时,客户端将文件写至group内一个storage server即认为写文件成功,storage server写完文件后,会由后台线程将文件同步至同group内其他的storage server。

每个storage写文件后,同时会写一份binlog,binlog里不包含文件数据,只包含文件名等元信息,这份binlog用于后台同步,storage会记录向group内其他storage同步的进度,以便重启后能接上次的进度继续同步;进度以时间戳的方式进行记录,所以最好能保证集群内所有server的时钟保持同步。

storage的同步进度会作为元数据的一部分汇报到tracker上,tracke在选择读storage的时候会以同步进度作为参考。

6.文件下载

客户端uploadfile成功后,会拿到一个storage生成的文件名,接下来客户端根据这个文件名即可访问到该文件。

跟upload file一样,在downloadfile时客户端可以选择任意tracker server。tracker发送download请求给某个tracker,必须带上文件名信息,tracke从文件名中解析出文件的group、大小、创建时间等信息,然后为该请求选择一个storage用来服务读请求。

定位文件:客户端上传文件后存储服务器将文件ID返回给客户端,此文件ID用于以后访问该文件的索引信息。文件索引信息包括:组名,虚拟磁盘路径,数据两级目录,文件名。

![]()

- 组名:文件上传后所在的storage组名称,在文件上传成功后有storage服务器返回,需要客户端自行保存。

- 虚拟磁盘路径:storage配置的虚拟路径,与磁盘选项store_path*对应。如果配置了store_path0则是M00,如果配置了store_path1则是M01,以此类推。

- 数据两级目录:storage服务器在每个虚拟磁盘路径下创建的两级目录,用于存储数据文件。

- 文件名:与文件上传时不同。是由存储服务器根据特定信息生成,文件名包含:源存储服务器IP地址、文件创建时间戳、文件大小、随机数和文件拓展名等信息。

知道FastDFS FID的组成后,我们来看看FastDFS是如何通过这个精巧的FID定位到需要访问的文件:

- 通过组名tracker能够很快的定位到客户端需要访问的存储服务器组,并将选择合适的存储服务器提供客户端访问

- 存储服务器根据“文件存储虚拟磁盘路径”和“数据文件两级目录”可以很快定位到文件所在目录,并根据文件名找到客户端需要访问的文件

由于group内的文件同步时在后台异步进行的,所以有可能出现在读到时候,文件还没有同步到某些storage server上,为了尽量避免访问到这样的storage,tracker按照如下规则选择group内可读的storage。

- 该文件上传到的源头storage - 源头storage只要存活着,肯定包含这个文件,源头的地址被编码在文件名中。

- 文件创建时间戳==storage被同步到的时间戳 且(当前时间-文件创建时间戳) > 文件同步最大时间(如5分钟) - 文件创建后,认为经过最大同步时间后,肯定已经同步到其他storage了。

- 文件创建时间戳 < storage被同步到的时间戳。 - 同步时间戳之前的文件确定已经同步了

- (当前时间-文件创建时间戳) > 同步延迟阀值(如一天)。 - 经过同步延迟阈值时间,认为文件肯定已经同步了。

7.小文件存储性能优化

FastDFS在小文件存储性能优化方面采用将小文件合并存储的方式,主要解决如下几个问题:

- 本地文件系统inode数量有限,从而存储的小文件数量也就受到限制。

- 多级目录+目录里很多文件,导致访问文件的开销很大(可能导致很多次IO)

- 按小文件存储,备份与恢复的效率低

FastDFS在V3.0版本里的机制,可将多个小文件存储到一个大的文件(trunk file),为了支持这个机制,FastDFS生成的文件fileid需要额外增加16个字节

- trunk file id

- 文件在trunk file内部的offset

- 文件占用的存储空间大小 (字节对齐及删除空间复用,文件占用存储空间>=文件大小)

每个trunk file由一个id唯一标识,trunk file由group内的trunk server负责创建(trunk server是tracker选出来的),并同步到group内其他的storage,文件存储合并存储到trunk file后,根据其offset就能从trunk file读取到文件。

文件在trunk file内的offset编码到文件名,决定了其在trunk file内的位置是不能更改的,也就不能通过compact的方式回收trunk file内删除文件的空间。但当trunk file内有文件删除时,其删除的空间是可以被复用的,比如一个100KB的文件被删除,接下来存储一个99KB的文件就可以直接复用这片删除的存储空间。

二、环境准备及安装

| 名称 | 说明 |

| centos | 7.x |

| libfatscommon | FastDFS分离出的一些公用函数包 |

| FastDFS | FastDFS本体 |

| fastdfs-nginx-module | FastDFS和nginx的关联模块 |

| nginx | nginx1.15.4 |

使用的系统软件

编译环境

yum install git gcc gcc-c++ make automake autoconf libtool pcre pcre-devel zlib zlib-devel openssl-devel wget vim -y

磁盘目录

| 说明 | 位置 |

| 所有安装包 | /usr/local/src |

| 数据存储位置 | /home/dfs/ |

| #这里我为了方便把日志什么的都放到了dfs |

mkdir /home/dfs #创建数据存储目录

cd /usr/local/src #切换到安装目录准备下载安装包

安装libfatscommon

git clone https://github.com/happyfish100/libfastcommon.git --depth 1

cd libfastcommon/

./make.sh && ./make.sh install #编译安装

安装FastDFS

cd ../ #返回上一级目录

git clone https://github.com/happyfish100/fastdfs.git --depth 1

cd fastdfs/

./make.sh && ./make.sh install #编译安装#配置文件准备

cp /usr/etc/fdfs/tracker.conf.sample /etc/fdfs/tracker.conf

cp /usr/etc/fdfs/storage.conf.sample /etc/fdfs/storage.conf

cp /usr/etc/fdfs/client.conf.sample /etc/fdfs/client.conf #客户端文件,测试用

cp /usr/local/src/fastdfs/conf/http.conf /etc/fdfs/ #供nginx访问使用

cp /usr/local/src/fastdfs/conf/mime.types /etc/fdfs/ #供nginx访问使用

安装fastdfs-nginx-module

cd ../ #返回上一级目录

git clone https://github.com/happyfish100/fastdfs-nginx-module.git --depth 1

cp /usr/local/src/fastdfs-nginx-module/src/mod_fastdfs.conf /etc/fdfs

安装nginx

wget http://nginx.org/download/nginx-1.15.4.tar.gz #下载nginx压缩包

tar -zxvf nginx-1.15.4.tar.gz #解压

cd nginx-1.15.4/#添加fastdfs-nginx-module模块

./configure --add-module=/usr/local/src/fastdfs-nginx-module/src/

make && make install #编译安装

单机部署

tracker配置

#服务器ip为 192.168.52.1#我建议用ftp下载下来这些文件 本地修改

vim /etc/fdfs/tracker.conf#需要修改的内容如下

port=22122 # tracker服务器端口(默认22122,一般不修改)

base_path=/home/dfs # 存储日志和数据的根目录

storage配置

vim /etc/fdfs/storage.conf#需要修改的内容如下

port=23000 # storage服务端口(默认23000,一般不修改)

base_path=/home/dfs # 数据和日志文件存储根目录

store_path0=/home/dfs # 第一个存储目录

tracker_server=192.168.52.1:22122 # tracker服务器IP和端口

http.server_port=8888 # http访问文件的端口(默认8888,看情况修改,和nginx中保持一致)

client测试

vim /etc/fdfs/client.conf

#需要修改的内容如下

base_path=/home/dfs

tracker_server=192.168.52.1:22122

#tracker服务器IP和端口#保存后测试,返回ID表示成功 如:group1/M00/00/00/xx.tar.gz

fdfs_upload_file /etc/fdfs/client.conf /usr/local/src/nginx-1.15.4.tar.gz

文件名规则如下:

配置nginx访问

vim /etc/fdfs/mod_fastdfs.conf

#需要修改的内容如下

tracker_server=192.168.52.1:22122

#tracker服务器IP和端口

url_have_group_name=true

store_path0=/home/dfs

#配置nginx.config

vim /usr/local/nginx/conf/nginx.conf

#添加如下配置

server {

listen 8888; ## 该端口为storage.conf中的http.server_port相同

server_name localhost;

location ~/group[0-9]/ {

ngx_fastdfs_module;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

#测试下载,用外部浏览器访问刚才已传过的nginx安装包,引用返回的ID

http://192.168.52.1:8888/group1/M00/00/00/wKgAQ1pysxmAaqhAAA76tz-dVgg.tar.gz#弹出下载单机部署全部跑通

分布式部署

tracker配置

#服务器ip为 192.168.52.2,192.168.52.3,192.168.52.4#我建议用ftp下载下来这些文件 本地修改

vim /etc/fdfs/tracker.conf

#需要修改的内容如下

port=22122 # tracker服务器端口(默认22122,一般不修改)

base_path=/home/dfs # 存储日志和数据的根目录

storage配置

vim /etc/fdfs/storage.conf#需要修改的内容如下

port=23000 # storage服务端口(默认23000,一般不修改)

base_path=/home/dfs # 数据和日志文件存储根目录

store_path0=/home/dfs # 第一个存储目录

tracker_server=192.168.52.2:22122 # 服务器1

tracker_server=192.168.52.3:22122 # 服务器2

tracker_server=192.168.52.4:22122 # 服务器3

http.server_port=8888 # http访问文件的端口(默认8888,看情况修改,和nginx中保持一致)

client测试

vim /etc/fdfs/client.conf#需要修改的内容如下

base_path=/home/moe/dfs

tracker_server=192.168.52.2:22122 # 服务器1

tracker_server=192.168.52.3:22122 # 服务器2

tracker_server=192.168.52.4:22122 # 服务器3#保存后测试,返回ID表示成功 如:group1/M00/00/00/xx.tar.gz

fdfs_upload_file /etc/fdfs/client.conf /usr/local/src/nginx-1.15.4.tar.gz

配置nginx访问

vim /etc/fdfs/mod_fastdfs.conf#需要修改的内容如下

tracker_server=192.168.52.2:22122 # 服务器1

tracker_server=192.168.52.3:22122 # 服务器2

tracker_server=192.168.52.4:22122 # 服务器3

url_have_group_name=true

store_path0=/home/dfs#配置nginx.config

vim /usr/local/nginx/conf/nginx.conf#添加如下配置

server {

listen 8888; ## 该端口为storage.conf中的http.server_port相同

server_name localhost;

location ~/group[0-9]/ {

ngx_fastdfs_module;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

启动

防火墙

#不关闭防火墙的话无法使用

systemctl stop firewalld.service #关闭

systemctl restart firewalld.service #重启

tracker

/etc/init.d/fdfs_trackerd start #启动tracker服务

/etc/init.d/fdfs_trackerd restart #重启动tracker服务

/etc/init.d/fdfs_trackerd stop #停止tracker服务

chkconfig fdfs_trackerd on #自启动tracker服务

storage

/etc/init.d/fdfs_storaged start #启动storage服务

/etc/init.d/fdfs_storaged restart #重动storage服务

/etc/init.d/fdfs_storaged stop #停止动storage服务

chkconfig fdfs_storaged on #自启动storage服务

nginx

/usr/local/nginx/sbin/nginx #启动nginx

/usr/local/nginx/sbin/nginx -s reload #重启nginx

/usr/local/nginx/sbin/nginx -s stop #停止nginx

检测集群

/usr/bin/fdfs_monitor /etc/fdfs/storage.conf# 会显示会有几台服务器 有3台就会 显示 Storage 1-Storage 3的详细信息

以上信息来源:

本人安装之后,在/etc/init.d/下面没有fdfs_trackerd和fdfs_storaged两个命令,所以我的启动等命令如下:

1:启动FastDFS

tracker: /usr/bin/fdfs_trackerd /etc/fdfs/tracker.conf

storage: /usr/bin/fdfs_storaged /etc/fdfs/storage.conf

2:关闭FastDFS

tracker:/usr/bin/fdfs_trackerd /etc/fdfs/tracker.conf stop

storage:/usr/bin/fdfs_storaged /etc/fdfs/storage.conf stop

或者 killall fdfs_trackered(storaged) -------注意,千万不要使用-9强行杀死进程。

我们要是使用终止命令或者使用 kill -9 fdfs进程id 来终结fdfs_storaged服务的,然后用上面的启动命令是启动不了的,因为log日志问题,会出现下面的错误

3:重启FastDFS

tracker:/usr/bin/fdfs_trackerd /etc/fdfs/tracker.conf restart

storage:/usr/bin/fdfs_storaged /etc/fdfs/storage.conf restart

4:查看集群情况

在任意一台storage(tracker也可以) /usr/bin/fdfs_monitor /etc/fdfs/storage.conf

1312

1312

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?