第1章 逻辑斯蒂回归

逻辑斯蒂回归模型

1.1.1 逻辑斯蒂分布

定义1.1 (逻辑斯蒂分布):设

X

是连续随机变量,

其中,

u

为未知参数,

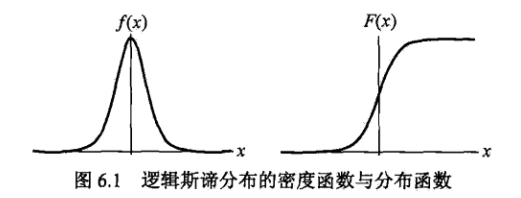

逻辑斯蒂分布的密度函数和分布函数如图6.1所示。分布函数属于逻辑斯蒂函数,其图形是一条

S

形曲(sigmoid curve)。该曲线以点(

曲线在中心附近增长速度较快,在两端增长速度较慢。形状参数

r

的值越小,曲线在中心附近增长越快。

1.1.2 二项逻辑斯蒂回归模型

二项逻辑斯蒂回归模型是一种分类模型,由条件概率分布

定义1.2 (逻辑斯蒂回归模型)二项逻辑斯蒂回归模型是如下的条件概率分布:

其中,

x∈Rn

是输入,

Y∈{0,1}

是输出,

w∈Rn

和

b∈R

是参数,

w

称为权重,

对于给定输入

x

,计算

有时为了方便,将权重向量和输入向量加以扩充,即

现在考察逻辑斯蒂回归模型的特点。一个事件的几率(odds)是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是

p

,那么该事件的几率是

对于逻辑斯蒂回归而言,由式(1.5)和式(1.6)得:

也就是说,在逻辑斯蒂回归模型中,输出 Y=1 的对数几率是输入 x 的线性函数。

1.3 模型参数估计

逻辑斯蒂回归模型学习时,对于给定的训练集

设:

P(Y=1|x)=π(x)

,

P(Y=0|x)=1−π(x)

则似然函数为:

∏Ni=1[π(xi)]yi[1−π(xi)]1−yi

对数似然函数为:

对

L(w)

求极大值,得到

w

<script type="math/tex" id="MathJax-Element-190">w</script>的估计值。

这样,问题就变成以对数似然函数为目标函数的最优化问题。逻辑斯蒂回归学习中通常采用的方法是梯度下降及拟牛顿法。

1、求解方法一:梯度上升法

1090

1090

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?