2018/04/08

想不在shell里面写代码,就是用spark-submit来弄。

新下载pyspark的话,包有200多M。所以就想着直接引用spark自带的。(虽然pip下载的版本跟这个也是匹配的)

但是直接引用失败,缺少py4j,先安装。

后面的话,就必须在脚本执行前就把这个东西给引入进去。

1 #! /bin/python

2 #coding:utf-8

3 #

4

5 import os

6 spark_home = os.getenv("SPARK_HOME")

7 import sys

8 sys.path.insert(0,os.path.join(spark_home,"python"))

9

17 from pyspark import SparkConf,SparkContext

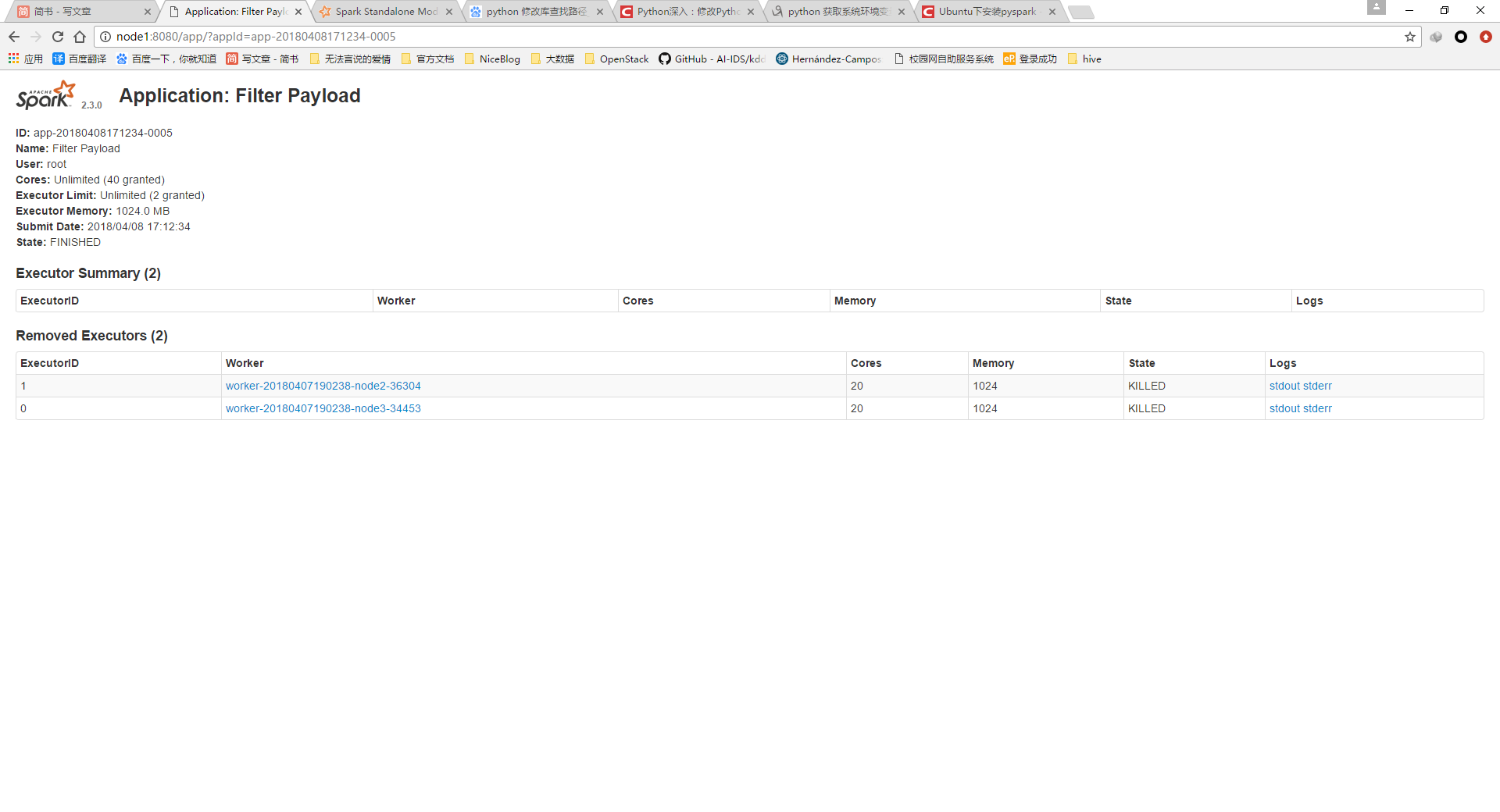

20 conf = SparkConf().setMaster("spark://node1:7077").setAppName("Filter Payload")

22 sc = SparkContext(conf = conf)这样执行以后,可以在webui上看到这些个设置,而且输出也就是pyspark的输出。

image.png

2018/04/13

貌似有一个更好的脚本可以提供。

https://github.com/beeva/beeva-best-practices/blob/master/big_data/spark/README.md

Spark Submit 脚本配置

Spark Submit 脚本配置

本文介绍如何通过spark-submit脚本配置Spark运行环境,并解决Py4j缺失问题,实现pyspark脚本的正常执行。

本文介绍如何通过spark-submit脚本配置Spark运行环境,并解决Py4j缺失问题,实现pyspark脚本的正常执行。

2989

2989

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?