点击上方“AI公园”,关注公众号,选择加“星标“或“置顶”

导读作者:Anders Christiansen

编译:ronghuaiyang

最近物体检测领域掀起阵anchor free的风,今天借这个风,也给大家分享一篇anchor free相关的文章。

问题

如果你之前干过修改anchor的活,你可能会感到沮丧、困惑,并对自己说:“一定有另一种方法!”现在看来,确实另一种方法。

当我第一次写关于anchor box的文章时,我的想法是绕过所有anchor box,将物体检测问题转化为语义分割问题。我尝试预测过对于每个像素,每个类的物体的界框的数量是多少。由于以下几个问题,结果相当糟糕:

我无法将分割蒙版转换回包围框。这意味着我不能隔离或对物体进行计数。

神经网络很难去学习物体周围的哪个像素属于边界框。这可以在训练中看到,模型首先分割物体,然后才开始在物体周围形成矩形框。

很快的,这几个月以来,已经有几个模型以一种更创新的方式取消了anchor boxes。

没有anchors的物体检测

CornerNet使用一个嵌入为每个像素预测边界框的左上角和右下角。每个corner的嵌入匹配以确定它们属于哪个物体。一旦你匹配了所有的corner,恢复边界框就很简单了。这解决了我所面临的问题,即取消anchor box,同时能够从输出中恢复出边界框。

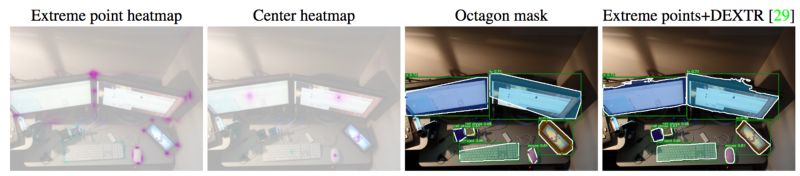

然而,CornerNet并没有解决我所面临的第二个问题,即网络必须学习如何定位一个甚至不包含该物体的像素。这就是ExtremeNet的用武之地。这种方法是基于CornerNet的,但它不是预测corners,而是预测物体的中心以及最远的左、右、顶和底点。这些“极值点”然后根据它们的几何形状进行匹配,结果非常好:

标注

但如何找到极值点的标注呢?不幸的是,作者从分割掩码中提取了极值点,如果只有边界框,则无法使用此选项。但是,极限点标注有几个优点:

标记一个对象的端点要比标记边界框容易得多。要标记一个边界框,你必须注意与两个最极端点对齐的角的位置。通常,标注工具必须在之后调整边界框,以便与极端点对齐。ExtremeNet论文估计,标记极值点所花费的时间几乎是标记边界框所花费时间的五分之一。

就像人类更容易标记极端点一样,神经网络也应该更容易指出它们的确切位置。目前,ExtremeNet的表现似乎优于其他一阶段检测器。

给定物体的极值点,生成边界框非常简单。如果还可以使用图像,DEXTR算法可用于生成分割的mask。这使得极限点比边界框更加通用。

速度不是很快

在将所有物体检测系统迁移到ExtremeNet之前,请记住,当前的实现是大而慢的。预训练模型达到了最先进的结果,拥有近2亿个参数,大小为800mb。当我在特斯拉K80 GPU (p2)上测试批量的单个图像时。使用GitHub中的demo.py脚本,每个图像大约需要8秒。使用DEXTR创建一个分割掩码,根据检测的次数每次增加2-12秒。如果你想从多个图像尺度对检测进行分组,那么这个数字会进一步增长。总的来说,在一张图像上运行多尺度分割需要一分钟的时间,尽管我认为可以通过优化代码来改进这些数字。CornerNet声称在Titan X (Pascal) GPU上运行速度约为4帧每秒,这也比现有的单阶段的检测器慢得多。在我考虑将ExtremeNet作为大多数应用程序的可行选项之前,需要有一个既快速又准确的版本。

结论

ExtremeNet论文声称,与所有其他single shot检测器相比,ExtremeNet的性能优越,同时也避免了必须仔细调整anchor box,然后解码输出。即使没有这样的模型,标注方法本身也提供了显著的好处。作为一个神经网络,该模型还没有完全端到端的学习,还需要包括各种算法来生成边界框或分割掩码。尽管如此,我非常希望在未来,极值点标注和模型成为物体检测的规范。

References

[1] Lin, Tsung-Yi et al. “Microsoft COCO: Common Objects in Context.” Lecture Notes in Computer Science (2014): 740–755. Crossref. Web.

[2] Law, Hei, and Jia Deng. “CornerNet: Detecting Objects as Paired Keypoints.” Lecture Notes in Computer Science (2018): 765–781. Crossref. Web.

[3] Zhou, Xingyi, Jiacheng Zhuo, and Philipp Krähenbühl. “Bottom-up Object Detection by Grouping Extreme and Center Points.” arXiv preprint arXiv:1901.08043 (2019).

[4] Maninis, K.-K. et al. “Deep Extreme Cut: From Extreme Points to Object Segmentation.” 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (2018): n. pag. Crossref. Web.

—

END—

—

END—

英文原文:https://medium.com/@andersasac/the-end-of-anchors-improving-object-detection-models-and-annotations-73828c7b39f6

请长按或扫描二维码关注本公众号

喜欢的话,请给我个好看吧!![]()

3946

3946

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?