前言:2025年,让你的AI既能“想事儿”又会“干活儿”!

还记得我们对AI的美好幻想吗?它不仅要答得出题,还得能上网查证、写代码、找信息,最好还能“像人一样”一步一步把难题解决——既能推理又会实际操作。2025年,这一幻想终于成真。而LangGraph中超火的ReAct Agent模板,正是实现这一转变的催化剂。今天,我们就来一本正经地拆解一下这个模板,看看它为AI世界开启了哪些新大门。

别眨眼,这将是一篇涵盖技术底蕴、实战案例、未来趋势、幽默小彩蛋的大部头爆款文章!无论你是资深开发者还是AI爱好者,都能在这里找到“知识爽点”。

目录

-

背景回顾:为什么“思考-行动”是AI解锁高阶智能的终极姿势?

-

ReAct Agent是什么?技术原理大科普

-

LangGraph Studio的ReAct Agent模板:拆解核心逻辑

-

案例复盘:ReAct Agent解决实际问题有多“绝”

-

从Prompt到Finetune:如何让你的Agent越来越聪明?

-

工程实战手册:定制你的ReAct超级Agent

-

ReAct的局限与挑战:别让AI太“天真”

-

展望未来:混合型Agent的赛博世界新图景

-

总结升华+互动引导:你的Agent梦想是什么?

1. 背景回顾:为什么“思考-行动”是AI解锁高阶智能的终极姿势?

1.1 两大能力,各自为战

传统AI主要有两大流派:

-

推理派(Reasoning):能“想事儿”,比如连环推理、多步询问、知识的推断,但它只靠自身记忆和参数,对外部世界“懒得管”。

-

行动派(Acting):会“干活儿”,能下指令、执行操作,甚至查找网页、调API、写代码……但大多时候,只能机械行动,缺少“诸葛亮脑袋”。

这两派过去“各自修炼”,很少融合。

1.2 智能晋级,必靠“协同”

人类为什么厉害?因为我们能一边思考一边行动,行动反馈又推动新一轮思考。这就是AI界新风潮:“Reason+Action = ReAct”。

-

推理赋予智能,决策不离大脑。

-

行动直连世界,能获取新信息、纠错和修正。

-

思考和行动交错,引爆涌现式智能!

1.3 LangGraph强力加持

LangGraph正是这方面的引领者。它用“像搭积木一样”可视化地描绘、编排Agent,把复杂逻辑变得极易管理和扩展——不仅开发者很爽,连新手小白都能秒上手。

2. ReAct Agent是什么?技术原理大科普

2.1 理论之源:ReAct论文闪亮登场

论文《ReAct: Synergizing Reasoning and Acting in Language Models》首次系统化提出:

让LLM(大语言模型)在解决任务时,迭代地“先思考、后行动”,两者密切配合。

这一发明直接刷新了AI的边界:

-

推理Trace:模型会把每一步思考明明白白地写出来!(有点像《武林外传》里的“写日记”)

-

行动计划:模型会决定用什么“外部工具”去执行任务,比如查文献、验事实、下指令等等。

-

观察反馈:每次行动后会获取新信息,再进入下一轮推理和行动。

2.2 为什么比传统Agent厉害?

-

抗幻觉能力max:只靠内部知识容易“编故事”,ReAct能借外部工具查真相——极大减少胡说八道!

-

可解释性强:每一轮推理和动作都“有迹可循”,方便人类检查和干预。

-

信任感up:用户不再是把AI当黑盒,而是能看到Agent的“解题思路”全过程。

2.3 Prompt驱动,有点人味儿

ReAct的prompt设计采用“人类示范轨迹”:既有思考,又有动作,带着环境反馈。模型照葫芦画瓢,逐步演化出解决问题的本领。

3. LangGraph Studio的ReAct Agent模板:拆解核心逻辑

3.1 Studio设定,让定制So easy

LangGraph Studio是开发者和设计师的福音。它提供了极易上手的ReAct Agent模板(目录:src/react_agent/graph.py),助你快速“造Agent”。

- 核心流程:

-

接收用户输入

-

推理/思考一番,决定下一步要干啥

-

执行指定“工具”,如数据库、搜索、API

-

获取行动结果

-

继续“想+干”循环,直到最终答案

-

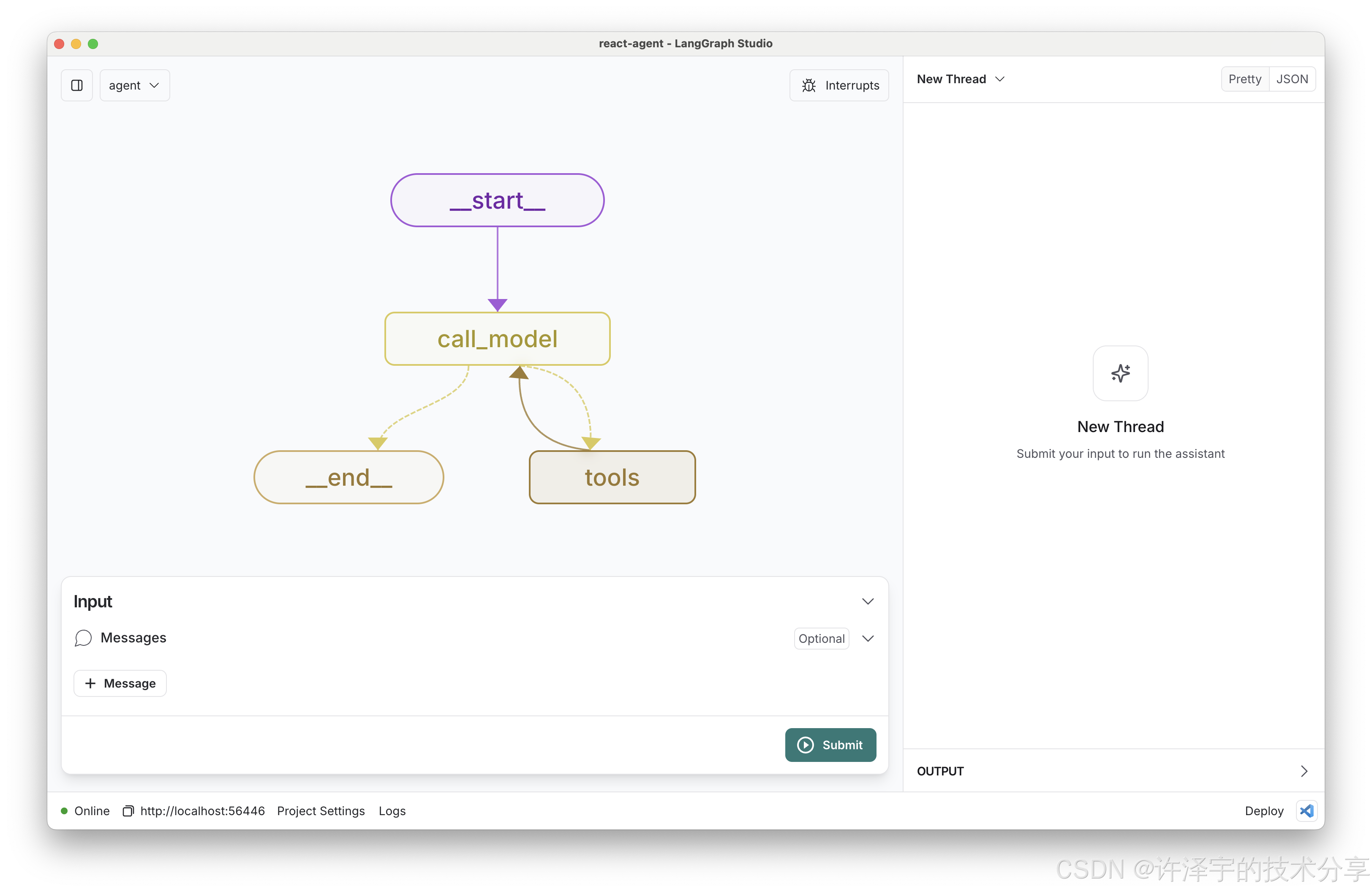

3.2 UI可视化,逻辑流畅如丝

-

Studio图形界面直观展示“思考-行动-反馈”流程,任你拖拉调整节点和边。

-

支持丰富工具库,比如内置搜索(Tavily)、外部API、自己写的Python函数。

-

动态编辑历史状态,热重载调试,工程师的“练手天堂”。

3.3 可插拔、可扩展

-

一行代码加新工具,Agent立马新技能get!

-

可选多种主流模型(Anthropic、OpenAI等),配置随心。

-

Prompt随写就改,人格化Agent触手可及。

# 示例代码片段:自定义工具

def weather_query(city):

# 访问天气API,返回天气描述

return ...

# 注册到Agent工具组

tools.append(weather_query)

4. 案例复盘:ReAct Agent解决实际问题有多“绝”

4.1 问答场景:HotpotQA实测

-

普通CoT(Chain-of-Thought)模型:只会“想”,查不到外部资料,容易“信口胡说”一下。

-

Act-only模型:会“查找”,可惜没推理,掌握一堆事实但不会综合。

- ReAct Agent:既会查资料,又会自己推理:

-

首先思考“我该查哪个人/词条?”

-

调用Wikipedia API搜索

-

综合各项信息,输出准确、解释详细的答案。

-

整个解题过程“有理有据”,调试和纠错都很简单!

-

实际论文实测,ReAct有效打破智能瓶颈——不仅提升成绩,还让解答思路全面透明。

4.2 决策场景:ALFWorld/WebShop等虚拟环境挑战

-

ReAct通过稀疏插入思考步骤,指引模型“何时该想?何时该干?”。

-

在复杂决策任务(比如虚拟购物),ReAct比纯模仿学习、强化学习高出10%以上成功率!

-

行动策略和推理轨迹都能给用户/工程师无限“检视和纠偏”空间。

4.3 实测Finetuning:小模型极限翻盘

-

只需用ReAct的示范prompt微调,小模型(参数小)能干翻大模型(纯prompt驱动)。

-

任务迁移与泛化能力蹭蹭上涨,各种场景“一靠边”就能玩花样。

5. 从Prompt到Finetune:如何让你的Agent越来越聪明?

5.1 Prompt设计揭秘

-

不只是“你来一段推理吧”,而是写出真实问题解决轨迹。

-

每条都包含 Reason(思考)、Action(具体行为)、Observation(行动结果)。

-

灵活插入人类反思点,让AI有“打盹儿”时刻。

用户问题:<xxx>

Reason: <我需要查找...>

Action: <搜索...>

Observation: <得到结果...>

Reason: <根据结果重新推理...>

Action: ...

5.2 微调策略精讲

-

用ReAct格式的数据微调,大幅提升模型“上下文理解+现实操作”双重能力。

-

微调后的小模型不再是“知识迷糊娃”,而是实打实的“问题解决能手”。

5.3 Prompt与Finetune联动:AI成长无极限

-

先用合理Prompt起步,遇到瓶颈就收集环节数据微调,不断循环升级。

-

支持“人类纠偏”,AI一旦走偏,改几步即可实时“回到正轨”。

-

工程师和产品经理能把控逻辑,业务需求随时打补丁。

6. 工程实战手册:定制你的ReAct超级Agent

6.1 定制工具方法

-

在

tools.py里加自己的API、外部服务。 -

UI中可选/插拔,极大简化feature上线。

-

比如,你可以让Agent既会查天气,又能调用自家CRM,还能授权执行自动化脚本。

6.2 选择与切换模型

-

LangGraph模板默认接入Anthropic的Claude 3 Sonnet,也可选OpenAI GPT-4、其他兼容大模型。

-

灵活配置,不怕厂商跑路。

6.3 调整推理流程

-

修改

graph.py即可定制“思考-行动”循环逻辑。 -

能插入中断节点,让Agent在危险时刻自动“停下了脚步,思索人生”(安全可控)。

6.4 多人协作与版本管理

-

LangGraph集成LangSmith,支持深入追踪、团队协同开发。

-

调试一条chat轨迹,比传统代码debug快N倍。

7. ReAct的局限与挑战:别让AI太“天真”

7.1 Prompt质量决定上限

-

Prompt太“水”,AI就像无头苍蝇,难出彩。

-

人类得精心设计“示例轨迹”,否则AI容易学会“偷懒”。

7.2 工具链安全与稳定

-

外部API死机或返回错信息,AI怎么办?Agent设计需提前加容错。

-

工具动作“越权”也需谨慎,比如误删数据库的bug,防不胜防。

7.3 推理与行动互动复杂性提升

-

多步推理-多步行动后,逻辑链拉得很长,对话历史极易膨胀,影响效率。

-

需设计优雅的“记忆&目标管理”机制,适当打断或归纳。

8. 展望未来:混合型Agent的赛博世界新图景

8.1 AI“多模态行动体”终将崛起

-

不只会文字推理,未来Agent还真能“看图”、“听音”、“动手”,全模态融合。

-

ReAct逻辑可扩展到多模态空间,AI的小宇宙无穷生发。

8.2 组团作战,Agent集群涌现高级智能

-

多个Agent各司其职,互相协作(“你思考我行动,他评估”)。 -形成“AI团队”,突破单体模型的天花板。

8.3 持续学习、自我纠偏,不断进化

-

Agent会自动总结行动结果,善用经验,实现“自我进化”。

-

让AI系统从“婴儿期”走向“成人期”,“与人类共同成长”。

9. 总结升华+互动引导:你的Agent梦想是什么?

9.1 技术升华

2025年,AI不只是个“会聊的文本机器人”,而是一个能“既思考又落实”,还随时能装新技能、纠正自身错误、给用户看得懂的操作理由的智能体。LangGraph的ReAct Agent模板,是你迈入这场智能革命的起跳板。未来Agent变得越来越“人”,越来越能干、能学、能解释,世界终有一天由此被深刻改变。

9.2 玩梗互动

看完这篇,技术党是否已经跃跃欲试,想立刻跑个自己的ReAct Agent?普通追新族是不是也对“AI能像人一样思考-行动”感到有趣?或者,各位产品经理已开始盘算下一个AI杀手应用?

评论区问题互动:

-

你最希望AI智能体能替你解决什么棘手问题?

-

你体验过哪些“思考-行动”型Agent,觉得有何神奇瞬间?

-

如果2025让你设计一个自己的ReAct Agent,你希望它会哪些独门技能?

快来留言区秀出你的“大脑洞”吧!本博主将随机送出一次免费LangGraph Studio加速包体验资格,期待你的奇思妙想与深入交流~

致谢

本文理论和案例均基于行业前沿论文与LangGraph官方模板,参考和融合了2025年最新Agent技术动态。任何探讨、学习、拓展,欢迎联系互动!AI的世界,由你我共建!

爆款潜力小贴士:如果你喜欢今天这篇硬核又有梗的深度解读,别忘了三连(点赞+分享+关注),每周一篇AI超新技术,和我一起玩转智能时代吧!

技术能改变世界,但精彩是由你来点燃。下次见!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?