安装配置记录

软件版本:hadoop-2.6.2-src.tar.gz, jdk1.7.0_65

开发工具:VMware Workstation12 Pro

宿主机信息:Windows7 64bit

操作系统:Redhat6.5

虚拟机内存设置:内存1G

虚拟机硬盘:20G

虚拟机网络设置:bridged

本次安装过程需要在非root用户下进行,期间会使用sudo命令,正常情况下,root用户不需要sudo,非root用户没有sudo使用权限,所以需要做以下准备:

su //登入root模式

chmod 740 /etc/sudoers //改变文件sudoers的权限为可写

vi /etc/sudoers // 用vi打开sudoers文件

username ALL=(ALL) ALL //在root ALL=(ALL) ALL处回车,另起一行写上

保存退出

chmod 440 /etc/sudoers //把sudoers的权限改为默认的440

退出root到普通用户模式,使用sudo测试,通过!

注:如果想要在使用sudo时不输入密码,可以把4处改为:

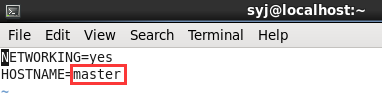

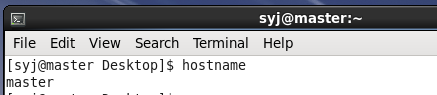

username ALL=(ALL)NOPASSWD:ALL1、修改下主机名为master

sudo vi /etc/sysconfig/network重启电脑后再查看结果:

修改主机名成功

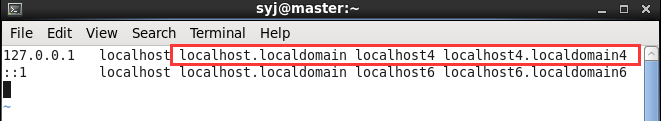

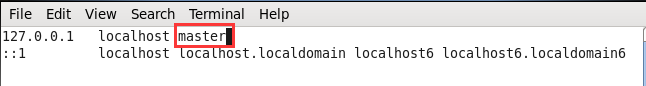

2、修改hosts中的主机名:

vi /etc/hosts修改为:

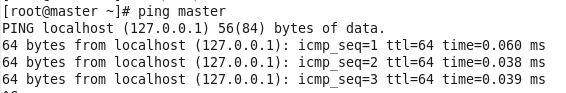

验证:

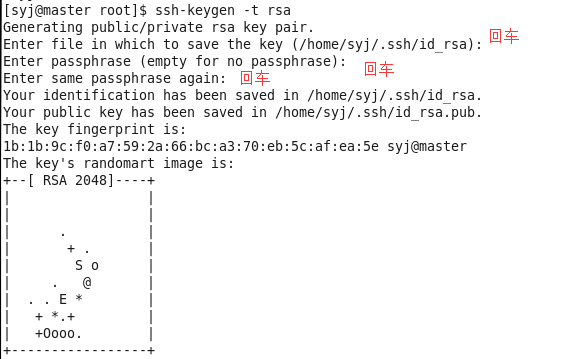

3、配置SSH:

ssh-keygen -t rsa经验之谈:不要用root用户,之后可能安装会遇到问题。

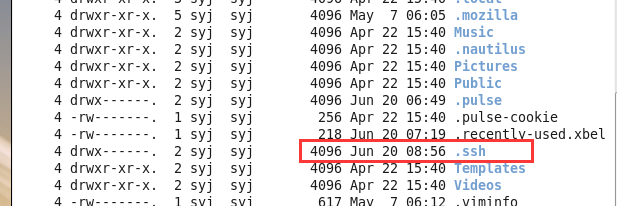

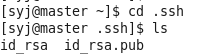

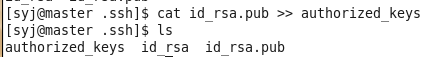

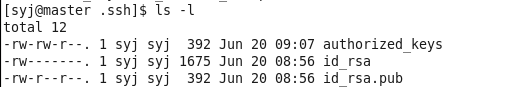

ls -lsa进入.ssh目录并生成authorized_keys文件:

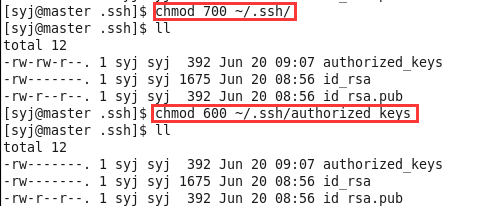

cat id_rsa.pub>>authorized_keys授权.ssh/文件夹权限为700,授权authorized_keys文件权限为600(or 644):

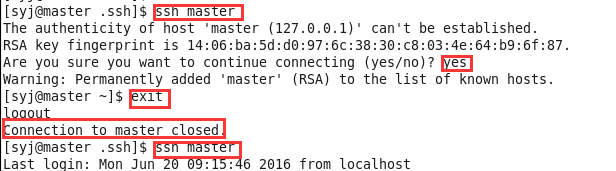

ssh验证:

4、jdk安装:

jdk官网下载:

http://www.oracle.com/technetwork/java/javase/downloads/index-jsp-138363.html

cd /home/syj/Downloads

sudo cp jdk-7u65-linux-x64.tar.gz /opt

cd /opt

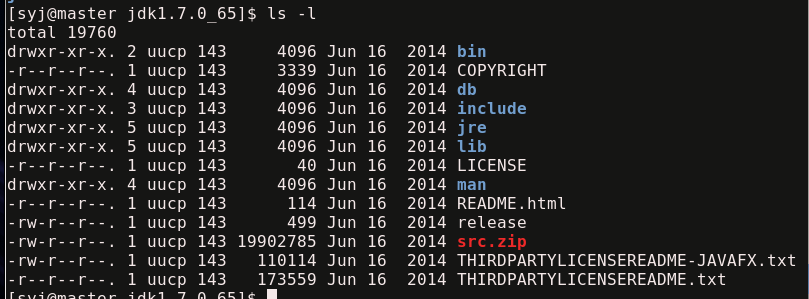

sudo tar -zxvf jdk-7u65-linux-x64.tar.gz

配置环境变量:

cd

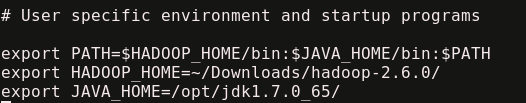

sudo vi .bash_profile保存,输入下面命令使之生效:

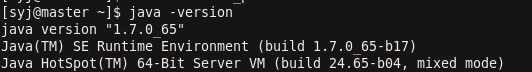

source .bash_profile验证是否安装成功:

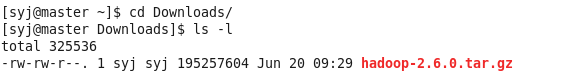

5、hadoop安装:

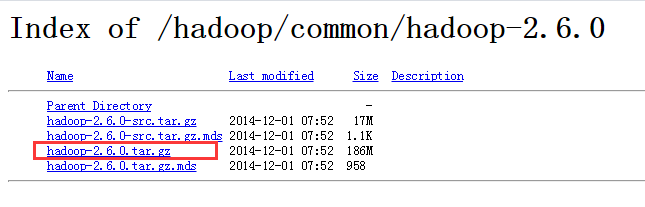

去官网下载安装包:http://apache.fayea.com/hadoop/common/hadoop-2.6.0/

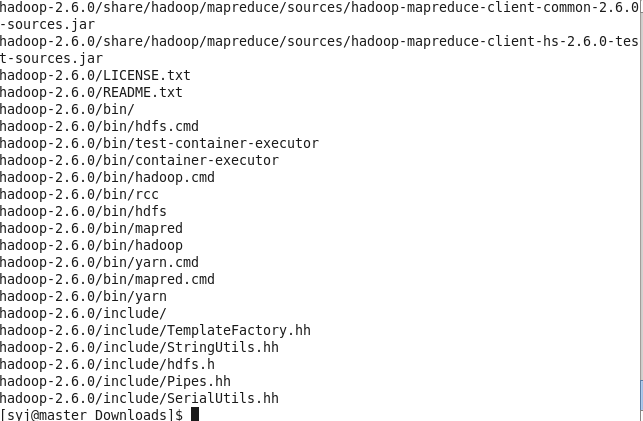

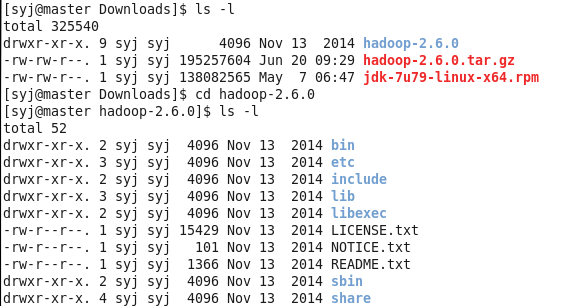

解压:

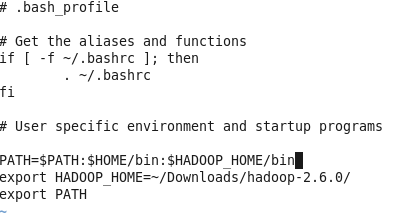

tar -zxvf hadoop-2.6.0.tar.gz修改系统配置文件,修改~/.bash_profile文件,增加HADOPP_HOME的bin文件夹到PATH中,修改后使用source命令使配置文件生效:

sudo vi ~/.bash_profile

使之有效:

source ~/.bash_profile

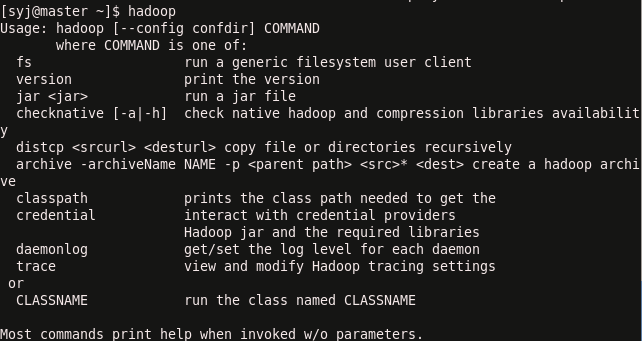

验证是否成功:

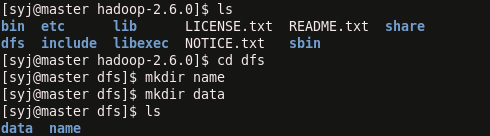

在hadoop目录下创建文件夹:

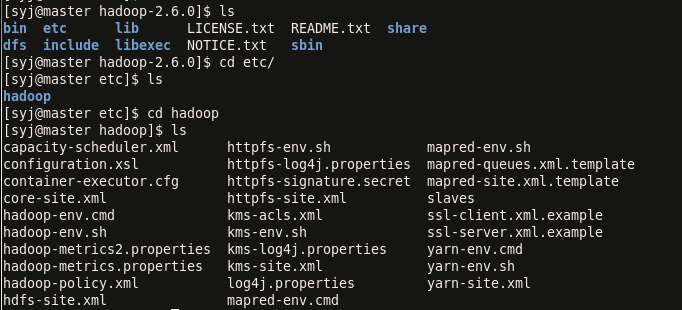

接下来开始修改hadoop的配置文件,首先进入hadoop2.6配置文件夹:

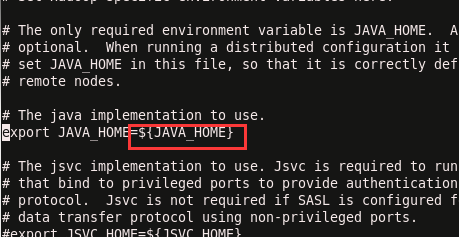

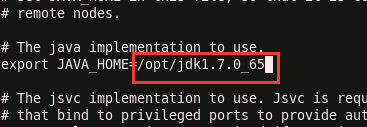

第一步修改配置文件hadoop-env.sh,加入”JAVA-HOME”,如下所示:

指定我们安装的“JAVA_HOME”:

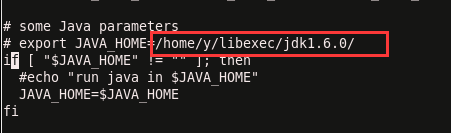

第二步修改配置文件”yarn-env.sh”,加入”JAVA_HOME”,如下所示:

指定我们安装的“JAVA_HOME”:

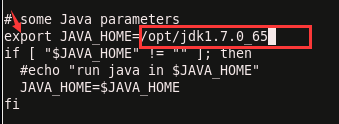

第三步 修改配置文件“mapred-env.sh”,加入“JAVA_HOME”,如下所示:

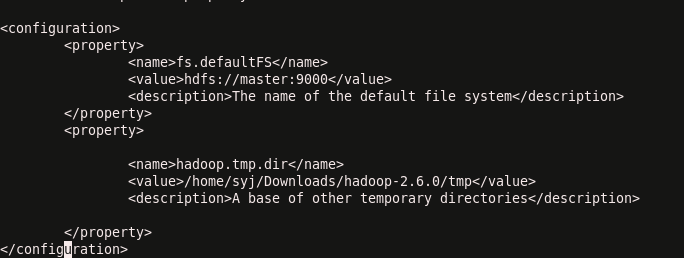

第五步 修改配置文件core-site.xml,这个是全局配置,如下所示:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

<description>The name of the default file system</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/syj/Downloads/hadoop-2.6.0/tmp</value>

<description>A base of other temporary directories</description>

</property>

</configuration>目前来说,core-site.xml文件的最小化配置,core-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.6.0/hadoop-project-dist/hadoop-common/core-default.xml

第六步 修改配置文件 hdfs-site.xml,如下所示:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/syj/hadoop-2.6.0/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/syj/hadoop-2.6.0/dfs/data</value>

</property>

</configuration>上述是hdfs-site.xml文件的最小化配置,hdfs-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.6.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml

第七步 修改配置文件 mapred-site.xml,如下所示:

copy mapred-site.xml.template命名为mapred-site.xml,打开mapred-site.xml,如下所示:

cp mapred-site.xml.template ~/Downloads/hadoop-2.6.0/etc/hadoop/mapred-site.xml<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>上述是mapred-site.xml最小化配置,mapred-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.6.0/hadoop-mapreduce-client/hadoop-mapreduce-client-core/mapred-default.xml

第八步 配置文件yarn-site.xml,如下所示:

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>上述内容是yarn-site.xml的最小化配置,yarn-site文件配置的各项内容可参考:http://hadoop.apache.org/docs/r2.6.0/hadoop-yarn/hadoop-yarn-common/yarn-default.xml

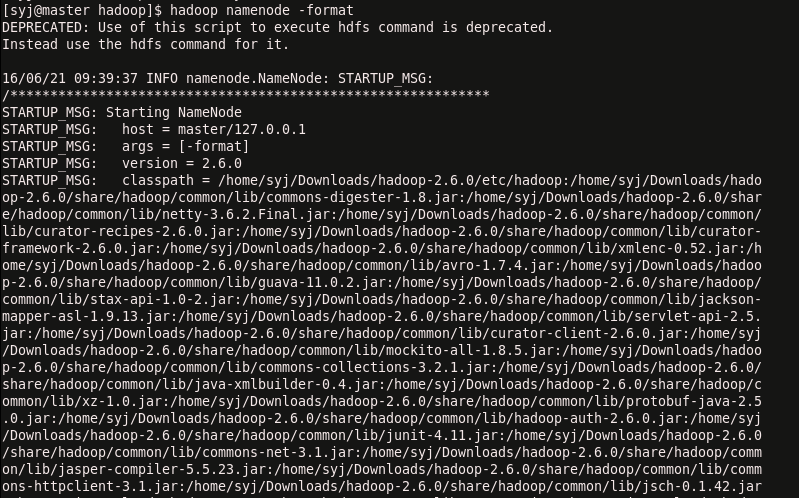

6、启动并验证hadoop伪分布式

第一步:格式化hdfs文件系统:

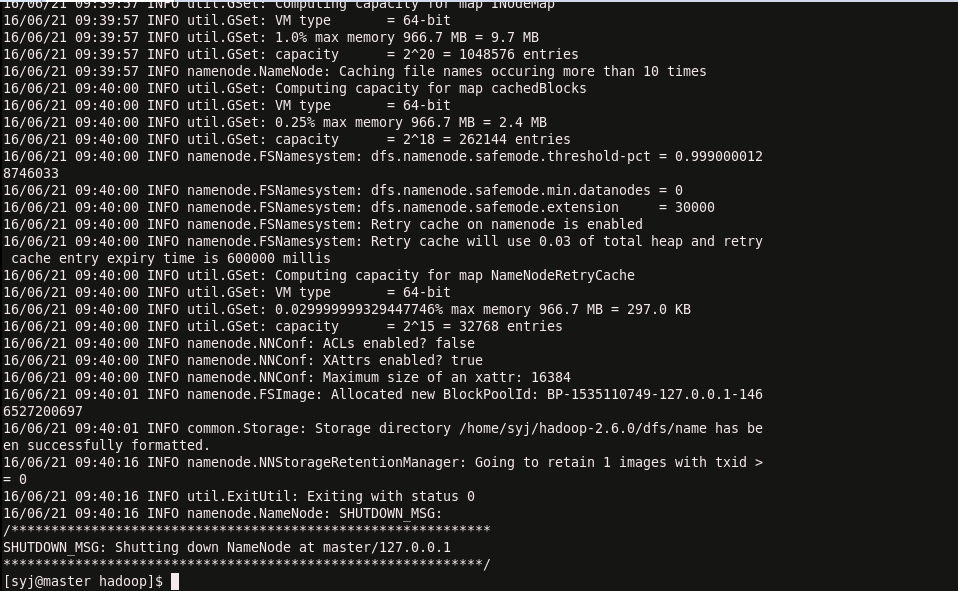

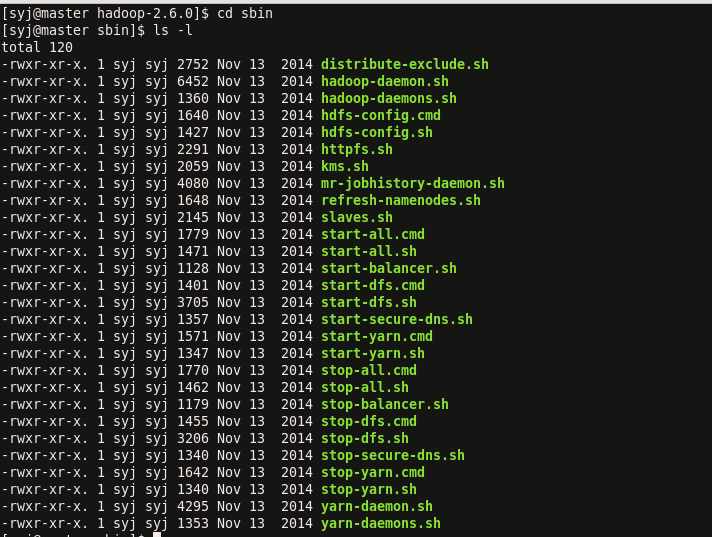

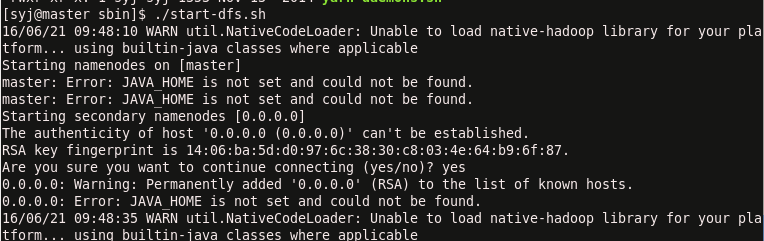

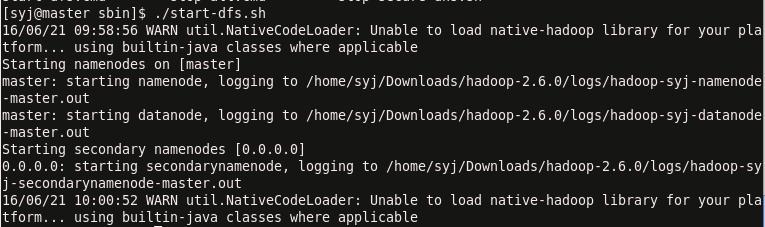

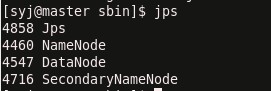

hadoop namenode -format第二步:进入sbin中启动hdfs,执行如下命令:

./start-dfs.sh这时输入jps后显示只开启了jps

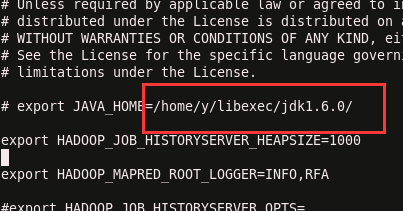

它提示说java_home没有,回到之前步骤,检查所有关于JAVA_HOME的内容,修改有误的,重新格式化,重新开启。

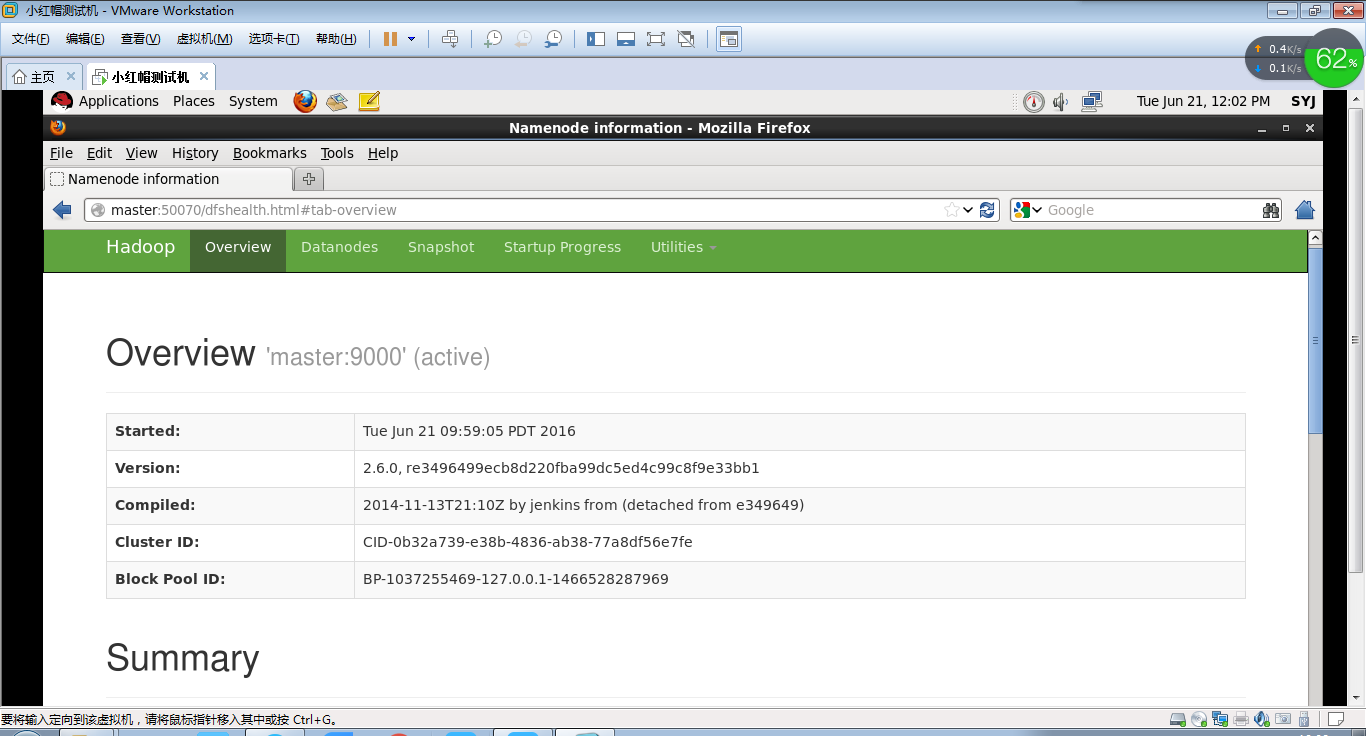

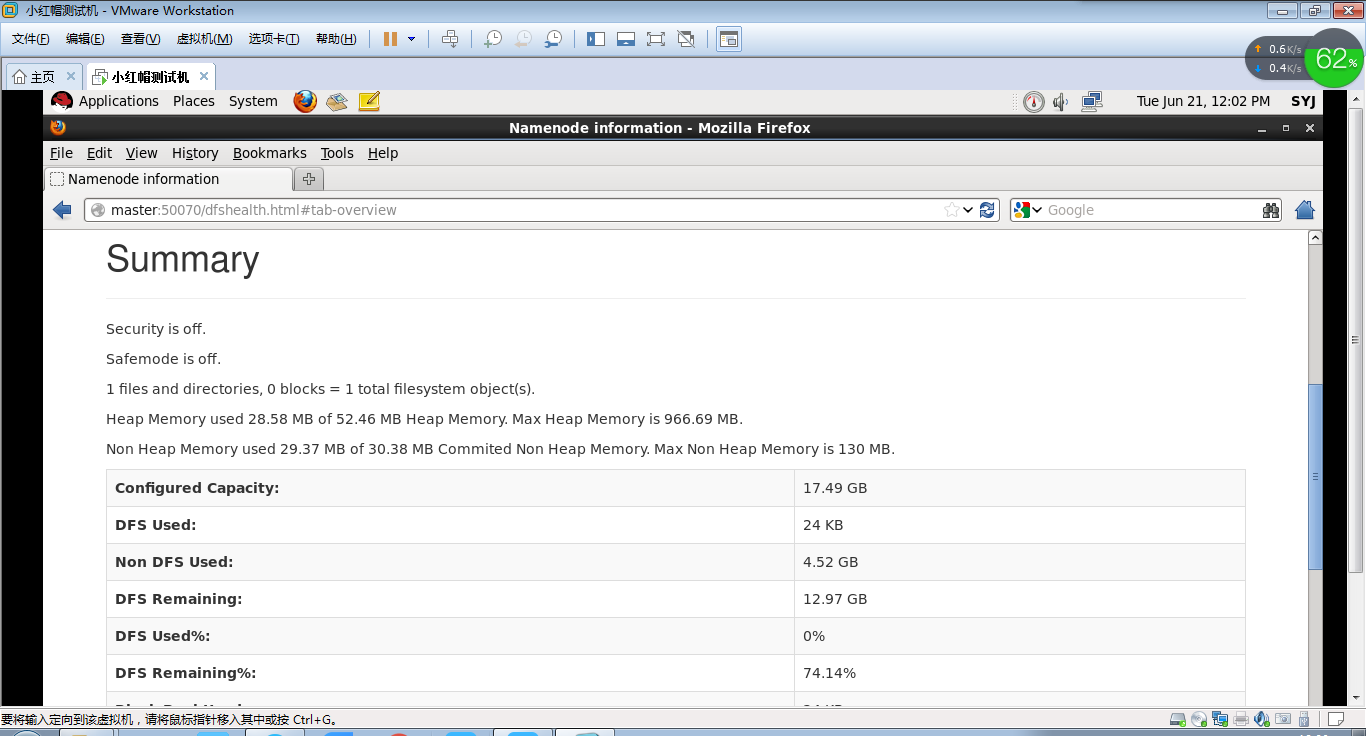

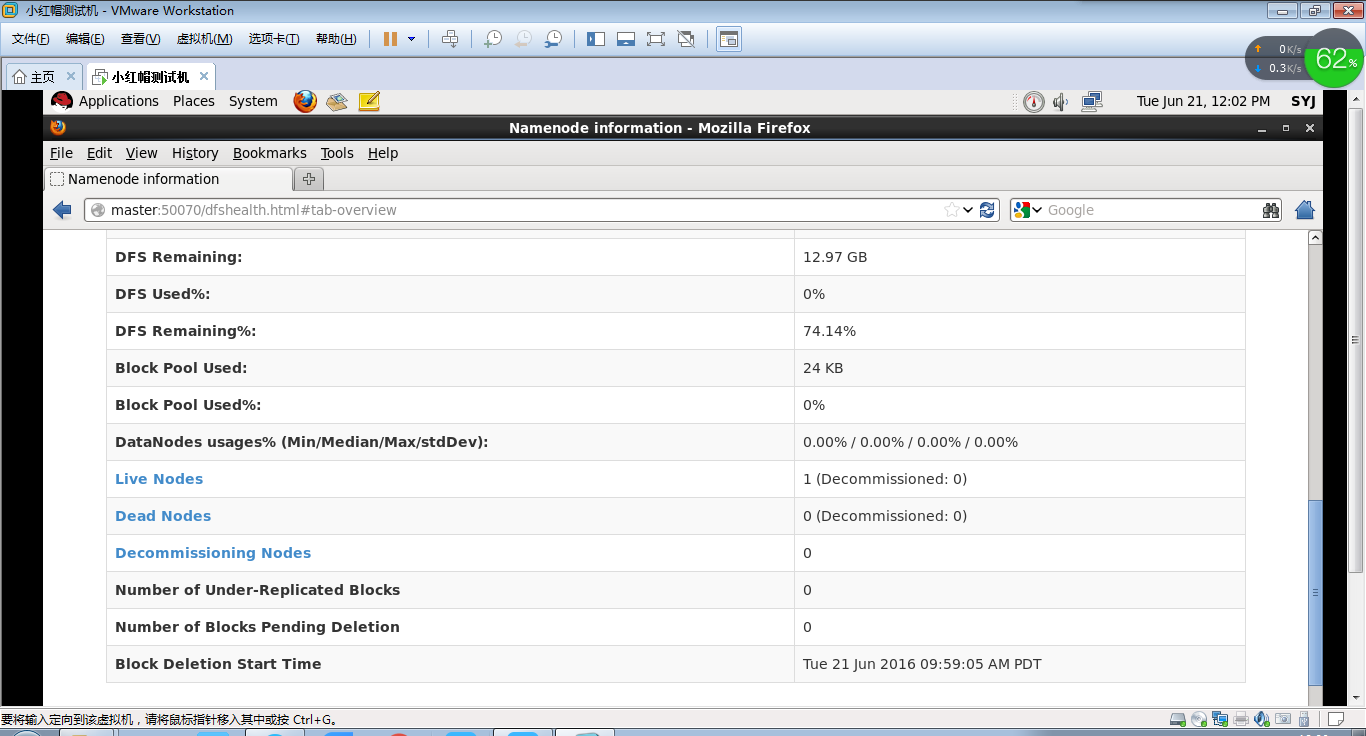

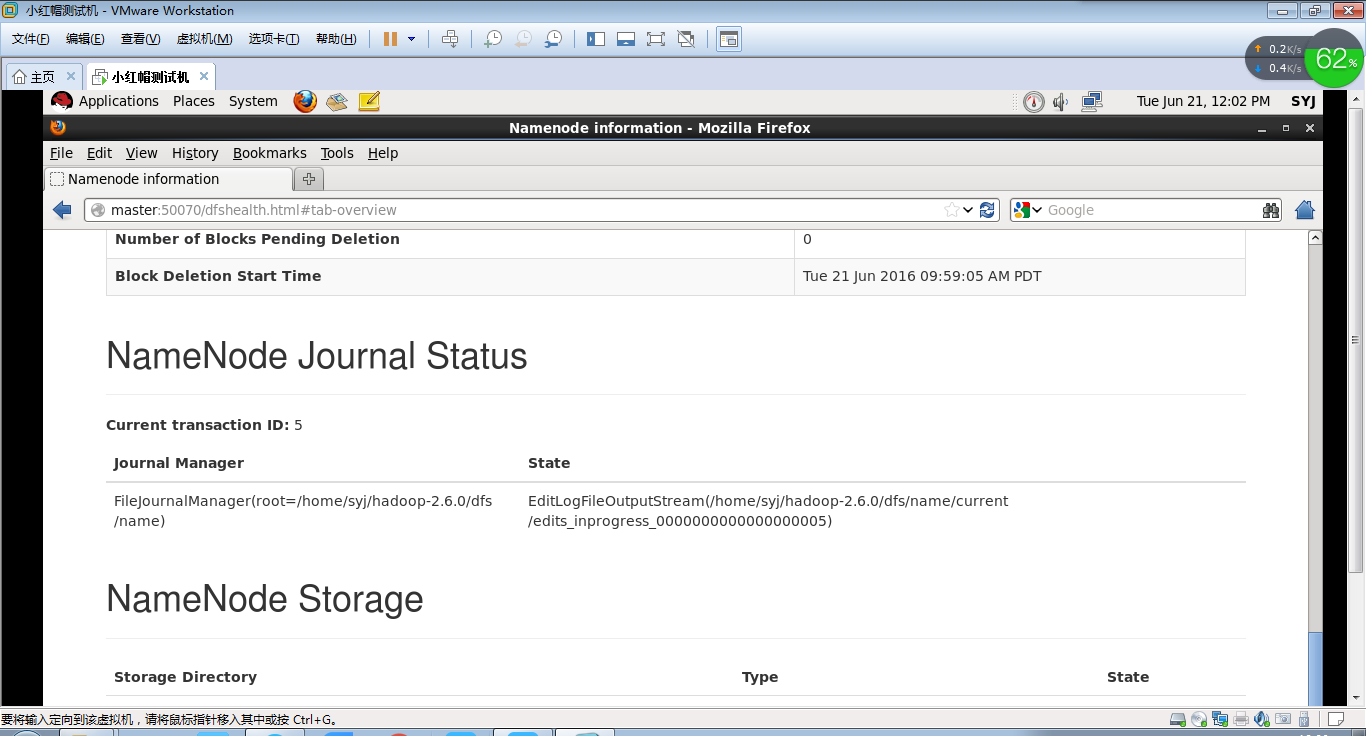

在虚拟机的火狐浏览器上输入http://master:50070/,通过web控制台查看hdfs。

遇到的问题

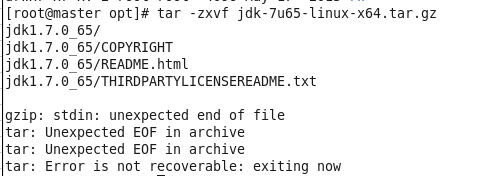

安装jdk:

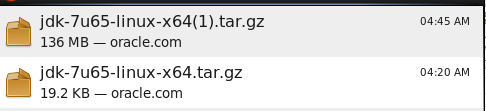

安装包有问题,下载的大小和真实的大小不一样,重新下载。

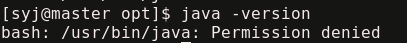

验证jdk安装是否成功:

我的java存放的位置应该是/opt,这里提到了/usr/bin/java,是之前安装了几次但没成功的,但是它们又没有写入环境变量中,所以遇到了这样的问题。

解决方案:删除

“`

sudo rm -rf /usr/bin/java

知识点解释

- 配置文件

配置hadoop,主要是配置core-site.xml,hdfs-site.xml,mapred-site.xml三个配置文件,默认下来,这些配置文件都是空的,所以很难知道这些配置文件有哪些配置可以生效,上网找的配置可能因为各个hadoop版本不同,导致无法生效。浏览更多的配置,有两个方法:

1.选择相应版本的hadoop,下载解压后,搜索*.xml,找到core-default.xml,hdfs-default.xml,mapred-default.xml,这些就是默认配置,可以参考这些配置的说明和key,配置hadoop集群。

2.浏览apache官网,三个配置文件链接如下:

http://hadoop.apache.org/common/docs/current/core-default.html

http://hadoop.apache.org/common/docs/current/hdfs-default.html

http://hadoop.apache.org/common/docs/current/mapred-default.html

这里是浏览hadoop当前版本号的默认配置文件,其他版本号,要另外去官网找。其中第一个方法找到默认的配置是最好的,因为每个属性都有说明,可以直接使用。另外,core-site.xml是全局配置,hdfs-site.xml和mapred-site.xml分别是hdfs和mapred的局部配置。

- hadoop web控制台页面的端口整理:

50070:hdfs文件管理

8088:ResourceManager

8042:NodeManager

19888:JobHistory(使用“mr-jobhistory-daemon.sh”来启动JobHistory Server)

博客说明

我第一次搭建hadoop完全分布式的文档下载链接:

http://download.csdn.net/detail/u012192235/9554411

csdn中一位前辈的伪分布式搭建博客:

http://blog.csdn.net/stark_summer/article/details/43484545

本实验室结合两次的文档搭建并完善的文档。

这个是我安装过程的截图,有一定的参考价值。

http://download.csdn.net/detail/u012192235/9555825

431

431

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?