task1绪论与深度学习概述、数学基础

(Datawhale31期组队学习)

文章目录

基础点

- 人工智能、机器学习与深度学习

- 起源与发展

- 重要的研究机构和著名科学家

- 深度学习的定义和主要应用

- 定义、理论和方法

- 主要应用

- 数学基础

- 张量、矩阵运算、矩阵基础、矩阵分解

- 概率统计、常见的(多变量)分布

- 信息论、熵、互信息、相对熵、交叉熵

- 最优化估计方法、最小二乘、线性模型

知识点

1 人工智能、机器学习与深度学习

概念区分

1.1 人工智能

利用数字计算机或者数字计算机控制的机器模拟、延伸 和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理 论、方法、技术及应用系统

1.2 机器学习

让计算机具有像人一样的学习和思考能力的技术的总称。具体来说是从已知数据中获得规律,并利用规律对未知数据进行预测的技术

1.2.1分类

> 有监督学习(SupervisedLearning)有老师,学生从老师那获得对错指示、最终答案的学习方法。跟老师评。

> 无监督学习(UnsupervisedLearning)没有老师,学生跟标准自学,跟着标准评价。自学标评

> 强化学习(ReinforcementLearning)没有老师,学生对问题答案自我评价。自学自评

1.2.2发展 1.2.3机构+科学家

1.2.3机构+科学家

-

Machine Learning at University of Toronto

- GeoffreyHinton:在BP算法,Boltzmannmachines, Time-delay neural nets, Variational learning and Deep learning做出杰出文献

- 深度学习之父;多伦多大学杰出教授;Google副总裁及首席科学顾问;英国皇家科学院院士,美国国家工 程院外籍院士,美国艺术与科学院 外籍院士

-

Deepmind at Google

-

AI research at Facebook

-

清华大学AI研究院

-

中国科学院自动化所

-

中国科学院数学与系统科学研究院

-

Tencent AI Lab

-

华为诺亚方舟实验室

-

阿里达摩院

-

Yann LeCun:卷积神经网络之父;纽约大学杰出教授;Facebook人工智能实验室负责人;纽约大学数据科学实验室创始人。在学习理论与学习算法、卷积神经 网络领域做出杰出文献。

-

Yoshua Bengio:蒙特利尔大学全职教授;加拿大统计学习算法研究主席;加拿大皇家科学院院士;CIFAR Senior Fellow;创办了ICLR国际会议。在MachineLearning,Deeplearning 领域做出杰出文献。

-

吴恩达(Andrew Ng):斯坦福大学计算机科学系和电子工程系副教授;在线教育平台Coursera的联合创始人(with Daphne Koller);2014年5月16日,吴恩达加入百度,担任百度公司首席科学家;2017年10月,吴恩达出任Woebot公司新任董事长。

2 深度学习的定义和主要应用

2.1 定义

通过训练多层网络结构对未知数据进行分类或回归

有监督学习方法

- 深度前馈网络

- 卷积神经网络

- 循环神经网络

无监督学习方法- 深度信念网

- 深度玻尔兹曼机

- 深度自编码器

2.2 应用

-

图像

- 物体识别:整幅图分类、识别

- 物体检测:检测图像中物体的位置进而识别物体

- 图像分割:对图像中的特定物体按边缘进行分割

- 图像回归:预测图像中物体组成部分的坐标

-

nlp

- 语言模型:根据之前词预测下一个单词

- 情感分析:分析文本体现的情感(正负向、正负中或多态度类型)

- 神经机器翻译:基于统计语言模型的多语种互译

- 神经自动摘要:根据文本自动生成摘要

- 机器阅读理解:通过阅读文本回答问题、完成选择题或完型填空

- 自然语言推理:根据一句话(前提)推理出另一句话(结论)

-

语音

- 语音识别:语音识别为文字

- 声纹识别:识别哪个人的声音

- 语音合成:根据文字合成特定人的语音

-

综合应用

- 图像描述:根据图像给出图像的描述句子

- 可视问答:根据图像或视频回答问题

- 图像生成:根据文本描述生成图像

- 视频生成:根据故事自动生成视频

3 数学基础

3.1 矩阵论

-

矩阵:二维数组,其中的每个元素一般由两个索引来确定一般用大写变量表示,m行n列的实数矩阵,记做 A ∈ R m × n A \in R_{m \times n} A∈Rm×n

-

张量(Tensor):矢量的推广,表示在一些矢量、标量和其他张量之间的线性关系的多线性函数。标量是0阶张量,矢量是一阶张量,矩阵是二阶张量,三维及以上数组一般称张量。

-

矩阵的秩(Rank):矩阵列向量中的极大线性无关组的数目,记作矩阵的列秩,也可定义行秩。行秩=列秩=矩阵的秩,通常记作rank(A)。

-

矩阵的逆s

- A为方阵,当 r a n k ( A n × n ) < n rank(A_{n \times n})<n rank(An×n)<n时,A为奇异矩阵或不可逆矩阵

- A为方阵,当 r a n k ( A n × n ) = n rank(A_{n \times n})=n rank(An×n)=n时,A为非奇异矩阵或可逆矩阵

- 其逆矩阵

A

−

1

A^{-1}

A−1满足以下条件,称

A

−

1

A^{-1}

A−1为矩阵A的逆矩阵:

A A − 1 = A − 1 A = I n AA^{-1} = A^{-1}A = I_{n} AA−1=A−1A=In

其中, I n I_{n} In 是 n × n n \times n n×n的单位阵。

-

矩阵的广义逆矩阵

- 矩阵不为方阵或者是奇异矩阵,不存在逆矩阵,但是可以计算其广义逆矩阵或者伪逆矩阵;

- 矩阵A,若存在矩阵B使得 A B A = A ABA=A ABA=A,B为A的广义逆矩阵

-

矩阵分解

- 特征向量:若矩阵 A为方阵,则存在非零向量x和常数 λ \lambda λ满足 A x = λ x Ax=\lambda x Ax=λx,则称 λ \lambda λ为矩阵 A A A的一个特征值,x为矩阵A 关于 λ \lambda λ 的特征向量。

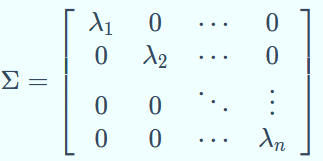

- A n × n A_{n \times n} An×n 的矩阵具有 n 个特征值, λ 1 ≤ λ 2 ≤ ⋯ ≤ λ n λ_1 ≤ λ_2 ≤ ⋯ ≤ λ_n λ1≤λ2≤⋯≤λn 其对应的n个特征向量为 𝒖 1 𝒖_1 u1, 𝒖 2 𝒖_2 u2,⋯, 𝒖 n 𝒖_n un

- 矩阵的迹trace: t r ( A ) = ∑ i = 1 n λ i tr(A)=\sum_{i=1}^n\lambda_i tr(A)=∑i=1nλi

- 行列式determinant: ∣ A ∣ = ∏ i = 1 n λ i ∣A∣=\prod_{i=1}^n \lambda_i ∣A∣=∏i=1nλi

-

矩阵特征分解

A n × n A_{n \times n} An×n 的矩阵具有n个不同的特征值,那么矩阵A可以分解为 A = U Σ U T A = U\Sigma U^{T} A=UΣUT

其中,

U

=

[

𝒖

1

,

𝒖

2

,

.

.

.

,

𝒖

n

]

U=[𝒖_1,𝒖_2,...,𝒖_n]

U=[u1,u2,...,un],

∣

∣

𝒖

i

∣

∣

2

=

1

||𝒖_i||_2 = 1

∣∣ui∣∣2=1

U

=

[

𝒖

1

,

𝒖

2

,

.

.

.

,

𝒖

n

]

U=[𝒖_1,𝒖_2,...,𝒖_n]

U=[u1,u2,...,un],

∣

∣

𝒖

i

∣

∣

2

=

1

||𝒖_i||_2 = 1

∣∣ui∣∣2=1 -

矩阵奇异值分解

对于任意矩阵 A m × n A_{m \times n} Am×n,存在正交矩阵 U m × m U_{m \times m} Um×m和 V n × n V_{n \times n} Vn×n,使其满足 A = U ∑ V T A = U\sum V^T A=U∑VT, U T U = V T V = I U^TU=V^TV=I UTU=VTV=I,则称上式为矩阵A的特征分解。

3.2 概率统计

- 随机变量(Random variable):随机事件的数量表现,随机事件数量化的好处是可以用数学分析的方法来研究随机现象。

- 离散:拥有有限个或者可列无限多个状态的随机变量

- 连续:变量值不可随机列举出来的随机变量,一般取实数值。

- 随机变量通常用概率分布来指定它的每个状态的可能性。

- 常见概率分布

- 伯努利分布:又称0-1分布,单个二值型离散随机变量的分布

- 概率分布: P ( X = 1 ) = p P(X=1)=p P(X=1)=p, P ( X = 0 ) = 1 − p P(X=0)=1−p P(X=0)=1−p

- 二项分布即重复n次伯努利试验,各试验之间都相互独立

- 如果每次试验时,事件发生的概率为p,不发生的概率为1-p,则n次重复独立试验中事件发生k次的概率为: P ( X = k ) = C n k p k ( 1 − p ) n − k P(X=k)=C_n^kp^k(1−p)^{n−k} P(X=k)=Cnkpk(1−p)n−k

- 均匀分布,矩形分布,在给定长度间隔[a,b]内的分布概率是等可能的,均匀分布由参数a,b定义,概率密度函数为

p

(

x

)

=

1

b

−

a

p(x)=\frac {1} {b-a}

p(x)=b−a1,

a

<

x

<

b

a<x<b

a<x<b

- 高斯分布,又称正态分布(normal),是实数中最常用的分布,由均值 μ μ μ和标准差 σ σ σ决定其分布,概率密度函数为: p ( x ) = 1 2 π σ e − ( x − μ ) 2 2 σ 2 p(x)=\frac {1}{\sqrt{2\pi}\sigma}e^{-\frac{(x-\mu)^2}{2\sigma^2}} p(x)=2πσ1e−2σ2(x−μ)2

- 指数分布:独立随机事件发生的时间间隔,参数为λ>0的指数分布概率密度函数为: p ( x ) = λ e − λ x x ≥ 0 p(x) = \lambda e^{-\lambda x} \quad x \geq 0 p(x)=λe−λxx≥0. 指数分布重要特征是无记忆性

- 伯努利分布:又称0-1分布,单个二值型离散随机变量的分布

- 多变量概率分布

- 条件概率(conditional probability)事件X在事件Y发生的条件下发生的概率 P ( X ∣ Y ) P(X|Y) P(X∣Y)

- 联合概率(joint probability)表示两个事件X和Y共同发生的概率, P ( X , Y ) P(X,Y) P(X,Y)

- 条件概率和联合概率的性质:

- P ( X ∣ Y ) = P ( X , Y ) P ( Y ) P ( Y ) > 0 P(X|Y)=\frac{P(X,Y)}{P(Y)} \quad P(Y)>0 P(X∣Y)=P(Y)P(X,Y)P(Y)>0

- 推广n个事件: P ( X 1 , X 2 , . . . , X n ) = P ( X 1 ∣ X 2 , . . . , X n ) P ( X 2 ∣ X 3 , . . . , X n ) . . . P ( x n − 1 ∣ X n ) P ( X n ) = P ( X n ) Π i = 1 n − 1 P ( X i ∣ X i + 1 , . . . , X n ) P(X_1,X_2,...,X_n)=P(X_1|X_2,...,X_n)P(X_2|X_3,...,X_n)...P(x_n-1|X_n)P(X_n)=P(X_n)\Pi_{i=1}^{n-1}P(X_i|X_i+1,...,X_n) P(X1,X2,...,Xn)=P(X1∣X2,...,Xn)P(X2∣X3,...,Xn)...P(xn−1∣Xn)P(Xn)=P(Xn)Πi=1n−1P(Xi∣Xi+1,...,Xn)

- 先验概率(Prior probability)根据以往经验和分析得到的概率,在事件发生前已知,作为“由因求果”的“因”

- 后验概率(Posterior probability)得到“结果”的信息后重新修正的概率,是“执果寻因”问题中 的“因”,后验概率是基于新的信息,修正后来的先验概率所获得的更接近实际情况的概率估计。

- P ( A = 1 ∣ B = 1 ) = P ( A = 1 ) P ( B = 1 ∣ A = 1 ) P ( B = 1 ) P(A=1∣B=1)=\frac {P(A=1)P(B=1∣A=1)}{P(B=1)} P(A=1∣B=1)=P(B=1)P(A=1)P(B=1∣A=1)

- 全概率公式:设事件 A i {A_i} Ai是样本空间 Ω Ω Ω 的一个划分,且 P ( A i ) > 0 ( i = 1 , 2 , . . . , n ) P(A_i)>0(i=1,2,...,n) P(Ai)>0(i=1,2,...,n),那么:事件B发生的可能性: P ( B ) = ∑ i = 1 n P ( A i ) P ( B ∣ A i ) P(B) = \sum_{i = 1}^nP(A_i)P(B|A_i) P(B)=∑i=1nP(Ai)P(B∣Ai)

- 贝叶斯公式:全概率公式给我们提供了计算后验概率的途径,即贝叶斯公式,事件B发生是事件 A i A_i Ai促成的可能性, P ( A i ∣ B ) = P ( B ) P ( B ∣ A i ) P ( A i ) = ∑ j = 1 n P ( A j ) P ( B ∣ A j ) P ( B ∣ A i ) P ( A i ) P( Ai∣B)=P( B)P( B∣Ai)P( Ai)=∑j=1nP( Aj)P( B∣Aj)P( B∣Ai)P( Ai) P(Ai∣B)=P(B)P(B∣Ai)P(Ai)=∑j=1nP(Aj)P(B∣Aj)P(B∣Ai)P(Ai)

- 常用统计量

- 方差: 衡量随机变量与数学期望之间的偏离程度,统计中的方差则为样本方差,是各个样本数据分别与其平均数之差 的平方和的平均数

V a r ( X ) = E [ x − E ( x ) ] 2 = E ( x 2 ) − [ E ( x ) ] 2 Var(X)=E{[x-E(x)]^2}=E(x^2)-[E(x)]^2 Var(X)=E[x−E(x)]2=E(x2)−[E(x)]2 - 协方差:衡量两个随机变量X和Y直接的总体误差

C o v ( X , Y ) = E [ x − E ( x ) ] [ y − E ( y ) ] = E ( x y ) − E ( x ) E ( y ) Cov(X,Y)=E{[x-E(x)][y-E(y)]}=E(xy)-E(x)E(y) Cov(X,Y)=E[x−E(x)][y−E(y)]=E(xy)−E(x)E(y)

- 方差: 衡量随机变量与数学期望之间的偏离程度,统计中的方差则为样本方差,是各个样本数据分别与其平均数之差 的平方和的平均数

3.3 信息论

- 熵(Entropy):信息熵,可以看作是样本集合纯度一种指标,也可以认为是样本集合包含的平均信息量。

- 假定当前样本集合X中第

i

i

i类样本

𝑥

𝑖

𝑥_𝑖

xi 所占的比例为

P

(

𝑥

𝑖

)

(

i

=

1

,

2

,

.

.

.

,

n

)

P(𝑥_𝑖)(i=1,2,...,n)

P(xi)(i=1,2,...,n),则

X

X

X的信息熵定义为

H

(

X

)

=

−

∑

i

=

1

n

P

(

x

i

)

l

o

g

2

P

(

x

i

)

H(X)=-\sum_{i=1}^nP(x_i)log_2P(x_i)

H(X)=−i=1∑nP(xi)log2P(xi)

H(X)的值越小,则X的纯度越高,蕴含的不确定性越少

- 假定当前样本集合X中第

i

i

i类样本

𝑥

𝑖

𝑥_𝑖

xi 所占的比例为

P

(

𝑥

𝑖

)

(

i

=

1

,

2

,

.

.

.

,

n

)

P(𝑥_𝑖)(i=1,2,...,n)

P(xi)(i=1,2,...,n),则

X

X

X的信息熵定义为

H

(

X

)

=

−

∑

i

=

1

n

P

(

x

i

)

l

o

g

2

P

(

x

i

)

H(X)=-\sum_{i=1}^nP(x_i)log_2P(x_i)

H(X)=−i=1∑nP(xi)log2P(xi)

- 联合熵:两个随机变量X和Y联合分布可以形成联合熵,度量二维随机变量XY的不确定性:

H ( X , Y ) = − ∑ i = 1 n ∑ j = 1 n P ( x i , y j ) l o g 2 P ( x i , y i ) H(X,Y)=-\sum_{i=1}^n\sum_{j=1}^nP(x_i,y_j)log_2P(x_i,y_i) H(X,Y)=−i=1∑nj=1∑nP(xi,yj)log2P(xi,yi) - 条件熵

在随机变量X发生的前提下,随机变量Y发生带来的熵,定义为Y的条件熵,用H(Y|X)表示

H ( Y ∣ X ) = ∑ i = 1 n P ( x i ) H ( Y ∣ X = x i ) = − ∑ i = 1 n P ( x i ) ∑ j = 1 n P ( y i ∣ x i ) l o g 2 P ( y i ∣ x i ) = − ∑ i = 1 n ∑ j = 1 n P ( x i , y i ) l o g 2 P ( y i ∣ x i ) H(Y|X)=\sum_{i=1}^nP(x_i)H(Y|X=x_i)=-\sum_{i=1}^nP(x_i)\sum_{j=1}^nP(y_i|x_i)log_2P(y_i|x_i)=-\sum_{i=1}^n\sum_{j=1}^nP(x_i,y_i)log_2P(y_i|x_i) H(Y∣X)=i=1∑nP(xi)H(Y∣X=xi)=−i=1∑nP(xi)j=1∑nP(yi∣xi)log2P(yi∣xi)=−i=1∑nj=1∑nP(xi,yi)log2P(yi∣xi)- 条件熵用来衡量在已知随机变量X的条件下,随机变量Y的不确定。

- 熵、联合熵和条件熵之间的关系: H ( Y ∣ X ) = H ( X , Y ) − H ( X ) H(Y|X) = H(X,Y)-H(X) H(Y∣X)=H(X,Y)−H(X).

- 互信息

I ( X ; Y ) = H ( X ) + H ( Y ) − H ( X , Y ) I(X;Y)=H(X)+H(Y)-H(X,Y) I(X;Y)=H(X)+H(Y)−H(X,Y)

- 相对熵:相对熵又称KL散度,是描述两个概率分布P和Q差异的一种方法,记做

D

(

P

∣

∣

Q

)

D(P||Q)

D(P∣∣Q)。在信息论中,

D

(

P

∣

∣

Q

)

D(P||Q)

D(P∣∣Q)表示用概率分布Q来拟合真实分布P时,产生的信息表达的损耗,其中P表示信源的真实分布,Q表示P的近似分布。

- 离散 D ( P ∣ ∣ Q ) = ∑ P ( x ) l o g P ( x ) Q ( x ) D(P||Q)=\sum P(x)log\frac{P(x)}{Q(x)} D(P∣∣Q)=∑P(x)logQ(x)P(x)

- 连续 D ( P ∣ ∣ Q ) = ∫ P ( x ) l o g P ( x ) Q ( x ) D(P||Q)=\int P(x)log\frac{P(x)}{Q(x)} D(P∣∣Q)=∫P(x)logQ(x)P(x)

- 交叉熵

求目标与预测值之间的差距,深度学习中经常用到的一类损失函数度量,比如在对抗生成网络( GAN )中

D ( P ∣ ∣ Q ) = ∑ P ( x ) l o g P ( x ) Q ( x ) = ∑ P ( x ) l o g P ( x ) − ∑ P ( x ) l o g Q ( x ) = − H ( P ( x ) ) − ∑ P ( x ) l o g P ( x ) D(P||Q)=\sum P(x)log\frac{P(x)}{Q(x)}=\sum P(x)logP(x)-\sum P(x)logQ(x)=-H(P(x))-\sum P(x)logP(x) D(P∣∣Q)=∑P(x)logQ(x)P(x)=∑P(x)logP(x)−∑P(x)logQ(x)=−H(P(x))−∑P(x)logP(x)

交叉熵: H ( P , Q ) = − ∑ P ( x ) l o g Q ( x ) H(P,Q)=-\sum P(x)logQ(x) H(P,Q)=−∑P(x)logQ(x)

3.4 最优化估计

最小二乘估计:最小平方法,是一种数学优化方法,最小化误差的平方和寻找数据的最佳函数匹配

- 回归,方便地求得未知参数,比如曲线拟合、最小化能量或者最大化熵等问题。

参考

- https://datawhalechina.github.io/unusual-deep-learning

3429

3429

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?