1 什么是SolrCloud

SolrCloud(solr 云)是Solr提供的分布式搜索方案,当你需要大规模,容错,分布式索引和检索能力时使用 SolrCloud。当一个系统的索引数据量少的时候是不需要使用SolrCloud的,当索引量很大,搜索请求并发很高,这时需要使 用SolrCloud来满足这些需求。

SolrCloud是基于Solr和Zookeeper的分布式搜索方案,它的主要思想是使用Zookeeper作为集群的配置信息中心。

它有几个特色功能:

1)集中式的配置信息

2)自动容错

3)近实时搜索

4)查询时自动负载均衡

1.1 Zookeeper是个什么玩意?

顾名思义zookeeper就是动物园管理员,他是用来管hadoop(大象)、Hive(蜜蜂)、pig(小猪)的管理员, Apache Hbase和 Apache Solr 的分布式集群都用到了zookeeper;Zookeeper:是一个分布式的、开源的程序协调服务,是hadoop项目下的一个子项目。

1.2 Zookeeper可以干哪些事情

1、配置管理

在我们的应用中除了代码外,还有一些就是各种配置。比如数据库连接等。一般我们都是使用配置文件的方式,在代码中引入这些配置文件。但是当我们只有一种配置,只有一台服务器,并且不经常修改的时候,使用配置文件是一个很好的做法,但是如果我们配置非常多,有很多服务器都需要这个配置,而且还可能是动态的话使用配置文件就不是个好主意了。这个时候往往需要寻找一种集中管理配置的方法,我们在这个集中的地方修改了配置,所有对这个配置感兴趣的都可以获得变更。比如我们可以把配置放在数据库里,然后所有需要配置的服务都去这个数据库读取配置。但是,因为很多服务的正常运行都非常依赖这个配置,所以需要这个集中提供配置服务的服务具备很高的可靠性。一般我们可以用一个集群来提供这个配置服务,但是用集群提升可靠性,那如何保证配置在集群中的一致性呢? 这个时候就需要使用一种实现了一致性协议的服务了。Zookeeper就是这种服务,它使用Zab这种一致性协议来提供一致性。现在有很多开源项目使用Zookeeper来维护配置,比如在HBase中,客户端就是连接一个Zookeeper,获得必要的HBase集群的配置信息,然后才可以进一步操作。还有在开源的消息队列Kafka中,也使用Zookeeper来维护broker的信息。在Alibaba开源的SOA框架Dubbo中也广泛的使用Zookeeper管理一些配置来实现服务治理。

2、名字服务

名字服务这个就很好理解了。比如为了通过网络访问一个系统,我们得知道对方的IP地址,但是IP地址对人非常不友好,这个时候我们就需要使用域名来访问。但是计算机是不能是别域名的。怎么办呢?如果我们每台机器里都备有一份域名到IP地址的映射,这个倒是能解决一部分问题,但是如果域名对应的IP发生变化了又该怎么办呢?于是我们有了DNS这个东西。我们只需要访问一个大家熟知的(known)的点,它就会告诉你这个域名对应的IP是什么。在我们的应用中也会存在很多这类问题,特别是在我们的服务特别多的时候,如果我们在本地保存服务的地址的时候将非常不方便,但是如果我们只需要访问一个大家都熟知的访问点,这里提供统一的入口,那么维护起来将方便得多了。

3、分布式锁

其实在第一篇文章中已经介绍了Zookeeper是一个分布式协调服务。这样我们就可以利用Zookeeper来协调多个分布式进程之间的活动。比如在一个分布式环境中,为了提高可靠性,我们的集群的每台服务器上都部署着同样的服务。但是,一件事情如果集群中的每个服务器都进行的话,那相互之间就要协调,编程起来将非常复杂。而如果我们只让一个服务进行操作,那又存在单点。通常还有一种做法就是使用分布式锁,在某个时刻只让一个服务去干活,当这台服务出问题的时候锁释放,立即fail over到另外的服务。这在很多分布式系统中都是这么做,这种设计有一个更好听的名字叫LeaderElection(leader选举)。比如HBase的Master就是采用这种机制。但要注意的是分布式锁跟同一个进程的锁还是有区别的,所以使用的时候要比同一个进程里的锁更谨慎的使用。

4、集群管理

在分布式的集群中,经常会由于各种原因,比如硬件故障,软件故障,网络问题,有些节点会进进出出。有新的节点加入进来,也有老的节点退出集群。这个时候,集群中其他机器需要感知到这种变化,然后根据这种变化做出对应的决策。比如我们是一个分布式存储系统,有一个中央控制节点负责存储的分配,当有新的存储进来的时候我们要根据现在集群目前的状态来分配存储节点。这个时候我们就需要动态感知到集群目前的状态。还有,比如一个分布式的SOA架构中,服务是一个集群提供的,当消费者访问某个服务时,就需要采用某种机制发现现在有哪些节点可以提供该服务(这也称之为服务发现,比如Alibaba开源的SOA框架Dubbo就采用了Zookeeper作为服务发现的底层机制)。还有开源的Kafka队列就采用了Zookeeper作为Cosnumer的上下线管理。

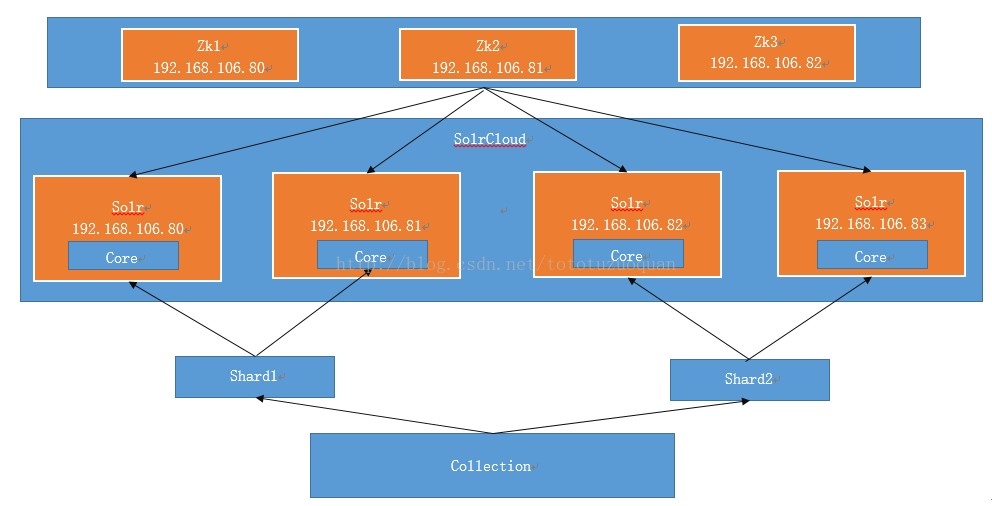

2 Solr集群的结构

3 Solr集群的搭建

本教程的这套安装是单机版的安装,所以采用伪集群的方式进行安装,如果是真正的生产环境,将伪集群的ip改下就可以了,步骤是一样的。

SolrCloud结构图如下:

需要三个zookeeper节点

四个solr节点

4 Zookeeper集群的搭建

4.1 软件环境

三个zookeeper实例。Zookeeper也是java开发的所以需要安装jdk。

1、Linux系统

2、Jdk环境。

3、Zookeeper。

服务器及软件信息信息

| 1 | 192.168.106.80 | 服务器上的位置:/usr/local/apache-tomcat-7.0.73 |

| 服务器ip和端口号:192.168.106.80:8080 | ||

| JDK-Version: 1.7.0_79 | ||

| Zookeeper: /home/tuzq/software/zookeeper | ||

| 2 | 192.168.106.81 | 服务器上的位置:/usr/local/apache-tomcat-7.0.73 |

| 服务器ip和端口号:192.168.106.81:8080 | ||

| JDK-Version: 1.7.0_79 | ||

| Zookeeper: /home/tuzq/software/zookeeper | ||

| 3 | 192.168.106.82 | 服务器上的位置:/usr/local/apache-tomcat-7.0.73 |

| 服务器ip和端口号:192.168.106.82:8080 | ||

| JDK-Version: 1.7.0_79 | ||

| Zookeeper: /home/tuzq/software/zookeeper | ||

| 4 | 192.168.106.83 | 服务器上的位置:/usr/local/apache-tomcat-8.5.12 |

| 服务器ip和端口号:192.168.106.83:8080 | ||

| JDK-Version: 1.7.0_79 |

使用伪分布式实现solr集群。需要三个zookeeper实例,4个tomcat实例,可以在一台虚拟机上模拟。建议虚拟机1G以上内存。

其中,192.168.106.83服务器上的tomcat是8.5的,当然也可以从其它服务器上拷贝一个完整的过来,使用命令如下:

| [root@hadoop3 local]# ls apache-tomcat-7.0.73 bin etc games include java lib lib64 libexec redis sbin share solrcloud src [root@hadoop3 local]# pwd /usr/local ##下面的意思是从当前的/usr/local中将apache-tomcat-7.0.73拷贝到192.168.106.83的root用户下的/usr/local目录下。 [root@hadoop3 local]# scp -r apache-tomcat-7.0.73 root@192.168.106.83:/usr/local/ The authenticity of host '192.168.106.83 (192.168.106.83)' can't be established. RSA key fingerprint is dc:55:2c:80:6a:9e:3d:a5:56:d7:0d:41:ba:d2:56:3c. Are you sure you want to continue connecting (yes/no)? yes Warning: Permanently added '192.168.106.83' (RSA) to the list of known hosts. root@192.168.106.83's password: 拷贝完后,进入83的/usr/local下查看内容 [root@localhost local]# pwd /usr/local [root@localhost local]# ls apache-tomcat-7.0.73 apache-tomcat-8.5.12 bin etc games include jdk1.8.0_73 lib lib64 libexec sbin share solrcloud src [root@localhost local]# |

4.2 Zookeeper的安装步骤

关于Zookeeper的集群安装配置参考:http://blog.csdn.net/tototuzuoquan/article/details/54003140

5 Solr实例的搭建

第一步:在4台服务器上分别安装tomcat,具体的软件安信息参考上面的4.1章节。

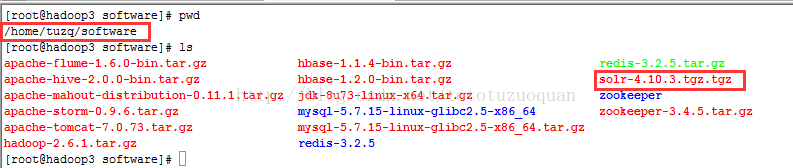

第二步:将solr-4.10.3.tgz.tgz分别上传到/home/tuzq/software下。

效果图如下:

解压solr-4.10.3.tar.gz压缩包。

| cd /home/tuzq/software tar –zxvf solr-4.10.3.tgz.tgz 解压命令执行完成之后执行ls命令,当前所在目录下多了一个solr-4.10.3 [root@localhost software]# ls apache-tomcat-8.5.12.tar.gz jdk-8u73-linux-x64.tar.gz solr-4.10.3 solr-4.10.3.tgz.tgz |

从压缩包中复制solr.war到tomcat。

| 其中192.168.106.80、192.168.106.81、192.168.106.82,192.168.106.83这三台服务器执行的命令如下: [root@hadoop3 software]# cd /home/tuzq/software/solr-4.10.3/example/webapps [root@hadoop3 webapps]# ls solr.war [root@hadoop3 webapps]#cp -R solr.war /usr/local/apache-tomcat-7.0.73/webapps [root@hadoop3 webapps]# cd /usr/local/apache-tomcat-7.0.73/webapps [root@hadoop3 webapps]# ls docs examples host-manager manager ROOT solr.war |

创建/usr/local/solrcloud这个文件夹,并将/home/tuzq/software/solr-4.10.3/example的solr文件拷贝到/usr/local/solrcloud,并将solr名称改成solrhome

| [root@localhost local] cd /usr/local [root@localhost local] mkdir solrcloud

拷贝solr,并改变solr的名称 [root@hadoop1 example]# cd /home/tuzq/software/solr-4.10.3/example [root@hadoop1 example]# ls contexts example-DIH example-schemaless logs README.txt scripts solr-webapp webapps etc exampledocs lib multicore resources solr start.jar [root@hadoop1 example]# cp -R solr /usr/local/solrcloud [root@localhost example]# cd /usr/local/solrcloud [root@localhost solrcloud]# ls solr [root@localhost solrcloud]#mv solr solrhome [root@localhost solrcloud]# ls solrhome [root@localhost solrcloud]# |

修改solrhome下的solr.xml

| [root@localhost solrcloud]# cd solrhome [root@localhost solrhome]# ls bin collection1 README.txt solr.xml zoo.cfg [root@localhost solrhome]# pwd /usr/local/solrcloud/solrhome |

192.168.106.80服务器上的配置修改如下(其中下面红色部分表示的tomcat所在的服务器的ip和端口号):

| <solr>

<solrcloud> <str name="host">${host:192.168.106.80}</str> <int name="hostPort">${jetty.port:8080}</int> <str name="hostContext">${hostContext:solr}</str> <int name="zkClientTimeout">${zkClientTimeout:30000}</int> <bool name="genericCoreNodeNames">${genericCoreNodeNames:true}</bool> </solrcloud>

<!—下面的配置暂时不动--> <shardHandlerFactory name="shardHandlerFactory" class="HttpShardHandlerFactory"> <int name="socketTimeout">${socketTimeout:0}</int> <int name="connTimeout">${connTimeout:0}</int> </shardHandlerFactory>

</solr> |

192.168.106.81服务器上的配置修改如下(其中下面红色部分表示的tomcat所在的服务器的ip和端口号):

| <solr>

<solrcloud> <str name="host">${host:192.168.106.81}</str> <int name="hostPort">${jetty.port:8080}</int> <str name="hostContext">${hostContext:solr}</str> <int name="zkClientTimeout">${zkClientTimeout:30000}</int> <bool name="genericCoreNodeNames">${genericCoreNodeNames:true}</bool> </solrcloud>

<!—下面的配置暂时不动--> <shardHandlerFactory name="shardHandlerFactory" class="HttpShardHandlerFactory"> <int name="socketTimeout">${socketTimeout:0}</int> <int name="connTimeout">${connTimeout:0}</int> </shardHandlerFactory>

</solr> |

192.168.106.82服务器上的配置修改如下(其中下面红色部分表示的tomcat所在的服务器的ip和端口号):

| <solr>

<solrcloud> <str name="host">${host:192.168.106.82}</str> <int name="hostPort">${jetty.port:8080}</int> <str name="hostContext">${hostContext:solr}</str> <int name="zkClientTimeout">${zkClientTimeout:30000}</int> <bool name="genericCoreNodeNames">${genericCoreNodeNames:true}</bool> </solrcloud>

<!—下面的配置暂时不动--> <shardHandlerFactory name="shardHandlerFactory" class="HttpShardHandlerFactory"> <int name="socketTimeout">${socketTimeout:0}</int> <int name="connTimeout">${connTimeout:0}</int> </shardHandlerFactory>

</solr> |

192.168.106.83服务器上的配置修改如下(其中下面红色部分表示的tomcat所在的服务器的ip和端口号):

| <solr>

<solrcloud> <str name="host">${host:192.168.106.83}</str> <int name="hostPort">${jetty.port:8080}</int> <str name="hostContext">${hostContext:solr}</str> <int name="zkClientTimeout">${zkClientTimeout:30000}</int> <bool name="genericCoreNodeNames">${genericCoreNodeNames:true}</bool> </solrcloud>

<!—下面的配置暂时不动--> <shardHandlerFactory name="shardHandlerFactory" class="HttpShardHandlerFactory"> <int name="socketTimeout">${socketTimeout:0}</int> <int name="connTimeout">${connTimeout:0}</int> </shardHandlerFactory>

</solr> |

第三步:重新启动tomcat(192.168.106.81~83四台都重启,以重启81为例),解压war包。

| [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/bin [root@hadoop1 bin]# ./shutdown.sh [root@hadoop1 bin]# ./startup.sh #通过下面的命令查看tomcat启动情况 [root@hadoop1 bin]# ps -ef | grep tomcat | grep -v grep #进入webapp目录下,查看solr.war的解压情况 [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/webapps [root@hadoop1 webapps]# ls docs examples host-manager manager ROOT solr solr.war 注意:要先停掉tomcat,然后再删除这个solr.war [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/bin [root@hadoop1 bin]# ./shutdown.sh [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/webapps [root@hadoop1 webapps]# rm -rf solr.war [root@hadoop1 webapps]# ls docs examples host-manager manager ROOT solr #重启一下tomcat. [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/bin [root@hadoop1 bin]# ./startup.sh |

把solr-4.10.3目录下example目录下的关于日志相关的jar包添加到solr工程中。

| #添加扩展依赖包(日志包) [root@hadoop3 ext]# cd /home/tuzq/software/solr-4.10.3/example/lib/ext [root@hadoop3 ext]# ls jcl-over-slf4j-1.7.6.jar jul-to-slf4j-1.7.6.jar log4j-1.2.17.jar slf4j-api-1.7.6.jar slf4j-log4j12-1.7.6.jar [root@hadoop3 ext] cp -R * /usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF/lib/ cd solr-4.10.3 #在WEB-INFO下创建一个classes目录 cd /usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF mkdir classes

#将日志文件拷贝到classes目录下 cp -r /home/tuzq/software/solr-4.10.3/example/resources/log4j.properties /usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF/classes |

第四步:创建solrhome。修改web.xml指定solrhome的位置。

| cd /usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF vim web.xml <env-entry> <env-entry-name>solr/home</env-entry-name> <env-entry-value>/usr/local/solrcloud/solrhome</env-entry-value> <env-entry-type>java.lang.String</env-entry-type> </env-entry>

|

其它solr相关的配置参考:http://blog.csdn.net/tototuzuoquan/article/details/61446788

6 solr集群的搭建

6.1 第一步

把solrhome中的配置文件上传到zookeeper集群。使用zookeeper的客户端上传。

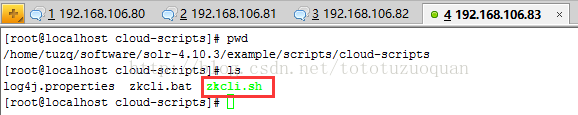

客户端命令位置:/home/tuzq/software/solr-4.10.3/example/scripts/cloud-scripts

使用zookeeper统一管理配置文件。需要把solrhome下的collection/的conf文件上传至zookeeper

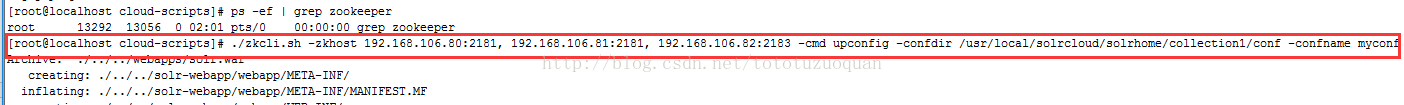

执行下边的命令将/usr/local/solrcloud/solrhome/collection1/conf下的配置文件上传到zookeeper(此命令为单条命令,虽然很长。此命令在solr-4.10.3/example/scripts/cloud-scripts/目录下:

| ./zkcli.sh -zkhost 192.168.106.80:2181,192.168.106.81:2181,192.168.106.82:2181 -cmd upconfig -confdir /usr/local/solrcloud/solrhome/collection1/conf -confname myconf |

红色字体部分的ip表示zookeeper集群的ip地址以及对应的端口。

查看配置文件是否上传成功:

[root@bogon bin]# cd /home/tuzq/software/zookeeper/bin

[root@bogon bin]# ./zkCli.sh

Connecting to localhost:2181

[zk: localhost:2181(CONNECTED) 8] ls /

[configs, zookeeper, myboys, mygirls]

[zk: localhost:2181(CONNECTED) 1] ls /configs

[myconf]

[zk: localhost:2181(CONNECTED) 13] ls /configs/myconf

[currency.xml, mapping-FoldToASCII.txt,protwords.txt, scripts.conf, synonyms.txt, stopwords.txt, velocity,_schema_analysis_synonyms_english.json, admin-extra.html, update-script.js,_schema_analysis_stopwords_english.json, solrconfig.xml,admin-extra.menu-top.html, elevate.xml, schema.xml, clustering,mapping-ISOLatin1Accent.txt, spellings.txt, xslt, _rest_managed.json, lang,admin-extra.menu-bottom.html]

[zk: localhost:2181(CONNECTED) 14]

6.2 第三步

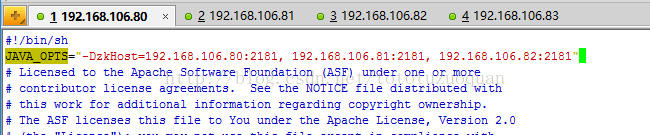

修改每一台solr的tomcat 的 bin目录下catalina.sh文件中加入DzkHost指定zookeeper服务器地址:

[root@localhost bin]#cd /usr/local/apache-tomcat-7.0.73/bin

[root@localhost bin]#vim catalina.sh

JAVA_OPTS="-DzkHost=192.168.106.80:2181,192.168.106.81:2181,192.168.106.82:2181"

红色字体的ip表示zookeeper集群的ip以及端口号(注意:每个之间的逗号之间不允许有空格)

(可以使用vim的查找功能查找到JAVA_OPTS的定义的位置,然后添加,可以在catalina.sh的第二行添加)

6.4 第四步

重新启动tomcat

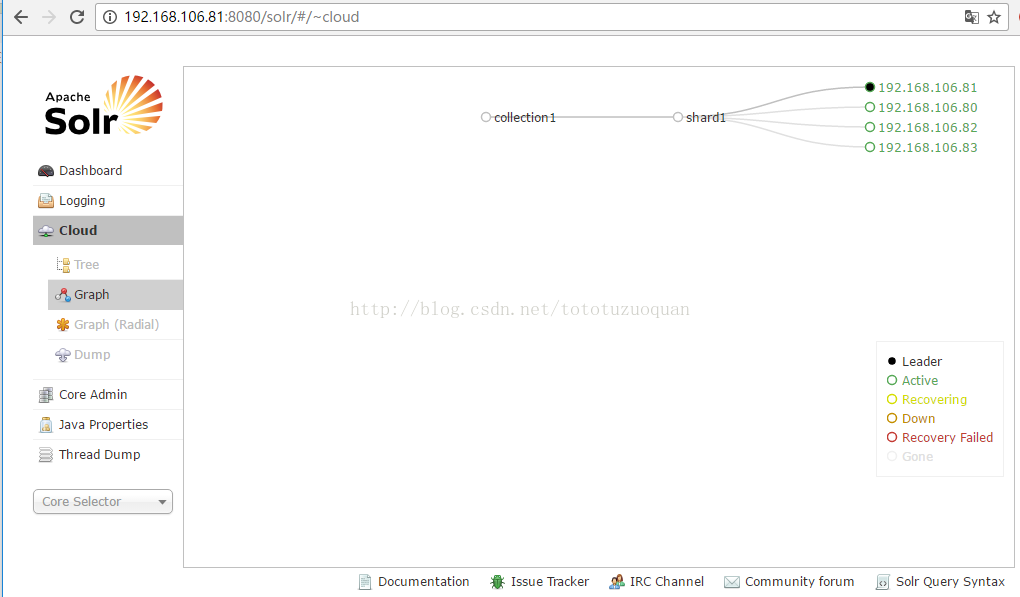

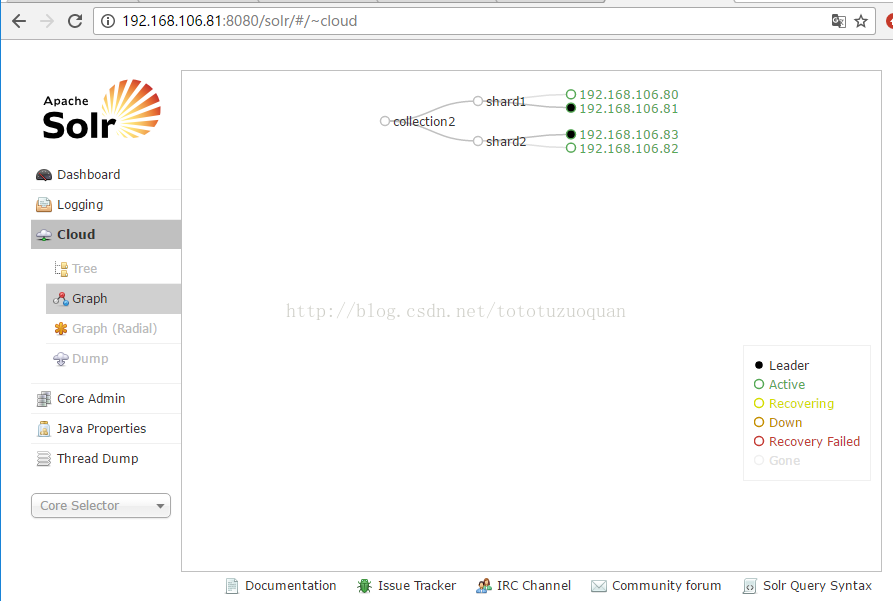

浏览器上访问:http://192.168.106.81:8080/solr/#/~cloud

一个主节点多个备份节点,集群只有一片。

6.5 第五步

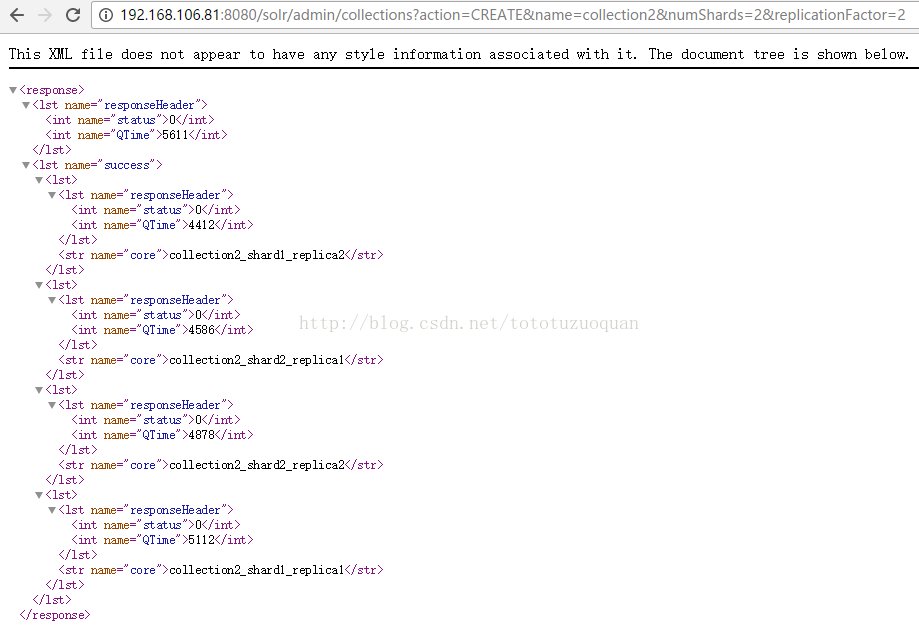

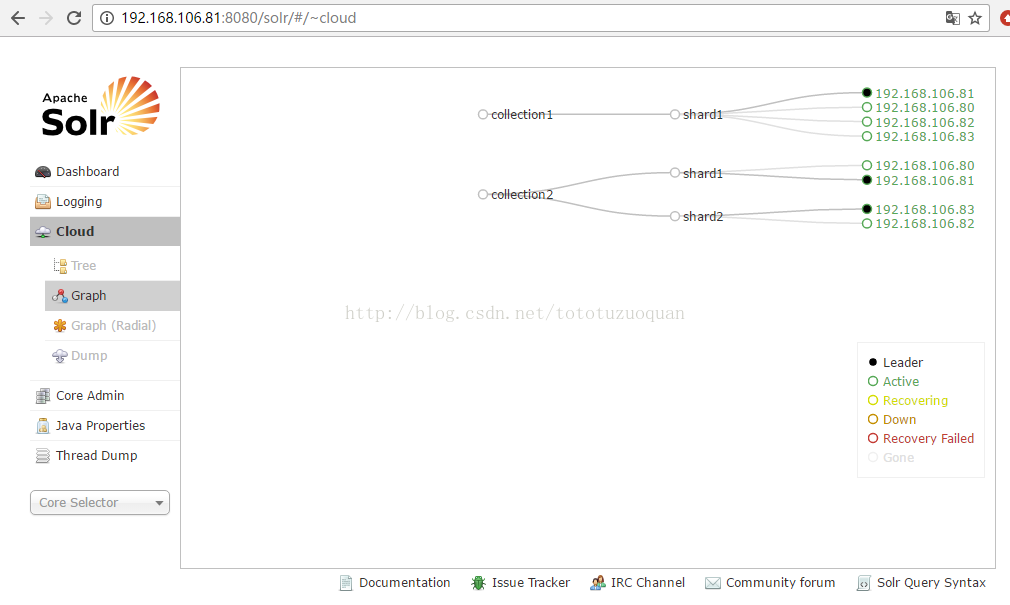

创建一个两片的collection,每片是一主一备。

使用以下命令创建:

6.6 第六步

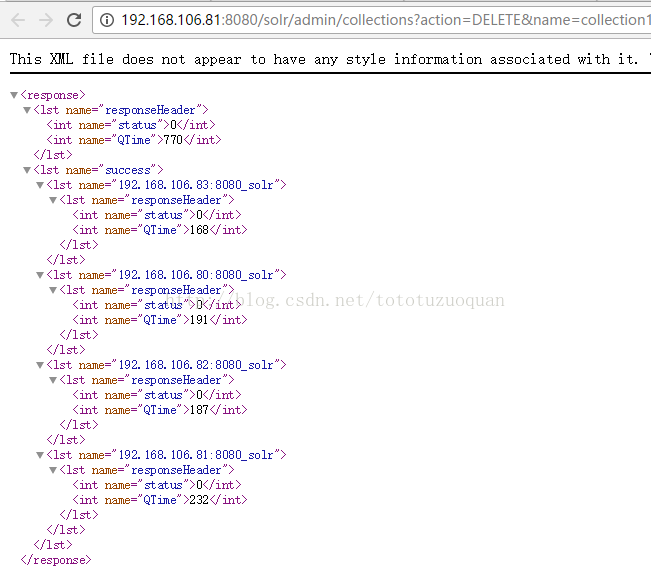

删除collection1.

http://192.168.106.81:8080/solr/admin/collections?action=DELETE&name=collection1

7、配置dataimport插件

1、 将/home/tuzq/software/solr-4.10.3下的contrib和dist拷贝到/usr/local/solrcloud(四台服务器都需要这样做)

| [root@localhost solr-4.10.3]# cd /home/tuzq/software/solr-4.10.3 [root@localhost solr-4.10.3]# cp -R contrib /usr/local/solrcloud [root@localhost solr-4.10.3]# cp -R dist /usr/local/solrcloud |

使用下面的方式将数据导入所需的jar放到相应的位置:

| [root@hadoop2 contrib]# cd /usr/local/solrcloud/contrib [root@hadoop2 contrib]# mkdir db [root@hadoop2 contrib]# cd db [root@hadoop2 db]# mkdir lib

进入:/home/tuzq/software/solr-4.10.3/dist,将: solr-dataimporthandler-4.10.3.jar、solr-dataimporthandler-extras-4.10.3.jar放到

将 solr-dataimporthandler-4.10.3.jar solr-dataimporthandler-extras-4.10.3.jar最终上传到lib文件夹下

最后的效果如下: [root@hadoop2 lib]# pwd /usr/local/solrcloud/contrib/dataimporthandler/lib [root@hadoop2 lib]# ls solr-dataimporthandler-4.10.3.jar solr-dataimporthandler-extras-4.10.3.jar [root@hadoop2 lib]#

最终将mysql-connector-java-5.1.38.jar放入到:/usr/local/solrcloud/contrib/db/lib中 cd /usr/local/solrcloud/contrib/db/lib

最终效果如下: [root@hadoop1 lib]# pwd /usr/local/solrcloud/contrib/db/lib [root@hadoop1 lib]# ls mysql-connector-java-5.1.38.jar [root@hadoop1 lib]# |

2、 创建分词,创建方式参考:http://blog.csdn.net/tototuzuoquan/article/details/61446788中关于分词部分的内容:

| [root@hadoop2 lib] cd /usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF/lib 将IKAnalyzer2012_FF.jar和IKAnalyzer2012FF_u1.jar放入到该文件夹下:

将IK-Analyzer-2012FF\src下的ext.dic、IKAnalyzer.cfg.xml、stopword.dic上传到:/usr/local/apache-tomcat-7.0.73/webapps/solr/WEB-INF/classes |

3、 以192.168.106.80为例,发现在之前放置的如下文件/usr/local/solrcloud/solrhome/collection1/conf,已经在创建集群的时候给删除了。这时候进入:/home/tuzq/software/solr-4.10.3/example/solr/collection1/conf,在下面创建一个data-config.xml文件,文件内容是:

| <?xml version="1.0" encoding="UTF-8" ?> <dataConfig> <dataSource type="JdbcDataSource" driver="com.mysql.jdbc.Driver" url="jdbc:mysql://192.168.106.80:3306/solr" user="root" password="123456"/> <document> <entity name="product" query="SELECT pid,name,catalog,catalog_name,price,description,picture FROM products"> <field column="pid" name="id"/> <field column="name" name="product_name"/> <field column="catalog" name="product_catalog"/> <field column="catalog_name" name="product_catalog_name"/> <field column="price" name="product_price"/> <field column="description" name="product_description"/> <field column="picture" name="product_picture"/> </entity> </document>

</dataConfig> |

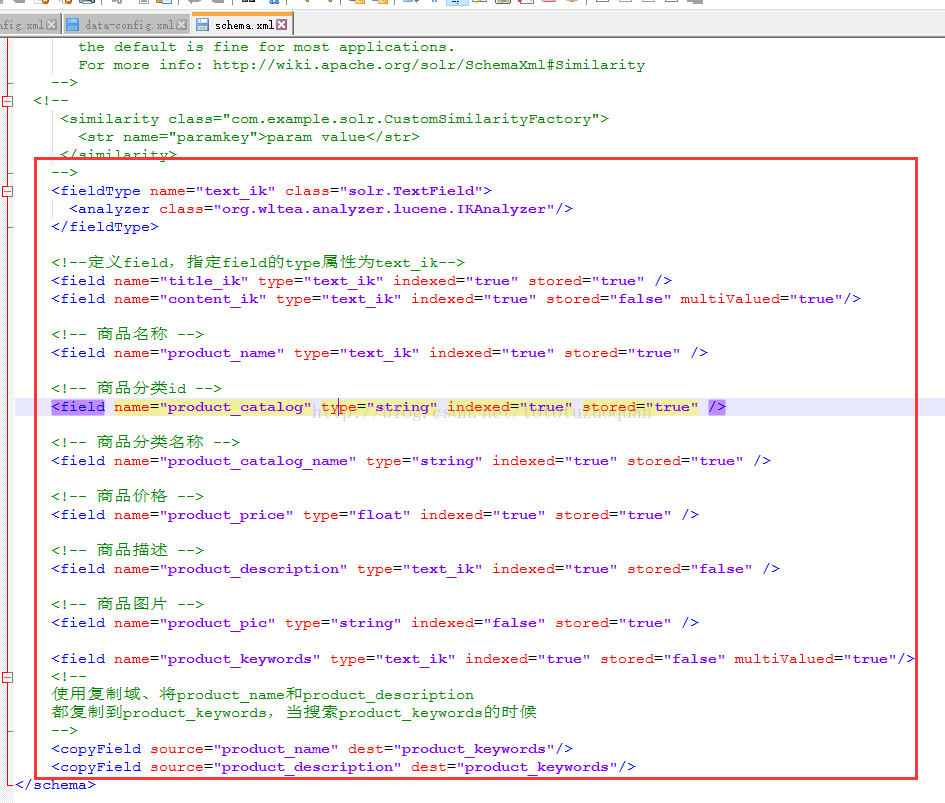

修改schema.xml:

内容如下:

| <fieldType name="text_ik" class="solr.TextField"> <analyzer class="org.wltea.analyzer.lucene.IKAnalyzer"/> </fieldType>

<!--定义field,指定field的type属性为text_ik--> <field name="title_ik" type="text_ik" indexed="true" stored="true" /> <field name="content_ik" type="text_ik" indexed="true" stored="false" multiValued="true"/>

<!-- 商品名称 --> <field name="product_name" type="text_ik" indexed="true" stored="true" />

<!-- 商品分类id --> <field name="product_catalog" type="string" indexed="true" stored="true" />

<!-- 商品分类名称 --> <field name="product_catalog_name" type="string" indexed="true" stored="true" />

<!-- 商品价格 --> <field name="product_price" type="float" indexed="true" stored="true" />

<!-- 商品描述 --> <field name="product_description" type="text_ik" indexed="true" stored="false" />

<!-- 商品图片 --> <field name="product_pic" type="string" indexed="false" stored="true" />

<field name="product_keywords" type="text_ik" indexed="true" stored="false" multiValued="true"/> <!-- 使用复制域、将product_name和product_description 都复制到product_keywords,当搜索product_keywords的时候 --> <copyField source="product_name" dest="product_keywords"/> <copyField source="product_description" dest="product_keywords"/> |

修改solrconfig.xml的配置,可以参考http://blog.csdn.net/tototuzuoquan/article/details/61446788中关于数据导入相关的配置:

| <lib dir="${solr.install.dir:../..}/contrib/extraction/lib" regex=".*\.jar" /> <lib dir="${solr.install.dir:../..}/dist/" regex="solr-cell-\d.*\.jar" />

<lib dir="${solr.install.dir:../..}/contrib/clustering/lib/" regex=".*\.jar" /> <lib dir="${solr.install.dir:../..}/dist/" regex="solr-clustering-\d.*\.jar" />

<lib dir="${solr.install.dir:../..}/contrib/langid/lib/" regex=".*\.jar" /> <lib dir="${solr.install.dir:../..}/dist/" regex="solr-langid-\d.*\.jar" />

<lib dir="${solr.install.dir:../..}/contrib/velocity/lib" regex=".*\.jar" /> <lib dir="${solr.install.dir:../..}/dist/" regex="solr-velocity-\d.*\.jar" />

<lib dir="${solr.install.dir:../..}/contrib/dataimporthandler/lib" regex=".*\.jar"/> <lib dir="${solr.install.dir:../..}/contrib/db/lib" regex=".*\.jar"/> |

接着将/home/tuzq/software/solr-4.10.3/example/solr/collection1/conf中的配置文件上传到zookeeper。

进入/home/tuzq/software/solr-4.10.3/example/scripts/cloud-scripts:

执行如下命令:

cd /home/tuzq/software/solr-4.10.3/example/scripts/cloud-scripts

| ./zkcli.sh -zkhost 192.168.106.80:2181,192.168.106.81:2181,192.168.106.82:2181 -cmd upconfig -confdir /home/tuzq/software/solr-4.10.3/example/solr/collection1/conf -confname myconf |

接着访问:http://192.168.106.80:8080/solr

点击data-config.xml文件

结果如下(发现数据库连接已经修改过来了):

重启tomcat集群。

| [root@hadoop1 bin] cd /usr/local/apache-tomcat-7.0.73/bin [root@hadoop1 bin]# ./shutdown.sh [root@hadoop1 bin]# ./startup.sh |

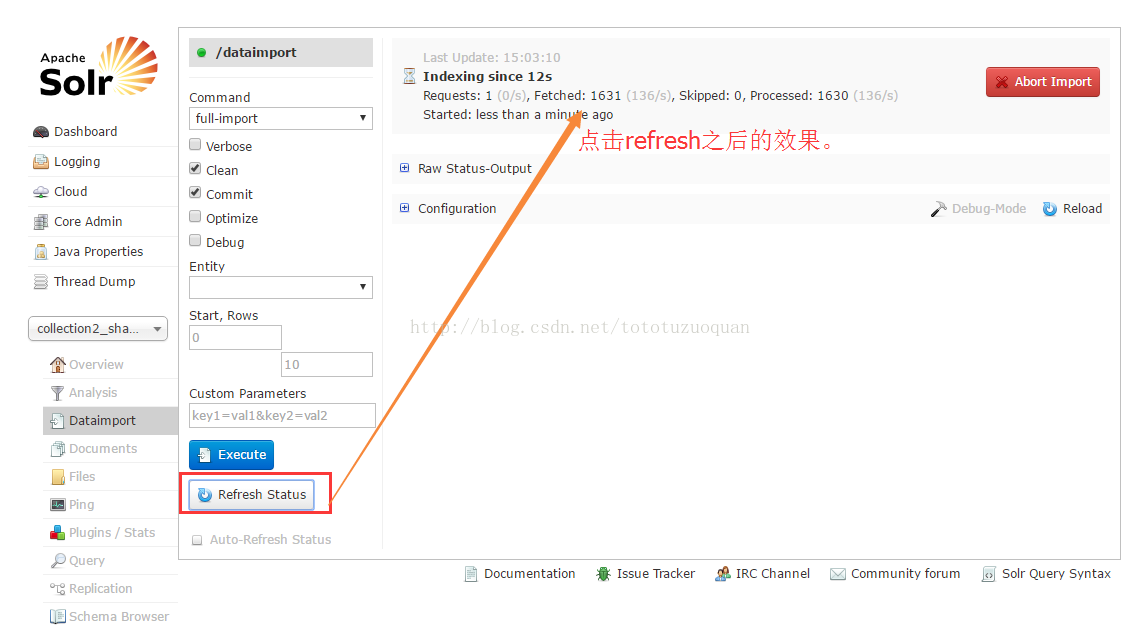

接着访问:http://192.168.106.80:8080/solr/

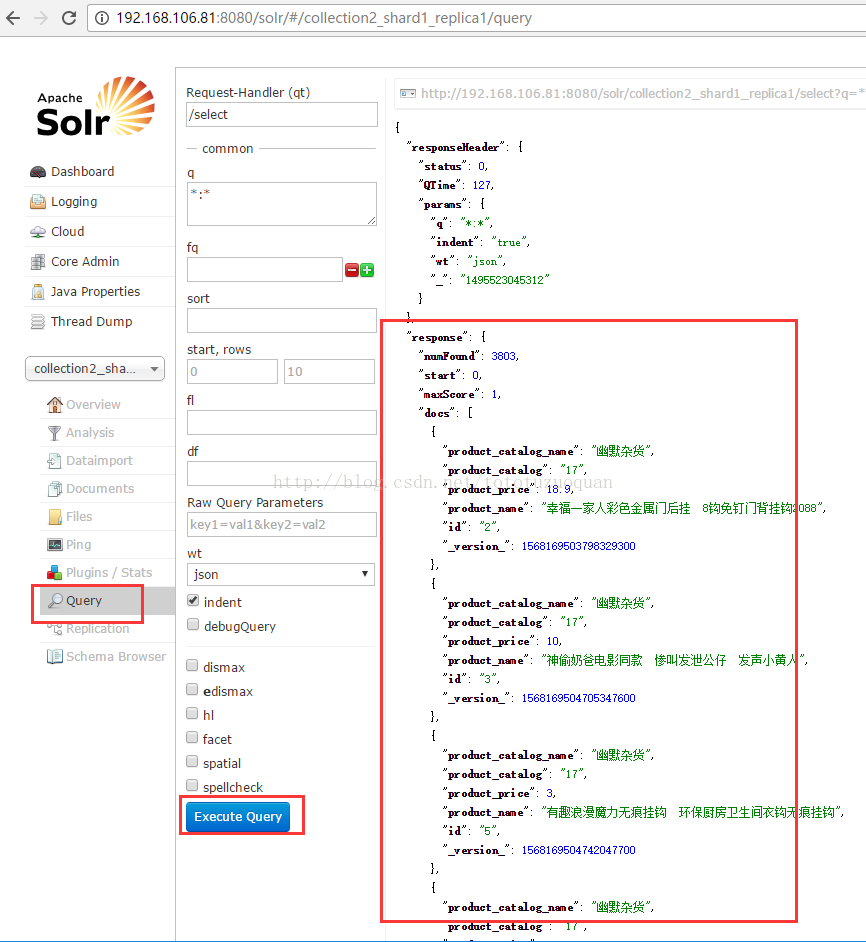

直接执行Execute,发现可以进行数据同步了。

最后:

进入

执行查询之后,发现右侧已经有数据了。

============================================

最后,solr集群搭建好之后,就可以用于调用了,案例如下(关于jar的获取参考:http://blog.csdn.net/tototuzuoquan/article/details/61709204):

代码如下:

| package cn.com.toto.cloud;

import org.apache.solr.client.solrj.SolrQuery; import org.apache.solr.client.solrj.impl.CloudSolrServer; import org.apache.solr.client.solrj.response.QueryResponse; import org.apache.solr.common.SolrDocument; import org.apache.solr.common.SolrDocumentList; import org.junit.Test;

/** * @brief TestSolrCloud.java 集群配置 * @attention 使用注意事项 * @author toto * @date 2017年5月23日 * @note begin modify by 涂作权 2017年5月23日 原始创建 */ public class TestSolrCloud {

@Test public void testCloud() throws Exception { //创建一个连接 String zkHost = "192.168.106.80:2181,192.168.106.81:2181,192.168.106.82:2181"; //参数:zookeeper服务器的地址列表 CloudSolrServer server = new CloudSolrServer(zkHost); //指定默认连接的collection server.setDefaultCollection("collection2"); //创建一查询对象 SolrQuery solrQuery = new SolrQuery(); solrQuery.setQuery("*:*"); //执行查询 QueryResponse queryResponse = server.query(solrQuery); SolrDocumentList solrDocumentList = queryResponse.getResults(); System.out.println("查询结果总数量:" + solrDocumentList.getNumFound()); for (SolrDocument solrDocument : solrDocumentList) { System.out.println(solrDocument.get("id")); System.out.println(solrDocument.get("product_name")); System.out.println(solrDocument.get("product_price")); System.out.println(solrDocument.get("product_picture")); } } } |

如果是整合在spring,springmvc的项目里面,整合方式如下:

1.1.1 实现步骤

第一步:创建一个web工程

第二步:导入jar包。Springmvc+spring+solrJ的jar包

第三步:开发dao

第四步:开发service

第五步:开发controller。

1.1.2 Dao

| @Repository public class ProductDaoImpl implements ProductDao {

//如果是单集的是HtttpSolrServer,如果是集群的环境下的,是SolrServer @Autowired private SolrServer solrServer;

@Override public ResultModel queryProduct(SolrQuery solrQuery) throws Exception {

//根据查询条件查询索引库 QueryResponse response = solrServer.query(solrQuery); //取查询结果 SolrDocumentList solrDocumentList = response.getResults(); //商品列表 List<ProductModel> productList = new ArrayList<>(); //遍历列表 for (SolrDocument solrDocument : solrDocumentList) { //取商品信息 ProductModel model = new ProductModel(); model.setPid((String) solrDocument.get("id")); //取高亮显示 Map<String, Map<String, List<String>>> highlighting = response.getHighlighting(); List<String> list = highlighting.get(solrDocument.get("id")).get("product_name"); String productName = ""; if (null != list && list.size() > 0) { productName = list.get(0); } else { productName = (String) solrDocument.get("product_name"); } model.setName(productName); model.setPrice((float) solrDocument.get("product_price")); model.setPicture((String) solrDocument.get("product_picture")); model.setCatalog_name((String) solrDocument.get("product_catalog_name")); //添加到商品列表 productList.add(model); } //添加到返回值对象中 ResultModel resultModel = new ResultModel(); resultModel.setProductList(productList); //查询结果的总数量 resultModel.setRecordCount(solrDocumentList.getNumFound());

return resultModel; }

} |

1.1.3 Service

| @Service public class ProductServiceImpl implements ProductService {

@Autowired private ProductDao productDao;

@Override public ResultModel queryProduct(String queryString, String catalog_name, String price, String sort, Integer page) throws Exception { SolrQuery solrQuery = new SolrQuery(); //拼装查询条件 //主查询条件 if (null != queryString && !"".equals(queryString)) { solrQuery.setQuery(queryString); } else { solrQuery.setQuery("*:*"); } //根据商品分类过滤 if (null != catalog_name && !"".equals(catalog_name)) { solrQuery.addFilterQuery("product_catalog_name:" + catalog_name); } //价格区间过滤 if (null != price && !"".equals(price)) { String[] strings = price.split("-"); solrQuery.addFilterQuery("product_price:["+strings[0]+" TO "+strings[1]+"]"); } //排序条件 if ("1".equals(sort)) { solrQuery.setSort("product_price", ORDER.desc); } else { solrQuery.setSort("product_price", ORDER.asc); } //分页条件 if (null == page) page = 1; //计算分页 int start = (page - 1) * Global.PAGE_SIZE; solrQuery.setStart(start); solrQuery.setRows(Global.PAGE_SIZE); //设置默认搜索域 solrQuery.set("df", "product_keywords"); //设置高亮 solrQuery.setHighlight(true); //高亮显示的域 solrQuery.addHighlightField("product_name"); //高亮显示的前缀 solrQuery.setHighlightSimplePre("<span style=\"color:red\">"); //高亮后缀 solrQuery.setHighlightSimplePost("</span>"); //执行查询 ResultModel resultModel = productDao.queryProduct(solrQuery); //计算总页数 Long recordCount = resultModel.getRecordCount(); int pageCount = (int) (recordCount / Global.PAGE_SIZE); if (recordCount % Global.PAGE_SIZE > 0) { pageCount++; } resultModel.setPageCount(pageCount); resultModel.setCurPage(page);

return resultModel; }

} |

1.1.4 Controller

| @Controller public class ProductController {

@Autowired private ProductService productService;

@RequestMapping("/list") public String queryProduct(String queryString, String catalog_name, String price, String sort, Integer page, Model model) throws Exception { //接收参数,调用service查询商品列表 ResultModel resultModel = productService.queryProduct(queryString, catalog_name, price, sort, page); //把resultModel传递给页面 model.addAttribute("result", resultModel); //参数回显 model.addAttribute("queryString", queryString); model.addAttribute("catalog_name", catalog_name); model.addAttribute("price", price); model.addAttribute("sort", sort); model.addAttribute("page", page); //返回jsp页面 return"product_list"; } } |

1.1.5 Web.xml

| <?xml version="1.0" encoding="UTF-8"?> <web-app xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns="http://java.sun.com/xml/ns/javaee"xmlns:web="http://java.sun.com/xml/ns/javaee/web-app_2_5.xsd" xsi:schemaLocation="http://java.sun.com/xml/ns/javaee http://java.sun.com/xml/ns/javaee/web-app_2_5.xsd" id="WebApp_ID" version="2.5"> <display-name>SolrCloudJD</display-name> <welcome-file-list> <welcome-file>index.html</welcome-file> <welcome-file>index.htm</welcome-file> <welcome-file>index.jsp</welcome-file> <welcome-file>default.html</welcome-file> <welcome-file>default.htm</welcome-file> <welcome-file>default.jsp</welcome-file> </welcome-file-list> <!-- 前端控制器 --> <servlet> <servlet-name>springmvc</servlet-name> <servlet-class>org.springframework.web.servlet.DispatcherServlet</servlet-class> <init-param> <param-name>contextConfigLocation</param-name> <param-value>classpath:springmvc.xml</param-value> </init-param> </servlet> <servlet-mapping> <servlet-name>springmvc</servlet-name> <url-pattern>*.action</url-pattern> </servlet-mapping> <!-- post乱码过滤器 --> <filter> <filter-name>Character Encoding</filter-name> <filter-class>org.springframework.web.filter.CharacterEncodingFilter</filter-class> <init-param> <param-name>encoding</param-name> <param-value>UTF-8</param-value> </init-param> </filter> <filter-mapping> <filter-name>Character Encoding</filter-name> <url-pattern>/*</url-pattern> </filter-mapping>

</web-app> |

1.1.6 Springmvc.xml

| <?xml version="1.0" encoding="UTF-8"?> <beans xmlns="http://www.springframework.org/schema/beans" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns:mvc="http://www.springframework.org/schema/mvc" xmlns:context="http://www.springframework.org/schema/context" xmlns:aop="http://www.springframework.org/schema/aop" xmlns:tx="http://www.springframework.org/schema/tx" xsi:schemaLocation="http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans-3.1.xsd http://www.springframework.org/schema/mvc http://www.springframework.org/schema/mvc/spring-mvc-3.1.xsd http://www.springframework.org/schema/context http://www.springframework.org/schema/context/spring-context-3.1.xsd http://www.springframework.org/schema/aop http://www.springframework.org/schema/aop/spring-aop-3.1.xsd http://www.springframework.org/schema/tx http://www.springframework.org/schema/tx/spring-tx-3.1.xsd "> <!-- 配置扫描包 --> <context:component-scan base-package="xxxxx"/> <!-- 配置注解驱动 --> <mvc:annotation-driven/> <!-- jsp视图解析器 --> <bean class="org.springframework.web.servlet.view.InternalResourceViewResolver" > <!-- 前缀 --> <property name="prefix" value="/WEB-INF/jsp/"></property> <!-- 后缀 --> <property name="suffix" value=".jsp"></property> </bean> <!-- 单机版的SolrServer --> <!-- <bean class="org.apache.solr.client.solrj.impl.HttpSolrServer"> <constructor-arg value="http://localhost:8080/solr/"></constructor-arg> </bean> --> <!-- 集群环境SolrServer --> <bean class="org.apache.solr.client.solrj.impl.CloudSolrServer"> <constructor-arg index="0"value="192.168.106.80:2181,192.168.106.81:2181,192.168.106.82:2181"/> <property name="defaultCollection" value="collection2"/> </bean>

</beans> |

1016

1016

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?