安装虚拟机

最新版本拿不到注册码,所以我选vmware workstation 12 这个版本,密钥就很多了。

安装linux

1)下载并安装

我下载的centos:https://www.centos.org/download/

可以去linux官网:https://www.linux.org/下载其他版本

问题:下载min版本后,用yum的方式安装桌面出现了不识别yum的情况。所以改下完整版,选择安装插件位置,选择了GNOME桌面的安装。

2)配置ip地址

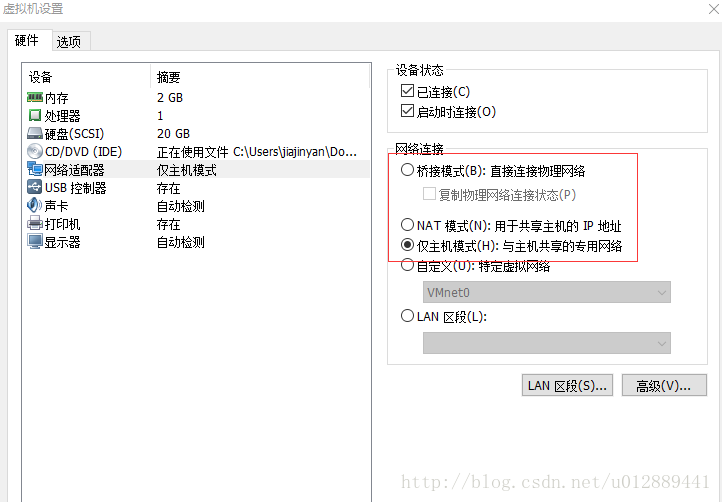

在虚拟机>虚拟机设置>网络适配器下有三种连接方式

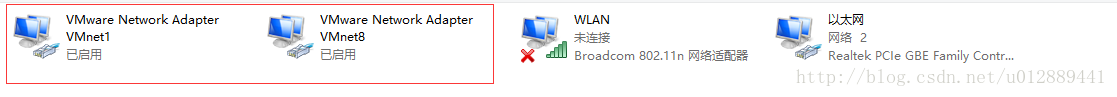

如果选择NAT模式,就将虚拟机的ip和适配器VMnet8的ip地址设在同一网段

如果选择仅主机模式,就讲虚拟机的ip和适配器VMnet1的ip地址设在同一网段

另外还要在虚拟网络编辑器中设置他们所在的网段

3)关闭防火墙

教程上关闭防火墙所以我就暂时关闭了,这块是个坑,以后补。

win10关闭防火墙(我实体机系统):控制面板>系统和安全>Windows防火墙

centOS7关闭防火墙:

systemctl stop firewalld.service #停止firewall

systemctl disable firewalld.service #禁止firewall开机启动

4)可以相互ping通

验证上述步骤配置正确。如果一方ping的通是3步骤出现了问题。

安装JDK

解压

配置(一定要配置JAVA_HOME)

在/etc/profile文件中添加JAVA_HOME和PATH

export JAVA_HOME=/usr/java/jdk1.6.0_45

export PATH=$PATH:$JAVA_HOME/bin

安装并配置hadoop

1).解压hadoop包

tar -zxvf hadoop-2.7.4.tar.gz -C /goalDirName

2).配置hadoop伪分布式(要修改4个文件,在/goalDirName/hadoop-2.7.4/etc/hadoop/下)

第一个:hadoop-env.sh

vim hadoop-env.sh

export JAVA_HOME=/usr/java/jdk1.6.0_45(一定要改成绝对命名方式) 第二个:core-site.xml

vim core-site.xml

<configuration>

<!-- 指定HDFS的namenode的通信地址 -->

<property>

<name>fs.default.name</name>

<value>hdfs://itcast:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存放目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/cloud/hadoop-1.1.2/tmp</value>

</property>

</configuration> 第三个:hdfs-site.xml

vim hdfs-site.xml

<configuration>

<!-- 配置HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration> 第四个:mapred-site.xml

vim mapred-site.xml

<configuration>

<!-- 指定jobtracker地址 -->

<property>

<name>mapred.job.tracker</name>

<value>itcast:9001</value>

</property>

</configuration>3).将hadoop添加到环境变量

vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.6.0_45

export HADOOP_HOME=/cloud/hadoop-1.1.2

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin source /etc/profile(刷新文件)

4).格式化HDFS(仅第一次启动需要)

hadoop namenode -format

5).启动hadoop

start-dfs.sh(启动dfs服务)

start-yarn.sh(启动yarn服务)

6).验证集群是否启动成功

jps(不包括jps应该有5个)

NameNode

SecondaryNameNode

DataNode

JobTracker

TaskTracker

还可以通过浏览器的方式验证

http://192.168.1.110:50070 (hdfs管理界面)

http://192.168.1.110:50030 (mr管理界面)

7).配置ssh免登陆

生成ssh免登陆密钥

ssh-keygen -t rsa

执行完这个命令后,会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

将公钥拷贝到要免登陆的机器上

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

5153

5153

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?