Scrapy,Python开发的一个快速,高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

在这篇入门教程中,我们假定你已经安装了python。如果你还没有安装,那么请参考安装指南。

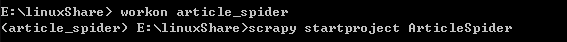

首先第一步:进入开发环境,workon article_spider

进入这个环境:

![]()

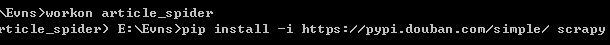

安装Scrapy,在安装的过程中出现了一些错误:通常这些错误都是部分文件没有安装导致的,因为大学时经常出现,所以对解决这种问题,很实在,直接到http://www.lfd.uci.edu/~gohlke/pythonlibs/这个网站下载对应的文件,下载后用pip安装,具体过程不在赘述。

![]()

然后进入工程目录,并打开我们的新创建的虚拟环境:

![]()

新建scrapy工程:ArticleSpider

![]()

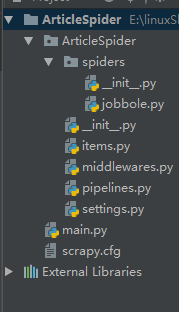

创建好工程框架:在pycharm中导入

scrapy.cfg: 项目的配置文件。

ArticleSpeder/: 该项目的python模块。之后您将在此加入代码。

ArticleSpeder/items.py: 项目中的item文件。

ArticleSpeder/pipelines.py: 项目中的pipelines文件。

ArticleSpeder/settings.py: 项目的设置文件。

ArticleSpeder/spiders/: 放置spider代码的目录。

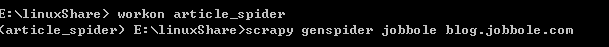

回到dos窗口用basic创建模板

![]()

上面pycharm的截图中已经创建好了:

为了今后更好的开发,创建一个用于debug的类main.py

| 1 2 3 4 5 6 |

|

这是代码内容

import sys 为了设置工程目录,调用命令才会生效

里面的路径最好不要写死:可以通过os获取路径,更加灵活

execute用来执行目标程序的

jobbole.py的内容

| 1 2 3 4 5 6 7 8 9 10 11 12 13 |

|

通过xpath技术获取对应文章的一些字段信息,包括标题,时间,评论数,点赞数等,因为比较简单所以不在赘述

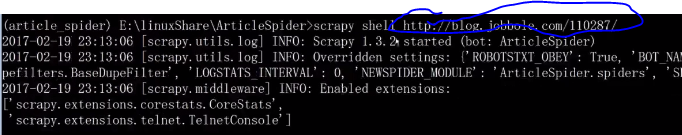

写到这儿,大家也知道每次在pycharm里面debug和麻烦,因为scrapy比较大,所以这时候我们可以使用Scrapy shell来调试

标记部分是目标网站的地址:现在我们可以更加愉悦的进行调试了。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?