1,archive

使用方法:hadoop archive -

archiveNamename <src>* <dest>

说明:创建一个hadoop档案文件(归档小文件)

例子:

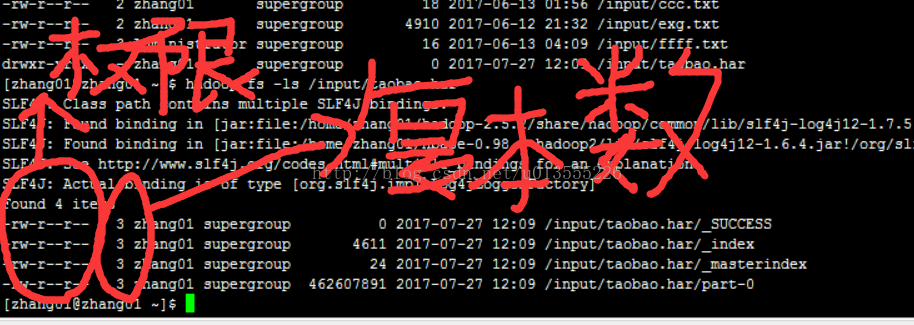

hadoop archive -archiveName taobao.har -p /input/1/ /input/

2,

distcp

使用方法:hadoop distcp <src1> <src2>

说明:在相同的文件系统中并行的复制文件

例子:

hadoop distcp /user/zhang01/README.txt /input/

3,fs

使用方法: hadoop fs [命令]

说明:运行文件命令

4,jar

使用方法: hadoop jar <jar> [mainclass] args

说明:运行hadoop的jar文件

hdfs文件18个基本命令

1,-cat

使用方法: hadoop fs -cat uri

说明:将路径指定的文件输出到屏幕

例子:

hadoop fs -cat /input/aaa.txt

2,-copyFromLocal

使用方法:hadoop fs -copyFromLocal <localsrc>uri <dest>

说明:将本地文件复制到hdfs

例子:

hadoop fs -copyFromLocal /home/zhang01/apache-hive-0.13.1-bin/README.txt /input/1/

3,-copyToLocal

使用方法:hadoop fs -copyToLocal src dest

说明:将hdfs文件复制到本地

例子:

hadoop fs -copyToLocal /input/1/README.txt /home/zhang01

4,-cp

使用方法:hadoop fs -cp uri

说明:将源文件从源路径复制到目标路径,可以有多个源路径但只能左右一个目标路径。

例子:

hadoop fs -cp /input/aaa.txt /input/bbb.txt /input/2

5,-du

使用方法:hadoop fs -du uri

说明:显示目录中所有文件大小或者指定文件大小。

例子:

hadoop fs -du /input

6,-dus

使用方法:hadoop fs -dus uri

说明:显示目录中所有文件总共大小或者指定文件大小。

例子:

hadoop fs -dus /input

7,-expunge

使用方法:hadoop fs -

expunge

说明:清空回收站。

例子:

hadoop fs -expunge

8,-get

使用方法:hadoop fs -

get src dest

说明:复制hdfs上文件到本地。

例子:

hadoop fs -get /input/aaa.txt /home/zhang01/

9,-ls

显示文件

10,-lsr

递归显示,也就是文件夹下的也显示

11,-mkdir

创建目录

12,-mv

移动文件

13,-put

上传文件到hdfs

14,-rm

删除文件

15,-rmr

递归删除文件

16,setrep

改变文件副本数

hadoop fs -setrep 1 /input/aaa.txt

17,-test

使用ezd对文件进行检查。

e:是否存在,存在返回0.

z:检查文件是否0字节

HDFS文件访问权限

只读权限-r

写入权限-w

读写权限-rw

执行权限-x

namenode对hdfs的目录和文件的源数据进行管理, datanode则是对文件进行存储和处理的具体工作节点。

1555

1555

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?