1.克隆虚拟机后,要修改虚拟机名字及ip地址,mac地址

方法:

vi /etc/sysconfig/network-scripts/ifcfg-eth0

重启网络服务: service network restart

查看: ifconfig 里面有相关信息

2,linux root权限分配以及修改hosts文件

192.168.118.129 Slave1

3.免密钥登录

使用下例中ssky-keygen和ssh-copy-id,仅需通过3个步骤的简单设置而无需输入密码就能登录远程Linux主机。

ssh-keygen 创建公钥和密钥。

ssh-copy-id 把本地主机的公钥复制到远程主机的authorized_keys文件上。

ssh-copy-id 也会给远程主机的用户主目录(home)和~/.ssh, 和~/.ssh/authorized_keys设置合适的权限 。

步骤1: 用 ssh-key-gen 在本地主机上创建公钥和密钥

ligh@local-host$ ssh-keygen -t rsa

Enter file in which to save the key (/home/jsmith/.ssh/id_rsa):[Enter key]

Enter passphrase (empty for no passphrase): [Press enter key]

Enter same passphrase again: [Pess enter key]

Your identification has been saved in /home/jsmith/.ssh/id_rsa.

Your public key has been saved in /home/jsmith/.ssh/id_rsa.pub.

The key fingerprint is: 33:b3:fe:af:95:95:18:11:31:d5:de:96:2f:f2:35:f9

ligh@local-host

步骤2: 用 ssh-copy-id 把公钥复制到远程主机上

ligh@local-host$ ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.0.3

ligh@remote-host‘s password:

Now try logging into the machine, with ―ssh ?remote-host‘‖, and check in:

.ssh/authorized_keys to make sure we haven‘t added extra keys that you weren‘t expecting.

[注: ssh-copy-id 把密钥追加到远程主机的 .ssh/authorized_key 上.]

步骤3: 直接登录远程主机

ligh@local-host$ ssh remote-host

Last login: Sun Nov 16 17:22:33 2008 from 192.168.1.2

3.将jdk,hadoop压缩包拷贝到/home/hadoop/usr中

解压:tar -xzvf jdk压缩包名

sudo vi /etc/profile

export JAVA_HOME=/usr/local/java/jdk1.7.0_45 export JRE_HOME=/usr/local/java/jdk1.7.0_45/jre export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:$CLASSPATH export PATH=$JAVA_HOME/bin: $PATH

source /etc/profile

)hadoop安装完毕需要配置hadoop的一些文件,准备工作先建立几个文件夹

home/hadoop/usr/dfs/name

home/hadoop/usr/dfs/data

home/hadoop/usr/tmp

6:修改配置文件

hadoop-env.sh:

core-site.xml:

hdfs-site.xml:

mapred-site.xml:

yarn-site.xml:

7:编辑slaves文件

清空加入从节点的名字

slave1

slave2

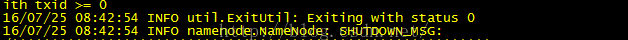

8:在master节点格式化hdfs

bin/hdfs namenode -format

看见status 0表示安装成功

9.启动sbin/start-all.sh

jps 查看启动进程

10 网页版查看

:http://192.168.48.130:8088/

:http://192.168.48.130:50070

11.若节点启动成 网页打不开 可能是防火墙没有关闭

428

428

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?