hadoop2.0已经发布了很多稳定版本,增加了很多特性,比如HDFS HA、YARN等。最新的hadoop-2.7.2又增加了YARN HA

1、环境准备

修改主机名、IP地址。这些在之前博客有提过就不再写了。

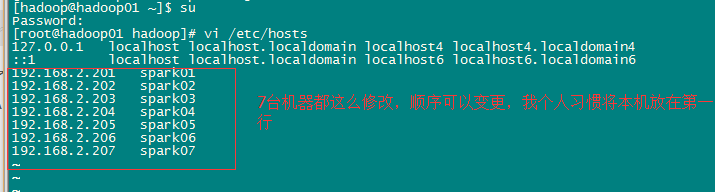

配置IP地址和主机名映射关系。

sudo vi /etc/hosts

集群规划:

主机名 IP 安装的软件 运行的进程

spark01 192.168.2.201 jdk、hadoop NameNode、 DFSZKFailoverController(zkfc)

spark02 192.168.2.202 jdk、hadoop NameNode、DFSZKFailoverController(zkfc)

spark03 192.168.2.203 jdk、hadoop ResourceManager

spark04 192.168.2.204 jdk、hadoop ResourceManager

spark05 192.168.2.205 jdk、hadoop、zookeeper DataNode、NodeManager、JournalNode、QuorumPeerMain

spark06 192.168.2.206 jdk、hadoop、zookeeper DataNode、NodeManager、JournalNode、QuorumPeerMain

spark07 192.168.2.207 jdk、hadoop、zookeeper DataNode、NodeManager、JournalNode、QuorumPeerMain

2、安装zookeeper集群在spark05-07上

参考博客:http://blog.csdn.net/u013821825/article/details/51375860

3、安装配置hadoop集群(在spark01上操作)

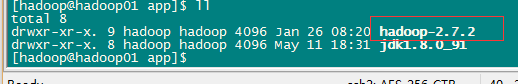

3.1 解压

tar -zxvf hadoop-2.7.2.tar.gz -C /app/

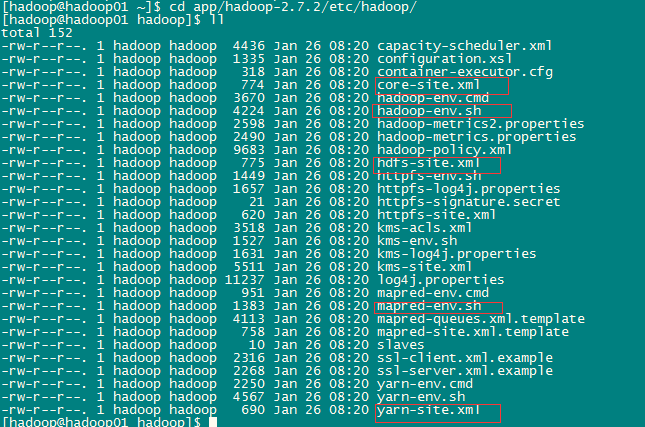

3.2 配置HDFS(hadoop2.0所有的配置文件都在HADOOP_HOME/etc/hadoop目录下)

#将hadoop添加到环境变量中

sudo vi /etc/profile

export JAVA_HOME=/home/hadoop/app/jdk1.8.0_91

export HADOOP_HOME=/home/hadoop/app/hadoop-2.7.2

export PATH=JAVA_HOME/bin: PATH: HADOOP_HOME/bin

export CLASSPATH=.: JAVAHOME/lib/dt.jar: JAVA_HOME/lib/tools.jar

#hadoop2.0的配置文件全部在$HADOOP_HOME/etc/hadoop下

cd /home/hadoop/app/hadoop-2.7.2/etc/hadoop

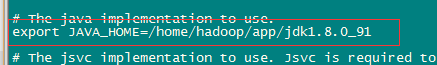

a、修改hadoo-env.sh

export JAVA_HOME=/home/hadoop/app/jdk1.8.0_91

b、修改core-site.xml

<configuration>

<!-- 指定hdfs的nameservice为ns1 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://ns1/</value>

</property>

<!-- 指定hadoop临时目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/app/hadoop-2.7.2/tmp</value>

本文介绍了如何搭建包含HDFS高可用(HA)、YARN的Hadoop集群。从环境准备、Zookeeper集群安装、Hadoop集群配置到启动测试,详细阐述了每个步骤,确保集群稳定运行。

本文介绍了如何搭建包含HDFS高可用(HA)、YARN的Hadoop集群。从环境准备、Zookeeper集群安装、Hadoop集群配置到启动测试,详细阐述了每个步骤,确保集群稳定运行。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

398

398

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?