这里已经假设部署了hadoop2.6.0 HA集群:

节点安排如下:

| 节点名称 | 角色 |

|---|---|

| itcast01、itcast02 | Namenode和zkfc |

| itcast03、itcast04 | ResourceManager |

| itcast05、itcast06、itcast07 | QuorumPeerMain JournalNode、Datanode、NodeManager |

1.在spark官网下载安装包,注意版本必须匹配,否则自己编译源码后再安装,这里选择 spark-1.3.1-bin-hadoop2.6 版本

2.在scala官网下载安装包,选择版本scala-2.10.4

3.上传spark和scala安装包到各个节点:

节点角色安排:

| 节点名称 | 角色 |

|---|---|

| itcast01、itcast02 | Spark Master |

| itcast05、itcast06、itcast07 | Spark slave |

4.通过scp命令拷贝安装包至各个节点(已经开启ssh互信):

root@itcast01> scp scala-2.10.4.tgz spark-1.3.1-bin-hadoop2.6.tgz root@itcast07:/root

5.在各个节点上(12567)解压安装包,并配置环境变量配置文件 /etc/profile

解压:

[root@itcast01 ~]# tar -zxvf spark-1.3.1-bin-hadoop2.6.tgz -C /itcast/

---

[root@itcast01 ~]# tar -zxvf scala-2.10.4.tgz -C /itcast//itcast是根目录下一个文件夹,一般用于放置hadoop集群文件,这里你可以自己设定

配置环境变量:

编辑配置文件:

vim /etc/profile

在/etc/profile 文件中添加:

export SCALA_HOME=/itcast/scala-2.10.4

export SPARK_HOME=/itcast/spark-1.3.1-bin-hadoop2.6

并在PATH变量中添加 $SCALA_HOME/bin:$SPARK_HOME/bin:

6.Spark配置文件的修改

修改配置文件conf/spark-env.sh

#java安装目录

JAVA_HOME=/usr/java/jdk1.7.0_79

#scala安装目录

SCALA_HOME=/itcast/scala-2.10.4

#hadoop 配置文件的目录(HA必须指定)

HADOOP_CONF_DIR=/itcast/hadoop-2.6.0/etc/hadoop/

##Spark集群配置参数##

#配置master的端口号

SPARK_MASTER_PORT=7077

#配置master的web端口号

SPARK_MASTER_WEBUI_PORT=8080

SPARK_WORKER_CORES=1

SPARK_WORKER_MEMORY=1000m

SPARK_WORKER_PORT=7078

SPARK_WORKER_WEBUI_PORT=8081

SPARK_WORKER_INSTANCES=1

修改配置文件conf/slaves

指定Spark的所有Slave节点地址,以IP或者hostname的形式标识

itcast05

itcast06

itcast077.拷贝配置文件到各个节点

scp spark-env.sh slaves root@$[HOSTNAME]:/itcast/spark-1.3.1-bin-hadoop2.6/conf/ 8.启动集群

启动顺序:Zookeeper -> Hadoop -> Spark

在3个Zookeeper节点分别执行:

【ZOOHOME】/bin/zkServer.sh start

namenode节点执行:

【HADOOP_HOME】/sbin/start-dfs.sh

resourcemanager节点执行:

【HADOOP_HOME】/sbin/start-yarn.sh

resourcemanager热备节点执行:

【HADOOP_HOME】/sbin/yarn-dameons.sh start resourcemanager

SparkMaster节点执行:

【SPARK_HOME】/sbin/start-all.sh

SparkMaster热备节点执行:

【SPARK_HOME】/sbin/start-master.sh

9.检查

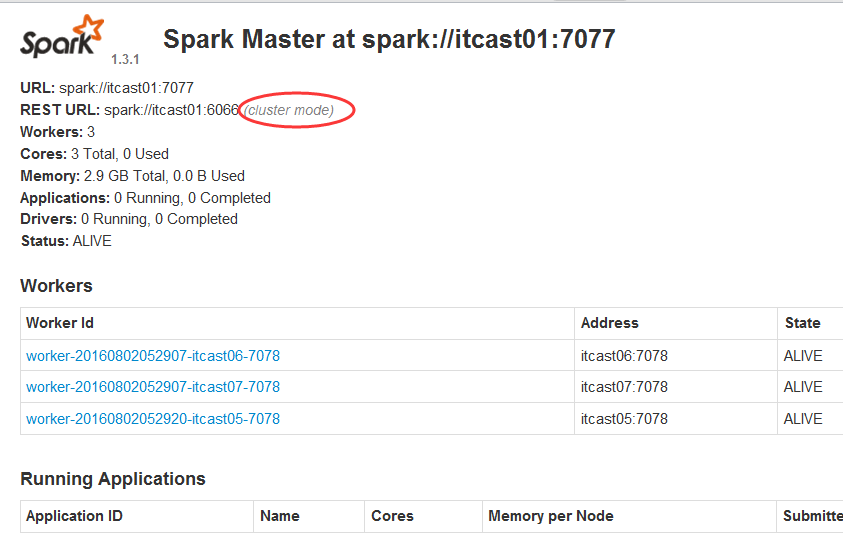

在web浏览器栏输入:http://【SPARK_MASTER】:8080/

第二行的 cluster mode 说明spark目前以集群模式启动

成功!

673

673

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?