一、ELK介绍

本节内容来自 开源实时日志分析ELK平台部署,感谢原作者详细的介绍。

日志主要包括系统日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

通常,日志被分散的储存不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。这样是不是感觉很繁琐和效率低下。当务之急我们使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。

集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心。

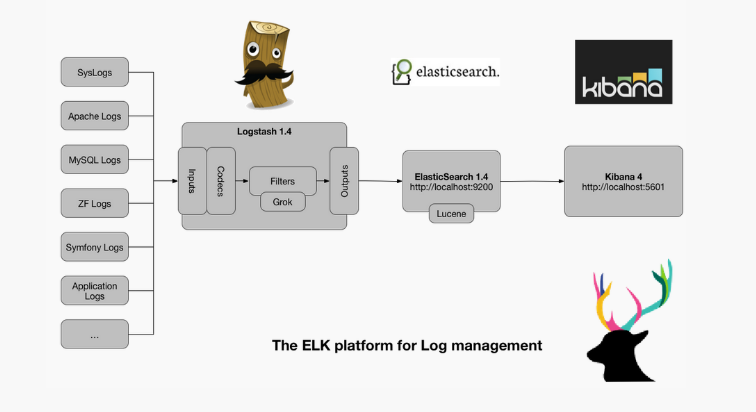

开源实时日志分析ELK平台能够完美的解决我们上述的问题,ELK由ElasticSearch、Logstash和Kiabana三个开源工具组成。官方网站请戳这里

- Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

- Logstash是一个完全开源的工具,他可以对你的日志进行收集、过滤,并将其存储供以后使用(如,搜索)。

- Kibana 也是一个开源和免费的工具,它Kibana可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助您汇总、分析和搜索重要数据日志。

二、ELK架构

三、ELK安装

- 系统环境 CentOS release 6.5 (Final)

- Elasticsearch 2.4.1

- Logstash 2.4.0

- Kibana 4.6.1

- java 1.7.0_79

本节主要介绍ELK的安装,至于java的安装和配置在这里不在进行阐述。

Elasticsearch

1、下载

wget https://download.elastic.co/elasticsearch/release/org/elasticsearch/distribution/tar/elasticsearch/2.4.1/elasticsearch-2.4.1.tar.gz2、解压

[userwyh@userwyh elk]$ tar -xzvf elasticsearch-2.4.1.tar.gz

[userwyh@userwyh elk]$ cd elasticsearch-2.4.13、安装Head插件

[userwyh@userwyh elasticsearch-2.4.1]$ ./bin/plugin install mobz/elasticsearch-head

-> Installing mobz/elasticsearch-head...

Trying https://github.com/mobz/elasticsearch-head/archive/master.zip ...

Downloading ...........................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................DONE

Verifying https://github.com/mobz/elasticsearch-head/archive/master.zip checksums if available ...

NOTE: Unable to verify checksum for downloaded plugin (unable to find .sha1 or .md5 file to verify)

Installed head into /mnt/elk/elasticsearch-2.4.1

本文介绍了ELK(Elasticsearch, Logstash, Kibana)平台的搭建过程,包括每个组件的功能、ELK架构,以及在CentOS 6.5环境下各个组件的详细安装步骤。通过ELK,可以实现日志的集中化管理、统计和检索,方便对服务器日志进行高效分析和问题排查。"

109636345,9186300,树莓派串口发送16进制Hex Python教程,"['树莓派开发', 'Python编程', '串口通信', '硬件交互']

本文介绍了ELK(Elasticsearch, Logstash, Kibana)平台的搭建过程,包括每个组件的功能、ELK架构,以及在CentOS 6.5环境下各个组件的详细安装步骤。通过ELK,可以实现日志的集中化管理、统计和检索,方便对服务器日志进行高效分析和问题排查。"

109636345,9186300,树莓派串口发送16进制Hex Python教程,"['树莓派开发', 'Python编程', '串口通信', '硬件交互']

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

411

411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?