(1) 坑一 会报如下的错误

[ERROR] Failed to execute goal on project spark-launcher_2.11: Could not resolve dependencies for project org.apache.spark:spark-launcher_2.11:jar:2.2.0: Could not find artifact org.apache.hadoop:hadoop-client:jar:2.6.0-cdh5.7.0 in nexus-aliyun (http://maven.aliyun.com/nexus/content/groups/public) -> [Help 1]

[ERROR]

[ERROR] To see the full stack trace of the errors, re-run Maven with the -e switch.

[ERROR] Re-run Maven using the -X switch to enable full debug logging.

[ERROR]

[ERROR] For more information about the errors and possible solutions, please read the following articles:

[ERROR] [Help 1] http://cwiki.apache.org/confluence/display/MAVEN/DependencyResolutionException

编辑 pom.xml 文件 ,添加如下的内容 蓝色字体需要添加的, 默认就行了

cloudera

cloudera repository

https://repository.cloudera.com/artifactory/cloudera-repos/

有条件的话 推荐VPN(可以访问谷歌等网站)

坑二 : 有时编译的机器内存不够

注意编辑机器的内存 一般推荐4G以上的内存

export MAVEN_OPTS="-Xmx2g -XX:ReservedCodeCacheSize=512m"

坑三:

如果编译的是Scala版本是2.10 需要先执行如下的脚本

./dev/change-scala-version.sh 2.10

坑四:

在编译spark源码的时候老师报类似的错误然后在spark 文件夹下的pom.xml里加入如下依赖,源码编译就没有报错成功编译出来了

修改spark源码下的 pom.xml 文件

net.alchim31.maven

scala-maven-plugin

3.2.0

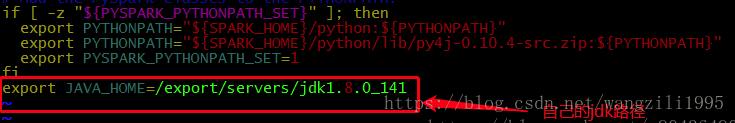

坑五:Spark 启动时,提示 JAVA_HOME not set

在sbin目录下的spark-config.sh文件下未添加JAVA_HOME的索引.

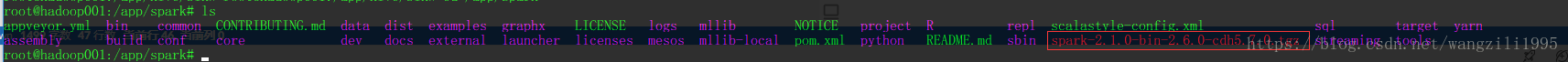

编译完成后 会打包生成一个tar包

Spark Standalone模式的架构和Hadoop HDFS/YARN很类似的

1 master + n worker

spark-env.sh

SPARK_MASTER_HOST=hadoop001

SPARK_WORKER_CORES=2

SPARK_WORKER_MEMORY=2g

SPARK_WORKER_INSTANCES=1

hadoop1 : master

hadoop2 : worker

hadoop3 : worker

hadoop4 : worker

…

hadoop10 : worker

slaves:

hadoop2

hadoop3

hadoop4

…

hadoop10

==> start-all.sh 会在 hadoop1机器上启动master进程,在slaves文件配置的所有hostname的机器上启动worker进程

963

963

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?