简介:在Python中,文本词频统计是一个涉及自然语言处理和数据挖掘的基础任务。本项目展示了如何使用Python及其库对《哈姆雷特》和《三国演义》这两部文学作品进行词频分析。通过编写脚本文件"e101.py"和"e102.py",使用 collections.Counter 和 nltk 库完成词频统计,并进行了单词预处理,如停用词移除和词干提取。结果可用于深入分析文本内容,包括主题、风格和作者写作风格。

1. Python文本词频统计基础

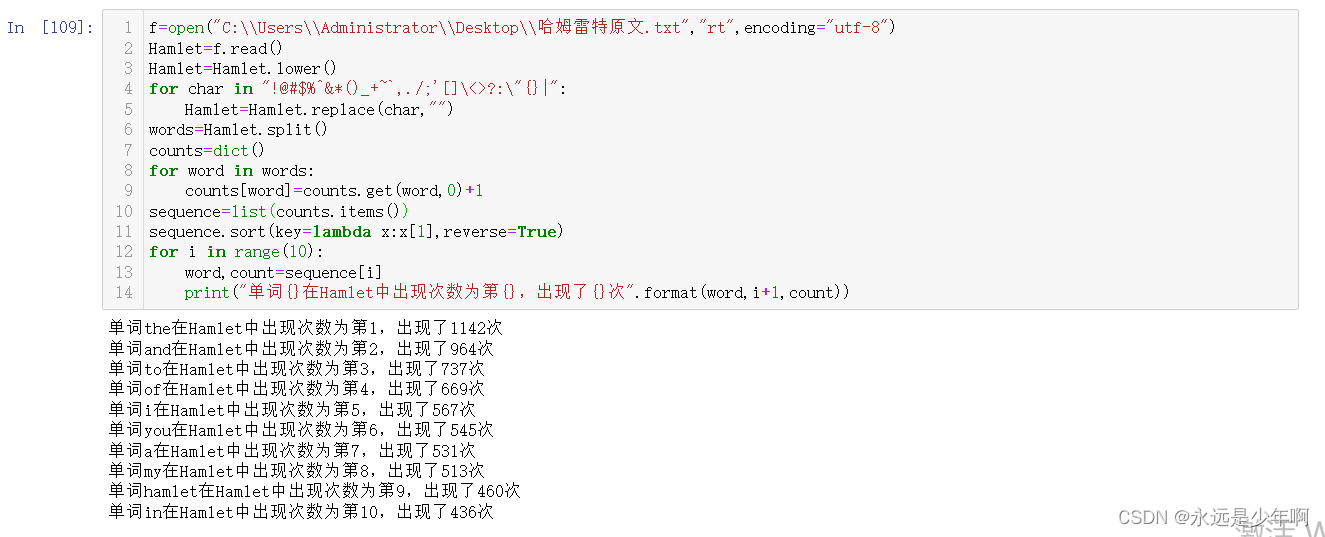

在进行文本分析时,词频统计是一个非常基础且重要的步骤。它可以帮助我们理解文本中的主要内容,发现关键词汇,并为进一步的文本挖掘奠定基础。本章节将带领读者从零开始,了解词频统计的概念和如何使用Python进行初步的词频统计。

1.1 词频统计的意义

词频统计(Term Frequency,简称TF)是指在一定数量的文本中,某个词语出现的次数。这是文本挖掘和信息检索中的一种基础技术。通过对词频的统计和分析,我们可以对文本集中的内容进行初步的量化评估。

1.2 Python中的词频统计实现

在Python中,我们可以使用基础的数据结构和循环来进行简单的词频统计。代码示例如下:

text = "这是一段示例文本 用来统计词频 在这段文本中 词频 统计 这几个词将会频繁出现"

# 将文本转换为小写,并按空格分割成单词列表

words = text.lower().split()

# 创建一个字典来存储单词频率

word_freq = {}

# 遍历单词列表,统计每个单词出现的次数

for word in words:

if word in word_freq:

word_freq[word] += 1

else:

word_freq[word] = 1

# 打印每个单词及其频率

for word, freq in word_freq.items():

print(f"单词: {word}, 频率: {freq}")

通过上述代码,我们可以得到文本中每个单词的出现频率,并进行后续的分析。在接下来的章节中,我们将介绍更高级的库和工具,以及如何处理更复杂的文本数据。

2. 《哈姆雷特》与《三国演义》文本分析

2.1 经典文学作品的文本获取

2.1.1 网络资源的下载和整理

获取经典文学作品的文本是进行文本分析的第一步。对于《哈姆雷特》和《三国演义》这类公有领域的文学作品,我们可以使用多种在线资源进行下载。例如,Project Gutenberg 和 ManyBooks 提供了各种语言的经典文学作品的电子版下载。

为了获取《哈姆雷特》文本,可以通过访问 Project Gutenberg 的网站,使用其提供的搜索功能找到这部作品,并下载它的文本文件。通常,这类网站提供的文本文件为纯文本格式(如 .txt ),这样便于后续处理。

对于《三国演义》,如果想要获取中文版本,可以查找中国的电子书网站或图书馆资源。下载时,需要注意文件编码,确保为UTF-8格式,以避免后续处理时出现乱码。

2.1.2 文本的格式化和预处理

获取文本后,需要进行格式化和预处理,以便于分析。格式化涉及将文本转换为统一的格式,例如将所有字符转换为小写,去除特殊字符和标点符号等。预处理可能包括将文本分割为单独的句子或章节,方便后续的主题和情感分析。

以Python为例,可以使用以下代码来实现基本的文本预处理:

import re

def preprocess_text(text):

# 转换为小写

text = text.lower()

# 移除标点符号

text = re.sub(r'[^\w\s]', '', text)

# 移除数字

text = re.sub(r'\d+', '', text)

# 分词处理

words = text.split()

return words

# 假设已经读取了《哈姆雷特》文本内容到hamlet_text变量中

preprocessed_text = preprocess_text(hamlet_text)

在进行预处理时,务必保持对原作品内容的尊重,遵守相关的版权法规和道德准则。

2.2 文本内容的初步探索

2.2.1 文本的长度和结构分析

对文本长度和结构的分析可以帮助我们了解作品的规模和组织形式。例如,我们可以统计《哈姆雷特》和《三国演义》中的字数、句子数、段落数等。

以《哈姆雷特》为例,可以使用以下代码进行基本的文本长度统计:

# 计算字数

word_count = len(preprocessed_text)

# 计算句子数,这里简单使用句号作为分隔符

sentence_count = len(re.findall(r'[.!?]', preprocessed_text))

# 计算段落数,这里简单使用空行来分隔段落

paragraph_count = preprocessed_text.count('\n\n') + 1

print(f"Word Count: {word_count}")

print(f"Sentence Count: {sentence_count}")

print(f"Paragraph Count: {paragraph_count}")

2.2.2 关键词和主题词的初步挖掘

通过对文本内容的初步探索,可以利用词频统计来挖掘关键词和主题词。这一步骤可以使用Python中的 collections.Counter 类来完成。

以下是如何利用 Counter 来统计词频,并打印出现频率最高的十个词汇的示例代码:

from collections import Counter

# 对预处理后的文本列表计算词频

word_counts = Counter(preprocessed_text)

# 获取出现频率最高的10个词汇

top_ten_words = word_counts.most_common(10)

print("Top 10 words in 'Hamlet':")

for word, count in top_ten_words:

print(f"{word}: {count}")

以上代码能够为我们提供一些关于文本的基本了解,例如哪些词是出现频率最高的。不过,这些高频词往往是连词、代词等停用词,因此在进一步分析时需要考虑去除它们。

3. collections.Counter 库使用

3.1 Counter 库简介

3.1.1 Counter 库的基本功能

collections.Counter 是Python标准库中的一个容器,用于计数可哈希对象。它是一个字典子类,用于计数可哈希对象。元素作为字典的键,其计数作为值。

3.1.2 Counter 库在文本分析中的应用

Counter 在文本分析中的应用十分广泛。由于文本分析通常涉及到对词、短语或其它可哈希实体的计数, Counter 提供了一个简单而有效的解决方案,以统计这些实体的频率。该库不仅直观且易于使用,还能够通过其提供的方法来处理各种计数任务,如最常出现的元素查询、元素的加减等。

3.2 Counter 在词频统计中的实践

3.2.1 统计单词频率的方法和步骤

要使用 Counter 统计单词频率,首先需要导入库,并将文本中的单词存入一个列表中。然后,可以使用 Counter 对这个列表进行计数。下面是一段示例代码:

from collections import Counter

# 假设text是已经清洗过的文本字符串

words = text.split()

# 使用Counter统计单词频率

word_counts = Counter(words)

print(word_counts)

上述代码段将输出一个 Counter 对象,其中包含每个单词及其出现次数。

3.2.2 与传统循环方法的对比分析

传统的循环方法需要手动初始化字典,并在遍历文本时对每个单词进行计数。使用 Counter 可以将这个过程简化为一行代码。下面是一个对比示例:

word_count_dict = {}

for word in words:

if word in word_count_dict:

word_count_dict[word] += 1

else:

word_count_dict[word] = 1

print(word_count_dict)

这种方法虽然直观,但是需要更多的代码行,并且对于初学者来说,可能不如 Counter 直观。 Counter 处理大数据集时更加高效,因为它是用C语言写的,执行效率更高。

通过对比分析,我们可以发现 Counter 不仅简化了代码,也提高了执行效率。它自动处理了数据的初始化和更新过程,使得开发者能够更加专注于数据分析本身,而非基础的计数操作。在处理大规模文本数据时,这种效率的提升尤为明显。

总结来看, collections.Counter 是一个强大的工具,特别适合用于文本分析中的词频统计。其简单易用的接口极大地简化了代码量,同时也提高了运行效率,使得文本分析变得更加便捷和高效。

4. nltk 库文本预处理功能

4.1 nltk 库的基本介绍

nltk 库是自然语言处理工具包(Natural Language Toolkit)的缩写,是Python中用于处理人类语言数据的最著名和广泛使用的库之一。它提供了丰富的接口用于文本的分词、标注、解析,以及向量空间模型等。在文本预处理阶段, nltk 能够帮助我们从原始文本中提取有用的结构和特征,从而为进一步的分析工作做好准备。

4.1.1 nltk 库的安装和导入

安装 nltk 库通常非常简单,可以通过pip工具安装最新版本:

pip install nltk

安装之后,我们在Python代码中导入 nltk 库,并下载所需的数据包。通常,在使用 nltk 进行文本处理之前,需要下载一系列的数据集和模型,以便使用其内置的功能。在Python脚本中,可以使用以下代码进行下载:

import nltk

# 下载nltk数据包

nltk.download('punkt') # 分词模型

nltk.download('averaged_perceptron_tagger') # 词性标注器

nltk.download('maxent_ne_chunker') # 命名实体识别器

nltk.download('words') # 英语词汇库

4.1.2 nltk 库的主要功能概述

nltk 库的主要功能非常丰富,包括但不限于:

- 分词(Tokenization):将文本切分成单词或其他有意义的片段。

- 标记化(Tagging):给单词标注词性,比如名词、动词等。

- 解析(Parsing):分析文本的语法结构。

- 词干提取(Stemming)和词形还原(Lemmatization):将单词转化为基本形式。

- 命名实体识别(Named Entity Recognition, NER):识别文本中的实体,如人名、地名、组织名等。

接下来,我们将重点探讨 nltk 库在文本预处理中的具体应用,即分词与标记化处理(4.2.1),以及词性标注和命名实体识别(4.2.2)。

4.2 利用 nltk 进行文本预处理

4.2.1 分词与标记化处理

分词是文本预处理中的第一个步骤,指的是将连续的文本切分成有意义的词汇单元。在 nltk 中,使用 word_tokenize 函数可以轻松完成这项工作:

import nltk

# 示例文本

text = "Natural language processing (NLP) is a field of computer science, artificial intelligence, and linguistics concerned with the interactions between computers and human (natural) languages."

# 分词

tokens = nltk.word_tokenize(text)

print(tokens)

执行上述代码后,我们得到一个由单词组成的列表。然而,在进一步分析之前,通常需要将这些单词转化为标准形式,这个过程称为标记化。在 nltk 中,可以使用 pos_tag 函数给单词标注词性:

# 词性标注

tagged_tokens = nltk.pos_tag(tokens)

print(tagged_tokens)

执行上述代码后,输出结果会包含每个单词及其对应的词性标签(如名词NN、动词VB等)。

4.2.2 词性标注和命名实体识别

词性标注(Part-of-Speech Tagging, POS Tagging)的目的是标注出句子中每个单词的词性,这对于后续的文本分析至关重要。 nltk 库提供了多个POS标注器,其中 PerceptronTagger 是一个常用且效果较好的选择。以下是一个词性标注的例子:

from nltk import pos_tag

from nltk.tokenize import word_tokenize

# 示例文本

sentence = "NLTK is a leading platform for building Python programs to work with human language data."

# 分词

words = word_tokenize(sentence)

# 词性标注

tagged_words = pos_tag(words)

print(tagged_words)

命名实体识别(Named Entity Recognition, NER)是NLP中的一个任务,其目的是识别文本中具有特定意义的实体,如人名、地名、机构名等。 nltk 的 maxent_ne_chunker 可以用于这项任务:

import nltk

nltk.download('maxent_ne_chunker')

nltk.download('words')

# 示例文本

sentence = "Barack Obama was the president of the United States."

# 分词与词性标注

tokens = word_tokenize(sentence)

tagged_tokens = pos_tag(tokens)

# 命名实体识别

tree = nltk.ne_chunk(tagged_tokens)

print(tree)

运行以上代码后, tree 对象会包含句子中的命名实体,以树状结构呈现。

通过本节的介绍,我们可以看到 nltk 库在文本预处理中的强大功能和灵活性。它不仅能够快速完成基本的文本分词任务,还可以进行深入的词性标注和命名实体识别,为后续的文本分析工作打下坚实基础。在实际应用中,我们可能需要根据具体任务调整预处理的流程和方法,以达到最佳的效果。接下来,我们将探讨停用词移除以及词干提取技术。

5. 停用词移除与词干提取

5.1 停用词的概念及其在文本分析中的作用

5.1.1 停用词的定义和来源

在文本分析中,停用词(Stop Words)指的是那些在自然语言处理中通常被过滤掉的常见词汇。这些词汇在句子中频繁出现,但对句子的语义贡献通常不大,例如英文中的“the”,“is”,“at”等。停用词的范围并不是固定不变的,它取决于分析的具体语境和目标。例如,在文学作品分析中,某些常用词汇可能是为了特定的文学效果而故意使用的,这时就需要特别小心是否要将其作为停用词移除。

停用词的来源多种多样,一般由一些通用语言的词汇集合构成。例如,NLTK库中就包含了大量的英文停用词列表,这些列表是根据不同的研究目的和场景精心挑选的。开发人员也可以根据自己的需求,手动添加或排除某些词汇。

5.1.2 如何有效地移除停用词

移除停用词是文本分析中的一个常见步骤,这可以减少数据的噪声,提高后续分析的质量和效率。在Python中,可以使用NLTK库快速移除停用词。以下是具体的步骤:

- 导入NLTK库和预定义的停用词列表。

- 准备待处理的文本。

- 将文本分词并标记化。

- 使用列表推导式或循环移除停用词。

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

# 定义要移除的停用词

extra_words = ['ourselves', 'hers', 'between', 'yourself', 'but', 'again', 'there', 'about', 'once', 'during', 'out', 'very', 'having', 'with', 'they', 'own', 'an', 'be', 'some', 'for', 'do', 'its', 'yours', 'such', 'into', 'of', 'most', 'itself', 'other', 'off', 'is', 's', 'am', 'or', 'who', 'as', 'from', 'him', 'each', 'the', 'themselves', 'below', 'are', 'we', 'these', 'your', 'his', 'through', 'don', 'nor', 'me', 'were', 'her', 'more', 'he', 'for', 'also', 'would', 'therefore', 'been', 'have', 'in', 'will', 'on', 'ours', 'had', 'she', 'all', 'no', 'when', 'at', 'any', 'before', 'them', 'same', 'and', 'been', 'have', 'in', 'will', 'on', 'ours', 'had', 'she', 'all', 'no', 'when', 'at', 'any', 'before', 'them', 'same', 'and', 'been', 'have', 'in', 'will', 'on', 'ours', 'had', 'she', 'all', 'no', 'when', 'at', 'any', 'before', 'them', 'same', 'and', 'been', 'have', 'in', 'will', 'on', 'ours', 'had', 'she'] # Simplified for example purposes

# Load English stopwords from NLTK

nltk.download('stopwords')

nltk.download('punkt')

# Example sentence

sentence = "This is an example sentence, showing off the stopword filtration."

# Tokenize the sentence

words = word_tokenize(sentence)

# Convert to lower case

words = [word.lower() for word in words]

# Remove punctuation from each word

words = [word for word in words if word.isalpha()]

# Filter out stop words

filtered_words = [word for word in words if word not in stopwords.words('english') + extra_words]

# Display the list of words

print(filtered_words)

在这段代码中,我们首先导入了必要的模块,并定义了一个额外的停用词列表 extra_words 。然后,我们使用 nltk 的 word_tokenize 函数将句子分词,并将每个词转换成小写。我们还移除了所有的标点符号,以确保只保留单词。最后,我们通过列表推导式移除了所有英文停用词,并打印出过滤后的单词列表。

5.2 词干提取技术

5.2.1 词干提取的理论基础

词干提取(Stemming)是将词汇还原到其基本形式的过程,它是文本分析中的一个基本步骤,目的在于减少词汇形式的变体。这样,不同形式的同一个词就可以被视为相同的项,从而简化词汇的使用和分析。

词干提取的一个常用方法是Porter词干算法,该算法通过一系列规则去除单词的词缀,实现将词汇还原到词干的形式。虽然这种方法有时候可能会生成一些非真实的单词,但在大多数文本分析的背景下,词干的形式足以满足需求。

5.2.2 nltk 库中的词干提取实现

NLTK库提供了Porter词干提取器,可以很容易地实现词干提取。以下是如何使用 nltk 实现词干提取的步骤:

- 导入

nltk库和PorterStemmer。 - 创建一个词干提取器实例。

- 准备待处理的文本。

- 分词并使用词干提取器处理单词。

- 输出处理后的词干。

import nltk

from nltk.stem import PorterStemmer

# 初始化词干提取器

stemmer = PorterStemmer()

# 示例句子

sentence = "Stemming is the process of reducing words to their word stem that affixes to suffixes and prefixes or to the roots of words."

# 分词

words = word_tokenize(sentence)

# 提取词干

stemmed_words = [stemmer.stem(word) for word in words]

# 输出词干

print(stemmed_words)

在这个例子中,我们首先导入了 nltk.stem 中的 PorterStemmer ,然后创建了其实例。对于给定的句子,我们首先分词,然后利用 stemmer.stem(word) 方法提取每个词的词干,并将结果打印出来。

使用词干提取技术,我们可以得到单词的基本形式,这对文本分析和挖掘是非常有用的。例如,在进行文本分类、信息检索或搜索优化时,使用词干可以提高算法的效率和准确性。

6. 文本分析结果深入理解

在进行文本分析时,我们通常关注的是文本中不同词汇的出现频率。通过这些频率数据,我们可以对文本内容进行更深层次的理解。本章节将探讨如何深入理解文本分析的结果,并将这些结果应用到实际的情境中。

6.1 词频统计结果的分析

6.1.1 结果数据的可视化展示

词频统计结果的可视化是一个非常重要的步骤。通过图表,我们可以直观地看出哪些词汇出现的频率最高,从而快速把握文本的重点。常见的可视化工具包括Python中的 matplotlib 库和 seaborn 库。下面是一个简单的例子,展示如何将词频结果绘制成柱状图。

import matplotlib.pyplot as plt

# 假设这是通过词频统计得到的词频数据

word_freq = {'love': 50, 'hate': 30, 'friendship': 20, 'war': 15}

# 绘制柱状图

plt.figure(figsize=(10, 5))

plt.bar(word_freq.keys(), word_freq.values(), color='blue')

plt.xlabel('Words')

plt.ylabel('Frequency')

plt.title('Word Frequency in the Text')

plt.show()

以上代码块将输出一个柱状图,展示各个单词的出现频率。

6.1.2 关键词和主题词的深入分析

关键词和主题词的深入分析可以帮助我们了解文本的核心内容。可以通过TF-IDF(Term Frequency-Inverse Document Frequency)算法来识别这些关键词。该算法通过计算每个词在文档中的频率和在整个文档集合中的分布,来判断词语的重要性。

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文本列表

texts = [

'The sky is blue.',

'The sun is bright.',

'The sun in the sky is bright.',

'We can see the shining sun, the bright sun.'

]

# 创建TF-IDF模型实例

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(texts)

# 获取特征名(词汇)

feature_names = tfidf_vectorizer.get_feature_names_out()

# 显示每个文档的TF-IDF值

for i, doc in enumerate(tfidf_matrix):

feature_index = doc.nonzero()[1]

tfidf_scores = zip(feature_index, [doc[0, x] for x in feature_index])

print(f"Document {i}:")

for index, score in sorted(tfidf_scores, key=lambda x: x[1], reverse=True):

print(f" {feature_names[index]}: {score}")

这段代码展示了如何使用 TfidfVectorizer 来计算文本中每个词的TF-IDF分数,并按照分数排序输出每个文档的重要词汇。

6.2 从词频到文本理解的延伸

6.2.1 词频统计与情感分析的结合

情感分析是一种基于文本分析技术的方法,用来确定文本(如评论、文章等)中的情感色彩是积极的、消极的还是中性的。通过将词频统计与情感分析结合,我们能对文本的情感倾向有一个更全面的认识。例如,使用 TextBlob 库可以快速进行情感分析:

from textblob import TextBlob

text = "I love this book!"

blob = TextBlob(text)

# 输出情感分析结果

print(blob.sentiment)

这段代码将输出一个情感对象,包含极性(polarity)和主观性(subjectivity)两个属性。

6.2.2 词频统计在文学作品研究中的应用

文学作品研究中,词频统计可以用来分析作者的写作风格、主题偏好以及文学作品中的重要主题。例如,通过对《哈姆雷特》和《三国演义》中的词频进行统计,我们可以比较两位作者对某些主题的偏好,以及这些主题在作品中出现的频率。

通过构建一个词频统计表,我们可以更加直观地看到不同主题词的出现频率,从而辅助文学评论家和学者进行更深入的研究。

# 示例数据框架创建

import pandas as pd

# 创建一个DataFrame来展示词频统计

data = {

'Word': ['war', 'love', 'king', 'empire'],

'Hamlet': [5, 20, 15, 0],

'Romance of the Three Kingdoms': [30, 10, 25, 18]

}

df = pd.DataFrame(data)

# 展示词频统计表

print(df)

这段代码创建了一个简单的DataFrame来展示两部作品中特定主题词的词频。这有助于文学研究者快速比较和分析不同作品中的主题倾向。

本章节介绍了如何使用不同的工具和技术深入理解文本分析结果,并将其应用于实际问题中。通过对词频统计结果进行可视化,结合情感分析,并运用于文学作品的研究,我们能够更深入地从文本数据中提取有价值的信息。

简介:在Python中,文本词频统计是一个涉及自然语言处理和数据挖掘的基础任务。本项目展示了如何使用Python及其库对《哈姆雷特》和《三国演义》这两部文学作品进行词频分析。通过编写脚本文件"e101.py"和"e102.py",使用 collections.Counter 和 nltk 库完成词频统计,并进行了单词预处理,如停用词移除和词干提取。结果可用于深入分析文本内容,包括主题、风格和作者写作风格。

4302

4302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?