简介:《信息论与编码理论》是信息安全领域的重要课程,涵盖了信息传输与存储的有效性、准确性和安全性保障。该课程由武汉大学出版社出版,教材包含信息论基础、编码理论、编码技术应用、课件结构和学习资源。信息论基础涉及熵、互信息和香农第一定理。编码理论包括纠错编码、信源编码和信道编码。编码技术应用介绍了数据压缩、数字签名与加密以及通信协议。课件结构包含章节介绍、定义解释、公式推导、实例分析和习题解答等,有助于学生逐步掌握核心概念,并包括实际应用案例。学习资源部分提供课程讲义、习题集和参考资料等,是自学或复习的理想选择。通过学习本课程,学生能掌握信息处理的基础理论,并在通信系统设计、数据安全和信息压缩等实际领域中应用。

1. 信息论基础概念

信息论是一个涵盖广泛领域的学科,它不仅是我们日常生活中交流信息的理论基础,也是现代通信技术不可或缺的一部分。在这一章,我们将从信息论的诞生讲起,深入探讨它的发展历程以及在今天科技世界中的作用。

1.1 信息论的起源与背景

信息论最初由克劳德·香农在1948年提出,香农在他的开创性论文《通信的数学理论》中,奠定了现代信息论的基础。该理论着重于信息的量化和传输过程中的优化,通过数学语言描述通信系统中信号的处理和传输。随着时间的推移,信息论不仅在理论上获得了巨大的进展,也在实际应用中不断展现出其核心价值。

1.2 信息论的核心概念

信息论的核心概念涉及信息的度量、传输和存储。信息量通常用比特(bit)来衡量,它是信息的最小单位。信息的传输过程涉及信号的编码、调制、发送和接收,这些都是为了在有噪声的信道中可靠地传输信息。存储则是信息论中另一重要议题,它关注信息的长期保存和检索效率。这些概念共同构成了信息论的基本框架,是理解和实践现代通信技术的基石。

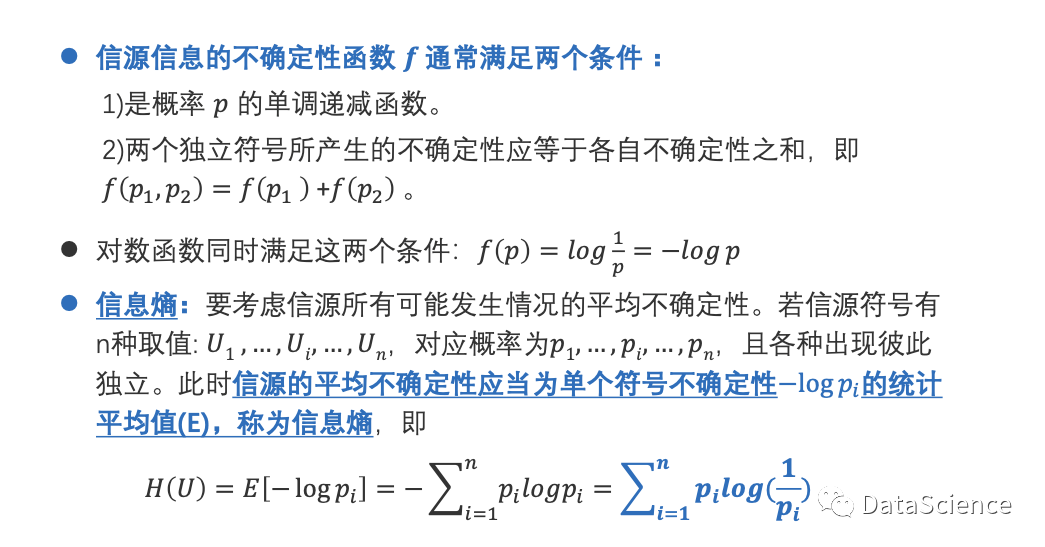

1.3 信息的量化与信息熵

量化信息是信息论中的一个重要步骤,它允许我们衡量和比较信息的多少。信息熵是量化信息不确定性的概念,它由香农首次提出,用来描述信息的平均信息量。信息熵不仅在理论上提供了对信息源特性的重要见解,而且在实践中,如数据压缩和信道编码等领域具有显著的应用价值。

通过本章的学习,您将获得对信息论这一重要学科的基本理解,为后续章节中更深入探讨信息论的具体应用和理论奠定了坚实的基础。

2. 熵与互信息的理解

熵是衡量信息不确定性的一个核心指标,在信息论中占据着举足轻重的地位。理解和计算熵是掌握信息论原理的基础。而互信息作为衡量两个变量间共有信息的量,揭示了信息传输过程中的效率和冗余性。本章将深入探讨熵与互信息的定义、计算方法和性质,并探讨它们在通信理论中的应用。

2.1 熵的本质与度量

2.1.1 熵的定义及其物理学背景

熵最初是热力学中的一个概念,由德国物理学家克劳修斯提出,用来描述系统中无序度的程度。在信息论中,熵被类比为消息或系统的不确定性。熵的数学定义为: [H(X) = -\sum_{i=1}^{n} p(x_i) \log p(x_i)] 其中,(H(X))是随机变量(X)的熵,(p(x_i))是该变量取值(x_i)的概率。

从物理学到信息论,熵的度量从描述热力学状态的混乱度转向了信息的不确定性。这种度量揭示了信息的真正价值——信息的稀缺性和预期效应。

2.1.2 熵的计算方法和信息熵

信息熵是信息量的一个度量,它量化了信息的平均不确定性。信息熵的计算实质上是对可能事件发生的概率进行加权平均。每个可能事件的信息量与它发生的概率的对数成反比。

对于连续随机变量,熵的计算需要使用概率密度函数,计算公式为: [H(X) = -\int_{-\infty}^{+\infty} f(x) \log f(x) dx] 在实际应用中,信息熵有助于我们评估信源的不确定性以及信道的容量。

2.1.3 熵的性质及其在通信中的应用

信息熵具有几个关键性质,例如可加性、最大值和最小值条件,这些性质在通信系统的性能评估中起着重要作用。

-

可加性 :如果(X)和(Y)是两个独立的随机变量,则它们组合的熵等于各自熵的和: [H(X,Y) = H(X) + H(Y)]

-

最大值条件 :在所有可能的概率分布中,均匀分布的熵最大。这意味着均匀分布提供了最大的不确定性。

-

最小值条件 :如果一个随机变量的取值是确定的,即其中一个取值的概率为1,其余为0,那么该随机变量的熵最小,为0。

在通信中,熵的性质用于信道编码设计、数据压缩以及评估信源的不确定性和冗余度。理解这些性质可以帮助设计更为高效和可靠的通信系统。

2.2 互信息的概念与作用

2.2.1 互信息的定义及数学表达

互信息用于量化两个随机变量间共享的信息量。其数学定义为: [I(X;Y) = \sum_{x \in X} \sum_{y \in Y} p(x,y) \log \frac{p(x,y)}{p(x)p(y)}] 其中,(I(X;Y))表示随机变量(X)和(Y)的互信息。

互信息的概念在信息论中至关重要,因为它不仅量化了两个变量间的相关性,还揭示了信息传输过程中的冗余度和效率。

2.2.2 互信息在信源编码中的应用

在信源编码中,互信息被用于衡量信源符号之间的相互依赖性,从而优化编码过程。比如在霍夫曼编码中,根据互信息进行权衡可以决定哪些符号应该被编码得更短。

2.2.3 互信息在信道编码中的意义

在信道编码中,互信息可以帮助我们了解信道传输信息的能力。信道容量是互信息的一个重要概念,它表示在不产生错误的情况下,信道能够传输的最大信息量。互信息的分析有助于优化信道编码方案,提升传输效率。

在下一章节中,我们将继续探讨香农定理以及编码理论的其他方面,为深入理解信息传输和存储提供更加丰富的知识。

3. 香农第一定理与编码理论

香农第一定理,又称信道编码定理,由克劳德·香农在1948年提出,它规定了在给定的信道中,存在一个信道容量上限,通过合适的编码技术,可以无限接近这一容量上限而进行通信,几乎不出现错误。本章将从定理的数学表述出发,逐步深入到编码理论的基本原理及其在通信系统中的实际应用。

3.1 香农第一定理的数学表述

3.1.1 信道容量的定义和计算

信道容量(C)是描述信道传输信息能力的一个度量值,它代表了在一定的信道噪声条件下,信道能够传输的最大信息速率,单位通常为比特每秒(bps)。香农公式给出了无噪声信道的容量计算方式:

[ C = B \log_2(1 + \frac{S}{N}) ]

其中: - (C) 是信道容量(bps); - (B) 是信道的带宽(Hz); - (S) 是信号的平均功率(W); - (N) 是噪声的平均功率(W)。

在此基础上,香农引入了信噪比(SNR),定义为信号功率与噪声功率的比值。信道容量的公式可重写为:

[ C = B \log_2(1 + SNR) ]

3.1.2 香农定理的证明概述

香农定理的证明涉及概率论和信息论的复杂概念,但其核心思想在于,无论信道噪声如何,都存在一种编码方式使得通信可以进行而错误率可任意小。这意味着通过不断增加信号的冗余度,可以达到信道容量的极限值。香农定理通过信息熵的数学模型和概率论的极限理论,表明在理论上只要信息传输速率不超过信道容量,就能够找到一种编码方法使得错误概率随着编码长度的增加而趋于零。

3.1.3 信道编码定理与实例分析

信道编码定理描述了如何通过编码来接近信道容量。编码过程增加了信息传输的冗余度,使得在传输中即使有部分信息被干扰,接收端也能通过纠错算法恢复原始数据。

一个典型的实例是利用汉明码(Hamming Code)进行错误检测与纠正。汉明码是一种线性纠错码,通过在数据中插入校验位来检测和纠正单比特错误。在实际应用中,例如在数字通信系统中,可以采用汉明码来确保数据传输的准确性。具体的编码过程包括确定合适的校验位数量,然后将这些校验位以一种特定的方式插入到数据流中,这样在接收端就可以通过特定的算法来检测并纠正出现的错误。

3.2 编码理论的基本原理

3.2.1 前向纠错编码与性能指标

前向纠错编码(FEC)是指在发送端对数据进行编码,使得即使接收端在传输过程中检测到错误,也能够在不请求重发的情况下,独立地纠正这些错误。性能指标如编码增益、编码复杂度和纠错能力是衡量FEC性能的重要因素。

3.2.2 信源编码定理及其应用

信源编码定理解决了如何在给定的通信带宽和噪声条件下,有效压缩信息的问题。根据香农的信源编码定理,存在一种最优编码方式,使得信息可以以接近信息熵的速率被压缩和传输,同时保证可被无损地还原。

信源编码在实际应用中,如在语音和图像的压缩处理中,使用了如霍夫曼编码(Huffman Coding)和算术编码(Arithmetic Coding)等技术。霍夫曼编码通过为不同字符赋予不同长度的二进制码字来实现压缩,其在压缩率和效率方面具有优势。算术编码则可以提供比霍夫曼编码更高的压缩效率,尤其适用于对小字符集的数据进行压缩。

3.2.3 码长、码率和冗余度的权衡

在编码理论中,码长、码率和冗余度是三个核心概念。码长是指编码后的数据长度,码率是指原始信息与编码信息的比率,而冗余度则是指编码过程中增加的非信息内容的比例。

在设计编码方案时,需要在传输效率与错误纠正能力之间进行权衡。短码长通常具有较低的冗余度,但可能牺牲了纠错能力;而长码长能够提供更高的纠错能力,但会降低传输效率。信道条件、信息的重要性和传输要求都是在选择合适的码长、码率和冗余度时需要考虑的因素。通过算法和策略的优化,可以在保证通信质量的同时,尽可能提高传输效率。

4. 纠错编码与信源编码

4.1 纠错编码的技术与应用

4.1.1 常见的纠错编码方法:汉明码、里德-所罗门码等

纠错编码是现代通信系统中不可或缺的部分,它通过引入冗余信息来检测和纠正数据在传输过程中产生的错误。汉明码和里德-所罗门码是两种广泛应用的纠错编码技术,它们各有特点。

汉明码由理查德·卫斯理·汉明提出,是一种线性纠错码。它可以在编码中加入校验位,通过特定的编码算法使得传输的每个数据包都能检测到单个错误,并且纠正这个错误。汉明码适用于纠正位错误,其设计简单,易于实现,但也只能纠正单个错误,对于多位错误则无能为力。

里德-所罗门码(Reed-Solomon codes)是基于有限域代数的一种纠错码,它能有效地纠正多个错误。这类码广泛应用于数字通信和存储系统中,比如CD和DVD的纠错。里德-所罗门码的一个重要特点是它能够处理连续的符号错误,而在数字通信中,连续的错误比单个错误更为常见。

4.1.2 纠错编码在通信系统中的实现

在通信系统中实现纠错编码,需要对原始数据进行编码处理,然后在接收端进行解码。一般而言,纠错编码实现包括以下几个步骤:

- 编码器设计: 设计一个能够根据输入数据生成带校验信息的编码器。例如,对于汉明码,编码器需要计算出哪些校验位,并将它们插入到数据流中正确的位置。

-

调制与传输: 将编码后的数据进行调制,然后通过物理媒介发送出去。调制的目的是将数据流转换为可以通过物理媒介传输的信号。

-

解码器实现: 在接收端,需要设计一个能够从接收到的带有错误的数据中恢复原始信息的解码器。对于汉明码,解码器会利用校验信息来检测和纠正错误。

-

错误检测与纠正: 实现错误检测逻辑,一旦检测到错误,解码器将尝试利用纠错逻辑进行修正。对于里德-所罗门码,通常采用基于有限域上的多项式运算来实现错误的检测和纠正。

4.1.3 纠错编码的选择和系统性能评估

选择合适的纠错编码方法,要基于通信系统的特定需求,以及系统对错误纠正能力和复杂度的折衷。性能评估主要涉及以下几个方面:

-

纠错能力: 不同的编码方法具有不同的纠错能力,例如,里德-所罗门码通常具有比汉明码更好的纠错能力,可以处理更多的错误。

-

开销大小: 纠错编码引入的校验位会增加数据的传输开销,因此需要平衡开销和纠错能力。

-

编码/解码复杂度: 某些编码技术在编码和解码过程中可能要求较高的计算资源,这在资源受限的环境中可能成为一个问题。

-

系统要求: 不同的通信系统对延迟、数据完整性、吞吐量等有不同的要求,这些都将影响纠错编码方法的选择。

4.2 信源编码的策略与技术

4.2.1 信源编码的基本概念

信源编码是信息论中的一个基本概念,它致力于解决如何有效地压缩数据以减少传输的数据量而不损失信息。信源编码的主要任务是去除数据中的冗余,利用数据的统计特性来减少表示数据所需的比特数。

信源编码的过程可以分为两个阶段:数据模型化和数据压缩。数据模型化是指确定数据的概率分布模型,数据压缩是指利用这一模型来减少数据冗余。信源编码的理论基础包括香农的熵概念和信道容量定理。

4.2.2 常见的信源编码技术:霍夫曼编码、算术编码等

信源编码技术通过分析数据的统计特性来压缩数据。下面介绍两种常见的信源编码技术:

-

霍夫曼编码(Huffman Coding): 霍夫曼编码是一种广泛使用的无损数据压缩方法。它依据字符在待编码数据中出现的频率来构建一棵霍夫曼树,每个字符对应树上的一个叶节点,并且字符出现的频率越低,它对应的编码就越长。这种方法可以有效减少数据的平均编码长度,提高压缩率。

-

算术编码(Arithmetic Coding): 算术编码是一种更高级的数据压缩技术,它不是对单个字符进行编码,而是对整个消息进行编码。算术编码能够根据字符出现的概率来为整个消息分配一个介于0和1之间的实数作为编码。算术编码能够更精细地利用数据的概率分布信息,因此它通常比霍夫曼编码具有更高的压缩比,尤其是在数据符号之间的概率差异较大时。

4.2.3 信源编码在多媒体压缩中的作用

信源编码在多媒体数据压缩中扮演着至关重要的角色。多媒体数据往往具有较高的冗余度,因此,通过有效的信源编码技术可以大幅减少需要传输的数据量,节省存储空间,加快网络传输速度。

在音频和视频编码中,信源编码技术通常会结合心理声学和心理视觉模型来进一步提高压缩效率。例如,MP3音频编码使用心理声学模型来去除人耳无法察觉的音频信息,而H.264视频编码则利用对视觉冗余度的深入理解来实现高效的视频压缩。

算法实现示例

以下是使用霍夫曼编码的一个简单示例,代码将为一个字符串生成霍夫曼树并为其生成编码,使用Python编程语言实现:

import heapq

from collections import defaultdict, Counter

class Node:

def __init__(self, char, freq):

self.char = char

self.freq = freq

self.left = None

self.right = None

# 为了使节点可以被比较,必须定义比较方法

def __lt__(self, other):

return self.freq < other.freq

def calculate_frequencies(data):

return Counter(data)

def build_huffman_tree(frequencies):

priority_queue = [Node(char, freq) for char, freq in frequencies.items()]

heapq.heapify(priority_queue)

while len(priority_queue) > 1:

left = heapq.heappop(priority_queue)

right = heapq.heappop(priority_queue)

merged = Node(None, left.freq + right.freq)

merged.left = left

merged.right = right

heapq.heappush(priority_queue, merged)

return priority_queue[0]

def assign_codes(node, prefix="", code={}):

if node is not None:

if node.char is not None:

code[node.char] = prefix

assign_codes(node.left, prefix + "0", code)

assign_codes(node.right, prefix + "1", code)

return code

def huffman_encoding(data):

frequencies = calculate_frequencies(data)

huffman_tree = build_huffman_tree(frequencies)

huffman_code = assign_codes(huffman_tree)

encoded_data = ''.join(huffman_code[char] for char in data)

return encoded_data, huffman_code

# 示例数据

data = "this is an example for huffman encoding"

encoded_data, huffman_code = huffman_encoding(data)

print(f"Encoded Data: {encoded_data}")

print(f"Huffman Code: {huffman_code}")

在这个例子中, calculate_frequencies 函数计算了输入字符串中每个字符的出现频率。 build_huffman_tree 函数通过频率堆构建了霍夫曼树,而 assign_codes 函数则为每个字符分配了霍夫曼编码。最后, huffman_encoding 函数执行整个编码过程,并输出编码后的数据和每个字符对应的霍夫曼编码。

5. 信道编码策略与数据压缩技术

在通信和数据存储领域,信道编码策略与数据压缩技术是提高数据传输效率和存储效率的重要手段。信道编码能增强数据传输的可靠性,而数据压缩则是优化数据存储和传输的有效途径。在本章中,我们将详细探讨信道编码的策略选择与优化,以及数据压缩技术的原理和应用。

5.1 信道编码策略的选择与优化

信道编码是通信系统中的关键技术之一,它能够在不增加传输功率的情况下,通过增加数据冗余来提高通信系统的可靠性。选择正确的信道编码策略对于保证数据在传输过程中的完整性至关重要。

5.1.1 信道编码策略的分类与对比

信道编码策略主要可以分为两大类:线性编码和非线性编码。线性编码中常见的有汉明码、里德-所罗门码等。它们各有优缺点,比如汉明码可以检测并纠正单个错误,而里德-所罗门码则在多个错误纠正方面更为有效。选择时需要根据具体应用场景和需求进行权衡。

5.1.2 高效信道编码的设计原则

高效的信道编码设计应遵循以下原则:

- 误码率低 :设计的编码应能最大限度地减少错误概率。

- 复杂度低 :编码和解码过程应尽量简单,以降低计算资源的消耗。

- 可扩展性 :编码策略应能适应不同传输速率和信道条件的变化。

- 适应性 :能够根据信道的变化自适应调整编码方案。

5.1.3 信道编码在无线通信中的应用

在无线通信中,由于信道条件复杂多变,信道编码的作用尤为突出。例如,LTE/4G和5G通信标准中,就采用了多种复杂的信道编码技术,如Turbo码、低密度奇偶校验码(LDPC)和极化码(Polar Code),以满足高速、高可靠性的通信需求。

5.2 数据压缩技术的原理与应用

数据压缩技术通过减少数据冗余来达到降低存储空间和传输带宽的需求。它在互联网、多媒体处理和存储系统中有着广泛的应用。

5.2.1 无损压缩与有损压缩的区别和原理

无损压缩和有损压缩是数据压缩的两大类型:

- 无损压缩 :在压缩过程中不会丢失任何数据信息,如ZIP文件压缩,常用于文本数据和程序代码的压缩。

- 有损压缩 :在压缩过程中允许一定程度的数据信息损失,以换取更高的压缩比,如JPEG和MP3格式,主要应用于图像和音频的压缩。

有损压缩技术通常利用了人类感知系统的局限性来减少数据的冗余度,例如,在视觉信息中可能舍弃人眼不易察觉的颜色细节。

5.2.2 数据压缩算法的实际应用案例

- Huffman编码 :用于无损数据压缩,它根据字符出现的频率来构建最优的前缀编码。

- JPEG标准 :广泛用于有损图像压缩,通过将图片转换到频率域并去除不重要的频率成分,以实现压缩。

- MP3格式 :对音频进行有损压缩的同时保留较高质量的听觉体验,主要通过去除人耳难以捕捉的声音细节。

5.2.3 数据压缩在存储和网络传输中的角色

数据压缩技术在存储和网络传输中扮演着重要的角色。在存储方面,压缩可以极大地减少所需的存储空间,提高数据存储效率。在网络传输中,压缩可以减少数据包的大小,提升传输速率,并降低网络拥堵的可能性。随着云计算和大数据技术的发展,数据压缩技术的重要性日益增加。

在接下来的章节中,我们将继续探讨数字签名、加密技术及通信协议的实际应用,以及推荐课程学习资源,帮助读者深入理解和应用这些重要的信息技术。

简介:《信息论与编码理论》是信息安全领域的重要课程,涵盖了信息传输与存储的有效性、准确性和安全性保障。该课程由武汉大学出版社出版,教材包含信息论基础、编码理论、编码技术应用、课件结构和学习资源。信息论基础涉及熵、互信息和香农第一定理。编码理论包括纠错编码、信源编码和信道编码。编码技术应用介绍了数据压缩、数字签名与加密以及通信协议。课件结构包含章节介绍、定义解释、公式推导、实例分析和习题解答等,有助于学生逐步掌握核心概念,并包括实际应用案例。学习资源部分提供课程讲义、习题集和参考资料等,是自学或复习的理想选择。通过学习本课程,学生能掌握信息处理的基础理论,并在通信系统设计、数据安全和信息压缩等实际领域中应用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?