Angela: You want to ask, so ask.

William: Are you real?

Angela: Well, if you can't tell, does it matter?

知乎视频www.zhihu.com看过《Westworld》第一季第二集的人一定会对这个片段印象深刻。年轻的 William 第一次游玩西部世界,在接待大厅遇见了接待员 Angela,它是一个非常逼真的人造人。

年轻的 William 非常执着于分辨,站在他面前的这个楚楚动人的接待员,是机器还是真人。

我猜《Westworld》的编剧团队一定有懂 GAN 的人,因为《Westworld》后面的剧情里,在提高一个人造人逼真程度(fidelity)的训练阶段,也遇到了模式崩塌(mode collapse)的问题。

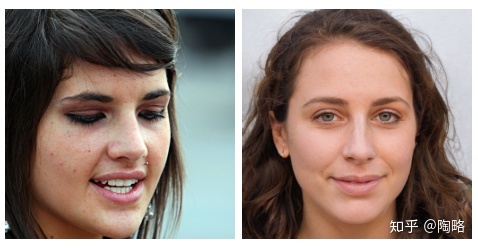

众所周知,在模式崩塌问题得到缓和之后,我们的 GAN 现在能够生成非常逼真的人类肖像图片,逼真到我们人眼都无法分辨真假[1]。

逼真到这个程度了,我们有必要去分辨真假吗?我们还能够分辨真假吗?

这个技术很牛逼,很有用,但也很危险。

自从 Deepfake 等类似技术开源后,人人都能够制造假图片、假视频,可以把视频里的人脸替换成别人或者一个不存在的人。

点我,你也可以!

一旦这个技术普及,我们将无法通过视觉判断视频里的人,是真人还是机器人[2]。如果扩展到语音领域,我们将无法通过听觉区分电话那头的人,是真人还是机器人[3]。更进一步,我们甚至能够轻易在 微博或推特 上创建一个活生生的“人”,甚至把自己包装成美国国会候选人[4]。

所以不少人就开始嚷嚷着:我们要打假!

我们还能够分辨出来吗?

然后许多炼丹师就站出来了:I can't do it, but my networks can!

对于我们伟大的炼丹师而言,这不就是个简单的二分类问题么?我们先随便凑它个10万张真人图片,再用GAN随便生成10万张假图片。然后找个在 ImageNet 上预训练的 ResNet-50 ,把我这个非常平衡的数据集喂进去,game over!

结果居然出乎意料地好!

我们的神经网络,分类精度能够达到95%以上,有时甚至99%[5]!妙啊!

这时候人类就纳闷啊:凭什么我们人类都做不到的事,你这个 Artificial Idiot 准确率怎么能这么高?难道你是 super-human ?

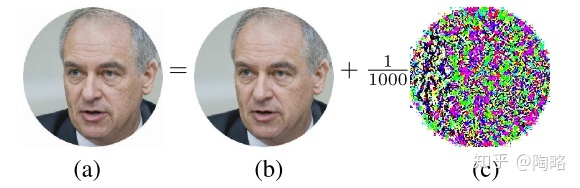

所以这里一定存在某些统计意义上的特征、模式,它们藏在 GAN 生成的图片中,而我们人类察觉不到。一篇论文分析了这些假图片的频谱,发现假图片的频谱与真图片相比,存在着一些伪影(artifacts),我们的卷积神经网络正好可以利用这些作为特征以辨别真假图片[1]。

碰巧的是,我在《对抗鲁棒性简介》里介绍过的 对抗样本,我们人类肉眼也是几乎无法把它与原始图片区分开的。碰巧的是,也有人分析过对抗样本的频谱[6][7],结论也与上文类似!

What a coincidence!

巧合的背后是事物的本质,是潜在的规律。

我们的卷积网络天生就非常擅长捕捉并利用这些频域上的特征(毕竟 时域卷积=频域乘积

扰动一些高频的特征,人类察觉不到,但我们的卷积网络对此非常敏感,这也是对抗样本现象存在的原因之一!参见:《深度学习为何不鲁棒》

是日也,天朗气清,惠风和畅,仰观宇宙之大,俯察品类之盛,所以游目骋怀,足以极视听之娱,信可乐也。

这时候,我们的 Nicholas Carlini 大佬就出现了!他来了,他来了,他带着犀利的文章走来了![8]

大佬就是大佬,文章 Introduction 第一句:“According to his Twitter account, Andrew Walz, was a congressional candidate”。

哈哈哈哈哈,xswl......... 文章开篇就 “根据某推特账号,blablabla.....”

他直接宣布:你们炼丹师训练的这些真假图片检测器,是不鲁棒的!一个微小的扰动,就能够让检测器认为图片是真的!

这在我们搞对抗鲁棒性的人看来,是一件习以为常且喜闻乐见的事,哈哈哈!

Carlini 设计了五种攻击方法,都具有很强的成功率,且对抗样本具备很强的迁移性。

所以我只要稍微在 GAN 生成的假图片上加一点小扰动,或者在 GAN 的隐空间加一点小扰动后再生成假图片,你这个检测器就失效啦~

这个时候,你神经网络也分辨不出来,我们人类也分辨不出来。

If you can't tell, does it matter?

参考

- ^abLeveraging Frequency Analysis for Deep Fake Image Recognition, ICML 2020

- ^宅男福音deepfakes开源了 https://mp.weixin.qq.com/s/hUcQ1SEZlHp7c-wQ-jlfRg

- ^靠「老板语音」骗走182万!音频版Deepfake让员工真假难辨乖乖转账 https://mp.weixin.qq.com/s/Zi78wMI4KZiDcMWy30YgQw

- ^A high school student created a fake 2020 candidate. Twitter verified it https://edition.cnn.com/2020/02/28/tech/fake-twitter-candidate-2020/index.html

- ^What makes fake images detectable? Understanding properties that generalize, ECCV 2020

- ^A Fourier Perspective on Model Robustness in Computer Vision, NeurIPS 2019

- ^High Frequency Component Helps Explain the Generalization of Convolutional Neural Networks, CVPR 2020

- ^Evading Deepfake-Image Detectors with White- and Black-Box Attacks, CVPR 2020

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?