来源:https://www.cnblogs.com/charlieroro

// the services chain

kubeServicesChain utiliptables.Chain = "KUBE-SERVICES"

// the external services chain

kubeExternalServicesChain utiliptables.Chain = "KUBE-EXTERNAL-SERVICES"

// the nodeports chain

kubeNodePortsChain utiliptables.Chain = "KUBE-NODEPORTS"

// the kubernetes postrouting chain

kubePostroutingChain utiliptables.Chain = "KUBE-POSTROUTING"

// the mark-for-masquerade chain

KubeMarkMasqChain utiliptables.Chain = "KUBE-MARK-MASQ" /*对于未能匹配到跳转规则的traffic set mark 0x8000,有此标记的数据包会在filter表drop掉*/

// the mark-for-drop chain

KubeMarkDropChain utiliptables.Chain = "KUBE-MARK-DROP" /*对于符合条件的包 set mark 0x4000, 有此标记的数据包会在KUBE-POSTROUTING chain中统一做MASQUERADE*/

// the kubernetes forward chain

kubeForwardChain utiliptables.Chain = "KUBE-FORWARD"这两个规则主要用来对经过的报文打标签,打上标签的报文可能会做相应处理,打标签处理如下:

(注:iptables set mark 的用法可以参见 https://unix.stackexchange.com/questions/282993/how-to-add-marks-together-in-iptables-targets-mark-and-connmark

http://ipset.netfilter.org/iptables-extensions.man.html )

-A KUBE-MARK-DROP -j MARK --set-xmark 0x8000/0x8000

-A KUBE-MARK-MASQ -j MARK --set-xmark 0x4000/0x4000Chain KUBE-MARK-DROP (6 references)

pkts bytes target prot opt in out source destination

0 0 MARK all -- * * 0.0.0.0/0 0.0.0.0/0 MARK or 0x8000

Chain KUBE-MARK-MASQ (89 references)

pkts bytes target prot opt in out source destination

88 5280 MARK all -- * * 0.0.0.0/0 0.0.0.0/0 MARK or 0x4000-A KUBE-POSTROUTING -m comment --comment "kubernetes service traffic requiring SNAT" -m mark --mark 0x4000/0x4000 -j MASQUERADE-A KUBE-FIREWALL -m comment --comment "kubernetes firewall for dropping marked packets" -m mark --mark 0x8000/0x8000 -j DROPChain INPUT (policy ACCEPT 209 packets, 378K bytes)

pkts bytes target prot opt in out source destination

540K 1370M KUBE-SERVICES all -- * * 0.0.0.0/0 0.0.0.0/0 /* kubernetes service portals */

540K 1370M KUBE-FIREWALL all -- * * 0.0.0.0/0 0.0.0.0/0Chain KUBE-FIREWALL (2 references)

pkts bytes target prot opt in out source destination

0 0 DROP all -- * * 0.0.0.0/0 0.0.0.0/0 /* kubernetes firewall for dropping marked packets */ mark match 0x8000/0x8000-A KUBE-SERVICES -d 172.21.12.49/32 -p tcp -m comment --comment "default/sonatype-nexus: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-HVYO5BWEF5HC7MD7-A KUBE-SVC-HVYO5BWEF5HC7MD7 -m comment --comment "oqton-backoffice/sonatype-nexus:" -j KUBE-SEP-ESZGVIJJ5GN2KKU-A KUBE-SEP-ESZGVIJJ5GN2KKUR -p tcp -m comment --comment "oqton-backoffice/sonatype-nexus:" -m tcp -j DNAT --to-destination 172.20.5.141:8080-A KUBE-SERVICES -m comment --comment "kubernetes service nodeports; NOTE: this must be the last rule in this chain" -m addrtype --dst-type LOCAL -j KUBE-NODEPORTS-A KUBE-NODEPORTS -p tcp -m comment --comment "oqton-backoffice/sonatype-nexus:" -m tcp --dport 32257 -j KUBE-MARK-MASQ

-A KUBE-NODEPORTS -p tcp -m comment --comment "oqton-backoffice/sonatype-nexus:" -m tcp --dport 32257 -j KUBE-SVC-HVYO5BWEF5HC7MD7-A KUBE-SERVICES -d 50.1.1.1/32 -p tcp -m comment --comment "kube-system/nginx-ingress-lb:https loadbalancer IP" -m tcp --dport 443 -j KUBE-FW-J4ENLV444DNEMLR3Chain KUBE-SVC-J4ENLV444DNEMLR3 (3 references)

10 600 KUBE-SEP-ZVUNFBS77WHMPNFT all -- * * 0.0.0.0/0 0.0.0.0/0 /* kube-system/nginx-ingress-lb:https */ statistic mode random probability 0.33332999982

18 1080 KUBE-SEP-Y47C2UBHCAA5SP4C all -- * * 0.0.0.0/0 0.0.0.0/0 /* kube-system/nginx-ingress-lb:https */ statistic mode random probability 0.50000000000

16 960 KUBE-SEP-QGNNICTBV4CXTTZM all -- * * 0.0.0.0/0 0.0.0.0/0 /* kube-system/nginx-ingress-lb:https */-A KUBE-SEP-ZVUNFBS77WHMPNFT -s 172.20.1.231/32 -m comment --comment "kube-system/nginx-ingress-lb:https" -j KUBE-MARK-MASQ

-A KUBE-SEP-ZVUNFBS77WHMPNFT -p tcp -m comment --comment "kube-system/nginx-ingress-lb:https" -m tcp -j DNAT --to-destination 172.20.1.231:443

-A KUBE-SEP-Y47C2UBHCAA5SP4C -s 172.20.2.191/32 -m comment --comment "kube-system/nginx-ingress-lb:https" -j KUBE-MARK-MASQ

-A KUBE-SEP-Y47C2UBHCAA5SP4C -p tcp -m comment --comment "kube-system/nginx-ingress-lb:https" -m tcp -j DNAT --to-destination 172.20.2.191:443

-A KUBE-SEP-QGNNICTBV4CXTTZM -s 172.20.2.3/32 -m comment --comment "kube-system/nginx-ingress-lb:https" -j KUBE-MARK-MASQ

-A KUBE-SEP-QGNNICTBV4CXTTZM -p tcp -m comment --comment "kube-system/nginx-ingress-lb:https" -m tcp -j DNAT --to-destination 172.20.2.3:443

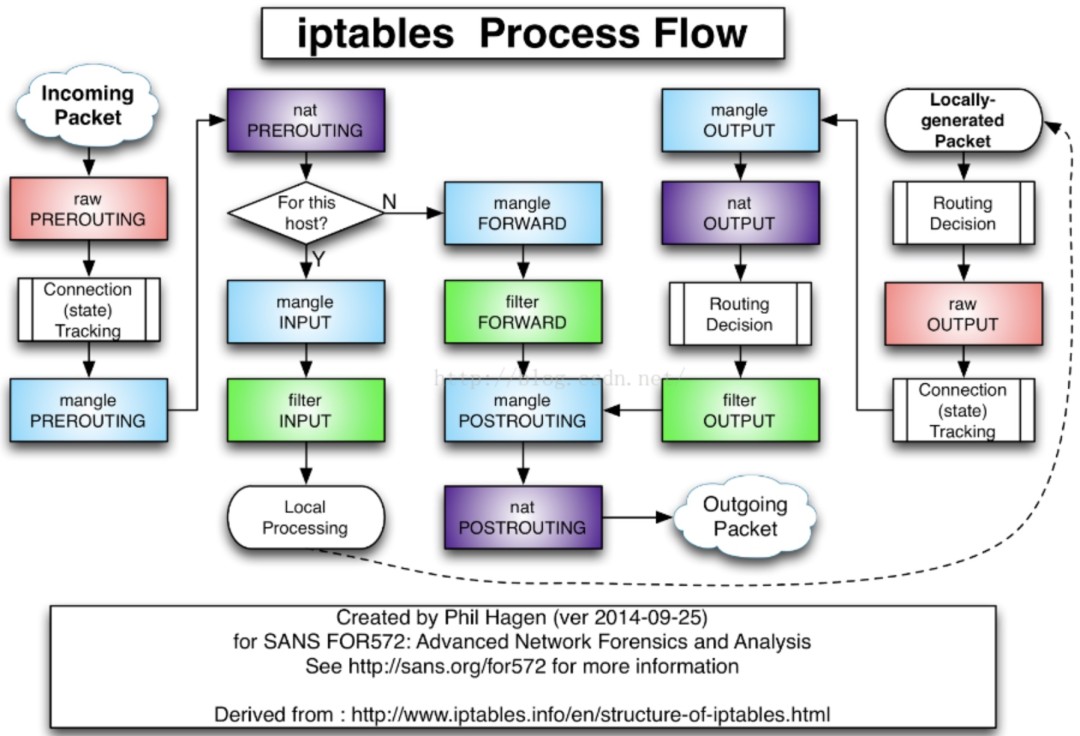

至此已经讲完了 kubernetes 的容器中 iptables 的基本访问方式,在分析一个应用的iptables 规则时,可以从 KUBE-SERVICE 入手,并结合该应用关联的服务(如 ingress LB 等)进行分析。

查看 iptables 表项最好结合 iptables-save 以及如 iptables -t nat -nvL 的方式,前者给出了 iptables 的具体内容,但比较杂乱;后者给出了 iptables 的结构,可以方便地看出表中的内容,但是没有详细信息,二者结合起来才能比较好地分析。链接状态可以查看 /proc/net/nf_conntrack

TIPS:

openshift 下使用如下配置创建 nodeport 类型的 service。"nodeport" 表示通过nodeport 方式访问的端口;"port" 表示通过 service 方式访问的口;"targetPort" 表示后端服务"app" 暴露的 pod 端口。通过 nodeport 访问集群的流程为: {dstNodeIP:dstNodePort}-->(iptables)DNAT-->{dstPodIP:dstPodPort}。 创建 nodeport 类型的 service 时会在每个 node 上开启一个端口号为 {nodePort}的监听 socket(单独使用 docker run -p 启动 nodeport 进程为 docker-proxy),其中一个作用方便给应用通过 loopback 地址访问容器服务,删除该进程后将无法通过 host 的 loopback 接口访问容器服务,更多参见 docker-proxy(http://dwz.date/cqfZ)。 同时也可以通过:{service:servicePort}-->(iptables)DNAT-->{dstPodIP:dstPodPort} 的方式在集群内部访问后端服务。apiVersion: v1

kind: Service

metadata:

annotations:

name: app-test

namespace: openshift-monitoring

spec:

externalTrafficPolicy: Cluster

ports:

- name: cluster

nodePort: 33333

port: 44444

protocol: TCP

targetPort: 55555

selector:

app: app

sessionAffinity: None

type: NodePort- END -

推荐阅读 从零认识 iptablesPython 调用 Kubernetes API 自动化管理资源

大型网站技术架构的演进之路

Ceph分布式存储日常运维管理

30个Python极简代码,10分钟get常用技巧!

部署一套完整的Kubernetes高可用集群(二进制)

10 分钟部署一个 Kubernetes 集群

从网管到架构师再到微创业,我这9年的成长感悟

点亮,服务器三年不宕机

737

737

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?