点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop(已更完)

- HDFS(已更完)

- MapReduce(已更完)

- Hive(已更完)

- Flume(已更完)

- Sqoop(已更完)

- Zookeeper(已更完)

- HBase(已更完)

- Redis (已更完)

- Kafka(正在更新…)

章节内容

上一节我们完成了如下的内容:

现实业务中我们会遇到:当Kafka集群中有一个节点宕机了,比如Broker0、Broker1中,Broker1宕机了,此时由于我们配置了副本数为2,Kafka集群正常工作,提供生产和消费能力。

但是当我们修好Broker1之后,恢复宕机之后,发现Leader都是Broker0,不会再平衡到Broker1上,所以我们需要用脚本来让Kafka集群进行自动再平衡。

- Kafka自动再平衡

- 新建主题

- 查看主题

- 模拟宕机

- 重启节点

- 编写JSON

- 测试运行

修改分区副本

现实业务中与实际项目中,我们可能由于主题的副本因子设置问题,需要重新设置副本因子。

由于集群的扩展,需要重新设置副本因子。

Topic一旦使用又不能轻易删除重建,因此动态增加副本因子就成为最终的选择。

背景情况

假设我们有两个KafkaBroker分别为:Broker0、Broker1

- 当我们创建Topic有2个分区,并且replication-factor为1,基本一个Broker一个分区。

- 当一个分区宕机了,该Topic就无法使用了,因为两个分区中只有一个可以使用

- 当我们创建的Topic有3个分区时,replication-factor为2时,可能分区数据分布情况是:[broker0,partition0,partition1,partition2] 和 [broker1,partition1,partition0,partition2]

- 每个分区有一个副本,当其中一个Broker宕机了,Kafka集群还能完整的凑出该Topic的两个分区,例如当Broker0宕机了,可以通过Broker1组合出Topic的两个分区。

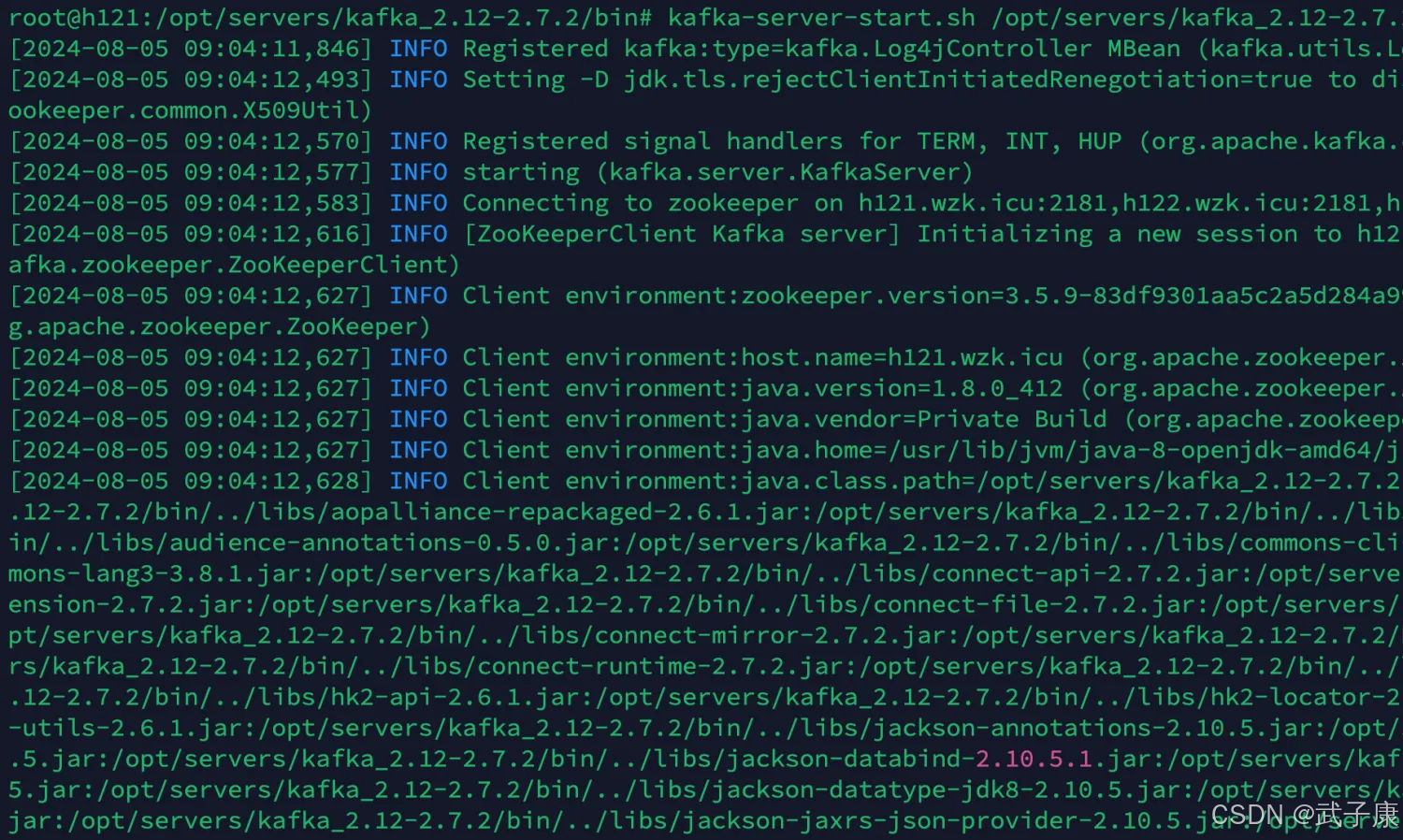

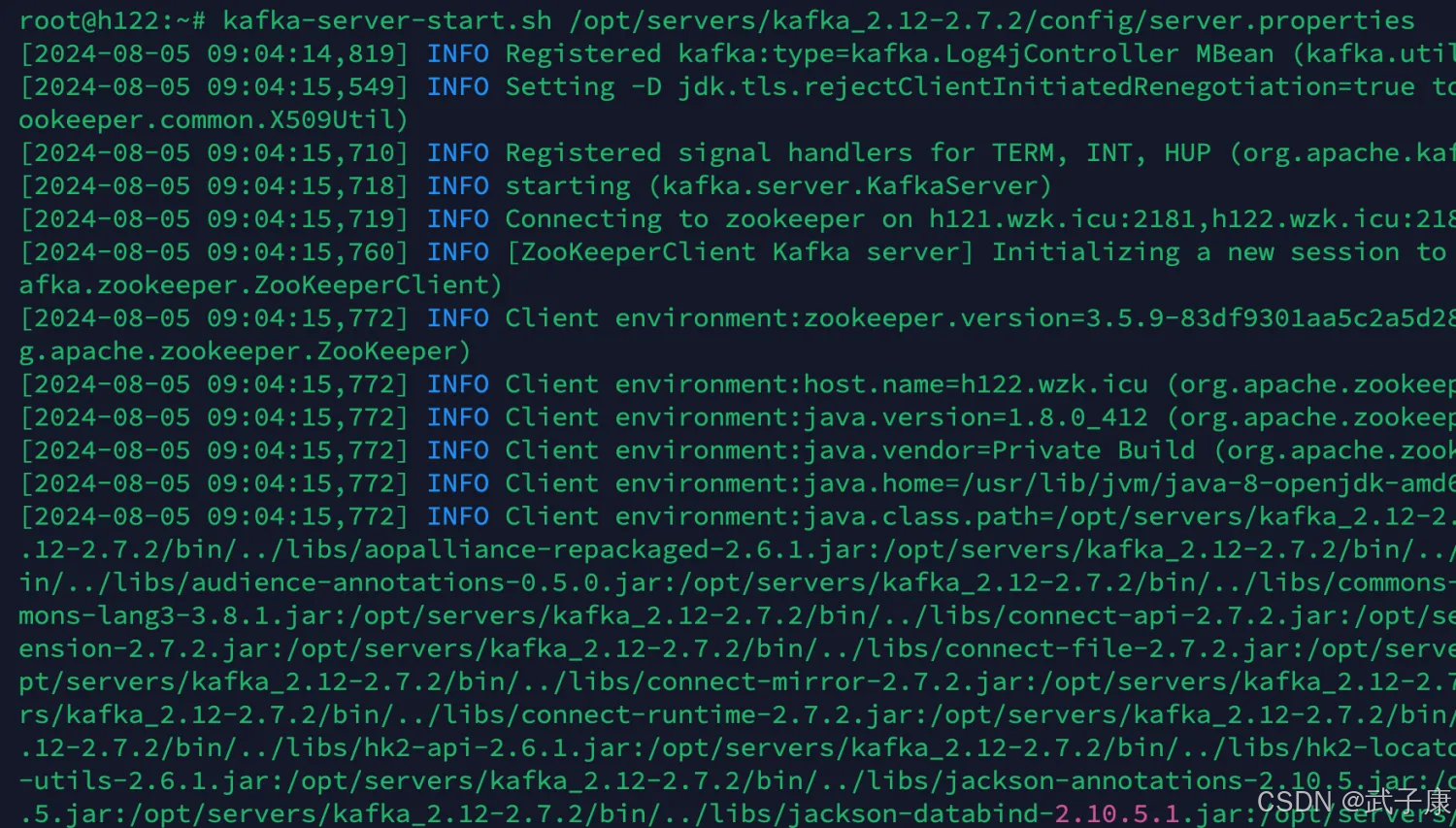

启动服务

确保你有两台节点是可以正常使用的:

我这里是h121和h122

h121

h122

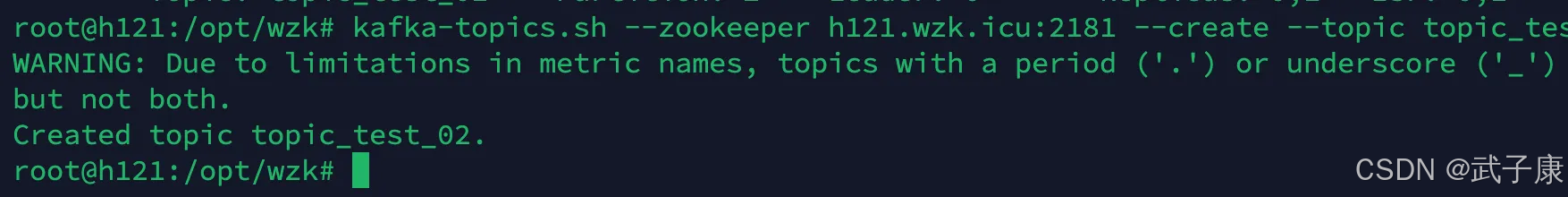

创建主题

运行结果如下图:

查看主题

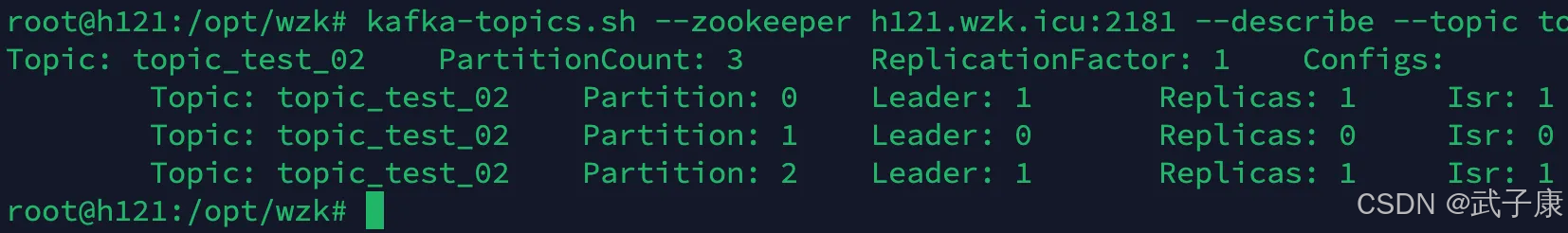

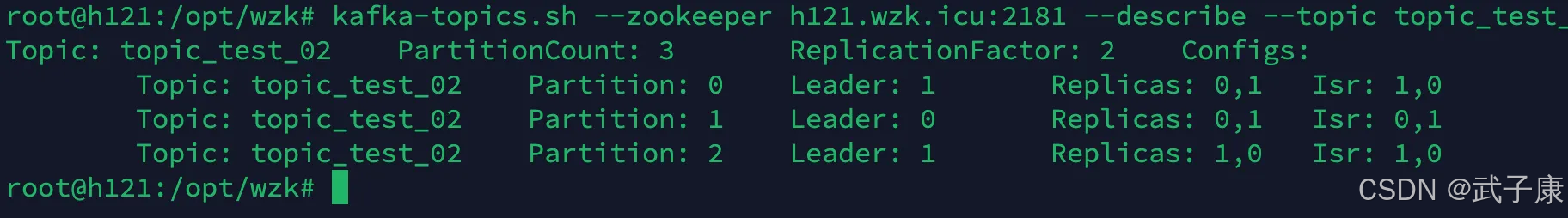

运行结果如下图:

可以看到跟我们的上一个实验的开头分配情况是一致的。

修改副本因子(不允许)

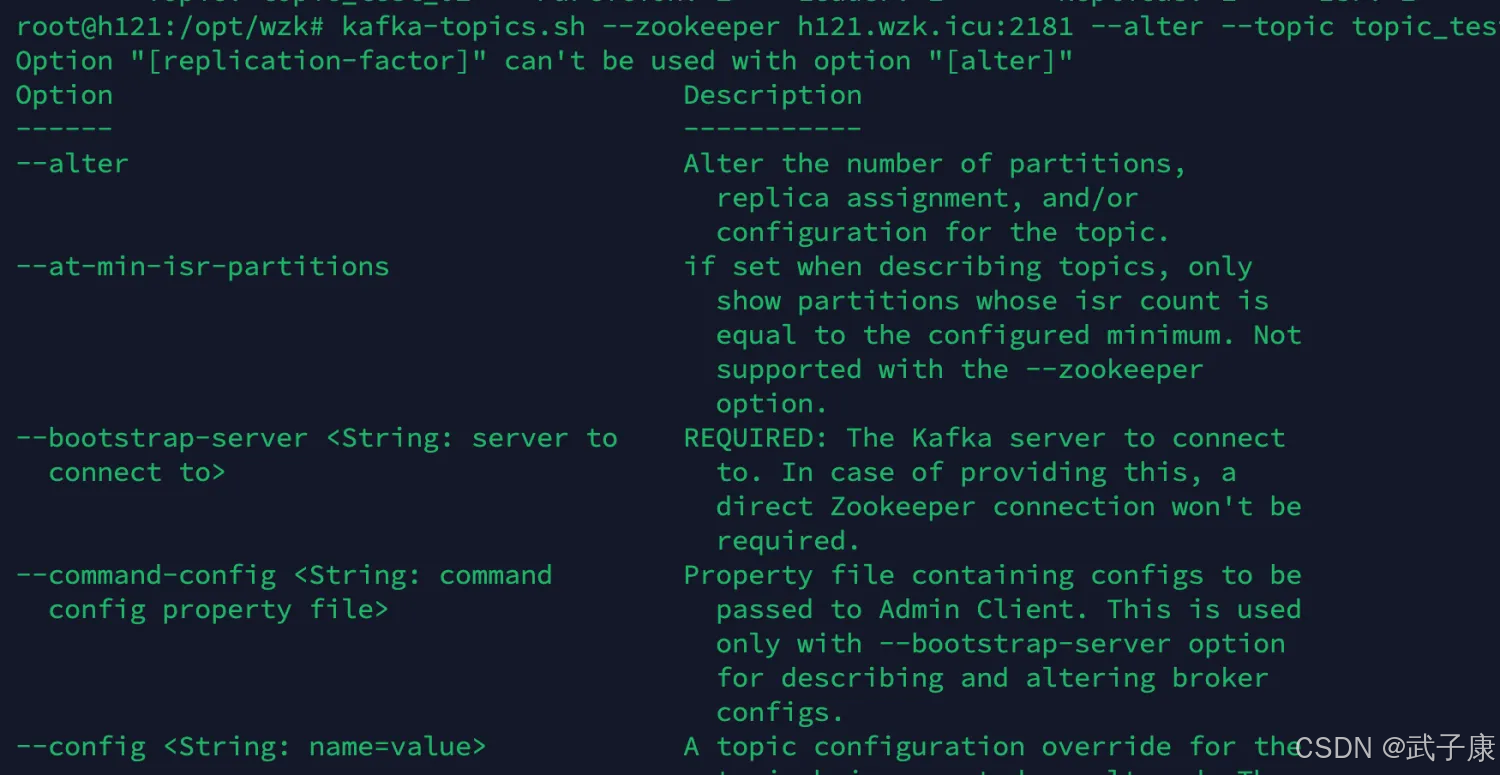

尝试修改

我们可以观察到,是不允许我们这样操作的:

那如果我们业务上要求我们修改副本因子,我们该怎么办呢?

下面提供一个可行的方案。

修改副本因子

编写JSON

所以我们需要借助 kafka-reassign-partitions.sh

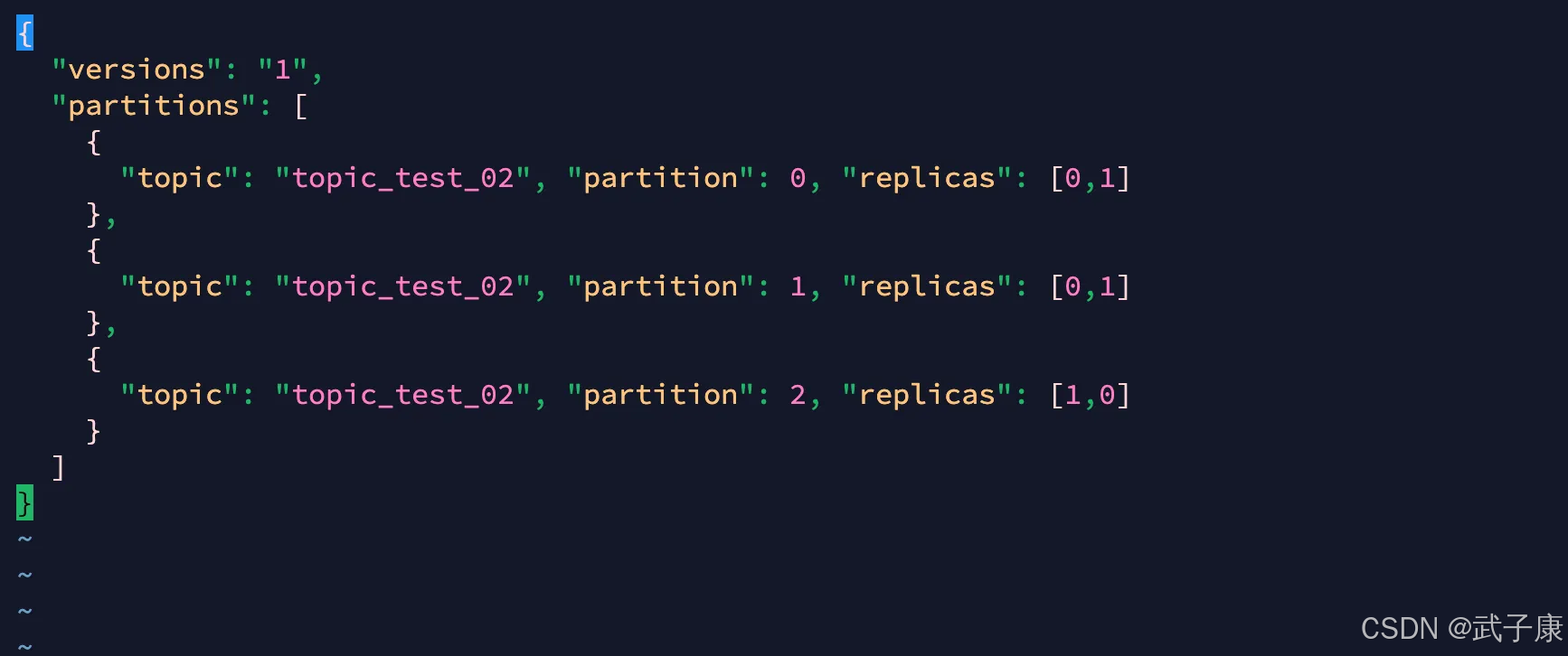

新建一个文件,这里的JSON在replicase里写入了多个:

我们写入的内容如下:

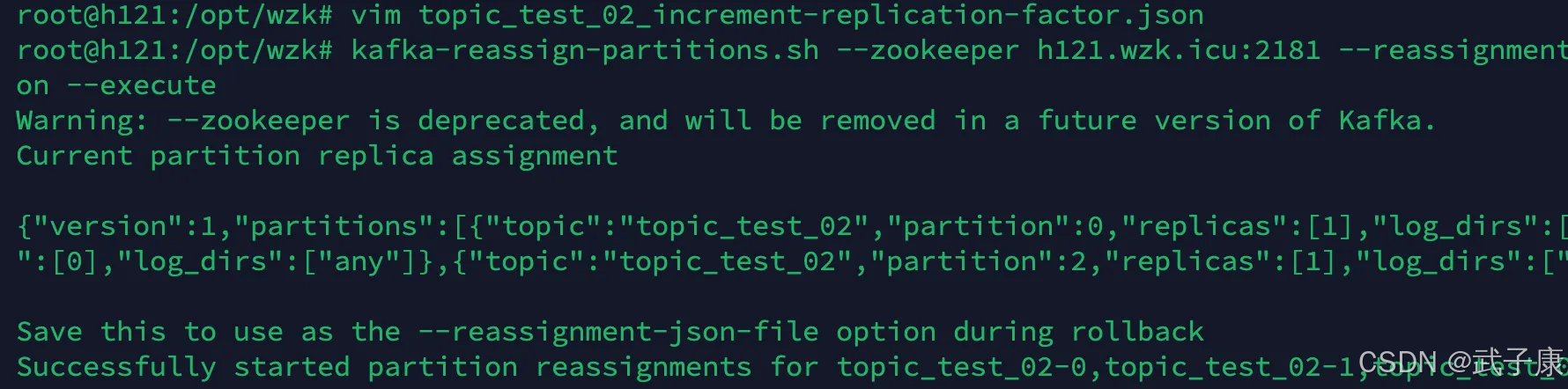

执行JSON

观察执行的结果如下:

查看结果

执行的结果如下图所示:

可以看到,我们的副本数已经是 01、01、10了,此时就算 h121 或者 h122 中有一台节点挂掉了,我们也可以继续进行消费!

3332

3332

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?