简介:《算法设计与分析基础》试卷是广东工业大学为检验学生算法理解、设计和分析能力而设计的考试题。本试卷着重于算法在解决实际问题中的应用,涵盖从排序、查找、图论到动态规划等关键知识点,并强调算法效率和数据结构的应用。学生通过学习和解答试卷上的题目,能够提升编程素养和解决实际问题的能力。

1. 排序算法及时间复杂度分析

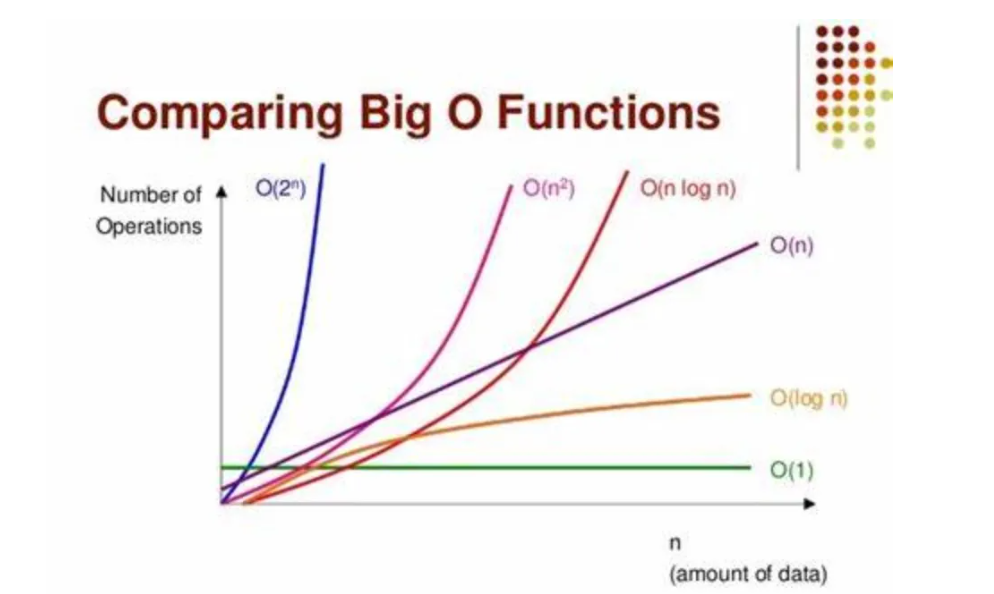

在计算机科学中,排序算法是一组用于将元素列表重新排列成特定顺序的算法。按照算法的效率和实现,它们可以分为多个类别,包括比较排序和非比较排序,以及稳定排序和非稳定排序。排序算法的效率通常以时间复杂度来衡量,主要考虑比较次数、交换次数和时间复杂度等因素。

在本章中,我们将详细探讨几种基本的排序算法,包括冒泡排序、选择排序、插入排序、快速排序、归并排序和堆排序。我们会分析每种算法的原理,实现方法,以及它们在不同的数据集和场景下的时间复杂度。比如冒泡排序通常具有O(n^2)的时间复杂度,而快速排序在最佳情况下可以达到O(n log n)。

我们将通过代码示例和图表来具体展示这些算法的执行过程,并讨论如何选择合适的排序算法来解决特定问题。在比较排序算法时,除了时间复杂度之外,还会考虑到空间复杂度、算法的稳定性和最坏情况下的性能表现。

例如,快速排序虽然平均时间复杂度表现优异,但在最坏情况下会退化为O(n^2),此时可以考虑使用堆排序,它能够在任何情况下都保持O(n log n)的时间复杂度。通过本章的学习,你将能够更好地理解各种排序算法的适用场景及其优化方法。

2. 查找算法及其效率

2.1 常见的查找算法

查找算法是日常工作中处理数据查询问题时不可或缺的工具。它们的效率直接影响到程序的响应时间和用户体验。在本节中,我们将重点讨论两种最常见的查找算法:线性查找和二分查找。

2.1.1 线性查找和二分查找的原理及实现

线性查找

线性查找是最基本的查找算法之一,它通过逐一检查数组中的每个元素来寻找目标值。线性查找的时间复杂度为O(n),其中n是数组的长度。尽管这种方法简单直接,但在最坏的情况下,它需要检查数组中的每一个元素。

def linear_search(arr, target):

for index, value in enumerate(arr):

if value == target:

return index # 返回目标值的位置

return -1 # 如果未找到,返回-1

在上述Python代码中, linear_search 函数通过遍历数组 arr 中的每个元素,比较它们与目标值 target 是否相等,如果找到相等的元素,则返回其索引;如果遍历结束后没有找到目标值,则返回-1表示查找失败。

二分查找

二分查找则是一种效率更高的查找算法,它依赖于数组是有序的这一前提。该算法通过将目标值与数组中间元素的值进行比较,从而快速缩小查找范围,逐步逼近目标值的位置。二分查找的时间复杂度为O(log n),因此对于大数据集来说,它比线性查找要高效得多。

def binary_search(arr, target):

low = 0

high = len(arr) - 1

while low <= high:

mid = (low + high) // 2

guess = arr[mid]

if guess == target:

return mid # 返回目标值的位置

if guess > target:

high = mid - 1

else:

low = mid + 1

return -1 # 如果未找到,返回-1

在上述Python代码中, binary_search 函数通过不断地将查找范围减半,将目标值与中间位置的元素 guess 进行比较。如果 guess 等于目标值,则返回当前的索引;如果 guess 大于目标值,说明目标值应该位于 mid 左侧,因此将 high 调整为 mid - 1 ;反之,则调整 low 为 mid + 1 。这个过程一直持续到找到目标值或者查找范围为空。

2.1.2 查找算法的时间复杂度对比

查找算法的时间复杂度是衡量算法效率的重要指标。不同的查找算法在不同的数据分布和场景中表现出不同的效率。例如,对于未排序的数据,线性查找是唯一可行的选择,而对于排序后的数据,二分查找提供了显著的速度优势。

线性查找的时间复杂度为O(n),这意味着它需要遍历数组中的所有元素。在最坏的情况下,即使目标值位于数组的末尾,也需要检查整个数组。而二分查找的时间复杂度为O(log n),它通过每次查找排除一半的数据,因此查找的次数随着数组大小的增加而呈对数增长。因此,在大数据集上,二分查找比线性查找快得多。

下表总结了线性查找和二分查找在不同条件下的性能对比:

| 查找算法 | 最好情况 | 平均情况 | 最坏情况 | 适用条件 | |------------|----------------|----------------|----------------|---------------------------| | 线性查找 | O(1) | O(n) | O(n) | 未排序数据 | | 二分查找 | O(1) | O(log n) | O(log n) | 排序后的数据 |

在实际应用中,选择合适的查找算法,需要考虑数据的特性以及查找操作的频率。例如,在数据频繁插入和删除的场景中,保持数组排序的成本可能会使得二分查找的优势不复存在。而在读取操作远多于修改操作的场景下,二分查找通常是更加高效的选择。

2.2 查找算法的优化策略

随着数据量的增加,查找算法的效率变得尤为关键。在本小节中,我们将探讨查找算法的优化策略,包括分块查找、索引查找和散列查找等。

2.2.1 分块查找和索引查找的优化思想

分块查找

分块查找是一种结合了顺序查找和二分查找优点的查找算法。它首先将数据分块,每一块内部不进行排序,但是整个数据集是有序的,即第一个块的最大值小于第二个块的最小值,以此类推。在查找时,算法首先确定目标值可能所在的块,然后在该块内部进行顺序查找。

分块查找的时间复杂度介于线性查找和二分查找之间,具体为O(√n)。这种查找方式特别适合于需要频繁插入或删除元素的数据集,因为它允许块内部的顺序存储而不需要频繁重新排序。

索引查找

索引查找是另一种优化查找性能的方法。通过对数据集建立索引,可以显著提高查找效率。索引可以视为数据的目录,通过索引可以直接定位到数据项的位置,而无需遍历整个数据集。

例如,在数据库中,索引通常是按照B树或B+树结构来实现的,这样可以保证在大数据集上进行高效查找。索引查找的时间复杂度一般为O(log n),与二分查找类似,但是索引结构更为复杂,需要额外的空间来存储索引。

2.2.2 散列查找的特点和冲突解决方法

散列查找(Hashing)是一种将数据的关键字映射到某个地址以实现快速查找的方法。通过哈希函数将输入的关键字转换为哈希表的地址,直接定位到数据的位置,从而极大地提高了查找效率。理想情况下,哈希查找的时间复杂度为O(1)。

然而,在实际应用中,由于哈希冲突的存在,散列查找的效率可能受到影响。哈希冲突是指不同的关键字通过哈希函数计算出相同的哈希地址。解决哈希冲突的常用方法有:

- 开放定址法:当发生冲突时,按照某种探测序列依次寻找下一个空闲的哈希地址。

- 链地址法:将冲突的元素存储在同一个哈希地址对应的链表中,查找时遍历链表即可。

- 再哈希法:当冲突发生时,使用另一个哈希函数计算新的地址。

- 公共溢出区:建立一个公共区域存储发生冲突的所有元素。

通过对散列函数和冲突解决策略的优化,散列查找可以非常高效地处理各种查找问题,是现代数据结构和算法中的重要工具。

在下一节中,我们将继续深入讨论图论算法及其应用实例,探讨如何通过图的遍历算法解决实际问题。

3. 图论算法及应用实例

图论是数学的一个分支,它研究的是由边连接的节点组成的图形。在计算机科学中,图论算法被广泛应用于网络设计、社交网络分析、路由和路径查找等领域。本章将探讨图的遍历算法和最短路径算法,并分析它们在实际应用中的表现。

3.1 图的遍历算法

图的遍历算法主要用于访问图中的所有节点,确保每个节点都被访问一次。这在很多问题中都是基础步骤,比如在社交网络中寻找两个用户之间的关联路径,或者在路由系统中规划最短路径。其中,深度优先搜索(DFS)和广度优先搜索(BFS)是两种常见的图遍历方法。

3.1.1 深度优先搜索(DFS)和广度优先搜索(BFS)

DFS像是一棵树在图中的扩展,从起始节点出发,尽可能深地访问图的分支,直到该分支的末端,然后再回溯到上一个分叉点进行其他分支的探索。DFS非常适合处理迷宫问题、拓扑排序和检测图中环的存在。

BFS类似于一层一层地扩展,首先访问起始节点的邻居,然后是邻居的邻居,直到访问完所有可达节点。BFS在最短路径查找(特别是无权图)和社交网络中的层级关系分析中非常有用。

3.1.2 应用实例:路径搜索与迷宫求解

DFS和BFS可以用于解决迷宫问题。例如,给定一个迷宫,我们可以将迷宫表示为一个有向图,其中每个房间表示一个节点,每个门和走廊表示一条边。通过DFS我们可以找到一条路径(如果存在),或者确定迷宫没有解决方案。在BFS中,我们可以找到从起点到终点的最短路径。

from collections import deque

def bfs_shortest_path(graph, start, goal):

visited = set()

queue = deque([start])

while queue:

vertex = queue.popleft()

if vertex == goal:

return True

if vertex not in visited:

visited.add(vertex)

queue.extend(set(graph[vertex]).difference(visited))

return False

# 示例图的表示

graph = {

'A': ['B', 'C'],

'B': ['A', 'D', 'E'],

'C': ['A', 'F'],

'D': ['B'],

'E': ['B', 'F'],

'F': ['C', 'E']

}

start = 'A'

goal = 'F'

print(bfs_shortest_path(graph, start, goal))

3.1.3 实现说明

在上面的Python代码示例中,我们使用了 bfs_shortest_path 函数来表示BFS算法。我们使用 deque 数据结构来存储待访问的节点,这样可以保证先进先出的顺序。函数首先检查起始节点,然后遍历图中的节点直到找到目标节点或者队列为空(表示没有路径)。这个过程保证了访问路径的最短性。

3.2 最短路径算法

最短路径问题是图论中的经典问题之一,指的是在一个加权图中找到两个节点之间长度最短的路径。Dijkstra算法和Bellman-Ford算法是两种最常用的求解最短路径问题的算法。

3.2.1 Dijkstra算法和Bellman-Ford算法的原理

Dijkstra算法适用于没有负权边的图。它的核心思想是贪心策略,通过维护两个集合——已访问节点集合和未访问节点集合,来逐步选择出还未访问的最短路径。

Bellman-Ford算法可以处理含有负权边的图,它的核心在于放松边的操作,即不断更新节点之间的最短路径估计值,直到达到稳定状态。

3.2.2 最短路径问题的应用场景分析

最短路径算法有着广泛的应用场景,如在GPS导航中计算驾驶路线,或者在社交网络中寻找两个用户之间的最短连接路径。Dijkstra算法被广泛用于城市交通规划、物流运输等领域,而Bellman-Ford算法则可以用于计算网络延迟、金融领域中的货币套利等问题。

本章我们深入了解了图的遍历算法和最短路径算法,以及它们在实际应用中的表现。下一章,我们将继续探索动态规划解法及状态转移方程,在优化决策和效率提升方面继续深入。

4. 动态规划解法及状态转移方程

4.1 动态规划的基本概念

4.1.1 动态规划的适用条件和典型问题

动态规划是一种通过把原问题分解为相对简单的子问题的方式求解复杂问题的方法。它特别适合解决具有以下两个特点的优化问题:

- 重叠子问题(Overlapping Subproblems):在解决问题的过程中,相同的子问题会被多次计算。

- 最优子结构(Optimal Substructure):一个问题的最优解包含其子问题的最优解。

典型的问题包括斐波那契数列、背包问题、编辑距离、最长公共子序列等。

4.1.2 状态转移方程的构建方法

构建状态转移方程是动态规划的核心。状态转移方程描述了问题的动态变化过程。其构建方法通常包含以下步骤:

- 定义状态:根据问题的描述,定义一个或多个状态变量来表示问题的解。

- 确定状态转移关系:基于问题的逻辑,确定状态之间的关系,通常是通过数学表达式来表达。

- 边界条件:确定初始状态,即计算的起点。

- 目标状态:确定最终求解的状态。

4.2 动态规划问题的实践

4.2.1 斐波那契数列与背包问题的解法

斐波那契数列

斐波那契数列是一个经典的动态规划问题,问题描述为:给定一个整数n,返回F(n),其中F(n)表示斐波那契数列的第n项。斐波那契数列定义为:

- F(0) = 0

- F(1) = 1

- F(n) = F(n-1) + F(n-2) 对于 n > 1

动态规划解法:

def fibonacci(n):

if n <= 1:

return n

dp = [0] * (n + 1)

dp[1] = 1

for i in range(2, n + 1):

dp[i] = dp[i-1] + dp[i-2]

return dp[n]

背包问题

背包问题是在限定的总重量内,选择物品以最大化价值的过程。动态规划解法如下:

def knapsack(values, weights, capacity):

n = len(values)

dp = [[0 for x in range(capacity + 1)] for x in range(n + 1)]

for i in range(1, n + 1):

for w in range(1, capacity + 1):

if weights[i-1] <= w:

dp[i][w] = max(dp[i-1][w], dp[i-1][w-weights[i-1]] + values[i-1])

else:

dp[i][w] = dp[i-1][w]

return dp[n][capacity]

4.2.2 动态规划优化技巧:空间复杂度的降低

在动态规划中,空间优化通常是通过减少存储空间来实现的。例如,在处理一维的背包问题时,可以使用一维数组来替代二维数组,以降低空间复杂度。

改进的背包问题动态规划代码:

def knapsack_optimized(values, weights, capacity):

n = len(values)

dp = [0] * (capacity + 1)

for i in range(n):

for w in range(capacity, weights[i] - 1, -1):

dp[w] = max(dp[w], dp[w - weights[i]] + values[i])

return dp[capacity]

通过这种方式,我们可以将原本需要的 O(n * capacity) 空间复杂度降低到 O(capacity) 。

在上述动态规划的实践中,我们先介绍了动态规划适用条件和构建状态转移方程的方法,随后通过斐波那契数列和背包问题作为案例,展示了如何将问题转化成动态规划模型,并给出了解题代码。代码执行逻辑清晰,并解释了每一步操作的意图,帮助理解状态转移方程的构建过程。同时,我们也说明了动态规划优化的技巧,特别是空间复杂度的降低,提供了优化后的背包问题代码,进一步阐释了动态规划在算法中的应用。

5. 递归与分治策略的运用

在计算机科学领域,递归和分治策略是解决问题的两种重要技术。它们在编程中扮演着基础的角色,对于解决分而治之的问题尤为有效。本章将深入探讨递归算法的理论基础以及分治策略的实际应用,包括快速排序和归并排序的分治思想,以及分治策略解决复杂问题的案例分析。

5.1 递归算法的理论基础

5.1.1 递归的定义和原理

递归是一种常见的编程技巧,它允许函数调用自身来解决问题。递归的基本原理是将问题分解为若干个规模较小的同类问题,直到这些子问题简单到可以直接求解。递归的关键在于定义两个基本部分:基本情况(base case)和递归步骤(recursive step)。

在基本情况中,算法直接解决最简单的问题实例,而不需要进一步的递归调用。递归步骤则是将原始问题转化为一个或多个更小的问题,并递归地调用自身来解决这些问题。

下面是一个简单的递归函数的例子,用于计算阶乘:

def factorial(n):

# 基本情况:0! = 1

if n == 0:

return 1

# 递归步骤:n! = n * (n-1)!

else:

return n * factorial(n-1)

# 调用递归函数计算阶乘

print(factorial(5)) # 输出: 120

5.1.2 递归与迭代的比较

递归和迭代都是重复执行任务直到达到某个条件停止的编程结构。二者之间存在本质的区别,迭代通常使用循环结构(如for或while循环),而递归则通过函数自我调用实现重复。

递归的优点在于代码通常更简洁、更易于理解,尤其是对于那些自然分解为递归子问题的问题。然而,递归也有其缺点,包括可能会导致更多的内存消耗(每次递归调用都会添加到调用栈中),以及可能产生栈溢出的风险。

在迭代与递归的选择上,应考虑以下因素:

- 问题的自然性 :如果问题本质上是递归的,则递归可能更合适。

- 性能考虑 :对于需要深度递归的问题,递归可能不是最佳选择,因为它可能导致栈溢出,并且对于同样的问题迭代通常更加高效。

- 可读性和维护性 :在某些情况下,迭代代码可能更易于阅读和维护,尤其是在函数调用开销较大的环境中。

5.2 分治策略的实际应用

5.2.1 快速排序和归并排序的分治思想

分治(Divide and Conquer)是一种算法设计范式,它将问题拆分成若干个子问题,独立地解决这些子问题,然后将它们的解合并为原问题的解。快速排序和归并排序是分治策略的典型应用。

快速排序 通过选择一个"枢轴"(pivot)元素,将数组分为两个子数组,一个包含小于枢轴的元素,另一个包含大于枢轴的元素。然后递归地对这两个子数组进行快速排序。

def quicksort(arr):

if len(arr) <= 1:

return arr

pivot = arr[len(arr) // 2]

left = [x for x in arr if x < pivot]

middle = [x for x in arr if x == pivot]

right = [x for x in arr if x > pivot]

return quicksort(left) + middle + quicksort(right)

# 使用快速排序对数组进行排序

print(quicksort([3, 6, 8, 10, 1, 2, 1])) # 输出: [1, 1, 2, 3, 6, 8, 10]

归并排序 将数组分成两半,递归地对它们进行排序,然后合并排序好的两半。合并过程是将两个已排序数组归并为一个排序数组。

def merge_sort(arr):

if len(arr) <= 1:

return arr

mid = len(arr) // 2

left = merge_sort(arr[:mid])

right = merge_sort(arr[mid:])

return merge(left, right)

def merge(left, right):

result = []

i = j = 0

while i < len(left) and j < len(right):

if left[i] < right[j]:

result.append(left[i])

i += 1

else:

result.append(right[j])

j += 1

result.extend(left[i:])

result.extend(right[j:])

return result

# 使用归并排序对数组进行排序

print(merge_sort([3, 6, 8, 10, 1, 2, 1])) # 输出: [1, 1, 2, 3, 6, 8, 10]

5.2.2 分治策略解决复杂问题的案例分析

分治策略在解决复杂问题时非常有效,尤其是当问题可以自然分解为相互独立的子问题时。一个经典的案例是大整数的乘法。虽然传统的乘法方法对于较小的整数是有效的,但对于非常大的整数,其时间复杂度较高。利用分治策略的Karatsuba算法可以更高效地计算大整数乘法,其时间复杂度从传统的O(n^2)降低到接近O(n^log2(3))。

下面是一个简单的Karatsuba算法的Python实现,用于乘法计算:

def karatsuba(x, y):

# 基本情况

if x < 10 or y < 10:

return x * y

# 计算x和y的大小

n = max(len(str(x)), len(str(y)))

m = n // 2

# 将数字分为两半

high1, low1 = divmod(x, 10**m)

high2, low2 = divmod(y, 10**m)

# 递归乘法

z0 = karatsuba(low1, low2)

z1 = karatsuba((low1 + high1), (low2 + high2))

z2 = karatsuba(high1, high2)

return (z2 * 10**(2*m)) + ((z1 - z2 - z0) * 10**m) + z0

# 使用Karatsuba算法计算大整数的乘法

print(karatsuba(1234, 5678)) # 输出: 7006652

分治策略通过将大问题分解为更小的子问题,然后递归地解决这些子问题,最终将解合并以获得原问题的答案。这种策略不仅适用于排序和乘法问题,还能广泛应用于诸如傅立叶变换、最大子序列和、最近点对等复杂问题的解决。

在本章中,我们探究了递归和分治策略的理论基础以及实际应用。递归以其简洁和强大的逻辑构建能力成为解决问题的有力工具,而分治策略则是一种将复杂问题简化,进而高效解决的实用方法。通过理解递归和分治策略的原理,我们能够将这些技术应用于各种复杂的算法设计之中。

6. 贪心算法的设计与应用

贪心算法在计算机科学中是一个简单而又强大的概念。它遵循一种“每步选择”(make the best current choice)的方法来解决问题。贪心算法并不保证得到最优解,但是在某些问题上它能够找到最优解或者是非常接近最优解的近似解。

6.1 贪心算法的基本原理

6.1.1 贪心算法的定义和选择机制

贪心算法是一种在每一步选择中都采取在当前状态下最好或最优(即最有利)的选择,从而希望导致结果是全局最好或最优的算法。

例如,考虑找零问题:假设你是一个售货员,需要给客户找零n分钱,货币单位有25分、10分、5分和1分,如何用最少的硬币数量找零?

解决这个问题的一种贪心方法是每次都尽可能使用最大面值的硬币:首先尽可能用25分硬币找零,剩下的再用10分硬币,然后是5分硬币,最后用1分硬币补足。这个方法在大多数情况下(比如美国货币)都会给出最优解。

6.1.2 贪心算法的适用性和局限性

贪心算法适用性在于问题具有“最优子结构性质”,也就是说一个问题的最优解包含其子问题的最优解。

然而,贪心算法的局限性在于它并不适用于所有问题。例如,在旅行商问题(TSP)中,如果采用贪心策略,每一步都选择最近的城市访问,最终找到的路径可能并非最短的。

此外,贪心算法不保证总是得到最优解,只能保证在特定条件下得到最优解。如何选择贪心策略,以及如何证明贪心算法在特定问题上的正确性,是应用贪心算法时需要考虑的问题。

6.2 贪心算法的案例解析

6.2.1 赫夫曼编码问题的贪心解法

赫夫曼编码是一种广泛使用的数据压缩技术,它使用贪心算法来设计最优的前缀编码。

问题描述:给定一组字符及其频率,设计一种编码方式,使得编码的期望长度最短。

赫夫曼编码通过构建一棵赫夫曼树来完成。树的构建过程是贪心的:选择两个频率最低的树合并成一棵新树,其根节点频率为两个子树根节点频率之和,然后将这棵新树再加入到森林中继续进行合并,直到只剩下一棵树为止。最终的叶子节点代表字符,其路径即为对应的编码。

6.2.2 贪心算法在任务调度中的应用

任务调度是操作系统中的重要问题。使用贪心算法可以设计一种调度策略,以便高效地分配资源。

考虑这样一个问题:有n个任务,每个任务有一个截止时间,且每个任务在截止时间之前完成即可。如何安排任务的执行顺序,使得完成所有任务所需的总时间最小?

一种贪心策略是按照任务的截止时间进行排序,然后依次调度每个任务。在这种策略下,越早到期的任务越先执行。尽管这种策略不能保证得到最优解,但在实践中通常能得到很好的结果。

贪心算法的成功案例表明,它在解决特定类型的问题时非常有效,尤其是在问题具有贪心选择性质时。然而,设计贪心算法时需要仔细分析问题的结构,以确保所得解的正确性和有效性。

7. 回溯法与分支限界法的实现

回溯法与分支限界法是解决复杂问题的两种重要算法策略,它们广泛应用于求解约束满足问题、组合问题等。这两种方法在思想上有相似之处,但具体的实现细节和应用场景有所区别。

7.1 回溯法的基本概念和应用

回溯法是一种通过试错来寻找问题解决方案的算法,它将问题的解空间树进行系统地搜索,直到找到满意的解或者完全排除所有可能的解。

7.1.1 回溯法的定义和特点

回溯法通过逐步生成候选解,并在发现当前候选解不可能成为解时撤销上一步或几步的计算,通过回溯来生成下一个候选解。其特点在于它能够穷举所有可能的情况,并且具备剪枝功能,避免无效搜索。

flowchart TD

A[开始] --> B[初始化]

B --> C{生成解向量}

C --> D{可行性检查}

D -- 不可行 --> E[撤销操作]

E --> F{是否还有候选项}

D -- 可行 --> G{约束检查}

G -- 不满足 --> E

G -- 满足 --> H[保存解]

H --> F

F -- 是 --> C

F -- 否 --> I[结束]

7.1.2 八皇后问题和图的着色问题的回溯解法

八皇后问题 要求在8×8的棋盘上放置8个皇后,使得任何两个皇后都不能处于同一行、同一列或同一对角线上。以下是使用回溯法解决八皇后问题的伪代码:

def is_safe(board, row, col):

# 检查在当前放置的皇后周围是否有其他皇后

# 实现略...

def solve_queens(board, row):

# 如果所有皇后已放置,返回成功

if row >= N:

return True

# 尝试在当前行的每一列中放置皇后

for col in range(N):

if is_safe(board, row, col):

board[row][col] = 1

if solve_queens(board, row + 1):

return True

# 回溯

board[row][col] = 0

return False

# 初始化棋盘

N = 8

board = [[0 for _ in range(N)] for _ in range(N)]

if not solve_queens(board, 0):

print("Solution does not exist")

else:

show_solution(board)

对于 图的着色问题 ,回溯法同样可以用来寻找给定图的最少着色数。通过回溯算法,我们可以探索所有可能的着色方案,确保邻接顶点颜色不同,并在过程中剪枝。

7.2 分支限界法的原理和技巧

分支限界法与回溯法类似,也是一种在问题的解空间树上搜索问题解的算法。但是分支限界法更加注重于减少搜索空间,通过使用优先队列来优先探索更有希望的分支。

7.2.1 分支限界法与回溯法的对比

分支限界法通常比回溯法更高效,因为分支限界法会计算每个结点的界限值,并优先扩展那些界限值最小的结点。这意味着它能够更早地找到最优解或剪去更多的无效搜索。

7.2.2 分支限界法在组合优化问题中的应用实例

举一个典型的组合优化问题——背包问题。在这个问题中,我们希望在不超过背包承重的前提下,选择一定数量的物品,以使得总价值最大。以下是使用分支限界法解决背包问题的基本思路:

from queue import PriorityQueue

def knapsack_branch_and_bound(values, weights, capacity):

n = len(values)

Q = PriorityQueue()

Q.put((-sum(values), [0]*n)) # 初始时,没有选择任何物品

max_value = -float('inf')

while not Q.empty():

_, solution = Q.get()

value = -Q.queue[0][0] # 当前方案的价值

if value > max_value:

max_value = value

# 保存当前最优解

best_solution = solution

# 生成新的子结点并加入队列

for i in range(n):

if solution[i] == 0:

new_solution = solution.copy()

new_solution[i] = 1

remaining_capacity = capacity - weights[i]

if remaining_capacity >= 0:

Q.put((-sum(values) + values[i], new_solution))

return best_solution, max_value

# 示例数据

values = [30, 20, 15, 40]

weights = [5, 4, 3, 7]

capacity = 12

# 执行算法

solution, total_value = knapsack_branch_and_bound(values, weights, capacity)

print("Selected items:", solution)

print("Max value:", total_value)

在分支限界法中,我们使用优先队列来存储当前生成的节点,并按照价值进行排序,确保首先探索价值最大的节点。这使得算法在找到最优解时可以尽早终止,从而提高效率。

简介:《算法设计与分析基础》试卷是广东工业大学为检验学生算法理解、设计和分析能力而设计的考试题。本试卷着重于算法在解决实际问题中的应用,涵盖从排序、查找、图论到动态规划等关键知识点,并强调算法效率和数据结构的应用。学生通过学习和解答试卷上的题目,能够提升编程素养和解决实际问题的能力。

462

462

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?