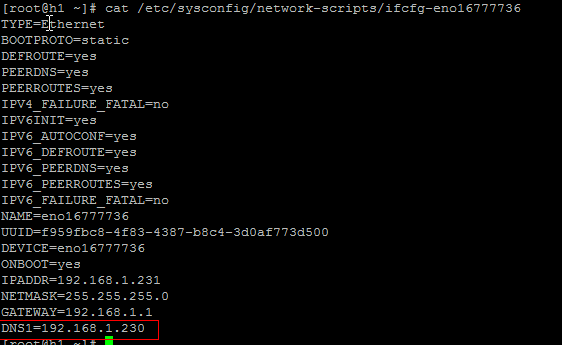

1. 配置IP

vi /etc/sysconfig/network-scripts/ifcfg-eno16777736

systemctl restart network.service

ip -4 addr

ping 192.168.1.1

vi /etc/hostname

ddd the following line:

dns.hadoop.com

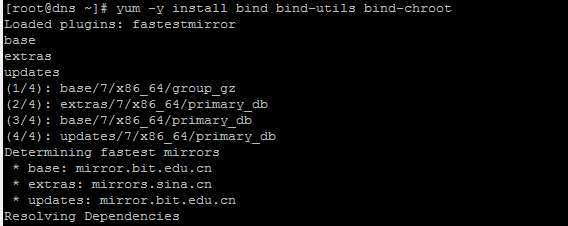

安装DNS软件包

yum -y install bind bind-utils bind-chroot

rpm -qa | grep '^bind'

修改/etc/named.conf

listen-on port 53 { any; }; #将原来的127.0.0.1改为any

allow-query { any; }; #将原来的localhost改为any

修改named.rfc1912.zones

添加入下内容:(也可以直接写在/etc/named.conf中)

zone "hadoop.com" IN {

type master;

file "named.hadoop.com";

allow-update { none; };

};

zone '1.168.192.in-addr.arpa" IN {

type master;

file "named.192.168.1.zone";

allow-update { none; };

};

配置正向解析文件

cp named.localhost named.hadoop.com

然后向文件named.hadoop.com添加如下内容

$TTL 1D

@ IN SOA dns.hadoop.com. grid.dns.hadoop.com. (

0 ; serial

1D ; refresh

1H ; retry

1W ; expire

3H ) ; minimum

NS dns.hadoop.com.

dns.hadoop.com. IN A 192.168.1.230

h1.hadoop.com. IN A 192.168.1.231

h2.hadoop.com. IN A 192.168.1.232

h3.hadoop.com. IN A 192.168.1.233

h4.hadoop.com. IN A 192.168.1.234

h5.hadoop.com. IN A 192.168.1.235

h6.hadoop.com. IN A 192.168.1.236

h7.hadoop.com. IN A 192.168.1.237

h8.hadoop.com. IN A 192.168.1.238

配置反向解析文件

cp named.localhost named.192.168.1.zone

并添加如下内容:

$TTL 1D

@ IN SOA dns.hadoop.com. grid.dns.hadoop.com (

0 ; serial

1D ; refresh

1H ; retry

1W ; expire

3H ) ; minimum

NS dns.hadoop.com.

231 IN PTR h1.hadoop.com.

232 IN PTR h2.hadoop.com.

233 IN PTR h3.hadoop.com.

234 IN PTR h4.hadoop.com.

235 IN PTR h5.hadoop.com.

236 IN PTR h6.hadoop.com.

237 IN PTR h7.hadoop.com.

238 IN PTR h8.hadoop.com.

查看日志

tail -30 /var/log/messages | grep named

添加DNS解析服务器IP

(其各节点的机器的IP配置文件中加入DNS1=192.168.1.230)

启动DNS

#启动DNS

systemctl start named.service

#设置自启动

systemctl start named.service

#查看DNS状态

systemctl status named.service

验证测试:

1129

1129

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?