最近几天在做spark数据同步过程中,中间通过kafka集群处理消息,每次同步到一半就会出现同步不了

查看日志如下:

最开始看到这个问题很懵逼,完全找不到解决问题的切入口,期间也询问了架构师-因为这个kafka和spark都是他引进来的,同时也问了运维同事,有没有碰到这个问题,最后都是无法解决这个问题

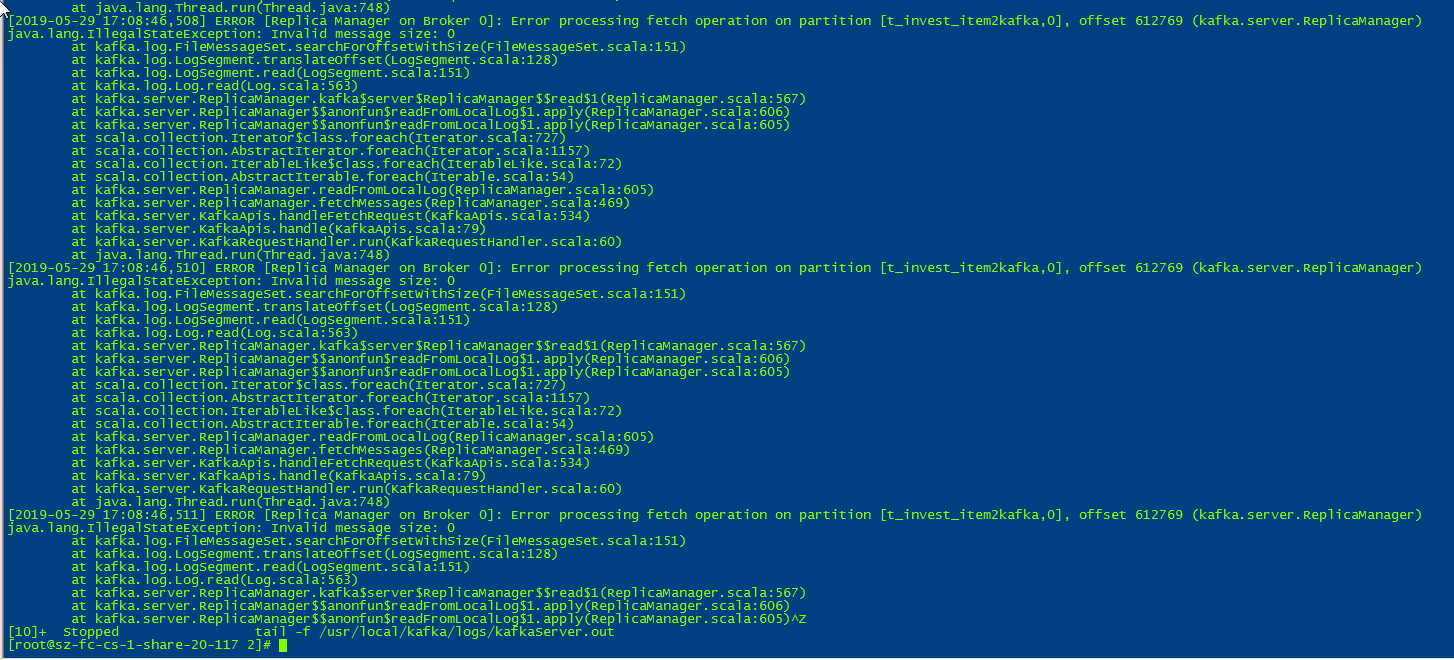

查看对应存在问题的kafka节点的日志:

一次突发奇想,是不是可以看一下kafka集群的日志,发现此时kafka集群也报错了,其实有时候看到错误还是很开心的,毕竟有错误才知道哪里存在问题

但是看到上面两个错误,给出的共同结果是kafka集群找不到topic的分区节点,但是这个环境貌似都是脚本话的安装,不存在什么问题啊,也检查了相关的配置,而且每次跑同步任务都是前面十几分钟都没啥问题,跑了十几分钟后才会出现上述问题

同时也检查了zk集群上的数据配置,也没啥问题,其实出现了这个问题,主要还是kafka集群和zookeeper存在问题,因为这个问题已经折腾了大量的时间,主要这个问题在线上和在3套功能测试环境都是没有问题,唯独在性能测试环境存在问题

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

654

654

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?