简介:日志文件在IT行业中扮演着记录系统和应用运行事件的关键角色。本文档“log日志数据文件(测试用-test)”特指用于测试目的的日志文件,包含了操作记录和错误信息,用于分析和调试。在软件测试中,日志文件记录了测试步骤、异常情况和错误报告等信息,对于理解测试过程和优化测试策略至关重要。本文将详细介绍如何使用日志文件进行错误排查、性能监控、安全审计、运维管理和测试反馈,同时强调了解析日志文件的重要性和使用日志分析工具的必要性。

1. 日志文件的重要性与分析

在当今复杂的IT环境中,日志文件作为系统活动和状态信息的记录,对于问题诊断、性能优化和安全审计至关重要。它们提供了一个历史视角,帮助开发者和运维人员理解过去发生了什么,从而作出基于事实的决策。

1.1 日志文件的角色和功能

日志文件的角色远不止于记录错误。它们详细记录了应用程序的正常操作流程,帮助分析师监测应用程序的运行状态,分析用户行为,以及评估系统性能。

1.2 日志分析的多层次价值

深入分析日志文件可以揭示系统中的关键性能指标(KPIs),帮助定位潜在的瓶颈和故障点。此外,它们在法律遵从性审核和安全事件的调查中也扮演着重要角色。

- **性能监控**:通过解析日志文件,可以监控关键性能指标,识别性能瓶颈。

- **故障诊断**:日志文件能够帮助快速定位系统故障和应用错误。

- **安全审计**:日志记录了安全事件的详细信息,为安全审计提供了重要证据。

在接下来的章节中,我们将探讨日志文件的结构、测试用日志文件的分析与调试、错误排查和性能监控,以及安全审计和日志聚合等内容。

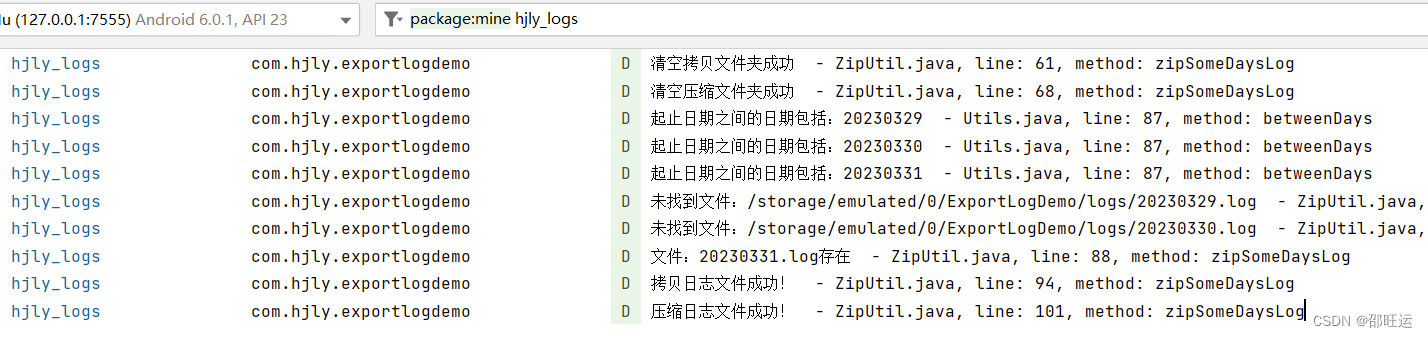

2. 测试用日志文件的分析与调试

在软件开发的过程中,测试阶段是一个至关重要的环节。有效的分析和调试测试用的日志文件对于提高软件质量和性能来说至关重要。本章将深入探讨测试用日志文件的结构解析、调试策略、常见错误信息的识别和定位、以及日志文件的过滤和搜索技巧。

2.1 日志文件的结构解析

2.1.1 日志格式的识别与理解

日志文件可以采用不同的格式,例如JSON、XML、CSV或者是自定义的文本格式。每种格式都有其特定的结构和字段定义。理解日志格式的结构对于后续的日志分析至关重要。

以JSON格式为例,日志文件通常包含如下字段:

-

timestamp: 记录事件发生的时间戳。 -

level: 记录日志级别,如INFO、WARN、ERROR等。 -

message: 记录具体的日志信息。 -

context: 其他上下文信息,如请求的ID、来源等。

例如:

{

"timestamp": "2023-04-01T10:52:52.852Z",

"level": "INFO",

"message": "User login successful",

"context": {

"userId": "12345",

"ipAddress": "***.***.*.***"

}

}

为了处理这些结构化数据,我们可以使用一些专门的工具或脚本语言进行解析。比如,我们可以使用Python的 json 库来解析JSON格式的日志文件。

import json

with open('log.json', 'r') as ***

***

***

***['message'])

2.1.2 时间戳和日志级别的识别

时间戳和日志级别是日志分析的关键部分。时间戳帮助开发者了解日志事件发生的具体时间,这对于定位问题和理解事件顺序非常有用。日志级别则提供了事件紧急程度和重要性的直接信息。

解析这些字段通常需要根据日志的格式来编写相应的解析规则。例如,如果日志是纯文本格式,并使用特定的字符串来表示日志级别,则可以通过正则表达式来提取这些信息。

import re

import datetime

log_pattern = r'(\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}.\d{3}Z) (INFO|WARN|ERROR) (.+)'

for line in log_***

***

***

***

*** {

'timestamp': datetime.datetime.fromisoformat(timestamp),

'level': level,

'message': message

}

# Handle log_entry...

2.2 测试用日志文件的调试策略

2.2.1 常见错误信息的识别和定位

识别和定位错误是日志调试过程中的关键一步。开发者可以通过搜索特定的错误代码或者错误模式来快速定位问题所在。

以下是一个简单搜索特定错误代码的Python脚本示例:

def find_error_codes(log_file, error_code):

error_count = 0

for line in log_***

***

***

***

***

***'log.txt', 'r') as ***

*** 'ERROR_CODE_1234')

if errors_found:

print(f"Found {errors_found} occurrences of error code.")

else:

print("No errors found.")

2.2.2 日志文件的过滤和搜索技巧

过滤和搜索日志文件可以通过一些专门的日志分析工具来实现,比如ELK Stack(Elasticsearch, Logstash, Kibana)组合,或者使用系统内置的日志管理工具如Windows的Event Viewer、Linux的 grep 命令等。

例如,使用 grep 命令在命令行中过滤特定的日志级别信息:

grep -i 'ERROR' /var/log/application.log

此外,还可以使用高级搜索语法来组合多个条件,如在ELK中的Kibana搜索栏使用Lucene查询语法进行复杂的查询。

在构建搜索查询时,可以考虑使用以下技巧:

- 使用通配符和正则表达式来拓宽或缩小搜索范围。

- 利用日志时间戳来筛选特定时间段内的日志。

- 应用逻辑运算符(如AND, OR, NOT)来组合多个搜索条件。

通过综合运用这些技巧,开发者可以快速准确地定位问题所在,从而进行有效的日志分析和调试。

在下一章中,我们将继续探讨错误排查方法与性能监控实践。

3. 错误排查方法与性能监控实践

3.1 错误排查方法

3.1.1 日志事件关联分析

在面对复杂的系统问题时,单条日志信息很难提供足够的信息来诊断问题。此时,日志事件关联分析(Correlation Analysis)显得尤为重要。通过将不同来源的日志事件关联起来,可以帮助我们构建出问题发生的完整时间线和上下文环境。

事件关联分析往往依赖于事件的共性和时间戳。例如,系统崩溃时,除了崩溃日志,可能会伴随着大量的连接错误、超时、重试日志等。这些日志虽然分散在不同的模块或服务中,但它们的时间戳相近,这些共同特征可以帮助我们快速定位到系统的关键问题点。

flowchart LR

A[开始事件关联分析] --> B[收集日志文件]

B --> C[提取关键信息]

C --> D[关联时间戳相近的日志]

D --> E[分析日志之间的逻辑关系]

E --> F[构建问题时间线]

F --> G[识别问题根本原因]

3.1.2 系统状态检查与故障诊断

进行故障诊断前,首要任务是检查系统的当前状态。这包括但不限于CPU、内存、磁盘I/O和网络使用情况。这些状态信息能帮助我们判断系统是否有资源瓶颈,或者是否存在网络通信问题。

graph TD

A[开始系统状态检查] --> B[检查CPU使用率]

A --> C[检查内存使用情况]

A --> D[检查磁盘I/O状态]

A --> E[检查网络使用情况]

B --> F[识别CPU瓶颈]

C --> G[识别内存泄漏]

D --> H[识别磁盘性能问题]

E --> I[识别网络延迟或中断]

F --> J[故障诊断]

G --> J

H --> J

I --> J

系统状态检查的命令示例如下:

# 查看CPU使用率

top

# 查看内存使用情况

free -m

# 查看磁盘I/O状态

iostat

# 检查网络使用情况

netstat -i

系统状态检查与故障诊断通常需要结合日志分析来进行,以全面理解系统运行状况。

3.2 性能监控实践

3.2.1 关键性能指标的监控方法

对于任何IT系统,监控关键性能指标(Key Performance Indicators,KPIs)是至关重要的。这些指标可能包括响应时间、吞吐量、系统负载等。监控这些指标可以帮助我们评估系统的健康状况,并及时发现潜在问题。

性能监控通常使用专门的监控工具来完成,这些工具能够提供实时的系统性能数据,一旦检测到异常,能够快速发出警报。在监控策略制定时,需要根据业务需求和系统特点来选择合适的监控指标和工具。

# 监控Web服务器响应时间

curl -o /dev/null -s -w "%{http_code} %{time_total}\n" ***

# 监控系统负载

uptime

3.2.2 性能瓶颈的诊断与优化

当性能监控显示出系统存在性能瓶颈时,如何定位并优化这些瓶颈就成为了关键。性能瓶颈可能发生在多种层面,比如应用层、数据库层或是网络层。诊断的步骤通常包括:

- 确定瓶颈发生的时间段和负载级别。

- 使用性能分析工具对系统进行压力测试。

- 分析测试结果,确定瓶颈源。

- 根据瓶颈源,采取相应的优化措施。

例如,针对数据库层的性能瓶颈,可以采取以下优化方法:

-- 检查数据库中的慢查询

SELECT query, query_time, lock_time, rows_sent, rowsExamined

FROM information_schema.processlist

WHERE query_time > 2;

-- 分析查询计划

EXPLAIN SELECT * FROM some_table WHERE condition;

通过逐步优化这些瓶颈,系统性能会得到显著提升。性能优化是一个持续的过程,需要定期检查和调整策略以适应业务发展的需要。

4. 安全审计应用与运维管理日志聚合

4.1 安全审计应用

4.1.1 审计日志的收集和分析

安全审计日志是企业IT系统中记录关键操作和事件的重要组成部分。它们提供了必要的历史记录,用于追查安全事件的根源、审计合规性以及在必要时进行责任的追溯。

审计日志的重要性

审计日志不仅帮助组织遵守各种法规,例如GDPR、HIPAA等,而且为风险管理提供了一个核心工具。通过持续的监控和审计日志的分析,组织能够及时发现异常行为,对潜在的安全威胁进行预警,并采取适当的措施。

收集审计日志的方法

有效的审计日志收集需要考虑以下几点:

- 日志来源的识别 :首先要确定哪些系统、应用程序和网络设备将生成对安全审计有帮助的日志。

- 日志格式化和标准化 :确保所有日志都以一种易于分析的格式存储,通常JSON或XML格式是首选。

- 日志收集工具的选择 :可以使用系统自带的日志工具,如Windows的事件查看器或Linux的syslog,也可以采用更为复杂的解决方案,如Splunk、Graylog等。

- 数据传输 :使用如Syslog、FTP、SCP或加密的TLS连接来传输日志数据至中央收集点。

分析审计日志

分析审计日志时,应重点查看以下方面:

- 用户活动 :包括登录、登出、权限更改、文件访问等。

- 系统事件 :包括服务启动/停止、配置更改、系统重启等。

- 网络流量 :监控异常的入站和出站连接。

- 数据访问模式 :异常的访问模式可能表明数据被非法访问或存在内部威胁。

示例代码块:

以下是一个简单的命令,用于在Linux系统中分析/var/log/auth.log文件,该文件记录了用户身份验证和授权活动的日志。

tail -f /var/log/auth.log | grep "Failed password"

分析审计日志的代码解读

-

tail -f:显示文件的最后几行,并实时追踪文件的更新。 -

/var/log/auth.log:指定日志文件的路径。 -

grep "Failed password":筛选出包含"Failed password"的行,通常用于发现登录尝试失败的情况。

分析审计日志是一种持续的过程,需要定期调整筛选条件以适应新出现的威胁模式,并且应使用自动化工具来协助这一过程。

4.1.2 安全事件的追踪和响应

一旦通过审计日志识别出可疑活动或潜在的安全事件,就必须采取进一步的追踪和响应措施。这一过程包括对事件的深入分析、对受影响系统的隔离、以及制定和执行修复策略。

事件追踪的步骤

- 详细审查事件 :分析事件上下文,了解事件发生的具体时间和位置。

- 影响评估 :评估事件对组织运营的影响范围和程度。

- 确定根本原因 :通过深入的技术分析,找到事件发生的原因。

- 风险评估 :基于事件的性质和影响,评估可能面临的风险。

事件响应计划

组织应预先制定一个详细的事件响应计划,该计划应包括以下内容:

- 事件响应团队的组成 :确定谁负责调查和处理安全事件。

- 事件分类和优先级 :定义不同类型的事件以及响应的优先级。

- 沟通协议 :确保事件发生时内部和外部沟通顺畅。

- 恢复步骤 :详细描述事件发生后恢复正常运营的步骤。

- 复盘和改进 :在事件处理完毕后,评估事件响应过程的有效性,并提出改进措施。

示例代码块:

此代码块用于演示如何在Linux系统中使用脚本实现针对特定事件的初步响应。

# 示例脚本:检测并响应登录失败事件

FailedLoginThreshold=3

FailedLoginCount=$(grep "Failed password" /var/log/auth.log | wc -l)

if [ $FailedLoginCount -ge $FailedLoginThreshold ]; then

echo "Detected potential brute force attack, triggering response protocol."

# Isolate the compromised system and apply temporary restrictions

# Notify the security team and trigger an investigation

else

echo "No action required."

fi

代码逻辑分析与参数说明

-

FailedLoginThreshold:设定一个阈值,超过这个值即认为有潜在的暴力破解攻击。 -

FailedLoginCount:计算在auth.log中“Failed password”出现的次数。 -

wc -l:统计日志中该字符串出现的行数。 -

if [ $FailedLoginCount -ge $FailedLoginThreshold ]; then:如果失败登录尝试次数达到或超过阈值,执行条件内的命令。 -

echo "Detected potential brute force attack, triggering response protocol.":输出检测到的潜在暴力破解攻击信息。 -

# Isolate the compromised system and apply temporary restrictions:注释,说明要对受影响系统进行隔离和临时限制。 -

# Notify the security team and trigger an investigation:注释,说明要通知安全团队并启动调查。

事件追踪与响应的最佳实践

- 实时监控与自动化 :使用先进的监控工具和自动化脚本以实时方式监控关键日志,快速响应安全事件。

- 预定义规则和流程 :确保有预定义的安全事件处理规则和流程,以加快响应时间。

- 定期培训与演练 :定期对事件响应团队进行培训,并通过模拟演练提高团队的反应能力。

- 持续改进 :事件处理完成后,要进行复盘,记录学习经验,并不断优化响应流程。

4.2 运维管理日志聚合

4.2.1 日志数据的集成与管理

在大规模的IT环境中,日志数据的集成和管理是确保高效运维的关键组成部分。日志聚合解决方案允许组织收集、存储、分析和可视化来自不同来源的日志数据。

日志数据集成的重要性

日志数据集成能够:

- 提高数据可见性 :提供一个统一的日志视图,帮助运维人员快速定位问题。

- 简化管理 :通过集中化存储,简化日志的备份、归档和清理。

- 增强安全性 :集中管理可以更好地保护日志数据,确保审计跟踪的完整性。

- 支持大数据分析 :集成后的日志数据可用于高级分析,如用户行为分析、预测性维护等。

实现日志数据集成的方法

实现日志数据集成通常包括以下几个步骤:

- 日志收集器部署 :使用如Fluentd、Logstash等工具收集不同来源的日志数据。

- 日志格式标准化 :确保所有日志数据都转换为统一的格式,便于处理。

- 数据传输 :安全地将日志数据发送到日志聚合系统。

- 存储解决方案的选择 :选择适合的存储解决方案,比如分布式文件系统或云存储服务。

- 索引和查询优化 :构建有效的索引和查询优化策略,加快日志检索速度。

示例代码块:

该示例展示了如何使用Logstash配置文件实现日志数据的收集与发送。

input {

file {

path => "/var/log/app.log"

start_position => "beginning"

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

add_tag => [ "ApacheAccessLog" ]

}

}

output {

elasticsearch {

hosts => ["elasticsearch-node1", "elasticsearch-node2"]

index => "app-%{+YYYY.MM.dd}"

}

}

日志数据管理的代码解读

-

input:定义日志源,这里是来自/var/log/app.log文件的日志数据。 -

file:指定文件路径和开始读取文件的位置。 -

filter:配置过滤器,使用grok插件解析Apache访问日志。 -

match:使用正则表达式来解析message字段的文本。 -

add_tag:为解析后的日志添加标签。 -

output:定义输出配置,这里使用Elasticsearch作为存储和搜索引擎。

日志数据管理的挑战与解决策略

- 性能优化 :对于大型日志数据集,性能优化是至关重要的。使用高效的数据结构和索引策略,并对查询进行调优。

- 数据清洗和预处理 :日志数据可能会包含大量的非结构化信息。应实施预处理来提取关键信息并丢弃无用数据。

- 安全和合规性 :应确保遵循数据保护法规,对敏感数据进行加密,并实现访问控制。

- 可扩展性 :随着数据量的增长,应设计可扩展的系统架构,以便应对未来的数据增长。

4.2.2 日志聚合平台的构建与优化

构建一个高效且可扩展的日志聚合平台对于大规模IT运维至关重要。它可以帮助组织从不同来源收集和集中日志数据,以便进行分析和监控。

构建日志聚合平台的关键要素

- 可扩展的存储 :设计可水平扩展的存储层,以支持不断增长的日志数据量。

- 实时处理与流式分析 :采用实时流处理技术对日志数据进行分析,以便快速响应。

- 数据可视化 :提供用户友好的界面,将复杂的数据转化为可操作的见解。

- 智能告警系统 :基于日志分析结果,实现智能告警机制,当检测到异常行为时及时通知相关人员。

构建日志聚合平台的步骤

- 需求分析 :分析组织的需求,确定日志数据的种类、量级和使用场景。

- 技术选型 :根据需求选择合适的技术栈,例如ELK(Elasticsearch, Logstash, Kibana)栈、Graylog等。

- 架构设计 :设计系统的物理架构和逻辑架构,包括数据流向和系统组件。

- 实施部署 :按照设计架构部署硬件和软件。

- 集成测试 :执行系统集成测试,验证系统功能满足预期。

- 监控与优化 :部署监控工具来持续跟踪系统性能,并进行调优。

mermaid格式流程图展示日志聚合平台构建过程:

graph LR

A[需求分析] --> B[技术选型]

B --> C[架构设计]

C --> D[实施部署]

D --> E[集成测试]

E --> F[监控与优化]

日志聚合平台优化策略

- 数据索引优化 :调整Elasticsearch中的索引策略,提高数据检索效率。

- 资源管理 :优化资源分配,包括CPU、内存和存储资源的动态调整。

- 维护与更新 :定期进行系统维护和软件更新,确保平台的稳定性和安全性。

- 用户培训 :对用户进行平台使用培训,提高用户对平台功能的认识。

代码块示例:优化Elasticsearch索引性能

PUT _template/log_index_template

{

"template": "log-*",

"settings": {

"number_of_shards": 3,

"number_of_replicas": 2

},

"mappings": {

"properties": {

"timestamp": {

"type": "date"

},

"message": {

"type": "text"

}

}

}

}

代码逻辑分析与参数说明

-

PUT _template/log_index_template:定义一个名为log_index_template的新模板。 -

"template": "log-*":指定该模板适用于所有以"log-"开头的索引。 -

"number_of_shards": 3和"number_of_replicas": 2:设置主分片数量为3个,副本分片数量为2个,以提供更好的查询性能和数据冗余。 -

"mappings": { "properties": { "timestamp": { "type": "date" } }}:定义数据映射,如timestamp字段应被视为日期类型。

通过上述策略和步骤,组织可以构建和优化其日志聚合平台,从而提高运维效率,增强安全性,并支持业务洞察。

结语

本章节深入探讨了安全审计应用和运维管理日志聚合的重要性、实践方法和优化策略。通过对审计日志的精细收集和分析,以及日志数据的有效集成与管理,组织可以更好地应对安全威胁,确保业务连续性和合规性。同时,日志聚合平台的构建与优化为运维团队提供了强大的工具来处理和分析日益增长的日志数据。

5. 测试反馈的记录与分析及日志配置与分析工具使用

在软件开发周期中,测试阶段是确保产品稳定性和性能的关键环节。有效的测试反馈和日志分析是改进软件质量和性能的重要手段。本章节将探讨如何记录和分析测试反馈,以及如何配置日志和利用日志分析工具来提高工作效率。

5.1 测试反馈的记录与分析

测试阶段的反馈记录对于软件质量保证至关重要。将测试结果与日志文件中的信息关联起来,可以帮助开发团队深入理解软件在不同环境下的行为,从而做出针对性的改进。

5.1.1 测试结果的记录与日志关联

在自动化测试执行后,测试结果通常包含通过/失败的状态、执行时间以及失败的详细信息。为了能够更好地分析问题,我们需要将这些测试结果与相关的日志文件关联起来。这一过程可以通过编写脚本实现,将日志文件中的关键信息提取出来,并与测试结果进行匹配。

例如,假设我们有一个Web应用的测试日志和错误日志,可以通过以下Python脚本提取测试失败时的错误日志信息:

import re

import json

# 假设日志文件和测试结果存储路径已知

log_file_path = 'path/to/your/logfile.log'

test_result_file_path = 'path/to/your/test_results.json'

# 正则表达式用于匹配错误日志条目

error_pattern = ***pile(r'ERROR.*')

# 读取测试结果并解析

with open(test_result_file_path, 'r') as ***

***

* 读取日志文件并寻找匹配项

with open(log_file_path, 'r') as ***

***

* 关联错误日志和测试结果

failed_tests_with_logs = []

for test in test_results:

if not test['passed']:

test_name = test['name']

for entry in log_entries:

if error_pattern.search(entry) and test_name in entry:

failed_tests_with_logs.append((test_name, entry))

# 输出关联后的测试和日志条目

for test_log in failed_tests_with_logs:

print(f"Test: {test_log[0]}, Log Entry: {test_log[1]}")

5.1.2 测试反馈的持续改进循环

将测试结果和日志关联后,我们还需要建立起一个持续改进的循环。测试团队应定期回顾失败案例,并使用日志信息来识别和解决重复出现的问题。此外,分析测试过程中的性能瓶颈,有助于优化测试流程和提升软件整体性能。

5.2 日志配置与日志分析工具的使用

合理配置日志文件对于后续的分析工作至关重要。此外,选择合适的日志分析工具可以大幅提高日志管理和分析的效率。

5.2.1 配置日志文件的策略和实践

配置日志文件时,应当考虑以下几点:

- 日志级别 :设置合适的日志级别,以便记录下必要的信息,同时避免过多的冗余信息。

- 格式化 :日志应有清晰的格式,便于读取和解析。

- 旋转和归档 :对于大量产生的日志,应使用日志轮转策略,确保日志文件不会无限制增长。

- 安全性 :确保敏感信息不会记录在日志中。

下面是一个日志配置文件的示例,使用了Python的logging模块:

import logging

# 创建一个日志器

logger = logging.getLogger('example_logger')

logger.setLevel(***) # 设置日志级别为INFO

# 创建一个处理器,并设置日志级别

handler = logging.FileHandler('app_log.log')

handler.setLevel(***)

# 创建一个格式器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler.setFormatter(formatter)

# 将处理器添加到日志器

logger.addHandler(handler)

# 使用日志器记录信息

***('This is an example log entry.')

5.2.2 日志分析工具的选择和应用案例

市场上有许多日志分析工具,它们各有特点。选择合适的工具,可以帮助我们快速定位问题和进行日志分析。

下面列举一些流行的日志分析工具及其特性:

- ELK Stack (Elasticsearch, Logstash, Kibana) :一个功能强大的日志管理解决方案,适合大规模日志的收集、索引和可视化。

- Splunk :一款商业软件,提供强大的搜索、监控和分析功能,非常适合处理和分析机器数据。

- Fluentd :一个开源数据收集器,专门用于统一日志层,具有高度可靠性和灵活性。

- Graylog :开源日志管理平台,提供实时数据处理和存储功能,支持灵活的警报和数据可视化。

以ELK Stack为例,其应用流程如下:

- 日志数据采集 :使用Logstash或Filebeat采集日志数据。

- 数据索引 :将采集到的数据发送到Elasticsearch进行索引处理。

- 数据分析与可视化 :利用Kibana进行数据分析和创建仪表板展示。

以配置Logstash为例,一个简单的配置文件内容如下:

input {

file {

path => "/var/log/example.log"

start_position => "beginning"

}

}

filter {

if [log_type] == "error" {

mutate {

add_field => { "is_error" => "true" }

}

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "app_log-%{+YYYY.MM.dd}"

}

}

通过上述内容的深入分析和实践,我们可以发现测试反馈的记录与分析以及日志配置与分析工具的使用是提升软件质量与性能不可或缺的环节。在实际操作中,我们需要根据具体的需求选择合适的工具和策略,并通过持续的学习与实践来优化我们的工作流程。

简介:日志文件在IT行业中扮演着记录系统和应用运行事件的关键角色。本文档“log日志数据文件(测试用-test)”特指用于测试目的的日志文件,包含了操作记录和错误信息,用于分析和调试。在软件测试中,日志文件记录了测试步骤、异常情况和错误报告等信息,对于理解测试过程和优化测试策略至关重要。本文将详细介绍如何使用日志文件进行错误排查、性能监控、安全审计、运维管理和测试反馈,同时强调了解析日志文件的重要性和使用日志分析工具的必要性。

日志文件的分析与应用全解析

日志文件的分析与应用全解析

707

707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?