简介:Lucene 是一个高性能的全文搜索库,提供强大的 API 实现文本检索功能。它包含多个组件,如索引、查询解析、搜索、排序高亮和文档更新删除。本例展示了如何通过具体的步骤和代码示例手工实现 Lucene 索引的创建、文档索引、查询处理和搜索结果展示,从而帮助开发者理解和应用 Lucene 进行全文检索。

1. Lucene 概述与功能介绍

在信息检索领域,Apache Lucene是一个强大的开源搜索引擎库,广泛应用于全文搜索应用程序中。它提供了构建搜索引擎的框架和工具,允许开发者在自己的应用程序中加入高效的搜索能力。Lucene不仅仅是一个全文搜索引擎,它还是一个工具包,提供了搜索算法、索引机制、查询处理等多种功能。

Lucene 的核心优势在于其高效率和可扩展性,使其能快速处理大量数据。它支持多种字段类型,如文本、数值和日期,并且能够处理复杂的查询请求,包括布尔操作、通配符、正则表达式等。此外,Lucene 的架构允许它在保持高性能的同时,进行横向扩展。

接下来,我们将深入探讨Lucene的核心组件和功能,以及它如何将这些组件组织起来构建出一个功能完备的搜索引擎。我们会从索引创建和文本分析开始,逐步深入到查询解析和结果排序等各个方面。通过本章内容,读者将获得一个全面的Lucene搜索引擎工作原理的概念和理解。

2. 索引组件深入探究

2.1 索引创建流程

2.1.1 索引结构与组件

索引是全文搜索的灵魂,它将文档转换为一种特定格式,以供查询时快速检索。Lucene 的索引结构复杂,但设计巧妙,可以高效地执行搜索操作。一个 Lucene 索引主要由以下组件构成:

- 段(Segments) :索引的基本单元,每个段都是一个独立的倒排索引。

- 倒排索引(Inverted Index) :包含词汇表和指向文档列表的指针,是实现快速搜索的关键。

- 文档(Documents) :索引的数据单元,由一系列字段(Fields)组成。

- 字段(Fields) :文档中用于检索的独立单元,可以包含文本、数字、二进制数据等。

索引过程中,Lucene 会进行如下操作:

- 创建索引文件,包括段文件、索引元数据文件等。

- 将文档中的数据转换为索引能够处理的格式。

- 将转换后的数据插入倒排索引中。

索引创建流程的关键是使倒排索引最小化并优化读写速度。为了达到这个目标,Lucene 采用了分段机制,通过合并段和删除无用信息来维护索引的性能。

2.1.2 分析器的使用与定制

文本分析是构建索引的重要一步。在 Lucene 中,分析器将输入的文本转换成一系列的标记(tokens),这些标记存储于倒排索引中。分析器由三部分组成:

- 字符过滤器(Character Filters) :在分词之前处理文本,例如去除HTML标记。

- 分词器(Tokenizer) :将文本分割成单独的标记。

- 标记过滤器(Token Filters) :处理分词器输出的标记,例如进行小写转换。

默认情况下,Lucene 提供了 StandardAnalyzer ,它适合英文等西方语言的分析。对于中文等非西方语言,通常需要定制分析器以适应语言特性。例如,中文文本需要进行分词处理,可以使用 IKAnalyzer 、 Jieba 等专用的中文分词器。

使用和定制分析器的代码示例如下:

import org.apache.lucene.analysis.Analyzer;

import org.apache.lucene.analysis.standard.StandardAnalyzer;

***.smart.SmartChineseAnalyzer;

// 使用标准分析器

Analyzer standardAnalyzer = new StandardAnalyzer();

// 使用中文智能分词分析器

Analyzer smartChineseAnalyzer = new SmartChineseAnalyzer();

2.2 文本分析处理

2.2.1 分词技术与原理

分词是将连续的文本切分成一个个有独立含义的词汇。分词技术是文本处理中的基础,尤其在中文中至关重要。中文分词的基本方法有:

- 基于字符串匹配的分词 :按照一定的规则切割文本,如最大匹配法和最小匹配法。

- 基于理解的分词 :采用一定的语言模型来判断分词的最佳路径,例如隐马尔可夫模型。

- 基于统计的分词 :使用机器学习技术,通过大量语料库训练得到分词模型。

分词技术的选择依赖于应用场景和具体的语言特性。Lucene 本身不直接提供中文分词器,但支持通过插件方式引入。

2.2.2 常见的中文分词工具

在中文分词领域,有一些非常优秀的工具可以与 Lucene 结合使用。以下是几种常见的中文分词工具:

- HanLP :Java语言开发的自然语言处理包,提供了丰富的分词算法。

- IKAnalyzer :基于 Java 的开源中文分词库,提供了细粒度的分词控制。

- Jieba :一款轻量级的中文分词工具,特别适用于搜索。

2.2.3 分词器的选择和实现

选择适合的分词器是中文搜索引擎开发中的重要环节。根据不同的业务需求,可以从以下方面考虑:

- 分词速度 :在大规模数据处理时,需要分词器具备较快的处理速度。

- 分词精度 :在法律、医疗等特定领域,对分词精度要求较高。

- 扩展性 :分词器是否支持自定义词典和扩展字典功能。

实现自定义分词器的步骤可能包括:

- 实现

Analyzer类并重写分词逻辑。 - 在自定义分词器中嵌入特定的分词算法。

- 根据需要选择或编写合适的字符过滤器和标记过滤器。

- 在 Lucene 索引创建过程中使用自定义分词器。

通过上述步骤,可以根据具体需求定制出满足业务场景的分词器。

以上内容仅为第二章的一个缩影,深入的细节与操作步骤在完整的章节内容中将更为详实,涵盖代码示例、策略对比和性能分析,以确保文章对IT专业人士具备较高的实用价值和深度。

3. 查询解析组件详解

查询是搜索引擎的核心功能之一,它允许用户根据特定的条件检索信息。在Lucene中,查询解析组件承担了将用户输入的查询语句解析成可执行查询对象的任务。本章将详细探究Lucene查询解析组件的构成和运作机制。

3.1 查询语言的构成

3.1.1 基本查询语法

Lucene查询语言相对简洁,但提供了足够的灵活性来执行各种复杂的搜索任务。基本查询语法包括关键词搜索、字段搜索和短语搜索等。

以关键词搜索为例,用户可以输入一个词或一组词来进行搜索。例如:

lucene search

这个查询将返回所有包含“lucene”和“search”这两个词的文档。

字段搜索允许用户指定一个字段来限制搜索范围。格式为 字段名:搜索词 。如搜索标题中包含“lucene”的文档:

title:lucene

短语搜索则通过引号来限定精确的短语匹配,比如:

"title:lucene search"

这个查询将会返回包含确切短语“lucene search”的文档标题。

3.1.2 复杂查询构造

除了基本语法,Lucene还支持更多的操作符来构造更复杂的查询,例如布尔操作符(AND, OR, NOT)、范围查询、通配符查询等。

布尔操作符用于组合多个搜索条件。例如:

lucene AND search

上述查询会返回包含“lucene”和“search”两个词的文档。

范围查询允许用户搜索某个范围内的值。格式为 字段名:[最小值 TO 最大值] 。比如搜索ID在1到10之间的文档:

id:[1 TO 10]

通配符查询可以使用 * 和 ? 进行模式匹配。 * 代表任意数量的字符,而 ? 代表任意单个字符。例如:

doc*

这个查询会匹配所有以“doc”开头的词。

代码块展示与逻辑分析

下面是一个使用Java编写的Lucene查询解析的示例代码:

import org.apache.lucene.analysis.standard.StandardAnalyzer;

import org.apache.lucene.document.Document;

import org.apache.lucene.index.DirectoryReader;

import org.apache.lucene.index.IndexReader;

import org.apache.lucene.queryparser.classic.QueryParser;

import org.apache.lucene.search.IndexSearcher;

import org.apache.lucene.search.Query;

import org.apache.lucene.search.ScoreDoc;

***Docs;

import org.apache.lucene.store.Directory;

import org.apache.lucene.store.FSDirectory;

import java.nio.file.Paths;

public class LuceneSearchExample {

public static void main(String[] args) throws Exception {

// 指定索引目录路径

String indexDirectoryPath = "/path/to/your/index";

// 创建查询解析器,指定默认字段

QueryParser parser = new QueryParser("content", new StandardAnalyzer());

// 解析查询语句

Query query = parser.parse("lucene AND search");

// 打开索引读取器

Directory directory = FSDirectory.open(Paths.get(indexDirectoryPath));

IndexReader reader = DirectoryReader.open(directory);

IndexSearcher searcher = new IndexSearcher(reader);

// 执行查询

TopDocs docs = searcher.search(query, 10);

// 获取并输出结果

for(ScoreDoc scoreDoc : docs.scoreDocs) {

Document doc = searcher.doc(scoreDoc.doc);

System.out.println(doc.get("title") + "\t" + doc.get("url"));

}

// 关闭资源

reader.close();

directory.close();

}

}

上述代码首先创建了一个 QueryParser 实例用于解析用户输入的查询语句。这里指定了默认字段为 content ,意味着没有明确指定字段的查询条件会默认应用于 content 字段。

解析之后,通过 IndexSearcher 执行查询,并获取了评分最高的前10个结果。

3.2 查询类型的支持

Lucene支持多种类型的查询,它们各自有不同的用途和性能特性。

3.2.1 布尔查询

布尔查询(BooleanQuery)是组合多个子查询的通用方式。每个子查询可以是布尔查询,也可以是其他类型的查询。布尔查询利用布尔操作符(AND, OR, NOT)来组合子查询。

下面展示了如何使用布尔查询:

BooleanQuery.Builder booleanQuery = new BooleanQuery.Builder();

// 添加子查询

booleanQuery.add(new TermQuery(new Term("title", "lucene")), BooleanClause.Occur.MUST);

booleanQuery.add(new TermQuery(new Term("content", "search")), BooleanClause.Occur.SHOULD);

Query query = booleanQuery.build();

上述代码创建了一个布尔查询,并添加了一个必须满足的子查询和一个可选的子查询。

3.2.2 范围查询

范围查询(RangeQuery)允许用户查询在某个范围内的文档。例如,用户可能只想搜索价格在10到20之间的产品。

RangeQuery rangeQuery = new TermRangeQuery("price", "10", "20", true, true);

这个查询会返回所有价格字段值在10到20之间的文档。参数中的 true, true 表示包括边界值。

3.2.3 模糊查询

模糊查询(FuzzyQuery)用于处理拼写错误的单词。例如,如果用户搜索的词是“lucen”,而索引中只有“lucene”,模糊查询可以用来匹配这个拼写错误。

FuzzyQuery fuzzyQuery = new FuzzyQuery(new Term("title", "lucen"), 2);

上述代码创建了一个模糊查询,其中 2 表示最大编辑距离。这个查询将会匹配包含“lucen”或“lucenc”等相似词汇的文档。

通过这些查询组件,Lucene允许开发者构建精确的查询表达式,以便满足复杂的搜索需求。下一章将介绍搜索组件的执行机制和优化策略,以进一步提升搜索效率和结果质量。

4. 搜索组件的实现与优化

4.1 执行查询机制

4.1.1 查询执行流程

Lucene 的查询执行流程涉及到多个组件和步骤,以确保查询能够高效准确地返回结果。首先,用户发出的查询请求经过 Lucene 的查询解析器(QueryParser)处理,解析成一个查询树。接着,查询树被转换成一个可执行的查询对象,如BooleanQuery、TermQuery等。这个转换过程由查询组件(QueryComponents)完成。

查询对象接下来需要与索引中的文档进行匹配。这个过程称为搜索(Search)。在 Lucene 中,搜索是通过索引的段(Segment)来进行的。每个段都对应一个或多个倒排索引(Inverted Index),在倒排索引中,词汇(Term)被存储并映射到包含它们的文档列表上。搜索组件会根据查询类型,遍历相关的倒排索引,并利用位集(BitSet)来快速定位匹配的文档。

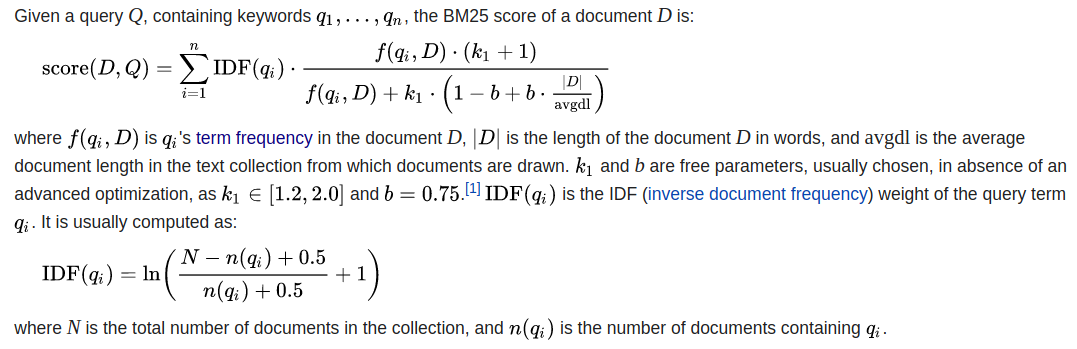

在执行查询的过程中,一个关键步骤是评分(Scoring)。Lucene 使用特定的评分算法(如TF-IDF、BM25等)为每个匹配的文档计算一个评分。这个评分基于词频(Term Frequency)、文档频率(Document Frequency)以及文档长度等因素。评分机制的选择和配置对查询结果的相关性有重要影响。

4.1.2 查询性能优化策略

为了提升查询性能,开发者可以采取多种优化策略。一种常见的优化手段是通过调整倒排索引的结构,比如使用词典(Dictionary)来减少查询时的内存占用,或者调整索引分片(Sharding)来提高并发处理能力。

另一个优化方向是调整查询本身。例如,开发者可以通过过滤器(Filter)来避免对不需要的文档进行评分计算,减少CPU的负担。还可以使用缓存(Caching)来存储高频查询的中间结果,减少重复的计算开销。

针对特定的查询类型,也可以进行优化。例如,对于范围查询(Range Query),可以通过维护正排索引(Forward Index)或使用预先排序的倒排索引(Sorted Inverted Index)来提升性能。对于模糊查询(Fuzzy Query),使用合适的编辑距离算法和合理的阈值设置能够提升查询速度同时保证结果的相关性。

4.2 文档匹配过程

4.2.1 索引匹配原理

文档匹配是 Lucene 中搜索的核心。在索引过程中,文档被分解为多个词条,每个词条都被加入到倒排索引中。在搜索过程中,查询树的每一个节点都对应着索引中的一个或多个倒排列表。这些列表被用来快速定位到包含查询词条的文档。

为了准确地匹配查询,Lucene 中的查询执行器(QueryExecutor)会根据查询对象的类型和结构,对倒排列表进行迭代、合并和裁剪操作。例如,一个BooleanQuery会组合多个子查询的倒排列表来找到满足所有条件的文档集合。而一个TermQuery只需要对包含特定词条的倒排列表进行查找即可。

文档匹配过程中,还需要考虑查询优化器(QueryOptimizer)。优化器会根据索引统计信息来决定最有效的搜索策略,比如是否跳过某些倒排列表的访问,或者调整搜索顺序来提升效率。

4.2.2 匹配结果的评分与排序

匹配到的文档集合需要根据评分算法进行评分,以此来确定文档的相关性排序。Lucene 默认使用TF-IDF算法来评估文档对查询的匹配程度。TF-IDF算法会考虑词频(Term Frequency)和逆文档频率(Inverse Document Frequency),从而计算出每个文档的评分。

评分之后,文档需要按照评分进行排序。这个排序过程可能会使用到多种排序方法,比如按相关性评分排序(Score Sorting),或者是其他字段(如日期、价格等)的多字段排序(Multi-Field Sorting)。多字段排序可能涉及到复杂的排序策略,例如二级排序(Secondary Sorting)和条件排序(Conditional Sorting)。

排序完成后,返回给用户的是一系列有序的结果列表。在这个过程中,还需要进行一些后处理步骤,例如去除重复文档(De-Duplication)和应用访问控制列表(Access Control List, ACL)来过滤结果。

通过上文的介绍,我们已经对 Lucene 的搜索组件的内部机制有了基本的认识,以及了解了如何通过不同的策略来优化文档的匹配过程。接下来,我们将具体探讨 Lucene 的排序和高亮组件的应用,以及更新和删除组件的功能性实践,进一步深入理解 Lucene 的强大功能和灵活性。

5. 排序和高亮组件的应用

5.1 结果排序的实现

5.1.1 排序算法与Lucene的集成

在搜索引擎中,用户期望搜索结果能够按照一定的顺序显示,通常这样的顺序与用户的需求息息相关。比如,对于新闻网站而言,人们通常希望看到最新的新闻排在前面。在Lucene中,排序功能能够通过集成不同的排序算法来实现。

Lucene提供了一些默认的排序选项,例如按文档的ID排序、按某个字段的值排序(升序或降序)、按照自定义的评分进行排序等。每种排序算法在Lucene内部都会有自己的实现,而我们可以通过定义不同的 Sort 对象来指定排序的方式。

一个简单的例子就是通过文档的创建时间来排序:

Sort sort = new Sort(SortField.FIELD_DOC);

在上述代码中, FIELD_DOC 字段指定了按照文档ID进行排序。如果需要按照自定义的字段(如时间戳、价格等)排序,可以通过 SortField 类创建一个自定义字段的排序对象:

SortField timestampSort = new SortField("timestamp", SortField.Type.INT);

Sort sort = new Sort(timestampSort);

在上述代码中,我们假设有一个名为"timestamp"的字段存储了文档的时间戳,我们通过指定 SortField.Type.INT 来进行整数类型排序。

5.1.2 多字段排序的实现方式

有时需要根据多个字段进行排序,例如,在一个电子商务平台上,可能需要先按照价格排序,如果价格相同则按评论数量排序。Lucene支持多字段排序,可以通过 Sort 类的构造函数或链式方法来添加多个排序字段。

SortField priceField = new SortField("price", SortField.Type.FLOAT);

SortField reviewCountField = new SortField("reviewCount", SortField.Type.INT);

Sort sort = new Sort().addSort(priceField).addSort(reviewCountField);

在此代码中,首先定义了价格字段的排序方式,然后定义了评论数量字段的排序方式。这两个字段都被添加到了同一个 Sort 对象中,表示按照价格排序,如果价格相同,则根据评论数量排序。

此外,对于字段排序,还可以设置是否忽略相同字段值(tie-breakers)以及是否降序排列等参数,使得排序功能更加灵活多变。

5.2 高亮显示技术

5.2.1 高亮显示原理

高亮显示是提高用户体验的重要方式之一,它在用户搜索关键词时,将关键词在结果中突出显示。这样用户可以一目了然地找到包含其搜索词的结果,并且能够快速判断该结果是否符合其需求。

在Lucene中,高亮显示的实现原理通常是这样的:在搜索结果返回时,系统将返回的文档中的关键词用特定的HTML标签包裹起来,比如使用 <strong> 标签,使得关键词部分以加粗或者不同的颜色显示。

为了实现高亮显示,Lucene需要在建立索引的时候存储关键词的位置信息。当执行查询的时候,Lucene会根据查询条件找到对应的关键词,并将这些关键词高亮显示。这个过程中,文档的每个字段都需要进行这样的操作,以确保所有匹配的部分都得到了高亮。

5.2.2 实现高亮显示的方法

在Lucene中,可以通过 Highlighter 类来实现高亮点的提取和格式化。基本的实现步骤包括:

- 创建

Highlighter对象。 - 设置

QueryScorer,它会根据提供的查询条件来选择高亮的部分。 - 使用

SimpleHTMLFormatter来设置高亮显示的具体格式。

下面是一个简单的代码示例:

SimpleHTMLFormatter formatter = new SimpleHTMLFormatter("<b><font color='red'>", "</font></b>");

QueryScorer scorer = new QueryScorer(query);

Highlighter highlighter = new Highlighter(formatter, scorer);

TokenStream tokenStream = analyzer.tokenStream("field", new StringReader("this is a test"));

String highlightedText = highlighter.getBestFragment(tokenStream, new StringReader("this is a test"), "this is a test");

在这个示例中,我们首先创建了一个 SimpleHTMLFormatter 对象,它定义了高亮显示的开始和结束标签,我们选择的是红色字体。接着创建了一个 QueryScorer 对象,它将根据查询条件来找到关键词的位置。 Highlighter 对象则使用这个评分器和格式器来实现高亮显示。

TokenStream 对象来自于分析器,它按照分词器的规则对文本进行分词处理。 getBestFragment 方法将会返回包含查询关键词的高亮片段。

通过这种方式,我们可以将文档中符合查询条件的关键词突出显示,从而提升用户的搜索体验。

在接下来的章节中,我们将继续深入探讨Lucene的更新和删除组件的功能性实践,以及如何通过手写实例来更好地理解和应用Lucene的各种功能。

6. 更新和删除组件的功能性实践

随着系统运行时间的增长,索引内容的更新和删除是维护索引健康和准确性的必要操作。Lucene 提供了灵活的机制来处理这些任务,我们将在本章深入探讨。

6.1 文档内容的更新策略

文档的更新操作在 Lucene 中并不直接修改现有文档,而是通过添加新文档并删除旧文档的方式来实现。这一行为需要精心设计的版本控制机制来确保数据的一致性。

6.1.1 更新机制和流程

Lucene 中的更新操作通常包含以下几个步骤:

- 检索旧文档 :首先,系统需要通过文档的唯一标识符(例如文档ID)来检索旧版本的文档。

- 删除旧文档 :根据检索到的文档信息,从索引中删除对应的旧文档条目。

- 添加新文档 :将新文档内容添加到索引中。

这里是一个简单示例来展示如何在 Lucene 中执行更新操作:

IndexReader reader = DirectoryReader.open(directory); // 打开索引读取器

IndexWriterConfig config = new IndexWriterConfig(analyzer); // 配置索引写入器

try (IndexWriter writer = new IndexWriter(directory, config)) {

// 检索并删除旧文档

String docID = "12345";

Document doc = ... // 根据ID检索文档逻辑

writer.deleteDocuments(new Term("id", docID));

// 添加新文档

writer.addDocument(doc);

}

reader.close(); // 关闭索引读取器

6.1.2 索引版本控制

Lucene 中的索引版本控制通常依赖于文档的版本号。每次更新操作时,都需要在文档中存储一个更高版本的数值,这样当检索旧文档时,可以匹配到版本较低的文档并将其删除。

6.2 索引的删除操作

删除操作是维护索引清晰度和准确性的重要手段。Lucene 提供了灵活的删除接口,支持删除指定文档和批量删除。

6.2.1 删除指定文档

删除指定文档的操作依赖于文档的唯一标识符,通常是文档ID。在 Lucene 中,删除操作非常简单:

IndexWriter writer = new IndexWriter(directory, config);

Term term = new Term("id", "指定的文档ID");

writer.deleteDocuments(term); // 执行删除操作

writer.close();

6.2.2 批量删除与索引清理

批量删除操作可以有效地删除一组文档,这在索引清理中非常有用,例如在信息归档后删除过时文档。

List<Term> termsToDelete = new ArrayList<>();

termsToDelete.add(new Term("id", "要删除的文档ID1"));

termsToDelete.add(new Term("id", "要删除的文档ID2"));

writer.deleteDocuments(termsToDelete.toArray(new Term[0])); // 批量删除

索引清理还涉及删除和合并操作,以确保索引的大小保持在合理范围内,同时通过合并操作来优化索引性能。

这些操作涉及到对索引文件的管理,通常由专门的后台服务来负责,以避免对正常搜索操作造成影响。

以上就是在更新和删除组件的功能性实践中的核心内容。在实际应用中,除了基本的操作外,还需要考虑错误处理、索引恢复机制以及性能优化等问题。在下一章节中,我们将通过具体的实例代码来演示如何在开发环境中搭建 Lucene 和进行实际的索引、查询等操作。

简介:Lucene 是一个高性能的全文搜索库,提供强大的 API 实现文本检索功能。它包含多个组件,如索引、查询解析、搜索、排序高亮和文档更新删除。本例展示了如何通过具体的步骤和代码示例手工实现 Lucene 索引的创建、文档索引、查询处理和搜索结果展示,从而帮助开发者理解和应用 Lucene 进行全文检索。

469

469

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?