Abstract

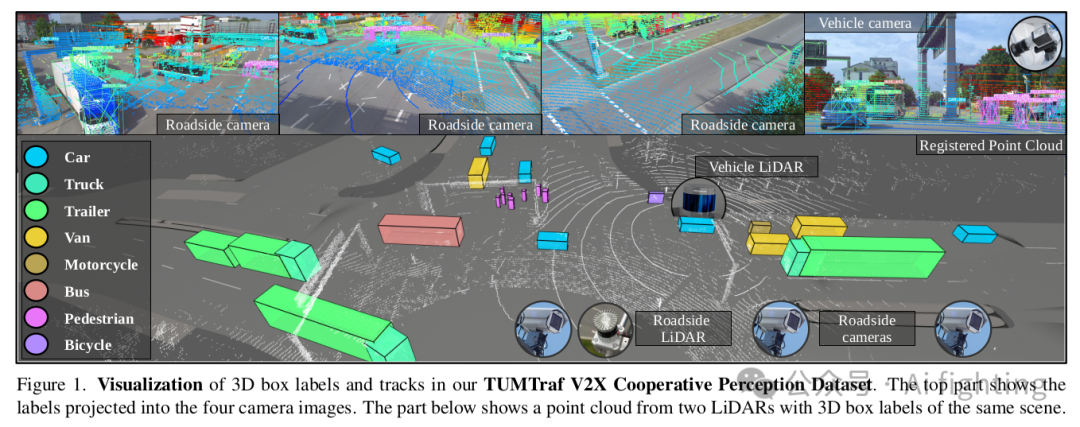

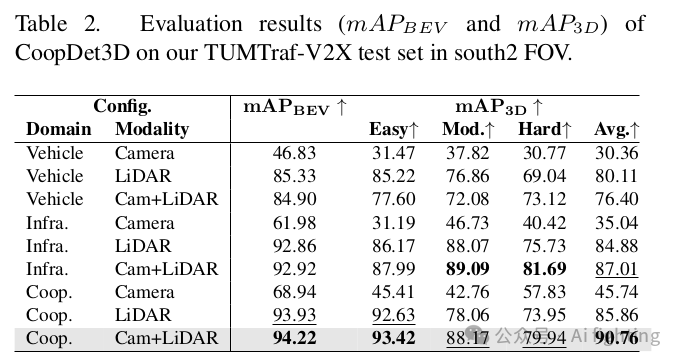

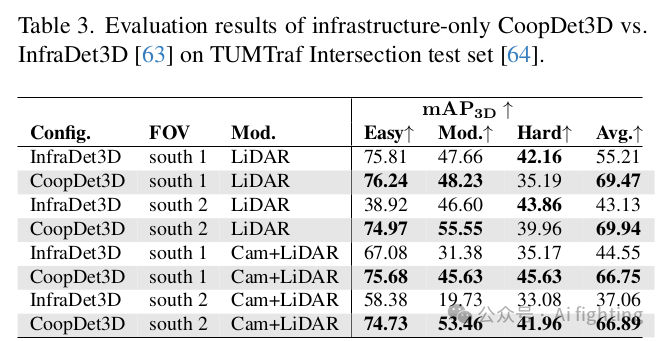

协同感知为增强自动驾驶车辆的能力和提高道路安全性提供了多种好处。除了车载传感器之外,使用路边传感器可以提高可靠性并扩大传感器范围。外部传感器为自动驾驶车辆提供更高的情境感知能力并防止遮挡。我们提出了CoopDet3D,这是一种协同多模态融合模型,以及TUMTraf-V2X,这是一个用于协同3D物体检测和跟踪任务的感知数据集。我们的数据集包含来自五个路边传感器和四个车载传感器的2,000个标注点云和5,000个标注图像。数据集中包含了30,000个带有跟踪ID的3D框以及精确的GPS和IMU数据。我们标注了八个类别,并涵盖了带有挑战性驾驶动作的遮挡场景,例如交通违规、险情事件、超车和掉头。通过多次实验,我们展示了我们的CoopDet3D相机-LiDAR融合模型相比于车辆相机-LiDAR融合模型提高了+14.36的3D mAP。最后,我们在我们的网站上公开了我们的数据集、模型、标注工具和开发套件。

代码地址:

https://tum-traffic-dataset.github.io/tumtraf-v2x/

Introduction

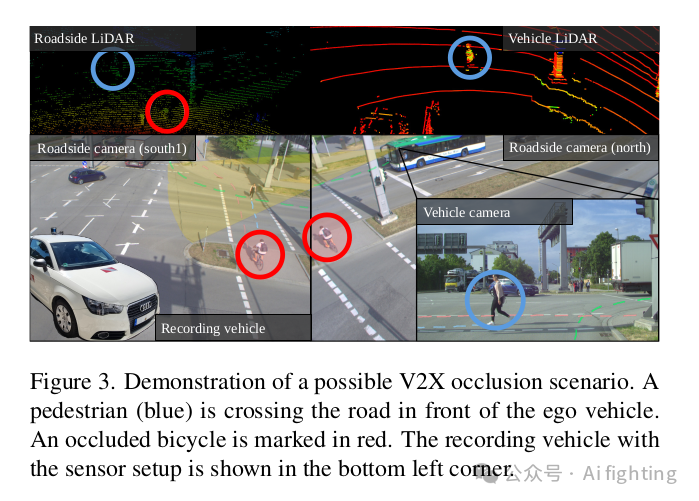

协同感知涉及车载传感器数据和路边传感器数据的融合,它在增强自动驾驶车辆的能力和提高道路安全性方面提供了多种优势。来自多个来源的数据使感知更具鲁棒性,能够应对传感器故障或恶劣环境条件。路边传感器提供的高视角有助于及早检测障碍物。此外,它们还对精确的车辆定位有帮助,并通过将部分感知任务转移到路边传感器上来减少自动驾驶车辆的计算负荷。路边传感器提供交通的全局视角,与车载传感器数据融合后可以提供全面的情境感知。由于协同感知能够交叉验证不同传感器的信息,因此误报或漏报的情况也减少了。

基础设施传感器可以通过V2X与车辆共享感知相关的信息。由于延迟极小并且具有实时能力,基于基础设施的感知系统可以进一步增强车辆的情境感知和决策过程。

TUMTraf-V2X Dataset

我们的TUMTraf V2X协同感知数据集专注于具有挑战性的交通场景以及各种日间和夜间场景。数据经过进一步标注,强调通过仔细标注和高质量审查过程来确保高质量标签。数据集包含密集交通和快速移动的车辆,揭示了协同感知中的具体挑战,例如姿态估计误差、延迟和同步问题。此外,我们提供了来自九个不同传感器的数据,这些传感器覆盖了相同的交通场景,涵盖各种天气条件和光照变化。基础设施传感器在交叉口的四个方向上布置,提供360°视野,从而获得更好的感知结果。最后,数据集中包含了罕见事件,例如行人违反交通规则,在四路繁忙的交叉口红灯亮起时穿越马路。

1、传感器组成

我们的TUMTraf V2X协同感知数据集是在一个具有九个传感器的智能交通系统上记录的。硬件设施传感器设置如下:

1个Ouster LiDAR OS1-64(第二代),64条垂直层,360°视场,地平线下方配置,10厘米精度@120米范围

4个Basler ace acA1920-50gc,相机分辨率为1920×1200,配备8毫米镜头的Sony IMX174 车载传感器设置如下:

1个Robosense RS-LiDAR-32,32条垂直层,360°视场,3厘米精度@200米范围

1个Basler ace acA1920-50gc,相机分辨率为1920×1200,配备16毫米镜头的Sony IMX174

1个Emlid Reach RS2+多频RTK GNSS接收器 1个XSENS MTi-30-2A8G4惯性测量单元(IMU)

2、传感器标定与对齐

我们在空间和时间域上同步相机和LiDAR。首先,我们使用棋盘格目标确定相机的内参(intrinsic parameters)以及径向和切向图像畸变。然后,通过在点云和相机图像中选择100对点,校准路边LiDAR与路边相机。外参(旋转和平移)通过最小化2D-3D点对应的重投影误差来计算。对于车载相机-LiDAR的校准,我们遵循相同的程序。最后,我们将车载LiDAR校准到路边LiDAR。这个空间配准首先通过估计粗略变换来完成。我们在每个点云中选择十对3D点,并使用最小二乘法最小化它们的距离。然后,我们应用点对点迭代最近点(ICP)算法来获得点云之间的精细变换。

在配准后,我们标注了车辆和基础设施的点云。粗略配准通过测量车载LiDAR和路边LiDAR的GPS位置完成。然后,我们将每第10个车载点云变换到基础设施点云的坐标系统。精细配准通过应用点对点ICP来获得准确的车对基础设施(V2I)变换矩阵。所有中间点云帧的旋转基于球面线性插值(SLERP)方法进行插值。

3、 数据选择和标注

我们基于具有挑战性的交通场景(如掉头、尾随事件和交通违规行为)选择数据。除了每帧31个物体的高交通密度外,我们还选择了高类别覆盖的帧。我们在晴天白天选择了700帧,在多云夜晚选择了100帧进行标注。相机和LiDAR数据分别以15 Hz和10 Hz的频率记录到rosbag文件中。我们基于ROS时间戳提取和同步数据,并使用我们的3D BAT(v24.3.2)标注工具对其进行标注。我们改进了3D BAT基线标注工具,通过一键标注功能更快、更精确地标注3D物体。标注人员在检查图像时被指导标注交通参与者。即使物体在图像中没有3D点,但在图像中可见,仍会被标注。极端部分(例如行人的四肢)包含在边界框内,但车辆的侧镜不包含在内。如果行人携带物体,该物体也包含在边界框内。如果两个或更多行人携带物体,则仅一个行人的边界框包含该物体。标注完成后,每个标注人员逐帧检查其他标注人员的工作。如果发现错误,会通知原标注人员并进行修正。这样可以确保我们的数据集标签具有高质量。

4、数据结构和格式

我们使用九个传感器从车辆和基础设施视角记录了八个不同场景,每个场景持续10秒。数据分为训练集(80%)、验证集(10%)和测试集(10%)。我们使用分层抽样将所有集合的对象类别均等分布(见图6a)。标签采用ASAM OpenLABEL标准。

5、数据集开发工具包 我们提供了一个开发工具包来使用我们的数据集。除了生成数据统计外,还提供多类别分层拆分(训练/验证/测试)、点云配准、加载OpenLABEL格式的标注、评估检测和跟踪结果、预处理步骤(如点云过滤)和后处理(如边界框过滤)模块。图4、图5和图6中的统计数据是使用我们的数据集开发工具包创建的。该工具包还包含将标签从OpenLABEL转换为KITTI或我们自定义的nuScenes格式(使用时间戳而非标记)及其逆转换的模块。此开发工具包使流行数据集的用户能够迁移其模型并使其与我们的数据集格式兼容。我们在MIT许可证下发布了开发工具包,并在Creative Commons(CC)BY-NC-ND 4.0许可证下发布了数据集。

Benchmark

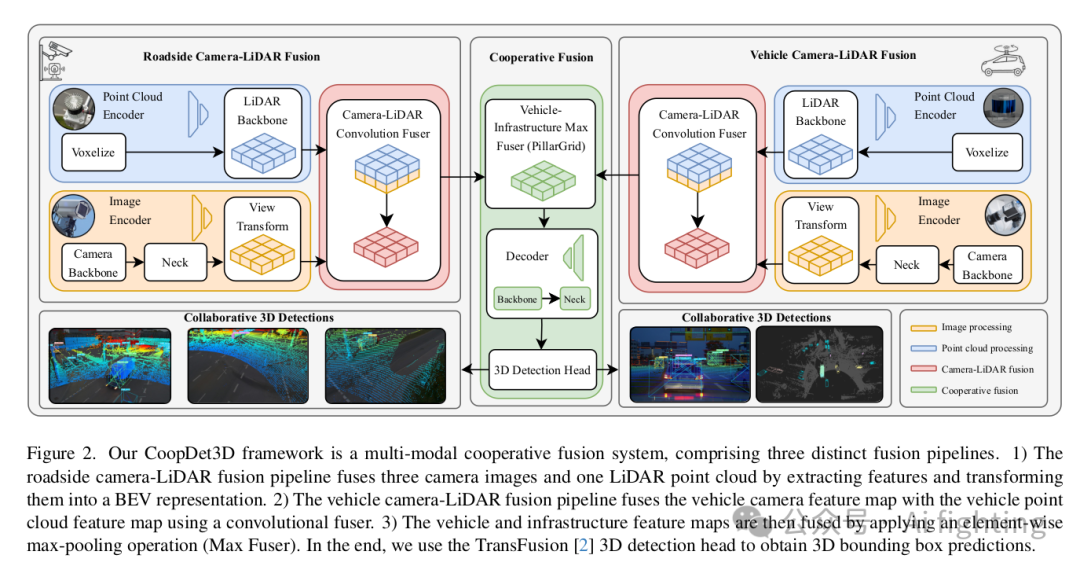

我们提出了CoopDet3D,这是BEVFusion和PillarGrid[的扩展,用于深度协同多模态3D目标检测,并在我们的数据集上进行了基准测试。

1、评估指标

准确性通过平均精度(mAP)来衡量。使用两种类型的mAP度量:BEV mAP考虑BEV中心距离,结果使用与BEVFusion相同的评估方法获得,该方法使用nuScenes的评估协议。同样,3D mAP度量考虑3D中的交集,结果使用我们的TUM Traffic数据集开发工具包的评估脚本获得。运行时间使用每秒帧数(FPS)作为指标,通过测量模型运行完整推理所需的时间,包括数据预处理和体素化。前五次迭代被跳过作为预热,因为它们通常比平均速度慢得多。最后,模型的复杂性通过训练和测试期间所有GPU上的最大VRAM使用量来衡量。

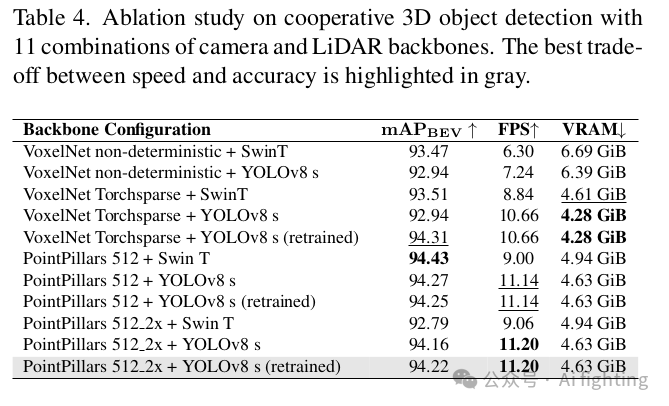

2、CoopDet3D模型

我们的CoopDet3D使用基于BEVFusion的主干网络在车辆和基础设施两侧分别进行相机-LiDAR融合,以获取车辆和基础设施特征。通过多次消融研究选择了最佳的图像和点云特征提取主干网络。然后,受到PillarGrid方法的启发,提出了元素级最大池化操作,将所得的融合相机-LiDAR特征融合在一起。最后,使用BEVFusion的检测头从融合特征中进行3D检测。CoopDet3D的架构如图2所示。

首先,我们禁用相机特征提取节点,并训练仅LiDAR模型20个周期。然后,使用预训练权重对协同模型进行微调,进一步训练8个周期。超参数调整显示BEVFusion[34]的默认超参数效果最好,因此未进行修改。预处理步骤也与BEVFusion相同,但我们将点云范围更改为x和y轴上的[−75, 75]和z轴上的[−8, 0],因为使用的数据集不同。此外,我们使用3台NVIDIA RTX 3090 GPU(24 GB VRAM)进行训练,并使用单台GPU进行评估。我们开源了我们的模型,并提供了预训练权重。

总结:

引用CVPR2024文章

TUMTraf V2X Cooperative Perception Dataset

欢迎关注我的公众号auto_driver_ai(Ai fighting), 第一时间获取更新内容。

TUMTraf V2X Cooperative Perception Dataset

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?