一 安装

二 简介

- 分布式&实时计算系统

- 一次初始化,持续计算,使用zeromq(netty)作为底层消息队列

三 架构

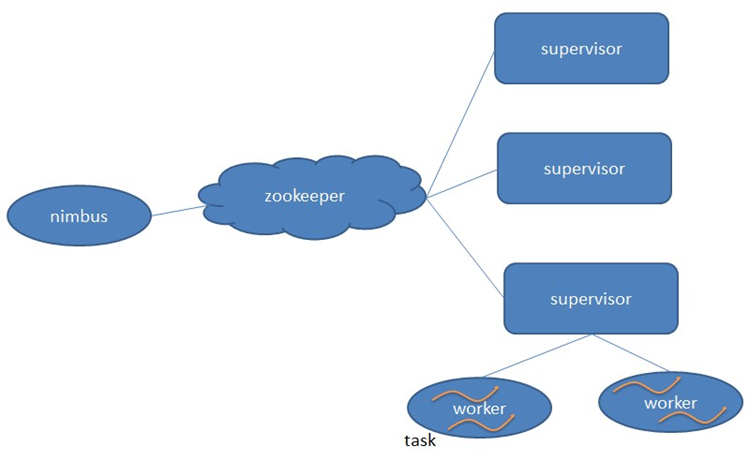

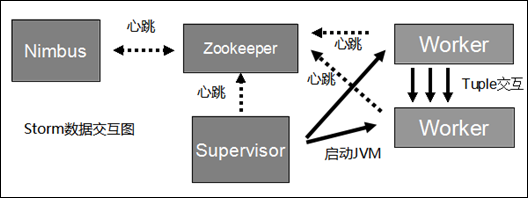

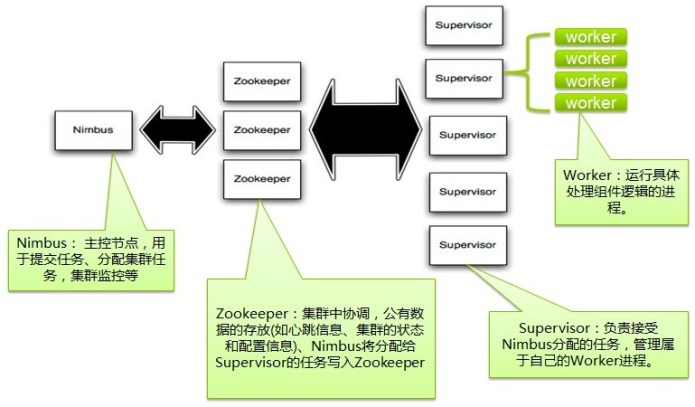

- Strom采用主从结构,由Nimbus和Supervisor组成,Nimbus进程运行在集群的主节点,负责任务的指派和分发,Supervisor运行在集群的从节点,负责执行任务的具体部分。

- Nimbus:负责资源分配和任务调度。

- Supervisor:负责接受nimbus分配的任务,启动和停止属于自己管理的worker进程。

- Worker:运行具体处理组件逻辑的进程,一个topology默认一个worker,一个节点上有多个worker。

- Task:worker中每一个spout/bolt的线程称为一个task,同一个spout/bolt的task可能会共享一个物理线程,该线程称为executor,可以在代码中增加spout/bolt并行度增加executor数目。

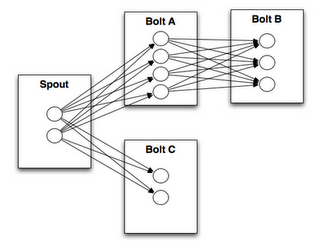

- Storm架构中使用Spout/Bolt编程模型来对消息进行流式处理。消息流是Storm中对数据的基本抽象,一个消息流是对一条输入数据的封装,源源不断输入的消息流以分布式的方式被处理,Spout组件是消息生产者,是Storm架构中的数据输入源头,它可以从多种异构数据源读取数据,并发射消息流,Bolt组件负责接收Spout组件发射的信息流,并完成具体的处理逻辑。在复杂的业务逻辑中可以串联多个Bolt组件,在每个Bolt组件中编写各自不同的功能,从而实现整体的处理逻辑

- Zookeeper作用:nimbus通过在zookeeper上写状态信息来分配任务。通俗的讲就是写哪些supervisor执行哪些task的对应关系。而supervisor则通过从zookeeper上读取这些状态信息,来领取任务。supervisor、task会发送心跳到zookeeper,使得nimbus可以监控整个集群的状态,从而在task执行失败时,可以重启他们。

四 Storm与Hadoop对比

| 结构 | Hadoop | Storm |

|---|---|---|

| 主节点 | JobTracker | Nimbus |

| 从节点 | TaskTracker | Supervisor |

| 应用程序 | Job | Topology |

| 工作进程名称 | Child | Worker |

| 计算模型 | Map / Reduce | Spout / Bolt |

在Hadoop架构中,应用程序Job代表着这样的作业:输入是确定的,作业可以在有限时间内完成,当作业完成时Job的生命周期走到终点,输出确定的计算结果;而在Storm架构中,Topology代表的并不是确定的作业,而是持续的计算过程,在确定的业务逻辑处理框架下,输入数据源源不断地进入系统,经过流式处理后以较低的延迟产生输出。如果不主动结束这个Topology或者关闭Storm集群,那么数据处理的过程就会持续地进行下去。

storm架构是如何解决Hadoop架构瓶颈的:

- Storm的Topology只需初始化一次。在将Topology提交到Storm集群的时候,集群会针对该Topology做一次初始化的工作,此后,在Topology运行过程中,对于输入数据而言,是没有计算框架初始化耗时的,有效避免了计算框架初始化的时间损耗。

- Storm使用Netty作为底层的消息队列来传递消息,保证消息能够得到快速的处理,同时Storm采用内存计算模式,无需借助文件存储,直接通过网络直传中间计算结果,避免了组件之间传输数据的大量时间损耗。

总结一下,有以下优点:

- 简单编程,在大数据处理方面相信大家对hadoop已经耳熟能详,基于Google Map/Reduce来实现的Hadoop为开发者提供了map/reduce原语,使并行批处理程序变得非常地简单和优美。同样,Storm也为大数据的实时计算提供了一些简单优美的原语,这大大降低了开发并行实时处理的任务的复杂性,帮助你快速、高效的开发应用。

- 多语言支持,除了用java实现spout和bolt,你还可以使用任何你熟悉的编程语言来完成这项工作,这一切得益于Storm所谓的多语言协议。多语言协议是Storm内部的一种特殊协议,允许spout或者bolt使用标准输入和标准输出来进行消息传递,传递的消息为单行文本或者是json编码的多行。

- 支持水平扩展,在Storm集群中真正运行topology的主要有三个实体:工作进程、线程和任务。Storm集群中的每台机器上都可以运行多个工作进程,每个工作进程又可创建多个线程,每个线程可以执行多个任务,任务是真正进行数据处理的实体,我们开发的spout、bolt就是作为一个或者多个任务的方式执行的。因此,计算任务在多个线程,进程和服务器之间并行进行,支持灵活的水平扩展。

- 容错性强,如果在消息处理过程中出了一些异常,Storm会重新安排这个出问题的处理单元,Storm保证一个处理单元永远运行(除非你显式杀掉这个处理单元)。

- 可靠性的消息保证,Storm可以保证spout发出的每条消息都能被“完全处理”。

- 快速的消息处理,用Netty作为底层消息队列, 保证消息能快速被处理。

- 本地模式,支持快速编程测试。

五 一些概念

1 Topology:一个实时计算任务被称作为Topology,包含Spout和Bolt

2 Tuple:数据模型,代表处理单元,可以包含多个Field,K/V的Map。

3 Worker:一个topology可能会在一个或者多个worker(工作进程)里面执行,每个worker是一个物理JVM并且执行整个topology的一部分。比如,对于并行度是300的topology来说,如果我们使用50个工作进程worker来执行,那么每个工作进程会处理其中的6个tasks。Storm会尽量均匀的工作分配给所有的worker,setBolt 的最后一个参数是你想为bolts的并行量。

4 Spouts

消息源spout是Storm里面一个topology里面的消息生产者。一般来说消息源会从一个外部源读取数据并且向topology里面发出消息:tuple。Spout可以是可靠的也可以是不可靠的,如果这个tuple没有被storm成功处理,可靠的消息源spouts可以重新发射一个tuple,但是不可靠的消息源spouts一旦发出一个tuple就不能重发了。

-

消息源可以发射多条消息流stream。使用OutputFieldsDeclarer。declareStream来定义多个stream,然后使用SpoutOutputCollector来发射指定的stream。代码上是这样的:collector.emit(new Values(str));

-

Spout类里面最重要的方法是nextTuple。要么发射一个新的tuple到topology里面或者简单的返回如果已经没有新的tuple。要注意的是nextTuple方法不能阻塞,因为storm在同一个线程上面调用所有消息源spout的方法。另外两个比较重要的spout方法是ack和fail。storm在检测到一个tuple被整个topology成功处理的时候调用ack,否则调用fail。storm只对可靠的spout调用ack和fail。

5 Bolts

-

所有的消息处理逻辑被封装在bolts里面。Bolts可以做很多事情:过滤,聚合,查询数据库等等。

-

Bolts可以简单的做消息流的传递(来一个元组,调用一次execute)。复杂的消息流处理往往需要很多步骤,从而也就需要经过很多bolts。比如算出一堆图片里面被转发最多的图片就至少需要两步:第一步算出每个图片的转发数量,第二步找出转发最多的前10个图片。(如果要把这个过程做得更具有扩展性那么可能需要更多的步骤)。

-

Bolts可以发射多条消息流, 使用OutputFieldsDeclarer.declareStream定义stream,使用OutputCollector.emit来选择要发射的stream。

-

Bolts的主要方法是execute,它以一个tuple作为输入,bolts使用OutputCollector来发射tuple(spout使用SpoutOutputCollector来发射指定的stream),bolts必须要为它处理的每一个tuple调用OutputCollector的ack方法,以通知Storm这个tuple被处理完成了,从而通知这个tuple的发射者spouts。一般的流程是: bolts处理一个输入tuple, 发射0个或者多个tuple, 然后调用ack通知storm自己已经处理过这个tuple了。storm提供了一个IBasicBolt会自动调用ack。

6 Reliability

- Storm保证每个tuple会被topology完整的执行。Storm会追踪由每个spout tuple所产生的tuple树(一个bolt处理一个tuple之后可能会发射别的tuple从而形成树状结构),并且跟踪这棵tuple树什么时候成功处理完。每个topology都有一个消息超时的设置,如果storm在这个超时的时间内检测不到某个tuple树到底有没有执行成功,那么topology会把这个tuple标记为执行失败,并且过一会儿重新发射这个tuple(超时的时间在storm0.9.0.1版本中是可以设置的,默认是30s)。

7 数据流模型

- Topology中每一个计算组件(Spout和Bolt)都有一个并行执行度,在创建Topology时可以进行指定,Storm会在集群内分配对应并行度个数的线程来同时执行这一组件。那么,有一个问题:既然对于一个Spout或Bolt,都会有多个task线程来运行,那么如何在两个组件(Spout和Bolt)之间发送tuple元组呢?Storm提供了若干种数据流分发(Stream Grouping)策略用来解决这一问题。在Topology定义时,需要为每个Bolt指定接收什么样的Stream作为其输入(注:Spout并不需要接收Stream,只会发射Stream)。目前Storm中提供了以下7种Stream Grouping策略:Shuffle Grouping、Fields Grouping、All Grouping、Global Grouping、Non Grouping、Direct Grouping、Local or shuffle grouping。

8 Storm里面有7种类型的stream grouping

- Shuffle Grouping: 随机分组, 随机派发stream里面的tuple,保证每个bolt接收到的tuple数目大致相同。

- Fields Grouping:按字段分组,比如按userid来分组,具有同样userid的tuple会被分到相同的Bolts里的一个task。而不同的userid则会被分配到不同的bolts里的task。

- All Grouping:广播发送,对于每一个tuple,所有的bolts都会收到。

- Global Grouping:全局分组, 这个tuple被分配到storm中的一个bolt的其中一个task,再具体一点就是分配给id值最低的那个task。

- Non Grouping:不分组,这个分组的意思是说stream不关心到底谁会收到它的tuple。目前这种分组和Shuffle grouping是一样的效果。有一点不同的是storm会把这个bolt放到这个bolt的订阅者同一个线程里面去执行。

- Direct Grouping: 直接分组, 这是一种比较特别的分组方法,用这种分组意味着消息的发送者指定由消息接收者的哪个task处理这个消息。只有被声明为Direct Stream的消息流可以声明这种分组方法。而且这种消息tuple必须使用emitDirect方法来发射。消息处理者可以通过TopologyContext来获取处理它的消息的task的id (OutputCollector.emit方法也会返回task的id)。

- Local or shuffle grouping:如果目标bolt有一个或者多个task在同一个工作进程worker中,tuple将会被随机发生给这些tasks。否则,和普通的Shuffle Grouping行为一致。

9 记录级容错

-

相比于s4, puma等其他实时计算系统,storm最大的亮点在于其记录级容错和能够保证消息精确处理的事务功能,下面就重点来看一下这两个亮点的实现原理。

-

Storm记录级容错的基本原理。首先来看一下什么叫做记录级容错?storm允许用户在spout中发射一个新的源tuple时为其指定一个message id,这个message id可以是任意的object对象。多个源tuple可以共用一个message id,表示这多个源 tuple对用户来说是同一个消息单元。storm中记录级容错的意思是说,storm会告知用户每一个消息单元是否在指定时间内被完全处理了。那什么叫做完全处理呢,就是该message id绑定的源tuple及由该源tuple后续生成的tuple经过了topology中每一个应该到达的bolt的处理。

10 Storm的事务拓扑

对操作有严格要求

六 一个例子

package com.ding.storm;

import org.apache.storm.Config;

import org.apache.storm.LocalCluster;

import org.apache.storm.StormSubmitter;

import org.apache.storm.spout.SpoutOutputCollector;

import org.apache.storm.task.TopologyContext;

import org.apache.storm.topology.BasicOutputCollector;

import org.apache.storm.topology.OutputFieldsDeclarer;

import org.apache.storm.topology.TopologyBuilder;

import org.apache.storm.topology.base.BaseBasicBolt;

import org.apache.storm.topology.base.BaseRichSpout;

import org.apache.storm.tuple.Fields;

import org.apache.storm.tuple.Tuple;

import org.apache.storm.tuple.Values;

import org.apache.storm.utils.Utils;

import java.util.HashMap;

import java.util.Map;

import java.util.Random;

import java.util.StringTokenizer;

import java.util.concurrent.atomic.AtomicInteger;

/**

* Created by Ding on 2018/1/22.

*/

public class WordCountTopolopgyAllInJava {

// 定义一个喷头,用于产生数据。该类继承自BaseRichSpout

public static class RandomSentenceSpout extends BaseRichSpout {

SpoutOutputCollector _collector;

Random _rand;

private AtomicInteger counter;

public void open(Map conf, TopologyContext context, SpoutOutputCollector collector){

_collector = collector;

_rand = new Random();

counter = new AtomicInteger();

}

public void nextTuple(){

// 睡眠一段时间后再产生一个数据

Utils.sleep(100);

// 句子数组

String[] sentences = new String[]{ "the cow jumped over the moon", "an apple a day keeps the doctor away",

"four score and seven years ago", "snow white and the seven dwarfs", "i am at two with nature" };

// 随机选择一个句子

String sentence = sentences[_rand.nextInt(sentences.length)];

// 发射该句子给Bolt

_collector.emit(new Values(sentence),this.counter.getAndIncrement());//发送加id才能反馈ack

}

// 确认函数

@Override

public void ack(Object id){

System.out.println("success! id: "+id.toString());

}

// 处理失败的时候调用

@Override

public void fail(Object id){

}

public void declareOutputFields(OutputFieldsDeclarer declarer){

// 定义一个字段word

declarer.declare(new Fields("word"));

}

}

// 定义个Bolt,用于将句子切分为单词

public static class SplitSentence extends BaseBasicBolt {

public void execute(Tuple tuple, BasicOutputCollector collector){

// 接收到一个句子

String sentence = tuple.getString(0);

// 把句子切割为单词

StringTokenizer iter = new StringTokenizer(sentence);

// 发送每一个单词

while(iter.hasMoreElements()){

collector.emit(new Values(iter.nextToken()));

}

}

public void declareOutputFields(OutputFieldsDeclarer declarer){

// 定义一个字段

declarer.declare(new Fields("word"));

}

}

// 定义一个Bolt,用于单词计数

public static class WordCount extends BaseBasicBolt {

Map<String, Integer> counts = new HashMap<String, Integer>();

public void execute(Tuple tuple, BasicOutputCollector collector){

// 接收一个单词

String word = tuple.getString(0);

// 获取该单词对应的计数

Integer count = counts.get(word);

if(count == null)

count = 0;

// 计数增加

count++;

// 将单词和对应的计数加入map中

counts.put(word,count);

System.out.println("hello word!");

System.out.println(word +" "+count);

// 发送单词和计数(分别对应字段word和count)

collector.emit(new Values(word, count));

}

public void declareOutputFields(OutputFieldsDeclarer declarer){

// 定义两个字段word和count

declarer.declare(new Fields("word","count"));

}

}

public static void main(String[] args) throws Exception

{

// 创建一个拓扑

TopologyBuilder builder = new TopologyBuilder();

// 设置Spout,这个Spout的名字叫做"Spout",设置并行度为5,增加executor线程数目

builder.setSpout("spout", new RandomSentenceSpout(), 5);

// 设置slot——“split”,并行度为8,它的数据来源是spout的

builder.setBolt("split", new SplitSentence(), 8).shuffleGrouping("spout");

// 设置slot——“count”,你并行度为12,它的数据来源是split的word字段

builder.setBolt("count", new WordCount(), 12).fieldsGrouping("split", new Fields("word"));

Config conf = new Config();

conf.setDebug(false);

conf.setMaxTaskParallelism(20);//topology 最大并行度

if (args != null && args.length > 0) {

//集群运行

StormSubmitter.submitTopology(args[0],conf,builder.createTopology());

} else {

//本地运行

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("word-count", conf, builder.createTopology());

Thread.sleep(10000);

}

}

}

七 与SparkStreaming对比

Spark Streaming位于Spark生态技术栈中,因此Spark Streaming可以和Spark Core、Spark SQL无缝整合,也就意味着,我们可以对实时处理出来的中间数据,立即在程序中无缝进行延迟批处理、交互式查询等操作。这个特点大大增强了Spark Streaming的优势和功能。

除此之外Spark Streaming无明显优势,如何使用要结合具体业务场景。

1065

1065

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?