keepalived介绍

- 在这里使用keepalived来实现高可用集群,因为heartbeat在centos6上有一些问题,影响实验效果

- heartbeat 切换的时候,会不是很及时——>比如:主 已经宕机了,但 从 却一直启动不了,通信会不顺畅,所以不使用 heartbeat

- keepalived通过VRRP(Virtual Router Redundancy Protocl 中文为:虚拟路由冗余协议)来实现高可用。

- 虚拟路由冗余协议(Virtual Router Redundancy Protocol,简称VRRP)是由IETF提出的解决局域网中配置静态网关出现单点失效现象的路由协议,1998年已推出正式的RFC2338协议标准。VRRP广泛应用在边缘网络中,它的设计目标是支持特定情况下IP数据流量失败转移不会引起混乱,允许主机使用单路由器,以及及时在实际第一跳路由器使用失败的情形下仍能够维护路由器间的连通性。

- 在这个协议里,会将多台功能相同的路由器组成一个小组,这个小组里会有1个master角色和N(N>=1)个backup角色。

- master会通过组播的形式向各个backup发送VRRP协议的数据包,当backup收不到master发来的VRRP数据包时,就会认为master宕机了。此时就需要根据各个backup的优先级来决定谁成为新的mater。

- Keepalived要有三个模块,分别是core、check和vrrp。其中core模块为keepalived的核心,负责主进程的启动、维护以及全局配置文件的加载和解析,check模块负责健康检查,vrrp模块是来实现VRRP协议的。

用keepalived配置高可用集群

-

准备两台机器130和132,130作为master,132作为backup

-

两台机器都执行yum install -y keepalived

-

两台机器都安装nginx,其中130上已经编译安装过nginx,132上需要yum安装nginx: yum install -y nginx

-

设定vip为100

-

编辑130上keepalived配置文件,内容获取地址

-

130编辑监控脚本,内容获取地址https://coding.net/u/aminglinux/p/aminglinux-book/git/blob/master/D21Z/master_keepalived.conf

-

给脚本755权限

-

systemctl start keepalived 130启动服务

-

132上编辑配置文件,内容获取地址

-

132上编辑监控脚本,内容获取地址

-

给脚本755权限

-

132上也启动服务 systemctl start keepalived

keepalived配置高可用集群

1.首先准备两台机器,都安装keepalived

- keepalived,实际是包含一个服务的,也就是说这个服务用来实现高可用

A机器,安装keepalived

[root@xuexi-001 ~]# yum install -y keepalived

B机器,安装keepalived

[root@localhost ~]# yum install -y keepalived

2.这里使用 nginx ,把它作为一个高可用的对象——>使用nginx作为演示对象的原因,因为nginx在工作中,在生产环境中,很多企业把nginx做一个负载均衡器

- 假设nginx一旦挂掉,那么后端所有的web,即使说是正常的,那也无法访问到

3.若是A、B机器没有装nginx服务,可以直接 yum安装

- 若是lnmp安装过nginx,则不需要安装了(源码包安装的nginx)

- 直接yum安装的nginx,两者很容易区分(PS:有时直接yum安装不了,需要安装yum扩展源——>yum install -y epel-release)

- 源码包安装nginx

- 源码安装nginx经常出现的错误

- A机器源码安装nginx (PS:有时初始化的时候,会看到无法初始化,是因为缺少一些包yum install -y gcc)

B机器yum安装nginx

[root@localhost ~]# yum install -y epel-release

[root@localhost ~]# yum install -y nginx

[root@localhost ~]# systemctl start nginx

[root@localhost ~]# ps aux | grep nginx

root 1410 0.0 0.2 120752 2096 ? Ss 22:26 0:00 nginx: master process /usr/sbin/nginx

nginx 1411 0.0 0.3 121136 3124 ? S 22:26 0:00 nginx: worker process

root 1413 0.0 0.0 112676 984 pts/0 R+ 22:27 0:00 grep --color=auto nginx

4.更改keepalived配置文件了,内容地址

- 默认的配置文件路径在/etc/keepalived/keepalived.conf

- 清空文件的快捷键方法 > !$

A机器更改配置文件

[root@xuexi-001 ~]# ls /etc/keepalived/keepalived.conf

/etc/keepalived/keepalived.conf

[root@xuexi-001 ~]# > !$ //直接清空文件内容了

> /etc/keepalived/keepalived.conf

[root@xuexi-001 ~]# cat /etc/keepalived/keepalived.conf

[root@xuexi-001 ~]# vim /etc/keepalived/keepalived.conf //去文件地址去下载内容

将拷贝的内容复制进去

只需要改网卡名字和飘逸IP为192.168.133.100

-----------------全局配置 ------------------

global_defs { //global_defs 全局配置标识

notification_email { //notification_email用于设置报警邮件地址

xuexi1@163.com //可以设置多个,每行一个

}

notification_email_from xuexi1@163.com //设置邮件发送地址

smtp_server 127.0.0.1 //设置邮件的smtp server地址

smtp_connect_timeout 30 //设置连接smtp sever超时时间

router_id LVS_DEVEL

}

---------------------------- VRRP配置 ---------------------------------------

vrrp_script chk_nginx {

script "/usr/local/sbin/check_ng.sh" //检查服务是否正常,通过写脚本实现,脚本检查服务健康状态

interval 3 //检查的时间间断是3秒

}

vrrp_instance VI_1 { //VRRP配置标识 VI_1是实例名称

state MASTER //定义master相关

interface ens33 //通过vrrp协议去通信、去发广播。配置时,需注意自己的网卡名称

virtual_router_id 51 //定义路由器ID ,配置的时候和从机器一致

priority 100 //权重,主角色和从角色的权重是不同的

advert_int 1 //设定MASTER与BACKUP主机质检同步检查的时间间隔,单位为秒

authentication { //认证相关信息

auth_type PASS //这里认证的类型是PASS

auth_pass aminglinux>com //密码的形式是一个字符串

}

virtual_ipaddress { //设置虚拟IP地址 (VIP),又叫做漂移IP地址

192.168.5.100 //更改为192.168.5.100

}

track_script { //加载脚本

chk_nginx

}

}

保存退出

- virtual_ipaddress:简称VIP,这个vip,两台机器,一个主,一个从,正常的情况是主在服务,主宕掉了,从起来了,从启动服务,从启动nginx以后,,启动以后,访问那个IP呢?把域名解析到那个IP上呢?假如解析到主上,主宕掉了,所以这个,需要定义一个公有IP(主上用的IP,从上也用的IP);这个IP是随时可以夏掉,去配置的

5.定义监控脚本,脚本内容获取地址https://coding.net/u/aminglinux/p/aminglinux-book/git/blob/master/D21Z/master_check_ng.sh

- 脚本路径在keepalived配置文件中有定义,路径为/usr/local/sbin/check_ng.sh

A机器定义监控脚本

[root@xuexi-001 ~]# vi /usr/local/sbin/check_ng.sh

#!/bin/bash

#时间变量,用于记录日志

d=`date --date today +%Y%m%d_%H:%M:%S`

#计算nginx进程数量

n=`ps -C nginx --no-heading|wc -l`

#如果进程为0,则启动nginx,并且再次检测nginx进程数量,

#如果还为0,说明nginx无法启动,此时需要关闭keepalived

if [ $n -eq "0" ]; then

/etc/init.d/nginx start

n2=`ps -C nginx --no-heading|wc -l`

if [ $n2 -eq "0" ]; then

echo "$d nginx down,keepalived will stop" >> /var/log/check_ng.log

systemctl stop keepalived

fi

fi

保存退出

- “脑裂”,在高可用(HA)系统中,当联系2个节点的“心跳线”断开时,本来为一整体、动作协调的HA系统,就分裂成为2个独立的个体。由于相互失去了联系,都以为是对方出了故障。两个节点上的HA软件像“裂脑人”一样,争抢“共享资源”、争起“应用服务”,就会发生严重后果——或者共享资源被瓜分、2边“服务”都起不来了;或者2边“服务”都起来了,但同时读写“共享存储”,导致数据损坏

- 如何判断脑裂?

- 分别在两台机查看当前服务器是否拥有虚拟IP,如果两台服务器都拥有,则说明发生了脑裂,证明目前双机通信出现问题,产生此问题的原有在于 两台服务器都探测不到组内其他服务器的状态(心跳请求无法正常响应),私自判定另一台服务器挂起,则抢占虚拟IP,脑裂的出现是不被允许的,解决此问题的方法为检查防火墙设置(关闭防火墙)或者使用串口通信。

6.脚本创建完之后,还需要改变脚本的权限(不更改权限,就无法自动加载脚本,那就无法启动keepalived服务)

[root@xuexi-001 ~]# chmod 755 /usr/local/sbin/check_ng.sh

7.启动keepalived服务,并查看是否启动成功(PS:启动不成功,有可能是防火墙未关闭或者规则限制导致的)

- systemctl stop firewalld 关闭firewalld

- iptables -nvL

- setenforce 0 临时关闭selinux

- getenforce命令查看是否为Permissive

- 这时再来启动keepalived,就会看到keepalived进程服务了

[root@xuexi-001 ~]# systemctl start keepalived

[root@xuexi-001 ~]# ps aux | grep keepalived

root 2276 0.0 0.0 118652 1396 ? Ss 23:11 0:00 /usr/sbin/keepalived -D

root 2277 0.0 0.1 127516 3304 ? S 23:11 0:00 /usr/sbin/keepalived -D

root 2278 0.0 0.1 127456 2840 ? S 23:11 0:00 /usr/sbin/keepalived -D

root 2303 0.0 0.0 112720 976 pts/0 R+ 23:11 0:00 grep --color=auto keepalived

8.查看nginx服务进程

[root@xuexi-001 ~]# ps aux |grep nginx

root 1035 0.0 0.0 46040 1292 ? Ss 20:14 0:00 nginx: master process /usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf

nobody 1041 0.0 0.2 48576 4188 ? S 20:14 0:00 nginx: worker process

nobody 1042 0.0 0.2 48576 3928 ? S 20:14 0:00 nginx: worker process

root 2389 0.0 0.0 112720 968 pts/0 R+ 23:12 0:00 grep --color=auto nginx

9.这时停止nginx服务

- /etc/init.d/nginx stop

[root@xuexi-001 ~]# /etc/init.d/nginx stop

Stopping nginx (via systemctl): [ 确定 ]

10.再来查看nginx服务进程,会看到自动加载了

[root@xuexi-001 ~]# ps aux |grep nginx

root 2478 0.0 0.0 46040 1292 ? Ss 23:12 0:00 nginx: master process /usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf

nobody 2480 0.0 0.2 48576 4192 ? S 23:12 0:00 nginx: worker process

nobody 2481 0.0 0.2 48576 3928 ? S 23:12 0:00 nginx: worker process

root 2515 0.0 0.0 112720 972 pts/0 R+ 23:12 0:00 grep --color=auto nginx

11.keepalived日志文件路径

- /var/log/messages

12.查看ip地址,使用 ip add 命令,而不能使用ifconfig命令,因为 ifconfig命令 是无法查看到vip192.168.5.100这个IP的

[root@xuexi-001 ~]# ip add

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:bf brd ff:ff:ff:ff:ff:ff

inet 192.168.5.130/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.100/32 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.150/24 brd 192.168.5.255 scope global secondary ens33:0

valid_lft forever preferred_lft forever

inet6 fe80::9625:3e1d:12c7:4fe6/64 scope link

valid_lft forever preferred_lft forever

3: ens37: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:c9 brd ff:ff:ff:ff:ff:ff

13.检查A、B 机器下防火墙和selinux是否关闭了,若没有关闭,可能会导致实验失败

- systemctl stop firewalld 关闭firewalld

- iptables -nvL

- setenforce 0 临时关闭selinux

- getenforce命令查看是否为Permissive

以上就是主机器A的配置

backup 机器配置

1.在B机器yum安装nginx和keepalived

[root@hf-01 ~]# yum install -y epel-release

[root@hf-01 ~]# yum install -y nginx

2.关闭B机器的防火墙和selinux

- iptables -F 清空规则

- setenforce 0 临时关闭selinux

3.自定义B机器keepalived配置文件,内容获取地址,更改虚拟IP和主一样的 https://coding.net/u/aminglinux/p/aminglinux-book/git/blob/master/D21Z/backup_keepalived.conf

首先清空B机器keepalived里面自带的配置文件

[root@localhost ~]# > /etc/keepalived/keepalived.conf

然后复制配置文件并粘贴进去,更改虚拟IP和主一样的

[root@localhost ~]# vi !$

vi /etc/keepalived/keepalived.conf

global_defs {

notification_email {

aming@aminglinux.com

}

notification_email_from root@aminglinux.com

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_script chk_nginx {

script "/usr/local/sbin/check_ng.sh"

interval 3

}

vrrp_instance VI_1 {

state BACKUP //这里 和master不一样的名字

interface ens33 //网卡和当前机器一致,否则无法启动keepalived服务

virtual_router_id 51 //和主机器 保持一致

priority 90 //权重,要比主机器小的数值

advert_int 1

authentication {

auth_type PASS

auth_pass aminglinux>com

}

virtual_ipaddress {

192.168.5.100 //这里更改为192.168.5.100

}

track_script {

chk_nginx

}

}

保存退出

4.定义监控脚本,路径再keepalived里面已定义过,脚本内容地址 https://coding.net/u/aminglinux/p/aminglinux-book/git/blob/master/D21Z/backup_check_ng.sh

- 这个脚本和主上的脚本有一点区别,启动nginx的命令不同,因为一个是yum安装,一个是源码包安装

[root@localhost ~]# vi /usr/local/sbin/check_ng.sh

#时间变量,用于记录日志

d=`date --date today +%Y%m%d_%H:%M:%S`

#计算nginx进程数量

n=`ps -C nginx --no-heading|wc -l`

#如果进程为0,则启动nginx,并且再次检测nginx进程数量,

#如果还为0,说明nginx无法启动,此时需要关闭keepalived

if [ $n -eq "0" ]; then

systemctl start nginx

n2=`ps -C nginx --no-heading|wc -l`

if [ $n2 -eq "0" ]; then

echo "$d nginx down,keepalived will stop" >> /var/log/check_ng.log systemctl stop keepalived

fi

fi

保存退出

5.改动脚本的权限,设置为755权限

[root@localhost ~]# chmod 755 /usr/local/sbin/check_ng.sh

6.B机器启动keepalived服务

- systemctl start keepalived

[root@localhost ~]# systemctl start keepalived

[root@localhost ~]# ps aux |grep keepalived

root 1499 0.0 0.1 118608 1388 ? Ss 23:27 0:00 /usr/sbin/keepalived -D

root 1500 0.0 0.3 120732 3112 ? S 23:27 0:00 /usr/sbin/keepalived -D

root 1501 0.0 0.2 120732 2532 ? S 23:27 0:00 /usr/sbin/keepalived -D

root 1538 0.0 0.0 112676 984 pts/0 R+ 23:27 0:00 grep --color=auto keepalived

如何区分主和从上的nginx?

A机器,是源码包安装的nginx(PS:这是lnmp配置好的环境虚拟主机内容)

[root@xuexi-001 ~]# cat /usr/local/nginx/conf/vhost/

aaa.com.conf proxy.conf test.com.conf

load.conf ssl.conf

[root@xuexi-001 ~]# cat /usr/local/nginx/conf/vhost/aaa.com.conf

server

{

listen 80 default_server;

server_name aaa.com

index index.html index.htm index.php;

root /data/wwwroot/default;

location ~ \.php$

{

include fastcgi_params;

fastcgi_pass unix:/tmp/aming.sock;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME /data/wwwroot/default$fastcgi_script_name;

}

}

[root@xuexi-001 ~]# cat /data/wwwroot/default/index.html

master This is the default site.

- B机器是yum安装的nginx

- 默认的索引页在 /usr/share/nginx/html/index.html

[root@localhost ~]# vi /usr/share/nginx/html/index.html

backup.backup

- 访问192.168.5.100这个VIP会看到和主机器(即A机器相同的内容),说明现在访问到的是机器master,VIP在master上

问题-B机器无法调用nginx服务?

- B机器关闭nginx服务,keepalived无法拉动nginx服务起来

- 解决方法:

- 再次设置755权限,就可以拉动nginx服务了

测试高可用

1.模拟线上生产环境,主机器宕机环境,最简单直接的方法,就是直接关闭keepalived服务

2.关闭master机器(即A机器)上的keepalived服务关闭

[root@xuexi-001 ~]# systemctl stop keepalived

3.查看A机器上的VIP被已经释放掉了

[root@xuexi-001 ~]# ip add

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:bf brd ff:ff:ff:ff:ff:ff

inet 192.168.5.130/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.150/24 brd 192.168.5.255 scope global secondary ens33:0

valid_lft forever preferred_lft forever

inet6 fe80::9625:3e1d:12c7:4fe6/64 scope link

valid_lft forever preferred_lft forever

3: ens37: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:c9 brd ff:ff:ff:ff:ff:ff

4.查看backup机器(即B机器)在监听VIP

[root@localhost ~]# ip add

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:36:a3:32 brd ff:ff:ff:ff:ff:ff

inet 192.168.5.133/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.100/32 scope global ens33

valid_lft forever preferred_lft forever

inet6 fe80::cf14:5db2:1b49:f0c2/64 scope link

valid_lft forever preferred_lft forever

5.查看B机器日志

[root@localhost ~]# tail /var/log/messages

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) Sending/queueing gratuitous ARPs on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

6.浏览器访问vip,会看到已经变成backup机器上的了

7.在master机器(即A机器)启动keepalived服务,会看到vip这个IP立刻回来了

[root@xuexi-001 ~]# systemctl start keepalived

[root@xuexi-001 ~]# ip add

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:bf brd ff:ff:ff:ff:ff:ff

inet 192.168.5.130/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.100/32 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.150/24 brd 192.168.5.255 scope global secondary ens33:0

valid_lft forever preferred_lft forever

inet6 fe80::9625:3e1d:12c7:4fe6/64 scope link

valid_lft forever preferred_lft forever

3: ens37: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:c9 brd ff:ff:ff:ff:ff:ff

inet6 fe80::44c4:9bed:dd1f:6c01/64 scope link

valid_lft forever preferred_lft forever

8.查看B机器日志变化

[root@localhost ~]# tail /var/log/messages

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) Sending/queueing gratuitous ARPs on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

[root@localhost ~]# tail /var/log/messages

Sep 3 23:46:52 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) Sending/queueing gratuitous ARPs on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:46:57 localhost Keepalived_vrrp[1501]: Sending gratuitous ARP on ens33 for 192.168.5.100

Sep 3 23:50:01 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) Received advert with higher priority 100, ours 90

Sep 3 23:50:01 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) Entering BACKUP STATE

Sep 3 23:50:01 localhost Keepalived_vrrp[1501]: VRRP_Instance(VI_1) removing protocol VIPs.

总结

- 在生产环境中,可能会用到2-3台backup角色, vim /etc/keepalived/keepalived.conf 这里面的权重调成不同级别,权重越高优先级越高!除了nginx服务的话,还可以做MySQL的高可用集群服务。(做mysql的高可用,一定要保证两边的数据一致)

LVS 介绍

- LVS是由国人章文嵩开发

- 流行度不亚于apache的httpd,基于TCP/IP做的路由和转发,稳定性和效率很高

- LVS最新版本基于Linux内核2.6,有好多年不更新了

- LVS有三种常见的模式:NAT、DR、IP Tunnel

- LVS架构中有一个核心角色叫做分发器(Load balance),它用来分发用户的请求,还有诸多处理用户请求的服务器(Real Server,简称rs)

LVS三种模式:

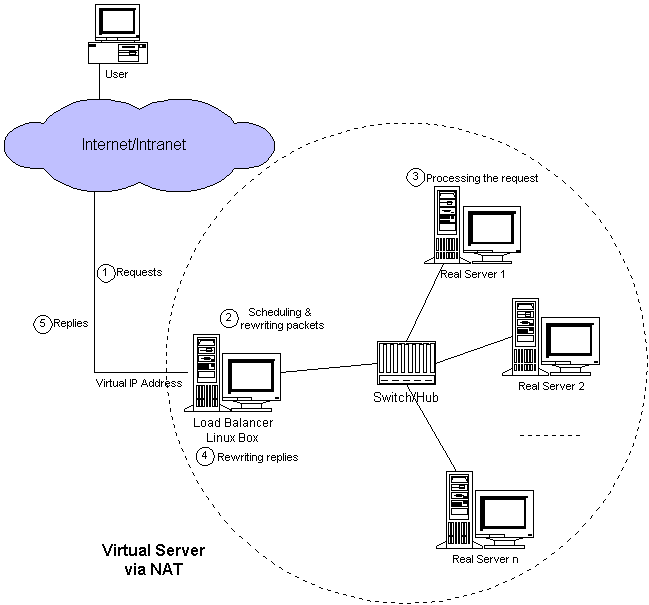

1、 LVS NAT模式

- 这种模式借助iptables的nat表来实现

- 用户的请求到分发器后,通过预设的iptables规则,把请求的数据包转发到后端的rs上去

- rs需要设定网关为分发器的内网ip

- 用户请求的数据包和返回给用户的数据包全部经过分发器,所以分发器成为瓶颈

- 在nat模式中,只需要分发器有公网ip即可,所以比较节省公网ip资源

# 使用NAT 这种模式的请求量不能过大 一般十台以内,超过十台就有点力不从心了,除非机器配置很高,网卡是千兆网卡,万兆光纤。

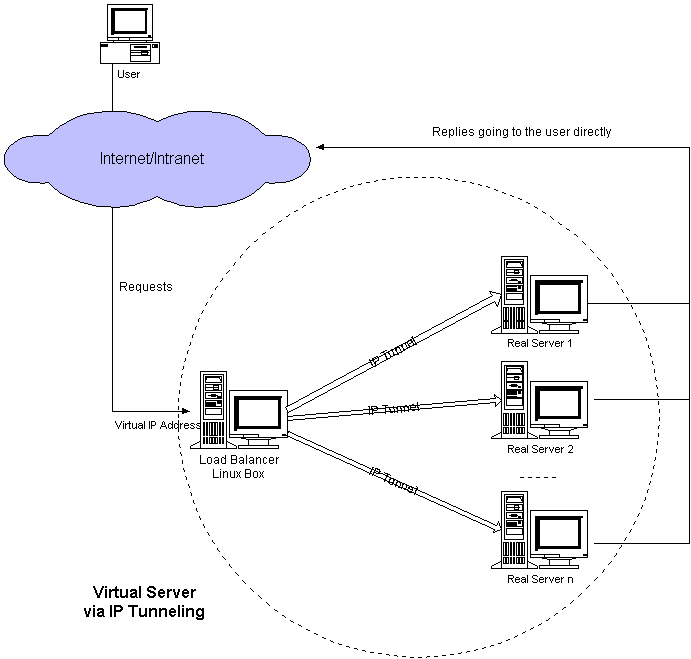

2、 LVS IP Tunnel模式

- 这种模式,需要有一个公共的IP配置在分发器和所有rs上,我们把它叫做vip

- 客户端请求的目标IP为vip,分发器接收到请求数据包后,会对数据包做一个加工,会把目标IP改为rs的IP,这样数据包就到了rs上

- rs接收数据包后,会还原原始数据包,这样目标IP为vip,因为所有rs上配置了这个vip,所以它会认为是它自己 [![]

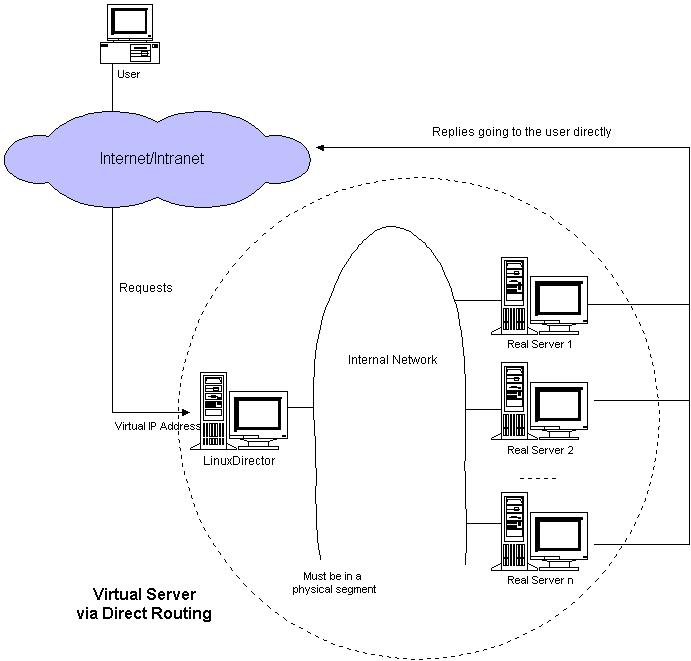

3、LVS DR模式

- 这种模式,也需要有一个公共的IP配置在分发器和所有rs上,也就是vip

- 和IP Tunnel不同的是,它会把数据包的MAC地址修改为rs的MAC地址

- rs接收数据包后,会还原原始数据包,这样目标IP为vip,因为所有rs上配置了这个vip,所以它会认为是它自己

NAT模式搭建 – 准备工作

- 三台机器

- 分发器,也叫调度器(简写为dir)

- 内网:133.130,外网:142.147(vmware仅主机模式)

- rs1

- 内网:133.132,设置网关为133.130

- rs2

- 内网:133.133,设置网关为133.130

- 三台机器上都执行执行

- systemctl stop firewalld; systemc disable firewalld

- systemctl start iptables-services; iptables -F; service iptables save

- 三台机器

- 分发器,也叫调度器(简写为dir)

- 内网:5.130,外网:81.144(vmware仅主机模式)

- rs1

- 内网:5.133,设置网关为5.130

- rs2

- 内网:5.134,设置网关为5.130

- 三台机器上都执行执行

- systemctl stop firewalld; systemc disable firewalld

- systemctl start iptables-services; iptables -F; service iptables save

安装iptables-services 每台机器上都安装

[root@xuexi-003 ~]# yum install -y iptables-services

[root@xuexi-003 ~]# systemctl start iptables

[root@xuexi-003 ~]# systemctl enable iptables

Created symlink from /etc/systemd/system/basic.target.wants/iptables.service to /usr/lib/systemd/system/iptables.service.

[root@xuexi-003 ~]# iptables -F

[root@xuexi-003 ~]# service iptables save

iptables: Saving firewall rules to /etc/sysconfig/iptables: [ 确定 ]

#为什么要开启iptables 服务,是因为要调用一个空规则,随后需要配置一个新的规则出来,默认的规则可能影响到实验效果。

然后还需要关闭selinux 所有的机器都需要更改

[root@xuexi-003 ~]# getenforce

Disabled

[root@xuexi-003 ~]# setenforce 0

setenforce: SELinux is disabled

[root@xuexi-003 ~]# vi /etc/selinux/config

更改配置文件关闭selinux

1、安装ipvsadm

[root@xuexi-001 ~]# yum install -y ipvsadm

2、在dir上编写脚本,vim /usr/local/sbin/lvs_nat.sh //内容如下

配置文件内容

#! /bin/bash

# director 服务器上开启路由转发功能,不开启的话没有办法把数据传输到后面的rs上面

echo 1 > /proc/sys/net/ipv4/ip_forward

# 关闭icmp的重定向

echo 0 > /proc/sys/net/ipv4/conf/all/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/default/send_redirects

# 注意区分网卡名字,两个网卡分别为ens33和ens37

echo 0 > /proc/sys/net/ipv4/conf/ens33/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/ens37/send_redirects

# director 设置nat防火墙

iptables -t nat -F

#清空iptables 规则

iptables -t nat -X

#清空链

iptables -t nat -A POSTROUTING -s 192.168.5.0/24 -j MASQUERADE

#可以实现同网段的内网上网

# director设置ipvsadm

IPVSADM='/usr/sbin/ipvsadm'

$IPVSADM -C

#清空规则

$IPVSADM -A -t 192.168.81.144:80 -s wlc -p 3

#设置一个规则 指定使用的什么规则(大规则)

$IPVSADM -a -t 192.168.81.144:80 -r 192.168.5.133:80 -m -w 1

$IPVSADM -a -t 192.168.81.144:80 -r 192.168.5.134:80 -m -w 1

#具体的规则(小规则)

3、没有输出内容,说明配置没有问题

[root@xuexi-001 ~]# sh /usr/local/sbin/lvs_nat.sh

[root@xuexi-001 ~]#

4、

- 两台rs上都安装nginx

#rs1

[root@xuexi-002 ~]# systemctl start nginx

[root@xuexi-002 ~]# netstat -lntp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 547/rpcbind

tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN 1204/nginx: master

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 802/sshd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 1047/master

tcp6 0 0 :::111 :::* LISTEN 547/rpcbind

tcp6 0 0 :::80 :::* LISTEN 1204/nginx: master

tcp6 0 0 :::22 :::* LISTEN 802/sshd

tcp6 0 0 ::1:25 :::* LISTEN 1047/master

tcp6 0 0 :::3306 :::* LISTEN 1045/mysqld

#rs2

[root@xuexi-003 ~]# systemctl start nginx

[root@xuexi-003 ~]# ps aux |grep nginx

root 1200 0.0 0.2 120752 2088 ? Ss 23:39 0:00 nginx: master process /usr/sbin/nginx

nginx 1201 0.0 0.3 121136 3116 ? S 23:39 0:00 nginx: worker process

root 1204 0.0 0.0 112676 980 pts/0 R+ 23:39 0:00 grep --color=auto nginx

[root@xuexi-003 ~]# netstat -lntp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 519/rpcbind

tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN 1200/nginx: master

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 809/sshd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 1057/master

tcp6 0 0 :::111 :::* LISTEN 519/rpcbind

tcp6 0 0 :::80 :::* LISTEN 1200/nginx: master

tcp6 0 0 :::22 :::* LISTEN 809/sshd

tcp6 0 0 ::1:25 :::* LISTEN 1057/master

tcp6 0 0 :::3306 :::* LISTEN 1015/mysqld

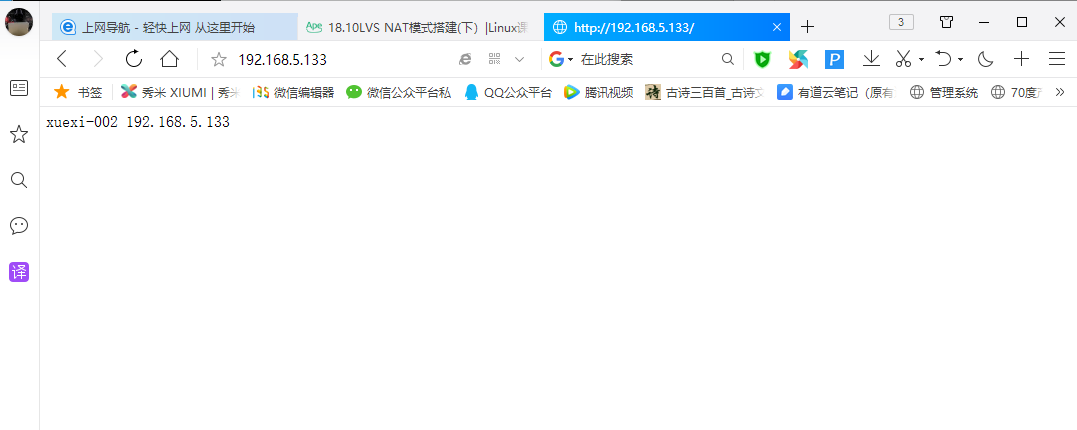

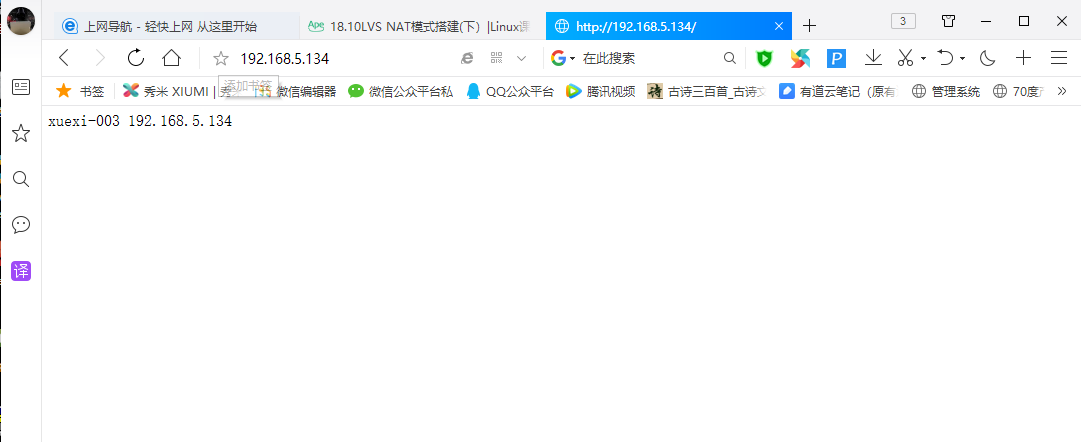

- 设置两台rs的主页,做一个区分,也就是说直接curl两台rs的ip时,得到不同的结果

#rs1

[root@xuexi-002 ~]# curl localhost

backup.backup

[root@xuexi-002 ~]# vi /usr/share/nginx/html/index.html

xuexi-002 192.168.5.133

#rs2

[root@xuexi-003 ~]# curl localhost

backup.backup

[root@xuexi-003 ~]# vi /usr/share/nginx/html/index.html

xuexi-003 192.168.5.134

- 浏览器里访问192.168.81.144,多访问几次看结果差异

可以在dir上更改一下规则,编辑配置文件vim /usr/local/sbin/lvs_nat.sh 将$IPVSADM -A -t 192.168.81.144:80 -s wlc -p 3 后面的-p 3 去掉

查看ipvsadm 设置的规则

[root@xuexi-001 ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.81.144:80 wlc

-> 192.168.5.133:80 Masq 1 2 0

-> 192.168.5.134:80 Masq 1 0 4

测试

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-002 192.168.5.133

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-002 192.168.5.133

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-002 192.168.5.133

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-002 192.168.5.133

[root@xuexi-001 ~]# curl 192.168.81.144

xuexi-003 192.168.5.134

测试结果

Keepalived+LVS DR

- 完整架构需要两台服务器(角色为dir)分别安装keepalived软件,目的是实现高可用,但keepalived本身也有负载均衡的功能,所以本次实验可以只安装一台keepalived

- keepalived内置了ipvsadm的功能,所以不需要再安装ipvsadm包,也不用编写和执行那个lvs_dir的脚本

- 三台机器分别为:

- dir(安装keepalived)133.130

- rs1 133.132

- rs2 133.133

- vip 133.200

- 编辑keepalived配置文件 vim /etc/keepalived/keepalived.conf//内容地址

- 需要更改里面的ip信息

- 执行ipvsadm -C 把之前的ipvsadm规则清空掉

- systemctl restart network 可以把之前的vip清空掉

- 两台rs上,依然要执行/usr/local/sbin/lvs_rs.sh脚本

- keepalived有一个比较好的功能,可以在一台rs宕机时,不再把请求转发过去

- 测试

1、因为之前做了NAT模式的现在需要做DR模式,需要将之前的rs1,rs2上面的网关更改回来

- rs1 192.168.5.2

- rs2 192.168.5.2

2、dir上编写脚本 vim /usr/local/sbin/lvs_dr.sh //内容如下

(dir)分发器上的配置

[root@xuexi-001 ~]# vi /usr/local/sbin/lvs_dr.sh

#! /bin/bash

echo 1 > /proc/sys/net/ipv4/ip_forward

ipv=/usr/sbin/ipvsadm

vip=192.168.5.200

rs1=192.168.5.133

rs2=192.168.5.134

ifdown ens33

ifup ens33

#注意这里的网卡名字

ifconfig ens33:2 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip dev ens33:2

$ipv -C

$ipv -A -t $vip:80 -s wrr

$ipv -a -t $vip:80 -r $rs1:80 -g -w 1

$ipv -a -t $vip:80 -r $rs2:80 -g -w 1

[root@xuexi-001 ~]# sh /usr/local/sbin/lvs_dr.sh

成功断开设备 'ens33'。

连接已成功激活(D-Bus 活动路径:/org/freedesktop/NetworkManager/ActiveConnection/3)

rs1

[root@xuexi-002 ~]# vi /usr/local/sbin/lvs_rs.sh

#/bin/bash

vip=192.168.5.200

#把vip绑定在lo上,是为了实现rs直接把结果返回给客户端

ifdown lo

ifup lo

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

#以下操作为更改arp内核参数,目的是为了让rs顺利发送mac地址给客户端

#参考文档www.cnblogs.com/lgfeng/archive/2012/10/16/2726308.html

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

rs2

[root@xuexi-003 ~]# vi /usr/local/sbin/lvs_rs.sh

#/bin/bash

vip=192.168.5.200

#把vip绑定在lo上,是为了实现rs直接把结果返回给客户端

ifdown lo

ifup lo

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

#以下操作为更改arp内核参数,目的是为了让rs顺利发送mac地址给客户端

#参考文档www.cnblogs.com/lgfeng/archive/2012/10/16/2726308.html

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

Keepalived+LVS DR

- 完整架构需要两台服务器(角色为dir)分别安装keepalived软件,目的是实现高可用,但keepalived本身也有负载均衡的功能,所以本次实验可以只安装一台keepalived

- 为什么需要把keepalived 加到lvs 中的目的是什么?

- 原因一:lvs,它有个关键角色,就是dir分发器,如果分发器宕掉,那所有的访问就会被终止,因为所有的入口全都在dir分发器上,所以需要把分发器做一个高可用,用keepalived实现高可用,并且keepalived还有负载均衡的作用。

- 原因二:在使用lvs的时候,如果没有额外的操作,这时将一个rs机器关机(宕机)时,lvs照样会分发数据到这台宕机机器,这是就会出现访问无效的情况,说明lvs并不聪明;这时使用keepalived,就可以保证集群中其中一台rs宕机了,web还能正常提供,不会出现用户访问时无效链接的结果;一般这种架构,肯定是2台keepalived;

- 因为keepalived内置了ipvsadm的功能,所以不再需要安装ipvsadm的包,也不用再编写和执行.sh脚本

准备工作

1.准备三台机器,分别为

- dir(安装keepalived)5.130

- rs1 5.133

- rs2 5.134

- vip 5.200

2.在dir分发器(A机器)上,清空ipvsadm规则,并查看ipvsadm规则,会发现已经清空

[root@xuexi-001 ~]# ipvsadm -C

[root@xuexi-001 ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

3.在分发器(即A机器)上编辑配置文件,在/etc/keepalived/keepalived.conf 配置,配置文件内容

- 因为之前做实验里面编辑过配置文件,这时直接删除,然后粘贴新的配置文件

- 修改配置文件中的网卡、vip ,还有rs机器上的IP

[root@xuexi-001 ~]# vim /etc/keepalived/keepalived.conf

vrrp_instance VI_1 {

#备用服务器上为 BACKUP

state MASTER

#绑定vip的网卡为ens33,你的网卡和阿铭的可能不一样,这里需要你改一下

interface ens33

virtual_router_id 51

#备用服务器上为90

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass aminglinux

}

virtual_ipaddress {

192.168.5.200

}

}

virtual_server 192.168.5.200 80 {

#(每隔10秒查询realserver状态)

delay_loop 10

#(lvs 算法)

lb_algo wlc

#(DR模式)

lb_kind DR

#(同一IP的连接60秒内被分配到同一台realserver)

persistence_timeout 60

#(用TCP协议检查realserver状态)

protocol TCP

real_server 192.168.5.133 80 {

#(权重)

weight 100

TCP_CHECK {

#(10秒无响应超时)

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 192.168.5.134 80 {

weight 100

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

:wq

4.启动keepalived服务,查看keepalived服务

[root@xuexi-001 ~]# systemctl start keepalived

[root@xuexi-001 ~]# ps aux |grep keepalived

root 1678 0.0 0.0 118652 1396 ? Ss 07:44 0:00 /usr/sbin/keepalived -D

root 1679 0.0 0.1 127520 3332 ? S 07:44 0:00 /usr/sbin/keepalived -D

root 1680 0.0 0.1 127388 2616 ? S 07:44 0:00 /usr/sbin/keepalived -D

root 1685 0.0 0.0 112720 976 pts/0 S+ 07:44 0:00 grep --color=auto keepalived

5.查看IP,会看到虚拟IP依然存在

[root@xuexi-001 ~]# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:bf brd ff:ff:ff:ff:ff:ff

inet 192.168.5.130/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.200/32 brd 192.168.5.200 scope global ens33:2

# 虚拟IP 依旧存在

valid_lft forever preferred_lft forever

inet 192.168.5.150/24 brd 192.168.5.255 scope global secondary ens33:0

valid_lft forever preferred_lft forever

inet6 fe80::9625:3e1d:12c7:4fe6/64 scope link

valid_lft forever preferred_lft forever

3: ens37: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:c9 brd ff:ff:ff:ff:ff:ff

inet 192.168.81.144/24 brd 192.168.81.255 scope global ens37

valid_lft forever preferred_lft forever

inet6 fe80::44c4:9bed:dd1f:6c01/64 scope link

valid_lft forever preferred_lft forever

6.查看ipvsadm规则

[root@xuexi-001 ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.5.200:80 wlc

7.这时关闭keepalived服务,再来查看ip,会看到虚拟IP停掉了

[root@xuexi-001 ~]# systemctl stop keepalived

[root@xuexi-001 ~]# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN qlen 1

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:bf brd ff:ff:ff:ff:ff:ff

inet 192.168.5.130/24 brd 192.168.5.255 scope global ens33

valid_lft forever preferred_lft forever

inet 192.168.5.150/24 brd 192.168.5.255 scope global secondary ens33:0

valid_lft forever preferred_lft forever

inet6 fe80::9625:3e1d:12c7:4fe6/64 scope link

valid_lft forever preferred_lft forever

3: ens37: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

link/ether 00:0c:29:b3:a2:c9 brd ff:ff:ff:ff:ff:ff

inet 192.168.81.144/24 brd 192.168.81.255 scope global ens37

valid_lft forever preferred_lft forever

inet6 fe80::44c4:9bed:dd1f:6c01/64 scope link

valid_lft forever preferred_lft forever

8.再来查看规则,会发现没有启动规则

[root@xuexi-001 ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

9.这时启动keepalived,再来查看规则

[root@xuexi-001 ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.5.200:80 wlc

-> 192.168.5.133:80 Route 100 2 0

-> 192.168.5.134:80 Route 100 1 1

10.注意事项:两点

- 1.打开dir机器的端口转发

echo 1 > /proc/sys/net/ipv4/ip_forward //打开端口转发

- 2.在rs机器上创建的/usr/local/sbin/lvs_rs.sh脚本,依然要执行它

#把vip绑定在lo上,是为了实现rs直接把结果返回给客户端

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

#以下操作为更改arp内核参数,目的是为了让rs顺利发送mac地址给客户端

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

总结

- keepalived 有一个比较好的功能,可以在一台rs宕机的时候,及时把他踢出 ipvsadm 集群,将不再发送数据包给,也就很好的避免的访问无连接的情况发送

5019

5019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?