当前业界对大数据应用开发的场景要求:

- 日志分析系统

- 商品推荐系统

- 用户行为分析系统

- 等等

案例1:Hadoop项目实战---黑马论坛日志分析 - CSDN博客

项目开发步骤

1.使用flume把日志数据导入到hdfs中

2.对数据进行清洗、清洗后的数据易于我们使用

3.明细日志使用hbase存储,能够利用ip、时间查询

4.使用hive进行数据的多维分析

5.把hive分析结果使用sqoop导出到mysql中

6.提供视图工具供用户使用

案例2:海量Web日志分析 用Hadoop提取KPI统计指标 | 粉丝日志

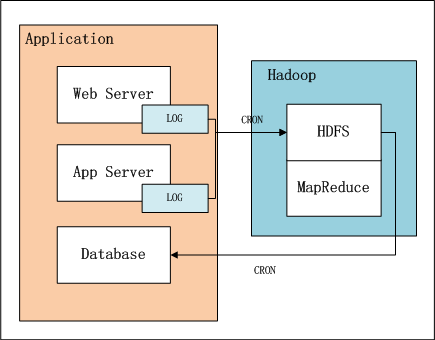

日志KPI系统架构

上图中,左边是Application业务系统,右边是Hadoop的HDFS, MapReduce。

1、日志是由业务系统产生的,我们可以设置web服务器每天产生一个新的目录,目录下面会产生多个日志文件,每个日志文件64M。

2、设置系统定时器CRON,夜间在0点后,向HDFS导入昨天的日志文件。 完成导入后,设置系统定时器,启动MapReduce程序,提取并计算统计指标。

3、完成计算后,设置系统定时器,从HDFS导出统计指标数据到数据库,方便以后的即使查询。

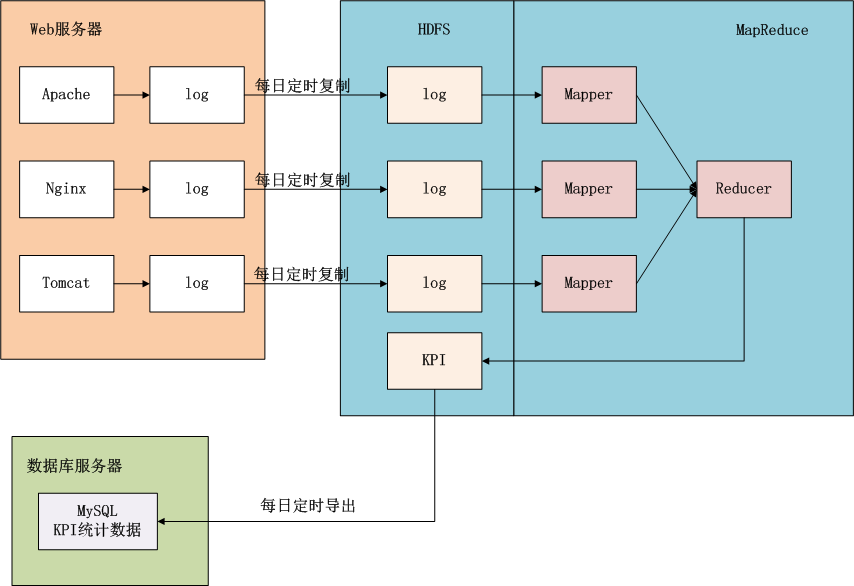

上面这幅图,我们可以看得更清楚,数据是如何流动的。蓝色背景的部分是在Hadoop中的,接下来我们的任务就是完成MapReduce的程序实现。

案例3:Hadoop学习笔记—20.网站日志分析项目案例(一)项目介绍 - Edison Chou - 博客园

1、需要用到的技术:

- Linux Shell编程

- HDFS、MapReduce

- HBase、Hive、Sqoop框架

2、上传日志文件至HDFS

把日志数据上传到HDFS中进行处理,可以分为以下几种情况:

- 如果是日志服务器数据较小、压力较小,可以直接使用shell命令把数据上传到HDFS中;

- 如果是日志服务器数据较大、压力较大,使用NFS在另一台服务器上上传数据;

- 如果日志服务器非常多、数据量大,使用flume进行数据处理;

3、数据清洗

使用MapReduce对HDFS中的原始数据进行清洗,以便后续进行统计分析;

4、统计分析

使用Hive对清洗后的数据进行统计分析;

5、分析结果导入MySQL

使用Sqoop把Hive产生的统计结果导出到mysql中;

6、提供视图工具

提供视图工具供用户使用,指标查询mysql、明细则查询Hbase;

865

865

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?