本文主要记录下给予python的nginx日志统计过程,主要原因是最近系统经常遭到未知程序的疯狂爬数据,虽然做了防爬机制,但是还是必须要找出是哪些IP访问次数比较多。想到的办法就是通过分析ngxin日志,从而找出这些IP排行即可。具体方案的操作步骤包括:

ngxin日志每日切割功能;

设置ngxin的日志格式;

编写python代码在每日切割之前统计下access.log中的IP访问次数并将统计结果录入MongoDB;

编写web查询MongoDB进行统计。

一、nginx日志每日切割功能

该功能主要通过自己编写shell脚本实现,然后将shell脚本通过crontab设置任务周期。

shell脚本如下:

#!/bin/bash

## 零点执行该脚本

## Nginx 日志文件所在的目录

LOGS_PATH=/usr/local/nginx/logs

## 获取昨天的 yyyy-MM-dd

YESTERDAY=$(date -d ”yesterday” +%Y-%m-%d)

## 移动文件

mv ${LOGS_PATH}/access.log ${LOGS_PATH}/access_${YESTERDAY}.log

## 向 Nginx 主进程发送 USR1 信号。USR1 信号是重新打开日志文件

kill -USR1 $(cat /usr/local/nginx/nginx.pid)

加入crontab

0 0 * * * /bin/bash /usr/local/nginx/sbin/cut-log.sh

二、设置ngxin日志格式

打开nginx.conf配置文件,在server段中加入

log_format access '$remote_addr - $remote_user [$time_local] "$request"' '$status $body_bytes_sent "$http_referer"' '"$http_user_agent" $http_x_forwarded_for'; access_log /usr/local/nginx/logs/access.log access;

加入成功后重启ngxin

/usr/local/sbin/nginx -s reload

三、编写python代码在每日切割之前统计下access.log中的IP访问次数并将统计结果录入MongoDB;

下载pymongo,上传到服务器,并安装

# tar zxvf pymongo-1.11.tar.gz

# cd pymongo-1.11

# python setup.py install

python连接mongodb样例

$ cat conn_mongodb.py

#!/usr/bin/python

import pymongo

import random

conn = pymongo.Connection("127.0.0.1",27017)

db = conn.tage #连接库

db.authenticate("tage","123")

#用户认证

db.user.drop()

#删除集合user

db.user.save({'id':1,'name':'kaka','sex':'male'})

#插入一个数据

for id in range(2,10):

name = random.choice(['steve','koby','owen','tody','rony'])

sex = random.choice(['male','female'])

db.user.insert({'id':id,'name':name,'sex':sex})

#通过循环插入一组数据

content = db.user.find()

#打印所有数据

for i in content:

print i

编写python脚本

#encoding=utf8

import re

zuidaima_nginx_log_path="/usr/local/nginx/logs/www.zuidaima.com.access.log"

pattern = re.compile(r'^\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}')

def stat_ip_views(log_path):

ret={}

f = open(log_path, "r")

for line in f:

match = pattern.match(line)

if match:

ip=match.group(0)

if ip in ret:

views=ret[ip]

else:

views=0

views=views+1

ret[ip]=views

return ret

def run():

ip_views=stat_ip_views(zuidaima_nginx_log_path)

max_ip_view={}

for ip in ip_views:

views=ip_views[ip]

if len(max_ip_view)==0:

max_ip_view[ip]=views

else:

_ip=max_ip_view.keys()[0]

_views=max_ip_view[_ip]

if views>_views:

max_ip_view[ip]=views

max_ip_view.pop(_ip)

print "ip:", ip, ",views:", views

#总共有多少ip

print "total:", len(ip_views)

#最大访问的ip

print "max_ip_view:", max_ip_view

run()

上面程序运行结果:

ip: 221.221.155.53 ,views: 1

ip: 221.221.155.54 ,views: 2

total: 2

max_ip_view: {'221.221.155.54': 2}

可以参考:http://kling.blog.51cto.com/3320545/1615505

shell脚本每天自动统计网站访问日志

写了个shell脚本,可以用来统计每天的访问日志,并发送到电子邮箱,方便每天了解网站情况。

脚本统计了:

1、总访问量

2、总带宽

3、独立访客量

4、访问IP统计

5、访问url统计

6、来源统计

7、404统计

8、搜索引擎访问统计(谷歌,百度)

9、搜索引擎来源统计(谷歌,百度)

#!/bin/bash

log_path=/home/www.centos.bz/log/access.log.1

domain="centos.bz"

email="log@centos.bz"

maketime=`date +%Y-%m-%d" "%H":"%M`

logdate=`date -d "yesterday" +%Y-%m-%d`

total_visit=`wc -l ${log_path} | awk '{print $1}'`

total_bandwidth=`awk -v total=0 '{total+=$10}END{print total/1024/1024}' ${log_path}`

total_unique=`awk '{ip[$1]++}END{print asort(ip)}' ${log_path}`

ip_pv=`awk '{ip[$1]++}END{for (k in ip){print ip[k],k}}' ${log_path} | sort -rn | head -20`

url_num=`awk '{url[$7]++}END{for (k in url){print url[k],k}}' ${log_path} | sort -rn | head -20`

referer=`awk -v domain=$domain '$11 !~

/http:\/\/[^/]*'"$domain"'/{url[$11]++}END{for (k in url){print

url[k],k}}' ${log_path} | sort -rn | head -20`

notfound=`awk '$9 == 404 {url[$7]++}END{for (k in url){print url[k],k}}' ${log_path} | sort -rn | head -20`

spider=`awk -F'"' '$6 ~ /Baiduspider/ {spider["baiduspider"]++} $6 ~

/Googlebot/ {spider["googlebot"]++}END{for (k in spider){print

k,spider[k]}}' ${log_path}`

search=`awk -F'"' '$4 ~ /http:\/\/www\.baidu\.com/

{search["baidu_search"]++} $4 ~ /http:\/\/www\.google\.com/

{search["google_search"]++}END{for (k in search){print k,search[k]}}'

${log_path}`

echo -e

"概况\n报告生成时间:${maketime}\n总访问量:${total_visit}\n总带宽:${total_bandwidth}M\n独

立访客:${total_unique}\n\n访问IP统计\n${ip_pv}\n\n访问url统计\n${url_num}\n\n来源页面统计

\n${referer}\n\n404统计\n${notfound}\n\n蜘蛛统计\n${spider}\n\n搜索引擎来源统计

\n${search}" | mail -s "$domain $logdate log statistics" ${email}

需要修改的三个变量log_path,domain和email

把此脚本添加到计划任务,就可以每天接收到统计的数据了。

linux定时切割nginx日志并删除指定天数前的日志记录

nginx的log日志分为access.log和error.log;其中access.log 记录了哪些用户、哪些页面以及用户浏览器、ip和其他的访问信息;error.log则是记录服务器错误日志.

201.158.69.116 - - [03/Jan/2013:21:17:20 -0600] fwf[-] tip[-] 127.0.0.1:9000 0.007 0.007 MX pythontab.com GET /html/test.html HTTP/1.1 "200" 2426 "http://a.com" "es-ES,es;q=0.8" "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.97 Safari/537.11" 187.171.69.177 - - [03/Jan/2013:21:17:20 -0600] fwf[-] tip[-] 127.0.0.1:9000 0.006 0.006 MX pythontab.com GET /html/test2.html HTTP/1.1 "200" 2426 "http://a.com" "es-ES,es;q=0.8" "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.97 Safari/537.11"

从上面我们可以看出几部分信息:

1.客户端(用户)IP地址。如:上例中的 201.158.69.116

2.访问时间。如:上例中的 [03/Jan/2013:21:17:20 -0600]

3.访问端口。如:上例中的 127.0.0.1:9000

4.响应时间。如:上例中的 0.007

5.请求时间。如:上例中的 0.007

6.用户地理位置代码(国家代码)。如:上例中的 MX(墨西哥)

7.请求的url地址(目标url地址)的host。如:上例中的 pythontab.com

8.请求方式(GET或者POST等)。如:上例中的 GET

9.请求url地址(去除host部分)。如:上例中的 /html/test.html

10.请求状态(状态码,200表示成功,404表示页面不存在,301表示永久重定向等,具体状态码可以在网上找相关文章,不再赘述)。如:上例中的 "200"

11.请求页面大小,默认为B(byte)。如:上例中的 2426

12.来源页面,即从哪个页面转到本页,专业名称叫做“referer”。如:上例中的 "http://a.com"

13.用户浏览器语言。如:上例中的 "es-ES,es;q=0.8"

14.用户浏览器其他信息,浏览器版本、浏览器类型等。如:上例中的 "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.11 (KHTML,like Gecko) Chrome/23.0.1271.97 Safari/537.11"

access.log日志的格式不是一成不变的,是可以自定义的。在nginx的nginx.conf配置文件找到:log_format 这里就是日志的格式

#log_format main '$remote_addr - $remote_user [$time_local] "$request" ' # '$status $body_bytes_sent "$http_referer" ' # '"$http_user_agent" "$http_x_forwarded_for"'; #access_log logs/access.log main;

log_format是Nginx的HttpLog模块指令,用于指定Nginx日志的输出格式。main为此日志输出格式的名称,可以在下面的access_log指令中引用。

例如:

192.168.21.1 - - [27/Jan/2014:11:28:53 +0800] "GET /2.php HTTP/1.1" 200 133 "-" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/33.0.1707.0 Safari/537.36" "-"192.168.21.128 200 127.0.0.1:9000 0.119 0.119

$remote_addr:客户端地址 192.168.21.1

$remote_user:客户端用户 -

$time_local:时间和时区 27/Jan/2014:11:28:53 +0800

$request:请求的URL路径和HTTP协议 GET /2.php HTTP/1.1

$status: HTTP状态 200

$body_bytes_sent:发送给客户端页面大小 133

$http_referer:页面跳转来源 -

$http_user_agent:用户访问终端 Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/33.0.1707.0 Safari/537.36

$http_x_forwarded_for:HTTP 代理中,请求端真实IP -

$http_host:用户在浏览器中输入的URL(IP或着域名)地址 192.168.21.128

$upstream_status: upstream状态 200

$upstream_addr: 后端upstream地址及端口 127.0.0.1:9000

$request_time: 页面访问总时间 0.119

$upstream_response_time:页面访问中upstream响应时间 0.119

如 果在客户端和Web服务器之间增加了中间层(比如反向代理服务器),此时Web服务器无法直接拿到客户端的lP,通过$remote_addr变量拿到的 将是反向代理服务器的IP地址。但是,反向代理服务器在转发请求的HTTP头信息中,可以增加X-Forwarded-For信息,用以记录原有的客户端 lP地址和原来客户端请求的服务器地址。

这 时候,就要用log_format指令来设置日志格式,让日志记录X-Forwarded-For信息中的lP地址,即客户的真实IP。例如,创建一个名 为mylogformat的日志格式,再用$http_x_forwarded_for变量记录用户的X-Forwarded-For lP地址:

log_format mylogformat '$http_x_forwarded_for - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"';

如果不想记录日志,可以使用以下指令关闭日志记录: access_log off

nginx日志文件的切割

生产环境中的服务器,由于访问日志文件增长速度非常快,日志太大会严重影响服务器效率。同时,为了方便对日志进行分析计算,须要对日志文件进行定时切割。定时切割的方式有按月切割、按天切割、按小时切割等。最常用的是按天切割。

Nginx不支持像Apache 一样使用cronolog来轮转日志,但是可以采用以下方式来实现日志文件的切割:

mv /usr/local/nginx/logs/access.log /usr/local/nginx/logs/access_20150519084513.log

kill -USR1 Nginx主进程号

通 过mv命令将日志文件重命名为/usr/local/nginx/logs/access_20150519084513.log,然后发送kill -USR1信号给Nginx的主进程号,让Nginx重新生成一个新的日志文件/usr/local/nginx/logs/access.log。

如果想每天定时切割日志,还要借助crontab。我们可以写个按天切割的日志,按年、月份目录存放日志的shell脚本:

[root@localhost logs]# vim /usr/local/nginx/sbin/cut_nginx_log.sh

#!/bin/bash

logs_path="/usr/local/nginx/logs/"

DAYS=30

mv ${logs_path}access.log ${logs_path}access_$(date -d "yesterday" +"%Y%m%d%H%M%S").log

#mv ${logs_path}access.log ${logs_path}access_$(date +"%Y年%m月%d日%H时%M分%S秒星期%w").log

kill -USR1 `cat /usr/local/nginx/logs/nginx.pid`

find ${logs_path} -name "access_*.log" -type f -mtime +$DAYS -exec rm {} \;

[root@localhost logs]# chmod +x /usr/local/nginx/sbin/cut_nginx_log.sh

[root@localhost logs]# crontab -e

0 0 * * * /usr/local/nginx/sbin/cut_nginx_log.sh

[root@localhost logs]# service crond restart

Stopping crond: [ OK ]

Starting crond: [ OK ]

[root@localhost logs]# chkconfig crond on

[root@localhost logs]#

如果脚本在执行过程中出现下面错误

nginx: [error] open() "/usr/local/nginx/logs/nginx.pid" failed

解决办法:

[root@localhost logs]# /usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf

Linux下定时切割Tomcat日志并删除指定天数前的日志

System.out和System.err都被打印到catalina.out。catalina.out不会rotate。一般在部署Tomcat后,运行久了,catalina.out文件会越来越大,对系统的稳定造成了一定的影响。

1、可通过修改conf/logging.properties日志配置文件来屏蔽掉这部分的日志信息。

[root@localhost conf]# pwd

/usr/local/tomcat/conf

[root@localhost conf]# cp logging.properties logging.propertiesbak

[root@localhost conf]# vim logging.properties

25 1catalina.org.apache.juli.FileHandler.level = FINE

26 1catalina.org.apache.juli.FileHandler.directory = ${catalina.base}/logs

27 1catalina.org.apache.juli.FileHandler.prefix = catalina.

将level级别设置成WARNING就可以大量减少日志的输出,当然也可以设置成OFF,直接禁用掉。

一般日志的级别有:

SEVERE (highest value) > WARNING > INFO > CONFIG > FINE > FINER > FINEST (lowest value)

2、使用cronolog工具切分Tomcat的catalina.out日志文件

下载、安装cronolog

[root@localhost src]# yum -y install gcc gcc-c++ [root@localhost src]# rpm -qa |grep cronolog [root@localhost src]# tar zxvf cronolog-1.6.2.tar.gz [root@localhost src]# cd cronolog-1.6.2 [root@localhost cronolog-1.6.2]# ./configure [root@localhost cronolog-1.6.2]# make && make install [root@localhost cronolog-1.6.2]# which cronolog /usr/local/sbin/cronolog

用which cronolog可以查到安装的路径,这个路径待会在修改catalina.sh时会用到。

修改catalina.sh 将183行修改成184行内容,注释掉355行,368、369行替换成370、371行,379、380行替换成381、382行

[root@localhost cronolog-1.6.2]# cp /usr/local/tomcat/bin/catalina.sh /usr/local/tomcat/bin/catalina.shbak [root@localhost cronolog-1.6.2]# vim /usr/local/tomcat/bin/catalina.sh 182 if [ -z "$CATALINA_OUT" ] ; then 183 # CATALINA_OUT="$CATALINA_BASE"/logs/catalina.out 184 CATALINA_OUT="$CATALINA_BASE"/logs/catalina.%Y-%m-%d.out 185 fi ...... 355 # touch "$CATALINA_OUT" ...... 363 -Djava.security.manager \ 364 -Djava.security.policy=="$CATALINA_BASE"/conf/catalina.policy \ 365 -Dcatalina.base="$CATALINA_BASE" \ 366 -Dcatalina.home="$CATALINA_HOME" \ 367 -Djava.io.tmpdir="$CATALINA_TMPDIR" \ 368 # org.apache.catalina.startup.Bootstrap "$@" start \ 369 # >> "$CATALINA_OUT" 2>&1 & 370 org.apache.catalina.startup.Bootstrap "$@" start 2>&1 \ | /usr/local/sbin/cronolog "$CATALINA_BASE"/logs/catalina.%Y-%m-%d.out >> /dev/null & 372 373 else 374 "$_RUNJAVA" "$LOGGING_CONFIG" $LOGGING_MANAGER $JAVA_OPTS $CATALINA_OPTS \ 375 -Djava.endorsed.dirs="$JAVA_ENDORSED_DIRS" -classpath "$CLASSPATH" \ 376 -Dcatalina.base="$CATALINA_BASE" \ 377 -Dcatalina.home="$CATALINA_HOME" \ 378 -Djava.io.tmpdir="$CATALINA_TMPDIR" \ 379 # org.apache.catalina.startup.Bootstrap "$@" start \ 380 # >> "$CATALINA_OUT" 2>&1 & 381 org.apache.catalina.startup.Bootstrap "$@" start 2>&1 \ 382 | /usr/local/sbin/cronolog "$CATALINA_BASE"/logs/catalina.%Y-%m-%d.out >> /dev/null & 384 fi [root@localhost cronolog-1.6.2]# service tomcat stop [root@localhost cronolog-1.6.2]# service tomcat start

这样在/usr/local/tomcat/logs每天会自动生成catalina.%Y-%m-%d.out文件,下面我们要做的是定期清理这些过期的文件,我们可以通过crontab来实现

[root@localhost logs]# crontab -e

no crontab for root - using an empty one

crontab: installing new crontab

[root@localhost logs]# crontab -l

30 5 * * 6 /bin/find /usr/local/tomcat/logs/ -mtime +7 -type f -name "catalina.*.out" -exec /bin/rm -f {} \;

[root@localhost logs]# cat /var/spool/cron/root

30 5 * * 6 /bin/find /usr/local/tomcat/logs/ -mtime +7 -type f -name "catalina.*.out" -exec /bin/rm -f {} \;

[root@localhost logs]#

3、使用下面脚本切分Tomcat的catalina.out日志文件、可用于一台服务器上多个tomcat实例,只需写多个脚本即可。

cat /data/scripts/cut_tomcat_robbot_log.sh

#!/bin/bash

#访问日志存放目录

logs_path="/data/logs/tomcat-robbot/"

MAXDAYS=30

#创建存放分割后的目录,

mkdir -p ${logs_path}

#创建存放分割后的目录,目录以年/月命名

#mkdir -p ${logs_path}$(date -d "yesterday" +"%Y")/$(date -d "yesterday" +"%m")/

#将访问日志进行迁移到指定目录

mv /data/tomcat/tomcat-robbot/logs/catalina.out ${logs_path}$(date -d "yesterday" +"%Y")/$(date -d "yesterday" +"%m")/catalina.out_$(date -d "yesterday" +"%Y%m%d")

#清空tomcat日志

echo "" > /data/tomcat/tomcat-robbot/logs/catalina.out

find /data/tomcat/tomcat-robot/logs/ -name 'catalina.out' | xargs truncate -s 0

#删除30日之前的日志

find ${logs_path} -maxdepth 1 -type f -mtime +$(expr ${MAXDAYS} - 1) -exec echo "Delete {}" \; -exec rm "{}" \;

做计划任务

crontab -e

00 0 * * * /bin/bash /data/scripts/cut_tomcat_robbot_log.sh >/dev/null 2>&1

service crond restart

nginx反向代理tomcat日志获取真实IP

(1)nigix nginx.conf配置文件中:

proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

(2)tomcat server.xml配置文件中:

<Valve className="org.apache.catalina.valves.AccessLogValve"

directory="logs" prefix="tomcat_access_log." suffix=".txt"

pattern="%a %r %t %{X-Real-IP}i" resolveHosts="false"/>

通过jmx监控tomcat

关于如何安装zabbix,可以参考上一篇文章http://blog.unix178.com/

配置修改zabbix监控端

备份zabbix_server.conf和zabbix_agentd.conf文件,重新编译安装zabbix

[root@nginx zabbix-2.2.0]# ./configure --enable-server --enable-agent --with-mysql --enable-ipv6 --with-net-snmp --with-libcurl --with-ssh2 --enable-java

2.zabbix_server端安装jdk

下载安装jdk-7u65-linux-x64.rpm

#yum install jdk-7u65-linux-x64.rpm

配置环境变量

[root@localhost ~]#vim /etc/profile/java.sh

在文件末尾添加如下内容

JAVA_HOME=/usr/java/jdk1.7.0_65

PATH=$JAVA_HOME/bin:$PATH

CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export JAVA_HOME

export PATH

export CLASSPATH

[root@localhost ~]#source /etc/profile

查看安装结果

[root@localhost ~]#java -version

java version "1.7.0_65"

Java(TM) SE Runtime Environment (build 1.7.0_65-b17)

Java HotSpot(TM) 64-Bit Server VM (build 24.65-b04.mixed mode)

3.修改zabbix_java相关选项

然后进入到下面的目录下面进行seeting.sh脚本编辑

[root@nginx zabbix-2.2.0]# find / -name zabbix_java

/data/zabbix/sbin/zabbix_java

[root@nginx zabbix-2.2.0]# cd zabbix_java

[root@nginx zabbix-2.2.0]# ls

bin lib settings.sh shutdown.sh startup.sh

该文件默认全部注释的,启用下面几项即可

[root@nginx zabbix_java]# vim settings.sh

LISTEN_IP="0.0.0.0"

LISTEN_PORT=10052

PID_FILE="/tmp/zabbix_java.pid"

START_POLLERS=10

修改zabbix_server文件

启用其中的几项

[root@nginx zabbix_java]# vim /data/zabbix/etc/zabbix_server.conf

JavaGateway=127.0.0.1

JavaGatewayPort=10052

StartJavaPollers=5

5.启动zabbix_java

[root@nginx zabbix-2.2.0]# cd /data/zabbix/sbin/zabbix_java

[root@nginx zabbix-2.2.0]# ls

bin lib settings.sh shutdown.sh startup.sh

[root@nginx zabbix-2.2.0]# ./startup.sh

[root@nginx zabbix-2.2.0]# ss -tunlp | grep 10052

tcp LISTEN 0 50 :::10052 :::* users:(("java",16405,12))

配置修改tomcat被监控端

下载catalina-jmx-remote.jar ,注意不同版本的tomcat下载相对应的catalina-jmx-remote.jar ,我这里的tomcat版本为7.0.53 下载对应的catalina-jmx-remote.jar 下载地址如下:

http://archive.apache.org/dist/tomcat/tomcat-7/v7.0.53/bin/extras/

将下载好的文件存放到tomcat子目录目录lib录下

[root@tomcat tmp]# mv catalina-jmx-remote.jar /usr/apache-tomcat-7.0.53/lib/

方法一:修改启动脚本文件

[root@tomcat]# cd /usr/apache-tomcat-7.0.53/bin

修改vim catalina.sh

在# ----- Execute The Requested Command -----------------下面添加如下内容:

CATALINA_OPTS="-Dcom.sun.management.jmxremote -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false -Djava.rmi.server.hostname=x.x.x.x"

-----备注(x.x.x.x是客户端ip地址,即tomcat本身ip地址)

-----这里的Port要和zabbix服务器定义的监听jmx端口保持一致。

方法二:也可以在tomcat的bin目录添加了一个setenv.sh脚本

# pwd

/usr/apache-tomcat-7.0.53/bin

# cat setenv.sh

#!/bin/bash

CATALINA_OPTS="${CATALINA_OPTS} -Djava.rmi.server.hostname=x.x.x.x"

CATALINA_OPTS="${CATALINA_OPTS} -Djavax.management.builder.initial="

CATALINA_OPTS="${CATALINA_OPTS} -Dcom.sun.management.jmxremote=true"

#CATALINA_OPTS="${CATALINA_OPTS} -Dcom.sun.management.jmxremote.port=12345" #监听jmx端口

CATALINA_OPTS="${CATALINA_OPTS} -Dcom.sun.management.jmxremote.ssl=false"

CATALINA_OPTS="${CATALINA_OPTS} -Dcom.sun.management.jmxremote.authenticate=false"

cd /usr/apache-tomcat-7.0.53/conf

vim server.xml

修改server.xml配置文件在

<Listener className="org.apache.catalina.core.ThreadLocalLeakPreventionListener" />

添加下面一行内容

<Listener className="org.apache.catalina.mbeans.JmxRemoteLifecycleListener" rmiRegistryPortPlatform="12345" rmiServerPortPlatform="12346" />

-----这里的Port要和zabbix服务器定义的监听jmx端口保持一致。

修改tomcat服务器的hosts文件

cat /etc/hosts

192.168.18.19 localhost.localdomain localhost

重启tomcat和zabbix_agentd服务

/usr/apache-tomcat-7.0.53/bin/catalina.sh stop -froce

/usr/apache-tomcat-7.0.53/bin/catalina.sh start

service zabbix_agentd stop

service zabbix_agentd start

在zabbix服务器端用工具测试

下载cmdline-jmxclient-0.10.3.jar工具

[root@monitor sbin]# ll

-rwxrwxr-x 1 root root 20124 5月 6 18:38 cmdline-jmxclient-0.10.3.jar

[root@monitor sbin]# pwd

/data/zabbix/sbin

[root@monitor sbin]# java -jar cmdline-jmxclient-0.10.3.jar - 115.159.3.225:12345 java.lang:type=Memory NonHeapMemoryUsage

05/07/2015 15:25:42 +0800 org.archive.jmx.Client NonHeapMemoryUsage:

committed: 53805056

init: 24576000

max: 136314880

used: 53247744

添加防火墙规则,首先停掉防火墙服务

service iptables stop

查看端口情况

[9kgame@VM_11_53_centos ~]$ netstat -anptul Active Internet connections (servers and established) Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 31963/sshd tcp 0 0 0.0.0.0:10050 0.0.0.0:* LISTEN 16827/zabbix_agentd tcp 0 0 :::46800 :::* LISTEN 5030/java tcp 0 0 :::59989 :::* LISTEN 5030/java tcp 0 0 :::22 :::* LISTEN 31963/sshd tcp 0 0 :::12345 :::* LISTEN 5030/java tcp 0 0 ::ffff:127.0.0.1:8035 :::* LISTEN 5030/java

在防火墙里面添加相应规则

vim /etc/sysconfig/iptables -A INPUT -s 1.1.1.1 -p tcp -m tcp --dport 12345 -j ACCEPT -A INPUT -s 1.1.1.1 -p tcp -m tcp --dport 12346 -j ACCEPT service iptables restart

再次进行测试

[root@monitor sbin]# java -jar cmdline-jmxclient-0.10.3.jar - 115.159.3.225:12345 java.lang:type=Memory NonHeapMemoryUsage 05/07/2015 15:25:42 +0800 org.archive.jmx.Client NonHeapMemoryUsage: committed: 53805056 init: 24576000 max: 136314880 used: 53247744

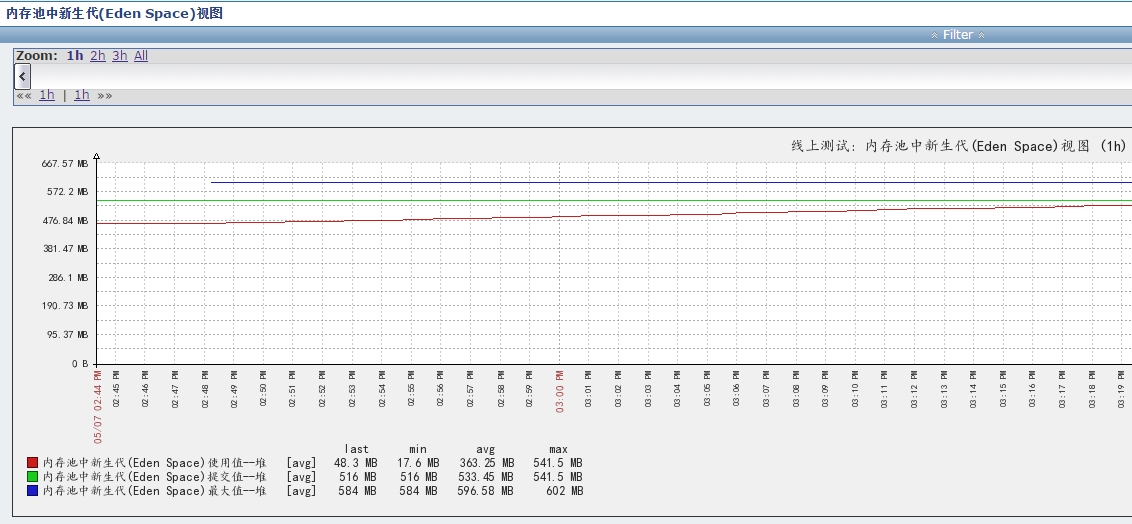

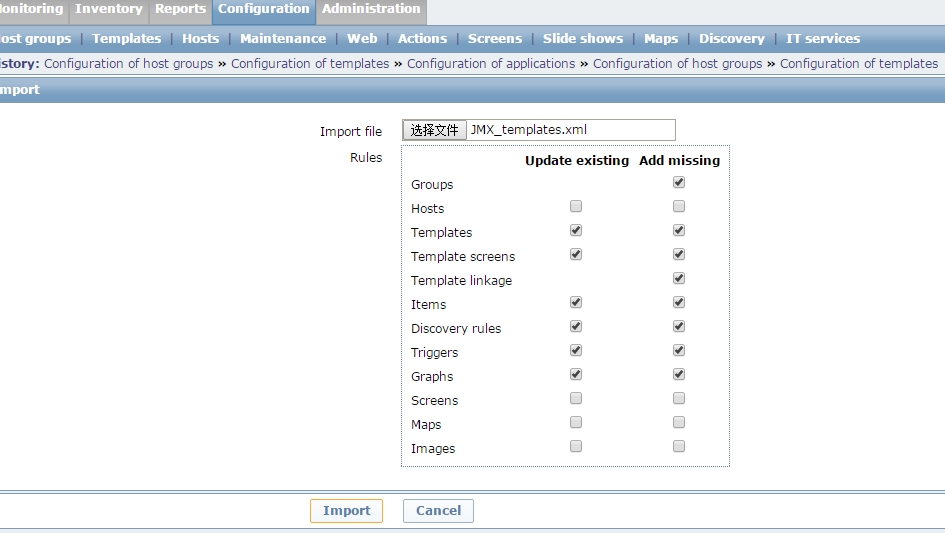

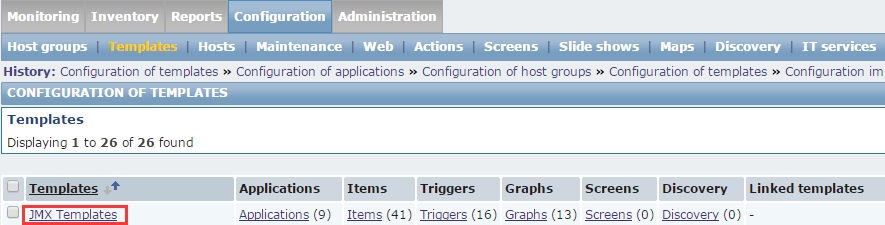

当使用zabbix自带的tomcat模板,不出图。

这里导入群里面朋友提供的一个模板,模板在附件里面。

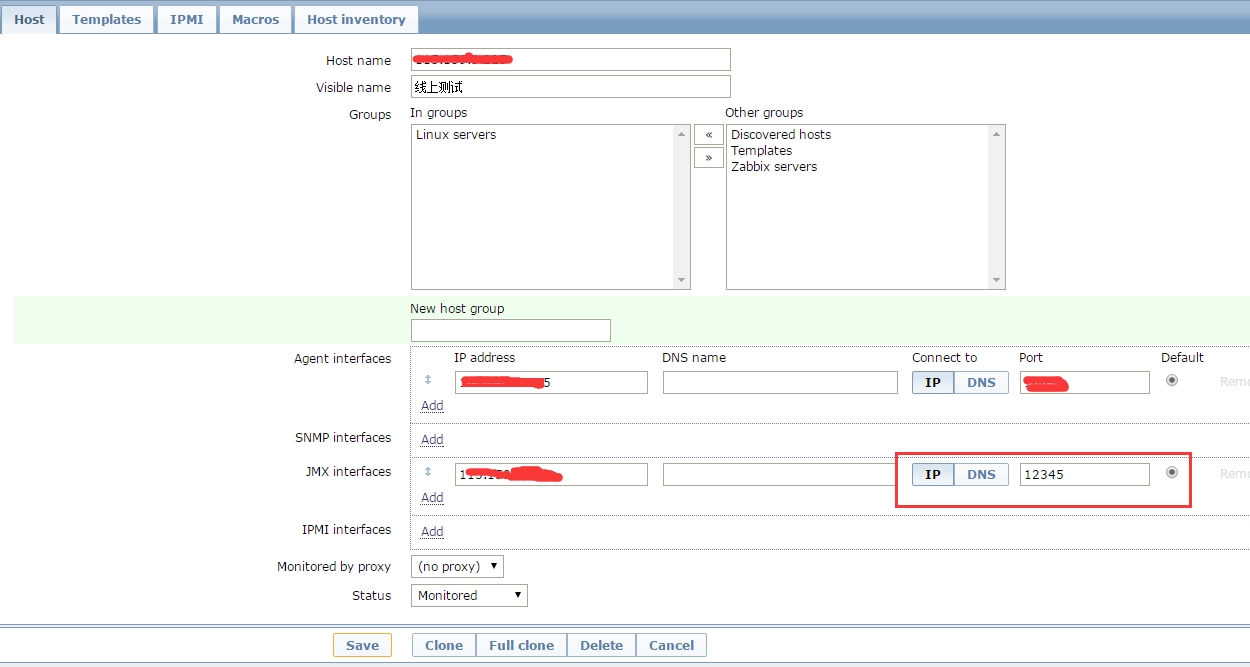

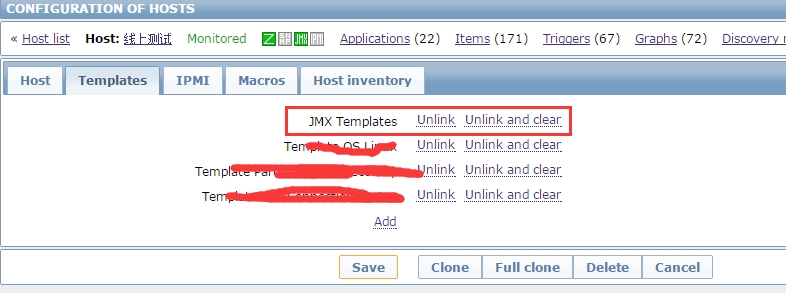

添加相关主机,并将JMX-Templates关联到主机上面

注意这里的IP地址就是tomcat被监控端IP地址,端口port一定要上是上面定义的,我这里使用12345

注意这里的IP地址就是tomcat被监控端IP地址,端口port一定要上是上面定义的,我这里使用12345

关联模板

可以参考:http://lovelace.blog.51cto.com/1028430/1424964

可以参考:http://lovelace.blog.51cto.com/1028430/1424964

http://oceanszf.blog.51cto.com/6268931/1540782

http://www.cnblogs.com/chrisDuan/p/4569312.html

http://www.myexception.cn/industry/1928442.html

https://www.zabbix.com/documentation/2.4/manual/config/items/itemtypes/jmx_monitoring?s[]=jmx

https://www.zabbix.com/documentation/2.4/manual/concepts/java

转载于:https://blog.51cto.com/hao360/1642392

1892

1892

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?