这篇来演示如何使用BeautifulSoup模块来从HTML文本中提取我们想要的数据。update on 2017-08-16:很多网友留言说Unsplash网站改版了,很多内容是动态加载的。所以建议动态加载的内容使用PhantomJS而不是Request库进行请求,如果使用PhantomJS请看我的下一篇博客,如果是定位html文档使用的class等名字更改的话,建议大家根据更改后的内容进行定位,学爬虫重要的是爬取数据的逻辑,逻辑掌握了网站怎么变都不重要啦。

一、运行环境

我的运行环境如下:

- 系统版本

Windows10。 - Python版本

Python3.5,推荐使用Anaconda 这个科学计算版本,主要是因为它自带一个包管理工具,可以解决有些包安装错误的问题。去Anacnda官网,选择Python3.5版本,然后下载安装。 - IDE

我使用的是PyCharm,是专门为Python开发的IDE。这是JetBrians的产品,点我获取更多。

二、模块安装

BeautifulSoup 有多个版本,我们使用BeautifulSoup4。详细信息点击此处获取更多。

使用管理员权限打开cmd命令窗口,在窗口中输入下面的命令即可安装:conda install beautifulsoup4

直接使用Python3.5 没有使用Anaconda版本的童鞋使用下面命令安装:pip install beautifulsoup4

然后我们安装lxml,这是一个解析器,BeautifulSoup可以使用它来解析HTML,然后提取内容。

Anaconda 使用下面命令安装lxml:conda install lxml

使用Python3.5 的童鞋们直接使用pip安装会报错(所以才推荐使用Anaconda版本),安装教程看这里。

如果不安装lxml,则BeautifulSoup会使用Python内置的解析器对文档进行解析。之所以使用lxml,是因为它速度快。

文档解析器对照表如下:

三、BeautifulSoup 库的使用

首先来看BeautifulSoup的对象种类,在使用的过程中就会了解你获取到的东西接下来应该如何操作。

3.1 BeautifulSoup对象的类型

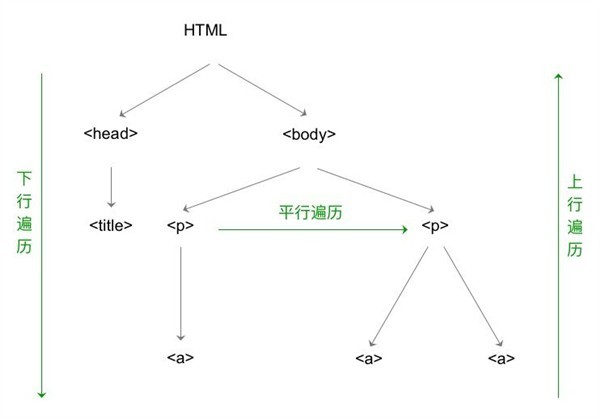

Beautiful Soup将复杂HTML文档转换成一个复杂的树形结构,每个节点都是Python对象。所有对象可以归纳为4种类型: Tag , NavigableString , BeautifulSoup , Comment 。下面我们分别看看这四种类型都是什么东西。

3.1.1 Tag

这个就跟HTML或者XML(还能解析XML?是的,能!)中的标签是一样一样的。我们使用find()方法返回的类型就是这个(插一句:使用find-all()返回的是多个该对象的集合,是可以用for循环遍历的。)。返回标签之后,还可以对提取标签中的信息。

提取标签的名字:

tag.name

提取标签的属性:

tag['attribute']

我们用一个例子来了解这个类型:

from bs4 import BeautifulSoup

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

soup = BeautifulSoup(html_d

本文介绍了Python爬虫新手如何使用BeautifulSoup库解析HTML,包括环境配置、模块安装、BeautifulSoup对象类型及遍历方法。通过实例演示如何获取HTML中的标签、属性、文本内容,并提供了获取网站图片URL的简单爬虫代码。

本文介绍了Python爬虫新手如何使用BeautifulSoup库解析HTML,包括环境配置、模块安装、BeautifulSoup对象类型及遍历方法。通过实例演示如何获取HTML中的标签、属性、文本内容,并提供了获取网站图片URL的简单爬虫代码。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?