随着大语言模型的发展,处理长文本的能力成为了一个重要挑战。虽然有许多方法试图解决这个问题,但都存在不同程度的局限性。最近,阿里巴巴的研究团队提出了一个名为GraphReader的新方法,通过将长文本组织成图结构,并利用智能体来探索这个图,成功提升了模型处理长文本的能力。

GraphReader的核心思想是将长文本分解成关键元素和原子事实,构建成一个图,然后让智能体在这个图中探索和推理。这种方法不仅能有效处理超长文本,还在多跳问答等复杂任务上取得了优异表现。与目前主流的长文本处理方法相比,GraphReader展现出更强的扩展性和鲁棒性。

这个创新方法为大语言模型处理长文本开辟了新的思路,有望在各种需要长文本理解的应用场景中发挥重要作用。接下来,让我们一起深入了解GraphReader的原理和优势。

论文标题:

GraphReader: Building Graph-based Agent to Enhance Long-Context Abilities of Large Language Models

论文链接:

https://arxiv.org/pdf/2406.14550

长文本处理的机遇与挑战

随着人工智能技术的快速发展,大语言模型在各种自然语言处理任务中展现出惊人的能力。然而,处理长文本仍然是一个棘手的问题。现有的方法往往受限于固定的上下文窗口大小,难以有效处理超长文本或需要多步推理的复杂任务。

目前,解决长文本处理问题的方法主要包括模型层面的优化、检索增强生成(RAG)和基于智能体的方法。但这些方法都存在各自的局限性,如需要大量计算资源、难以捕捉长距离依赖关系,或在处理极长文本时效果下降。

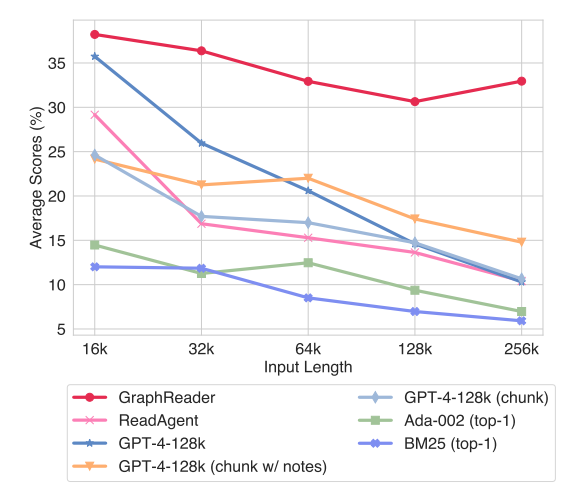

面对这些挑战,阿里巴巴的研究团队提出了GraphReader方法。GraphReader通过将长文本组织成图结构,并利用智能体在图中探索,成功提升了模型处理长文本的能力。在LV-Eval数据集上,GraphReader在各种长度的文本(从16k到256k tokens)上都显著优于其他方法,包括GPT-4-128k。特别是在处理256k tokens长度的文本时,GraphReader仍然保持了较高的性能,而其他方法的性能则大幅下降。

GraphReader为长文本处理提供了创新思路,通过智能组织信息和探索策略,有效突破了传统方法的限制。它不仅能处理超长文本,还在复杂的多跳问答任务中表现出色,为大模型处理长文本提供了一种新的方法。

GraphReader:图结构与智能体的完美结合

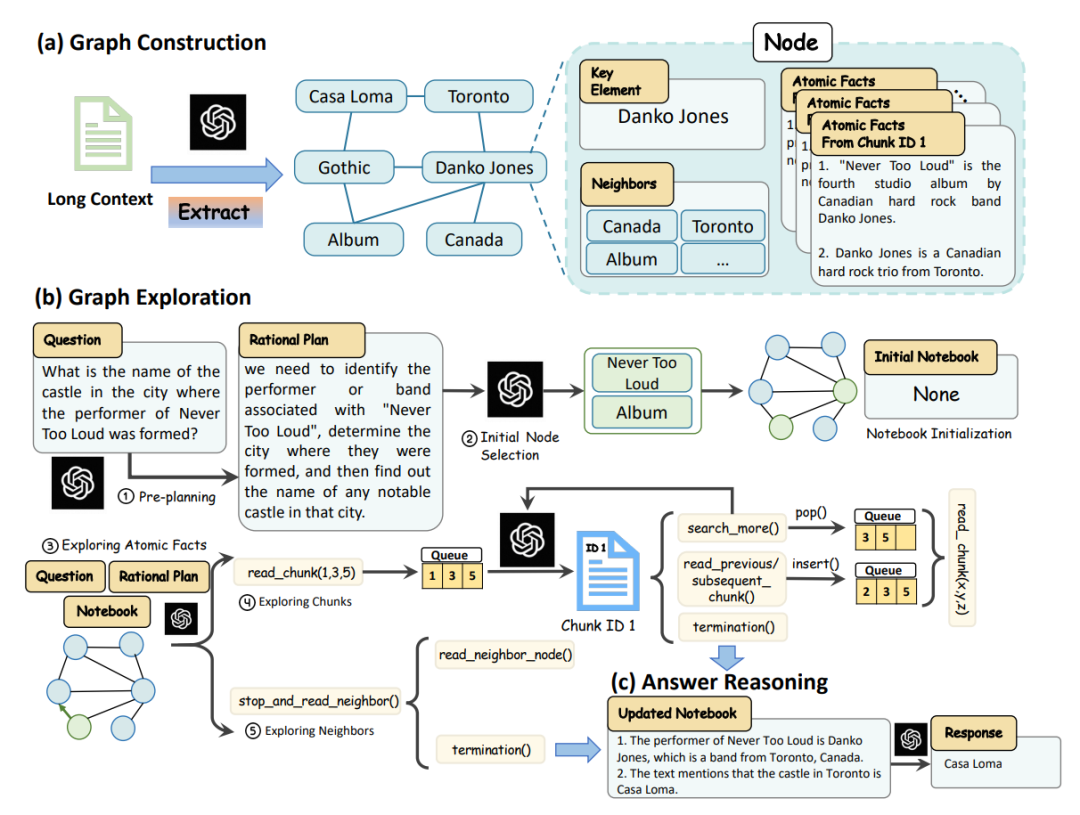

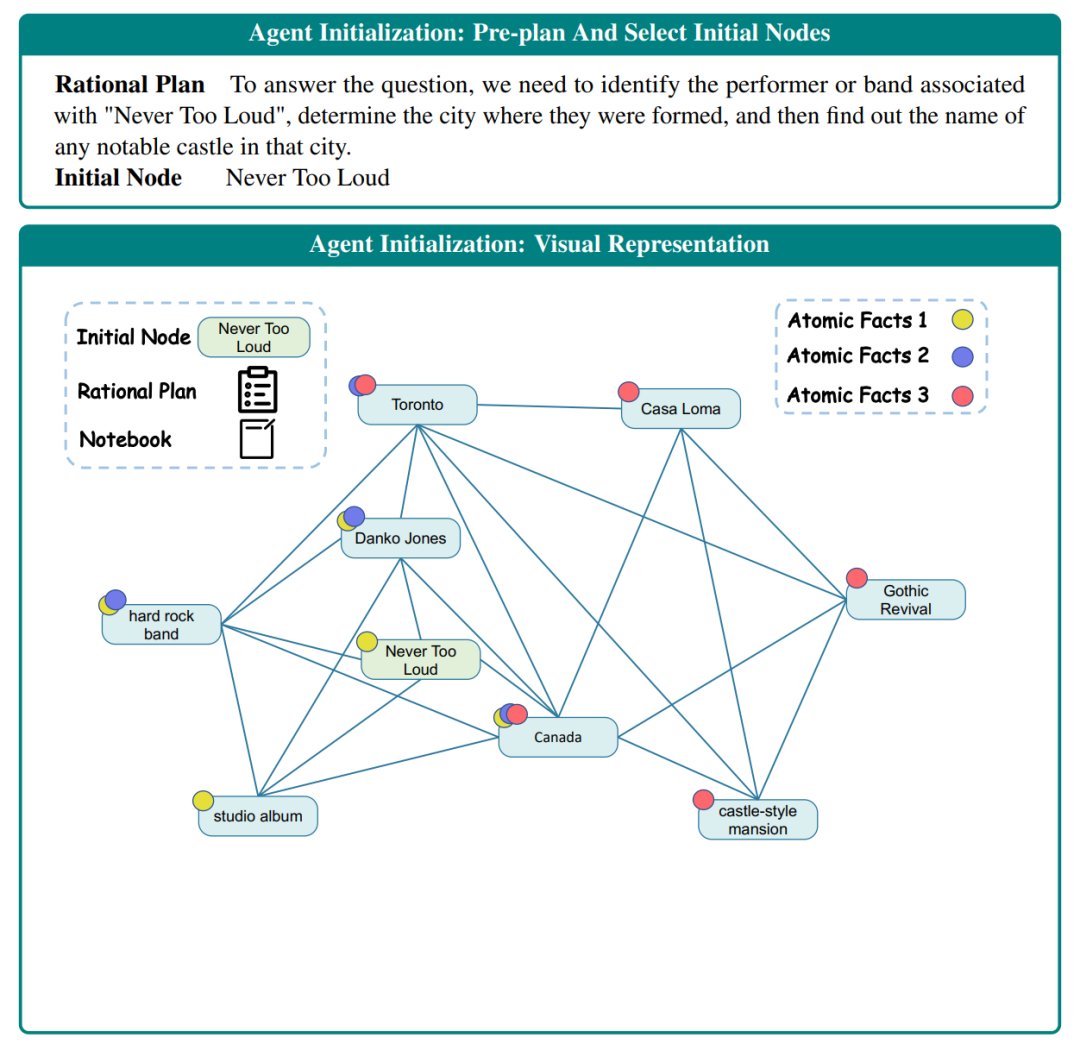

GraphReader方法的核心在于将长文本转化为图结构,并通过智能体在图中进行探索。GraphReader整体的流程如下图所示,整体可以分为图构建与图探索:

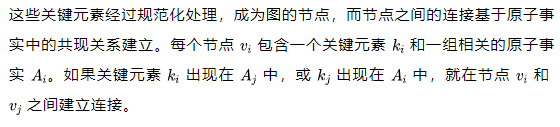

这个过程始于图的构建。首先将长文本分割成最大长度为 的块,保留段落结构。对每个块,GraphReader提取原子事实和关键元素。

- 原子事实是最小的、不可分割的事实单元,以简洁的句子形式呈现。

- 关键元素则包括重要的名词、动词和形容词。

构建完图后,GraphReader初始化智能体来探索这个图。

- 智能体首先根据问题制定一个理性计划,这个计划会分步骤解析问题,确定需要收集的关键信息。

- 然后,智能体从所有节点中选择最相关的N个节点作为起点。

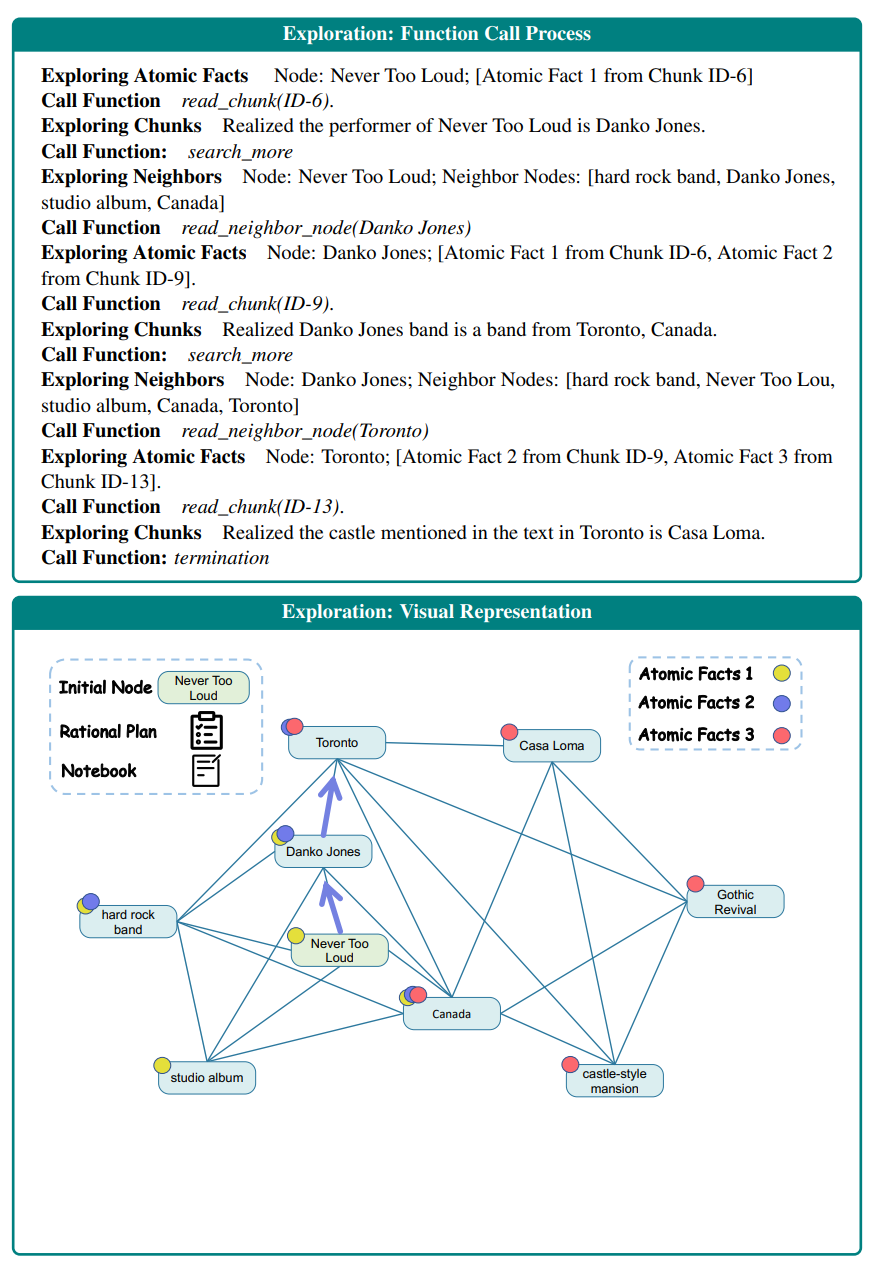

下图展示了智能体的探索过程,它会探索原子事实、文本块和相邻节点,不断更新笔记本中的信息。这个过程通过一系列预定义的函数来实现,如 read_chunk、stop_and_read_neighbor、search_more 等。

在探索过程中,智能体采用粗到细的策略,先阅读原子事实,再根据需要阅读原始文本块。当智能体探索原子事实时,它可以选择 read_chunk 函数来读取相关的文本块,或者选择 stop_and_read_neighbor 函数来探索相邻节点。

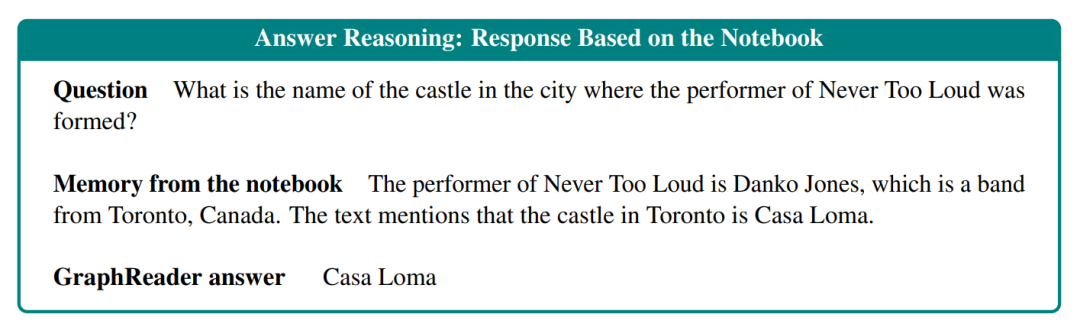

最后,GraphReader根据笔记本中记录的信息进行推理,生成最终的答案。这个过程结合了多路径探索的结果,能够处理复杂的多跳问题。智能体会分析每条探索路径的笔记本内容,考虑其他笔记中的补充信息,并使用多数投票策略解决任何不一致,最终综合所有可用信息生成答案。

通过这种方法,GraphReader能够在有限的上下文窗口内灵活地处理长文本和复杂推理任务。它不仅能有效捕捉长距离依赖关系,还能在多跳问答等任务上展现出优异的性能。

GraphReader的长文本处理结果

GraphReader在多个实验中展现出了卓越的性能,证明了它在处理长文本和复杂推理任务方面的强大能力。

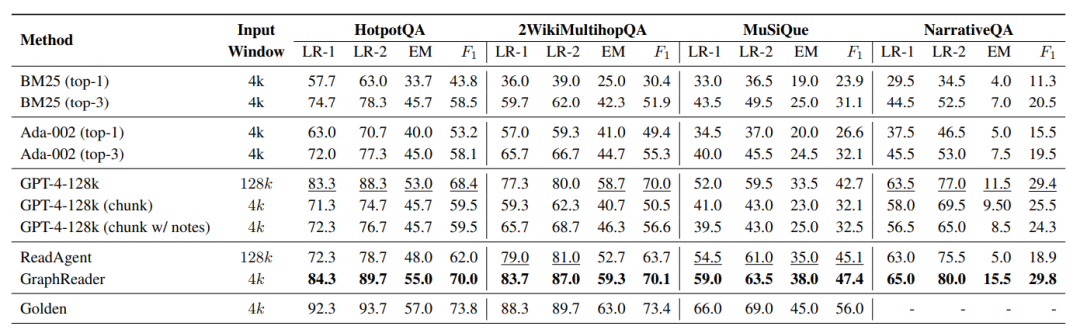

首先,在多跳问答任务上,GraphReader表现出色。在HotpotQA、2WikiMultihopQA和MuSiQue这三个数据集上,GraphReader均取得了最佳性能。特别值得注意的是,GraphReader仅使用4k的上下文窗口,就超越了包括GPT-4-128k在内的所有基线方法。例如,在HotpotQA数据集上,GraphReader的LR-1和LR-2评分分别达到84.3%和89.7%,而GPT-4-128k的评分为83.3%和88.3%。这一结果充分证明了GraphReader在处理复杂推理任务时的优势。

在单跳长文本问答任务上,GraphReader同样表现优异。在NarrativeQA数据集上,GraphReader的LR-1和LR-2评分分别为65.0%和80.0%,显著高于其他方法。这证明了GraphReader不仅在多跳任务上有优势,在处理长文本的单跳问题上也表现出色。

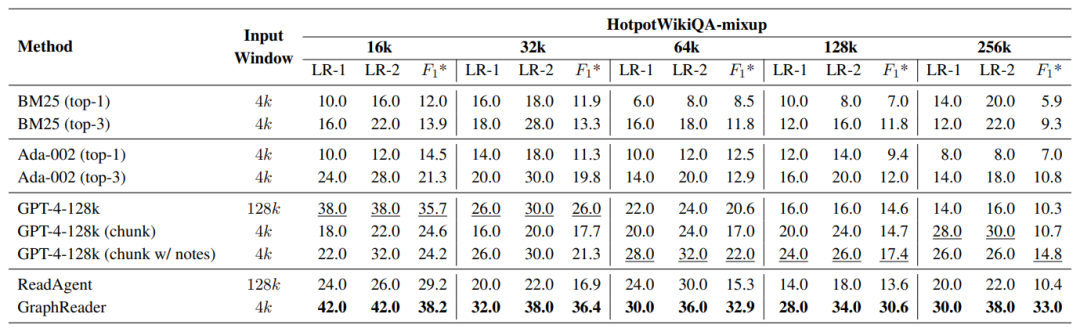

GraphReader在超长文本处理上展现出较好的表现。在HotpotWikiQA-mixup数据集上,GraphReader在从16k到256k不同长度的文本上都保持了优异的性能。特别是在256k长度的文本上,GraphReader的LR-1和LR-2评分分别为30.0%和38.0%,而GPT-4-128k的评分仅为14.0%和16.0%。

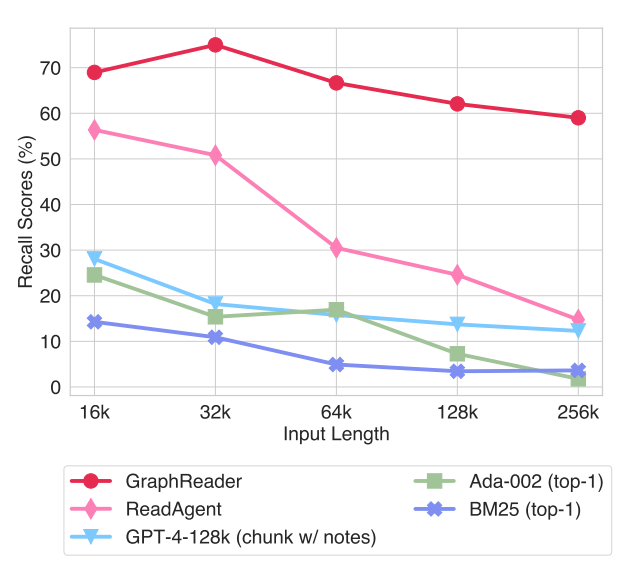

下图进一步展示了GraphReader在不同文本长度下的支持事实召回率。可以看到,随着文本长度的增加,所有方法的召回率都有所下降,但GraphReader的下降幅度最小。在256k长度的文本上,GraphReader仍然保持约60%的召回率,而其他方法的召回率大幅下降。

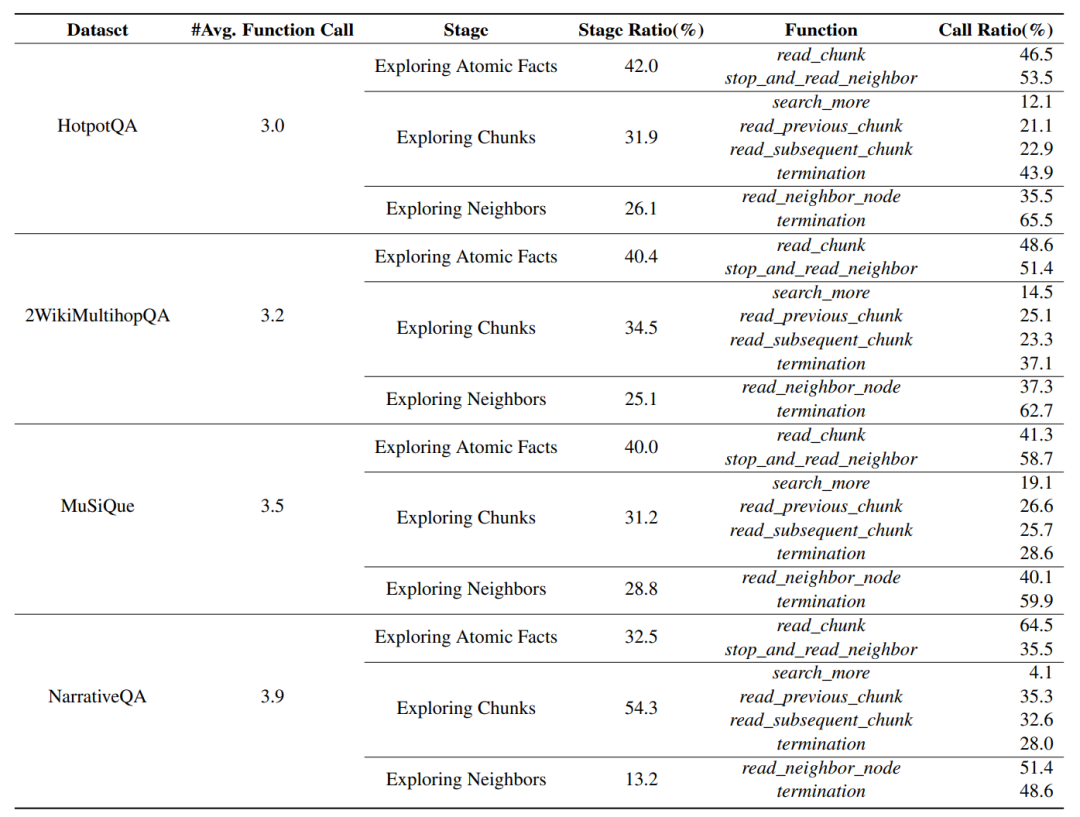

为了深入理解GraphReader的工作机制,研究团队还进行了详细的功能调用分析和图结构统计。在不同类型的任务中,GraphReader会采用不同的功能调用模式。例如,在多跳问答任务中,读取相邻节点是最常用的操作,而在单跳问答任务中,读取文本块是最频繁的操作。这种灵活的调用策略使GraphReader能够适应不同类型的问题。

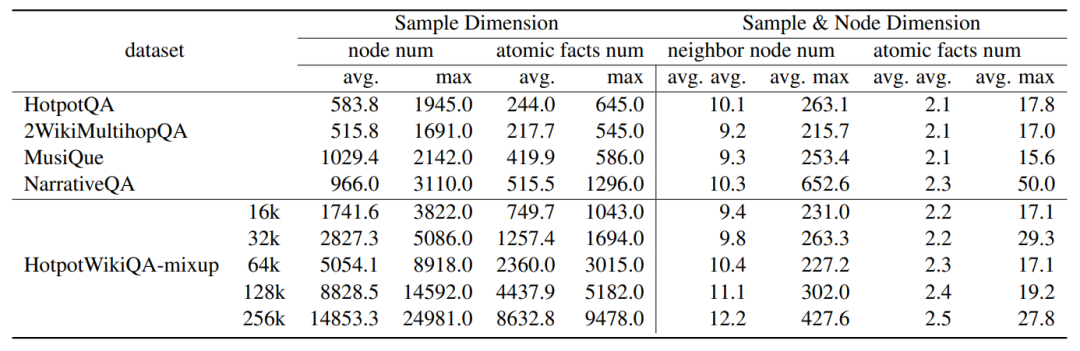

下表展示了构建的图结构统计数据。可以看到,随着文本长度的增加,图中的节点数和原子事实数也相应增加。平均每个节点有约10个相邻节点,每个节点平均关联2个原子事实。这种结构使得GraphReader能够有效地组织和利用长文本中的信息。

总的来说,这些实验结果充分证明了GraphReader在处理长文本和复杂推理任务方面的卓越能力。它不仅在各种长度的文本上都表现出色,而且在多跳和单跳问答任务中都展现出了显著的优势。GraphReader的这种"魔法"般的表现,为长文本处理领域带来了新的可能性。

GraphReader的潜力与未来方向

GraphReader为长文本处理开辟了一条创新之路。通过将长文本组织成图结构,并利用智能体进行探索,它成功突破了传统方法的限制。实验结果表明,GraphReader不仅能处理超长文本,还在复杂的多跳问答任务上表现出色,甚至超越了GPT-4-128k等强大模型。

尽管取得了显著成果,GraphReader仍有进一步改进的空间。未来的研究方向可以包括:优化图的构建和探索过程以提高效率;验证GraphReader在其他长文本处理任务中的效果;探索与其他先进自然语言处理技术的结合;以及开发开源版本以促进更广泛的应用和改进。

总的来说,GraphReader为解决长文本处理这一关键挑战提供了一个有前景的解决方案。随着进一步的研究和优化,它有望在各种需要长文本理解的应用场景中发挥重要作用,推动自然语言处理技术的进一步发展。

527

527

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?