简介:本压缩包包含了实现CSV和JSON文件相互转换的资源,包括程序脚本、转换示例和相关技术文档。用户可以利用这些工具将JSON数据转换为CSV格式,反之亦然,并处理CSV文件的列提取与制表等任务。此外,用户将获得一个符合转换规范的JSON文件示例,以便测试脚本功能并理解输入输出格式。

1. CSV和JSON格式简介

1.1 CSV格式

CSV(逗号分隔值)是一种常见的文本文件格式,用于存储结构化数据表格。它通过逗号分隔每个字段,每行代表一条记录。CSV文件的优点在于简单易读,广泛支持在各种软件和编程语言中进行数据交换。

1.1.1 CSV格式的特点

- 简单性 :CSV文件由纯文本组成,每行代表一个数据记录,字段间通常用逗号分隔。

- 兼容性 :几乎所有编程语言和应用程序都支持CSV格式,使其成为数据交换的通用语言。

1.1.2 CSV的应用场景

- 数据导入导出 :数据库管理系统、电子表格软件(如Microsoft Excel)常用于数据导入导出。

- 日志记录 :系统日志和应用日志常以CSV格式存储,便于分析和处理。

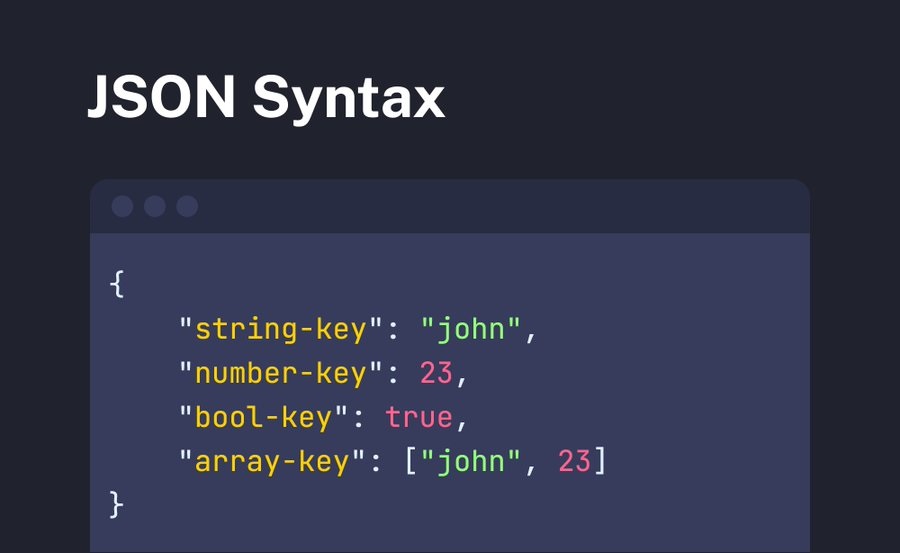

1.2 JSON格式

JSON(JavaScript对象表示法)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。JSON格式支持嵌套的数据结构,适合表示复杂的数据关系。

1.2.1 JSON格式的特点

- 可读性 :JSON格式清晰,易于理解,结构直观。

- 互操作性 :JSON被大多数编程语言支持,可以轻松在不同语言间转换数据。

1.2.2 JSON的应用场景

- Web服务 :JSON是现代Web应用中数据交互的标准格式,常用于Web服务API的请求和响应数据。

- 配置文件 :由于其可读性和易编辑性,JSON也常用于配置文件。

1.2.3 CSV与JSON的比较

- 结构差异 :CSV是平面表格数据,适合简单数据;JSON支持嵌套结构,适合复杂数据。

- 处理复杂性 :JSON的解析通常比CSV复杂,需要更强大的数据处理能力。

在接下来的章节中,我们将深入探讨如何在Python中使用csv和json模块来处理这两种格式的数据,以及如何实现数据转换、优化处理和脚本编写等高级功能。

2. Python3的csv模块使用

2.1 csv模块的基本操作

2.1.1 csv文件的读取和写入

在本章节中,我们将探讨如何使用Python3中的csv模块来读取和写入CSV文件。CSV(Comma-Separated Values,逗号分隔值)文件是一种常见的文本文件格式,用于存储表格数据,通常使用逗号作为字段分隔符。

首先,我们来看如何读取CSV文件。Python3的csv模块提供了一个 csv.reader 对象,它可以帮助我们逐行读取CSV文件。以下是读取CSV文件的基本步骤:

import csv

# 打开CSV文件

with open('example.csv', 'r') as csv***

* 创建csv.reader对象

reader = csv.reader(csvfile)

# 逐行读取

for row in reader:

print(row)

在这个例子中,我们首先导入了csv模块,然后使用 with 语句打开一个名为 example.csv 的文件。 csv.reader 对象被创建,并用来逐行读取文件内容。每行内容被读取为一个列表,列表中的每个元素对应一列数据。

写入CSV文件的过程与读取类似,但这里我们使用 csv.writer 对象。以下是写入CSV文件的基本步骤:

import csv

# 要写入的数据

data = [

['Name', 'Age', 'City'],

['Alice', '24', 'New York'],

['Bob', '27', 'Los Angeles']

]

# 打开CSV文件

with open('output.csv', 'w', newline='') as csv***

* 创建csv.writer对象

writer = csv.writer(csvfile)

# 写入数据

writer.writerows(data)

在这个例子中,我们首先定义了一个名为 data 的列表,其中包含了要写入CSV文件的数据。然后,我们打开一个名为 output.csv 的文件,并创建了一个 csv.writer 对象。最后,我们使用 writer.writerows() 方法将数据写入文件。

2.1.2 csv文件的分割和合并

CSV文件的分割和合并是数据处理中常见的操作。在本节中,我们将探讨如何使用Python的csv模块来实现这些操作。

CSV文件的分割通常是指将一个大的CSV文件分割成多个小的CSV文件,每个文件包含原始文件的一部分数据。这可以通过逐行读取原始文件并写入新的文件来实现。以下是分割CSV文件的一个示例:

import csv

# 打开原始CSV文件

with open('large.csv', 'r') as large***

* 创建csv.reader对象

reader = csv.reader(largefile)

# 打开新文件

with open('small1.csv', 'w', newline='') as smallfile1:

writer1 = csv.writer(smallfile1)

# 写入前5行数据

writer1.writerows(next(reader) for _ in range(5))

with open('small2.csv', 'w', newline='') as smallfile2:

writer2 = csv.writer(smallfile2)

# 写入接下来的5行数据

writer2.writerows(next(reader) for _ in range(5))

在这个例子中,我们首先打开一个名为 large.csv 的大型CSV文件,并创建了一个 csv.reader 对象。然后,我们创建了两个新的CSV文件 small1.csv 和 small2.csv ,并分别为它们创建了 csv.writer 对象。我们使用 next(reader) 来读取原始文件的下一行,并将其写入新文件。这样,我们就将一个大的CSV文件分割成了两个较小的文件。

CSV文件的合并是指将多个CSV文件合并成一个大的CSV文件。这可以通过逐个读取每个文件并将它们的数据写入到一个新的CSV文件来实现。以下是合并CSV文件的一个示例:

import csv

# 要合并的CSV文件列表

filenames = ['small1.csv', 'small2.csv']

# 创建一个csv.writer对象

writer = csv.writer(open('merged.csv', 'w', newline=''))

# 逐个读取文件并写入数据

for filename in filenames:

with open(filename, 'r') as csv***

***

* 跳过表头

next(reader)

# 写入数据

writer.writerows(reader)

在这个例子中,我们首先定义了一个名为 filenames 的列表,其中包含了要合并的CSV文件的名称。然后,我们创建了一个 csv.writer 对象,并打开一个名为 merged.csv 的新文件。接着,我们逐个打开要合并的文件,创建 csv.reader 对象,并逐行读取数据(跳过表头)。最后,我们将读取的数据写入到新文件中。

通过本章节的介绍,我们了解了如何使用Python3的csv模块来处理CSV文件的基本操作,包括读取、写入、分割和合并。这些操作对于数据预处理和数据分析是非常有用的。在接下来的章节中,我们将探讨csv模块的高级功能,例如字段类型转换和表头与行数据处理。

3. Python3的json模块使用

在本章节中,我们将深入了解Python3中json模块的使用,包括其基本操作和高级功能。json(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成。Python3通过内置的json模块提供了对json数据格式的支持。

3.1 json模块的基本操作

3.1.1 json数据的解析和生成

在处理json数据时,我们经常需要将其解析为Python中的数据结构(如字典或列表),或者将Python数据结构转换为json格式。Python的json模块提供了 json.loads() 函数用于解析json格式的字符串,以及 json.dumps() 函数用于生成json格式的字符串。

import json

# json字符串

json_str = '{"name": "John", "age": 30, "city": "New York"}'

# 解析json字符串为Python对象

person = json.loads(json_str)

print(person) # 输出: {'name': 'John', 'age': 30, 'city': 'New York'}

# 将Python对象转换为json字符串

json_str = json.dumps(person)

print(json_str) # 输出: {"name": "John", "age": 30, "city": "New York"}

参数说明

-

json.loads(s[, encoding[, cls[, object_hook[, parse_float[, parse_int[, parse_constant[, object_pairs_hook[, **kw]]]]]]]]):将json字符串s解析为Python对象。 -

json.dumps(obj[, skipkeys[, ensure_ascii[, check_circular[, allow_nan[, cls[, indent[, separators[, default[, **kw]]]]]]]]]):将Python对象obj转换为json字符串。

代码逻辑解读

在上述代码中,我们首先导入了 json 模块,并定义了一个json格式的字符串 json_str 。使用 json.loads() 函数将这个字符串解析为一个Python的字典对象 person 。然后,我们使用 json.dumps() 函数将这个字典对象转换回json格式的字符串。

3.1.2 json数据的编码和解码

除了直接解析和生成json字符串,json模块还提供了文件读写的功能,可以对json数据进行编码和解码操作。

import json

# 将Python对象写入json文件

person = {"name": "John", "age": 30, "city": "New York"}

with open('person.json', 'w') as f:

json.dump(person, f, indent=4)

# 从json文件读取数据

with open('person.json', 'r') as f:

person = json.load(f)

print(person)

参数说明

-

json.dump(obj, fp[, skipkeys[, ensure_ascii[, check_circular[, cls[, indent[, separators[, default[, **kw]]]]]]]]]):将Python对象obj编码为json格式,并写入文件对象fp。 -

json.load(fp[, cls[, object_hook[, parse_float[, parse_int[, parse_constant[, object_pairs_hook[, **kw]]]]]]]):从文件对象fp读取数据,并将其解码为Python对象。

代码逻辑解读

在上述代码中,我们首先定义了一个Python字典对象 person ,然后使用 json.dump() 函数将其写入到一个名为 person.json 的文件中。接着,我们使用 json.load() 函数从该文件中读取数据,并将其解码回Python对象。

3.2 json模块的高级功能

3.2.1 非标准数据处理

json模块支持标准的数据类型转换,包括字符串、数值、列表、字典等。但在处理一些非标准数据时,例如Python中的 datetime 对象,我们需要自定义编码器和解码器。

from datetime import datetime

import json

class DateTimeEncoder(json.JSONEncoder):

def default(self, obj):

if isinstance(obj, datetime):

return obj.isoformat()

return json.JSONEncoder.default(self, obj)

# 使用自定义编码器

person = {"name": "John", "birthday": datetime.now()}

json_str = json.dumps(person, cls=DateTimeEncoder)

print(json_str)

# 使用自定义解码器

def decode_datetime(obj):

if isinstance(obj, str):

return datetime.fromisoformat(obj)

return obj

person = json.loads(json_str, object_hook=decode_datetime)

print(person)

参数说明

-

cls:自定义编码器类,需要继承json.JSONEncoder。 -

object_hook:自定义解码器函数,用于解码json字符串。

代码逻辑解读

在上述代码中,我们首先定义了一个 DateTimeEncoder 类,它继承自 json.JSONEncoder 并重写了 default 方法,用于处理 datetime 对象。接着,我们创建了一个包含 datetime 对象的 person 字典,并使用 json.dumps() 函数将其转换为json字符串,同时传入 cls 参数。最后,我们定义了一个 decode_datetime 函数,用于在解码json字符串时将日期时间字符串转换回 datetime 对象。

3.2.2 大型数据集的优化处理

处理大型数据集时,将所有数据加载到内存中可能会导致内存不足的问题。为了优化内存使用,我们可以使用 json.JSONDecoder 的 raw_decode 方法逐块读取和解析json数据。

import json

import io

# 模拟大文件

large_json = '{"name": "John", "age": 30}\n{"name": "Jane", "age": 25}'

large_file = io.StringIO(large_json)

# 自定义解码器

def decode_large_json(data):

decoder = json.JSONDecoder()

while True:

try:

obj, index = decoder.raw_decode(data)

yield obj

data = data[index:].lstrip()

except json.JSONDecodeError:

break

for person in decode_large_json(large_file.read()):

print(person)

参数说明

-

raw_decode(s[, idx]):从字符串s的idx位置开始解码,返回一个包含解码对象和下一个索引的元组。

代码逻辑解读

在上述代码中,我们首先模拟了一个包含多个json对象的大文件。然后,我们定义了一个 decode_large_json 函数,该函数使用 json.JSONDecoder 的 raw_decode 方法逐块读取和解析json数据。通过不断更新索引,我们可以逐个解码json对象,而不是一次性将整个文件加载到内存中。

在本章节中,我们介绍了Python3中json模块的基本操作和高级功能。通过这些知识,我们可以有效地处理json数据,无论是标准数据还是非标准数据,甚至是大型数据集。接下来的章节,我们将继续深入探讨数据转换技术的实现。

4. 数据转换技术实现

在本章节中,我们将深入探讨数据转换的基本概念和实践操作。数据转换是数据处理中的一个重要环节,它涉及到不同类型和结构的数据转换,以满足特定的应用需求。我们将从数据类型转换和数据结构转换两个基本概念出发,逐步深入到实践操作中的键值对映射和数据清洗预处理。

4.1 数据转换的基本概念

4.1.1 数据类型转换

数据类型转换是指将数据从一种类型转换为另一种类型的过程。在Python中,这通常涉及到内置类型的转换,如将字符串转换为整数或浮点数,或者将列表转换为字典等。在数据处理的实际应用中,数据类型转换还包括从一种数据格式转换为另一种数据格式,例如将CSV文件中的数据转换为JSON格式。

4.1.2 数据结构转换

数据结构转换是指改变数据的组织方式,以适应不同的需求或目标格式。例如,将表格数据转换为树状结构,或者将一个复杂的嵌套字典转换为扁平化的键值对列表。

4.2 数据转换的实践操作

4.2.1 键值对映射

键值对映射是数据转换中的一个常见操作,它涉及到将数据集中的元素映射到键值对的形式。例如,将CSV文件中的每一行转换为字典形式,其中列标题作为键,对应的单元格值作为值。

4.2.2 数据清洗和预处理

数据清洗是数据转换过程中不可或缺的一部分。它涉及到去除重复数据、填充缺失值、纠正错误等。预处理则是指在数据转换之前对数据进行的一系列准备操作,以确保转换过程的顺利进行。

实践操作详解

为了更好地理解数据转换的实践操作,我们将通过一个简单的例子来进行说明。假设我们有一个CSV文件,需要将其转换为JSON格式,并进行一些基本的数据清洗。

import csv

import json

# 读取CSV文件并转换为字典列表

def read_csv_to_dicts(csv_filename):

with open(csv_filename, 'r', newline='', encoding='utf-8') as csv***

***

***

***

* 数据清洗:移除空值

def clean_data(data_dicts):

cleaned_data = [d for d in data_dicts if all(d.values())]

return cleaned_data

# 将字典列表转换为JSON字符串

def convert_to_json(data_dicts):

json_data = json.dumps(data_dicts, indent=4)

return json_data

# 主函数

def main(csv_filename):

# 读取CSV数据

data_dicts = read_csv_to_dicts(csv_filename)

# 清洗数据

cleaned_data = clean_data(data_dicts)

# 转换为JSON

json_data = convert_to_json(cleaned_data)

# 输出JSON数据

print(json_data)

# 执行主函数

if __name__ == '__main__':

main('input.csv')

代码逻辑解读分析

在上述代码中,我们首先定义了三个函数:

-

read_csv_to_dicts:读取CSV文件并将其转换为字典列表。 -

clean_data:对字典列表进行数据清洗,移除包含空值的字典。 -

convert_to_json:将字典列表转换为JSON字符串。

在主函数 main 中,我们依次调用这些函数,并将CSV文件转换为JSON格式,同时完成了数据清洗的工作。

参数说明

-

csv_filename:输入的CSV文件名。 -

data_dicts:包含CSV文件中每行数据的字典列表。 -

cleaned_data:清洗后的数据列表。 -

json_data:JSON格式的字符串。

通过本章节的介绍,我们了解了数据转换的基本概念和实践操作。在接下来的章节中,我们将继续探讨CSV列提取和制表功能的实现方法。

5. CSV列提取和制表功能

在本章节中,我们将深入探讨如何使用Python进行CSV文件的列提取和制表功能,以及如何结合制表和分割进行数据处理。这些操作在数据分析和数据处理中非常常见,因为CSV文件是一种非常流行的存储结构化数据的方式。

5.1 列提取的基本方法

5.1.1 使用csv模块进行列提取

CSV文件的列提取是一个简单而实用的操作。使用Python的 csv 模块可以轻松地完成这一任务。下面我们将通过一个示例来展示如何实现列提取。

import csv

# 打开CSV文件

with open('example.csv', 'r') as csv***

* 创建CSV阅读器

reader = csv.reader(csvfile)

# 遍历每一行

for row in reader:

# 提取特定列,例如第二列

specific_column = row[1]

print(specific_column)

在上述代码中,我们首先导入了 csv 模块,然后使用 open 函数打开了一个名为 example.csv 的文件。接着,我们创建了一个CSV阅读器,并遍历了CSV文件中的每一行。在遍历过程中,我们通过索引访问了每一行的特定列(在这个例子中是第二列)并将其打印出来。

5.1.2 使用正则表达式提取列

除了使用 csv 模块,我们还可以使用正则表达式来提取CSV文件中的列。这种方法在处理格式不规范的CSV文件时特别有用。

import re

# 定义一个正则表达式,用于匹配CSV中的列

csv_regex = ***pile(r'(".*?"|[^,]+)')

# 读取CSV文件内容

with open('example.csv', 'r') as csv***

***

* 使用正则表达式提取所有列

columns = csv_regex.findall(content)

# 打印所有列

for column in columns:

print(column)

在上面的代码中,我们首先定义了一个正则表达式 csv_regex ,用于匹配引号内的内容或者引号外的任何字符。然后,我们读取了CSV文件的全部内容,并使用 findall 方法找到了所有匹配的列。最后,我们遍历并打印了所有提取的列。

5.2 制表功能的实现

5.2.1 制表符的使用和设置

在处理CSV文件时,我们可能需要将数据转换为制表符分隔的文本,以便于在某些特定的软件中使用,比如Excel或者某些数据分析工具。我们可以使用Python的 csv 模块来实现这一功能。

import csv

# 定义输出的制表符分隔文件名

output_filename = 'example.tsv'

# 打开CSV文件

with open('example.csv', 'r') as csvfile, open(output_filename, 'w') as.tsv***

* 创建CSV阅读器

reader = csv.reader(csvfile)

# 创建TSV写入器

writer = csv.writer(tsvfile, delimiter='\t')

# 遍历CSV文件的每一行

for row in reader:

# 将行数据转换为制表符分隔的格式,并写入TSV文件

writer.writerow(row)

在上面的代码中,我们首先定义了输出的制表符分隔文件名。然后,我们打开CSV文件进行读取,并创建了一个TSV文件进行写入。我们使用 csv.writer 函数创建了一个TSV写入器,并设置了分隔符为制表符 \t 。接着,我们遍历了CSV文件的每一行,并使用 writerow 方法将每一行写入TSV文件。

5.2.2 制表和分割结合的数据处理

有时,我们可能需要将CSV文件中的数据进行分割,并且每个分割后的部分再进行制表处理。这可以通过结合使用Python的字符串分割方法和 csv 模块来实现。

import csv

# 打开CSV文件

with open('example.csv', 'r') as csv***

* 读取CSV文件内容

content = csvfile.read()

# 分割CSV文件内容为行

rows = content.split('\n')

# 定义制表符分隔文件名

output_filename = 'example_split.tsv'

# 打开TSV文件

with open(output_filename, 'w') as tsv***

* 遍历每一行

for row in rows:

# 分割每一行的数据为列

columns = row.split(',')

# 创建TSV写入器

writer = csv.writer(tsvfile, delimiter='\t')

# 将列数据写入TSV文件

writer.writerow(columns)

在上述代码中,我们首先读取了CSV文件的全部内容,并将其分割为行。然后,我们遍历每一行,将其分割为列,并创建了一个TSV文件进行写入。在这个过程中,我们使用了 csv.writer 函数,并设置了分隔符为制表符 \t 。

通过本章节的介绍,我们了解了如何使用Python进行CSV文件的列提取和制表功能。我们学习了使用 csv 模块和正则表达式进行列提取,以及如何将CSV文件转换为制表符分隔的TSV文件。这些技能在数据预处理和分析中非常有用。在下一章节中,我们将继续探讨Python脚本的编写和操作,以及如何将这些数据处理技术应用于实际的脚本编写中。

6. Python脚本编写和操作

6.1 Python脚本的基础知识

Python脚本是用Python语言编写的源代码文件,可以在Python环境中执行。编写规范的Python脚本对于代码的可读性和可维护性至关重要。

6.1.1 脚本结构和编写规范

一个标准的Python脚本通常包含以下几个部分:

- 文档字符串(docstring) :通常位于脚本的最顶部,用于简要描述脚本的功能和使用方法。

- 导入模块 :按照PEP 8规范,将

import语句放在脚本顶部。 - 全局变量 :尽量避免使用全局变量,以减少副作用。

- 函数定义 :将代码分解为多个函数,每个函数完成一个功能。

- 主逻辑块 :包含脚本的主要执行逻辑。

"""这是一个简单的Python脚本示例

描述:这个脚本用于演示基本的脚本结构和编写规范。

import sys

def say_hello(name):

"""向指定的人问好"""

print(f"Hello, {name}!")

def main():

if len(sys.argv) > 1:

name = sys.argv[1]

say_hello(name)

else:

print("Usage: python script.py [name]")

if __name__ == "__main__":

main()

6.1.2 脚本的调试和优化

调试脚本是确保脚本正确执行的关键步骤,常用的调试方法包括:

- 使用

print()函数进行日志记录 :输出变量值或程序执行状态,帮助定位问题。 - 使用

pdb模块 :Python的内置调试工具,可以设置断点、单步执行等。 - 代码优化 :重构代码以提高效率,例如使用列表推导式、生成器等。

# 使用pdb进行调试

import pdb

def main():

pdb.set_trace()

# 执行主逻辑

if __name__ == "__main__":

main()

6.2 Python脚本的应用实践

Python脚本在自动化任务和数据处理方面应用广泛,可以处理从简单的文件操作到复杂的机器学习模型训练等任务。

6.2.1 自动化任务脚本编写

自动化脚本可以简化日常重复工作,提高效率。例如,可以编写一个脚本来自动化备份文件。

import shutil

import os

def backup_folder(source_folder, backup_folder):

"""备份文件夹"""

if not os.path.exists(backup_folder):

os.makedirs(backup_folder)

for filename in os.listdir(source_folder):

file_path = os.path.join(source_folder, filename)

if os.path.isfile(file_path):

shutil.copy(file_path, backup_folder)

if __name__ == "__main__":

source_folder = '/path/to/source'

backup_folder = '/path/to/backup'

backup_folder(source_folder, backup_folder)

6.2.2 复杂数据处理脚本编写

Python强大的标准库和第三方库使其成为处理复杂数据的理想选择。例如,使用 pandas 库来处理CSV文件中的数据。

import pandas as pd

def process_csv_data(file_path, output_path):

"""处理CSV文件数据"""

data = pd.read_csv(file_path)

# 进行数据处理,例如:清洗、转换等

data.to_csv(output_path, index=False)

if __name__ == "__main__":

file_path = '/path/to/input.csv'

output_path = '/path/to/output.csv'

process_csv_data(file_path, output_path)

在实际应用中,Python脚本可以根据需求进行编写,以适应不同的工作流程和数据处理场景。通过使用Python提供的各种模块和库,可以大大简化和自动化许多复杂的任务。

简介:本压缩包包含了实现CSV和JSON文件相互转换的资源,包括程序脚本、转换示例和相关技术文档。用户可以利用这些工具将JSON数据转换为CSV格式,反之亦然,并处理CSV文件的列提取与制表等任务。此外,用户将获得一个符合转换规范的JSON文件示例,以便测试脚本功能并理解输入输出格式。

2308

2308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?