简介:网络爬虫是自动遍历并抓取网页信息的工具,Java因跨平台、稳定性和强大的库支持在爬虫开发中十分流行。Websphinx是Java开发的网络爬虫框架,本课程将探讨Java在网络爬虫开发中的关键知识点,包括HTTP通信、HTML解析、数据存储、多线程处理、URL管理、延迟加载与JavaScript处理、异常处理、IP代理、日志记录以及分布式爬虫的设计和实现。通过深入学习Websphinx框架,学生将掌握如何构建高效、稳定的爬虫系统,提升网络数据挖掘的能力。

1. Java在网络爬虫中的应用

简介

Java作为一种成熟的编程语言,其强大的网络功能和丰富的库支持使其在网络爬虫开发中得到广泛应用。网络爬虫(Web Crawler),也被称为网络蜘蛛(Web Spider)或网络机器人(Web Robot),是一种按照一定的规则,自动抓取互联网信息的程序或脚本。在大数据、搜索引擎、内容监测等众多应用场景中,Java网络爬虫扮演着重要角色。

Java的网络爬虫优势

Java在开发网络爬虫时的优势主要体现在以下几点:

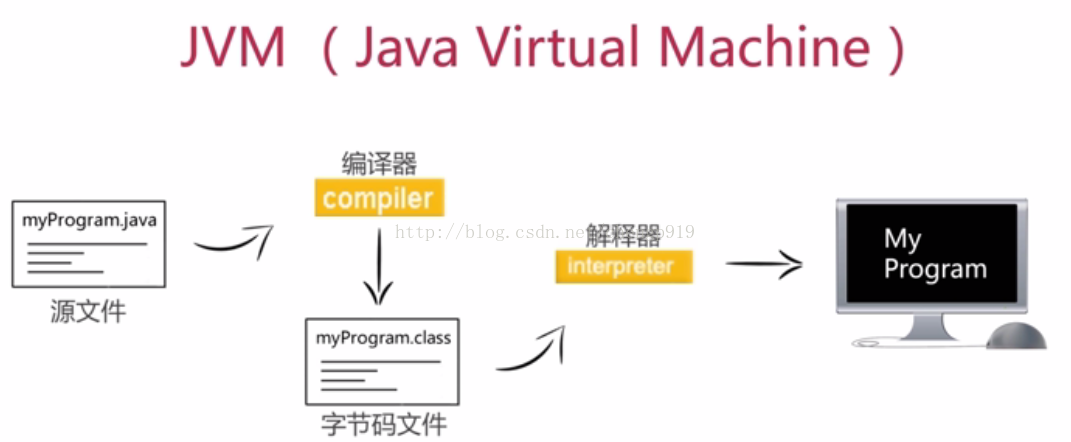

- 跨平台特性 :Java具有良好的跨平台特性,一次编写,到处运行,这对于需要在不同操作系统上部署爬虫的场景尤其重要。

- 丰富的库支持 :如Apache HttpClient、Jsoup等,为HTTP请求处理、HTML解析提供了便捷的工具。

- 成熟的开发环境 :Java拥有成熟的开发工具和生态,如IntelliJ IDEA、Eclipse等,以及强大的调试功能,能够加快开发和调试过程。

- 高效的数据处理 :Java有着优秀的并发处理能力,能够有效地处理大量的网络请求和数据解析,适合开发高效能的爬虫程序。

开发前的准备工作

在开始编写网络爬虫之前,需要做好以下准备工作:

- 需求分析 :明确爬虫的目标、抓取的数据范围以及最终的数据处理方式。

- 法律合规性检查 :确保遵守相关法律法规,不侵犯网站版权或隐私。

- 工具选择与环境配置 :根据需求选择合适的Java版本、开发工具以及依赖库,搭建开发环境。

通过上述介绍,我们已经对Java在网络爬虫中的应用有了初步的了解,下一章我们将深入探讨HTTP通信的基础知识及其在Java中的实现方式。

2. HTTP通信基础和Java实现

2.1 HTTP协议的基本原理

HTTP(超文本传输协议)是互联网上应用最为广泛的一种网络协议。作为网络爬虫开发者,理解HTTP协议是基础中的基础。

2.1.1 请求与响应模型

HTTP通信采用请求/响应模型。客户端发送一个HTTP请求到服务器,然后服务器返回一个响应。请求与响应都有一个状态行、一些响应头、一个空行以及实体内容(可选)。

- 请求行 包含了HTTP方法、请求资源的URL以及HTTP版本。

- 状态行 则包含了服务器对请求的响应状态码、原因短语和HTTP版本。

- 响应头 提供了关于响应的元数据,如内容类型、内容长度等。

- 实体内容 则是HTTP消息的数据部分,包含HTML代码、图片等。

举个例子,一个标准的GET请求和响应:

GET /index.html HTTP/1.1

Host: ***

HTTP/1.1 200 OK

Content-Type: text/html

Content-Length: 127

<html>

...

</html>

2.1.2 状态码和方法的使用

HTTP状态码用于表示服务器对请求的处理结果。常见的状态码有:

- 2xx :请求成功,如200 OK。

- 3xx :重定向,如301 Moved Permanently。

- 4xx :客户端错误,如404 Not Found。

- 5xx :服务器错误,如500 Internal Server Error。

HTTP请求方法定义了客户端与服务器交互的方式,包括但不限于:

- GET :请求服务器发送某个资源。

- POST :向服务器提交数据,常用于表单提交。

- HEAD :类似于GET,但是只返回响应头。

- PUT :上传文件。

- DELETE :删除资源。

2.2 Java中的HTTP通信工具

2.2.1 URL和URLConnection的使用

Java提供了 ***.URL 和 URLConnection 类来处理HTTP请求。

使用 URL 类可以直接打开一个到URL指向的资源的连接。而 URLConnection 是 URL 类的父类,提供了读取和写入资源的接口。以下是一个简单的使用示例:

URL url = new URL("***");

URLConnection connection = url.openConnection();

InputStream inputStream = connection.getInputStream();

// 处理inputStream...

inputStream.close();

2.2.2 HttpClient的高级特性

随着Java 9中引入的 HttpClient ,Java现在有了更加现代化的方式来处理HTTP请求。

HttpClient 支持HTTP/2,允许异步非阻塞调用,并且更易于使用。以下是一个使用 HttpClient 发起GET请求的示例:

HttpClient client = HttpClient.newHttpClient();

HttpRequest request = HttpRequest.newBuilder()

.uri(URI.create("***"))

.build();

HttpResponse<String> response = client.send(request, HttpResponse.BodyHandlers.ofString());

System.out.println(response.body());

在这个示例中,我们创建了一个 HttpClient 实例,并使用它发送了一个GET请求。响应被异步地接收,因为我们使用了 .send() 方法。处理响应内容通过响应体处理器 BodyHandlers.ofString() 来转换为字符串。

通过深入学习HTTP协议和Java提供的API,开发者可以更好地控制网络爬虫的行为,提高数据采集的效率和质量。在后续章节中,我们将探讨如何解析HTML文档、存储数据以及实现高效的多线程操作,这些都是网络爬虫开发的关键技能。

3. HTML解析技术与Jsoup库

3.1 HTML文档结构解析

3.1.1 DOM树与节点概念

HTML文档结构是一种以树状形式存在的模型,被称作文档对象模型(Document Object Model,简称DOM)。在HTML中,每一个标签、属性、文本等都被视作树的一个节点。这种结构允许我们以编程方式访问和修改网页内容。

当浏览器加载一个HTML文档时,它会解析HTML代码并构建出DOM树。对于Java程序来说,可以通过解析库来读取和操作这个DOM树,其中Jsoup是一个常用的选择。使用Jsoup时,我们无需担心HTML解析的各种细节问题,它能将HTML文档抽象为简单的对象和方法。

理解DOM树的层级结构对于掌握HTML解析技术至关重要。DOM节点分为多种类型,例如元素节点(Element)、文本节点(Text)、注释节点(Comment)等。在解析和操作HTML文档时,常常需要定位特定的节点,如遍历所有段落 <p> 标签或修改具有特定类名的元素内容。

3.1.2 CSS选择器的应用

为了在DOM树中定位特定的节点,我们通常使用CSS选择器。CSS选择器是一种强大的工具,可以基于元素的标签名、类名、ID、属性等特征来选取特定的节点。

在Jsoup库中,CSS选择器用于查询和提取文档中的元素。例如,如果我们想选取页面上所有的图片,可以使用选择器 "img" 。使用点符号 . 可以选取具有特定类名的元素,如 "div.my-class" 选择所有类名为 my-class 的 div 元素。而 # 符号用于选取ID属性值对应的元素。

// 示例代码段:使用Jsoup选取页面中的所有图片,并打印出它们的src属性

Elements images = doc.select("img");

for (Element img : images) {

String src = img.absUrl("src");

System.out.println(src);

}

在上面的代码中,我们首先使用 doc.select("img") 获取了文档中所有的 <img> 标签。然后,通过遍历 Elements 对象,我们使用 absUrl("src") 方法获取每个图片标签的绝对URL,并将其打印出来。

3.2 Jsoup库的使用和案例分析

3.2.1 Jsoup的基本使用方法

Jsoup库提供了丰富的API,使得从简单的HTML文档解析到复杂的网页数据抽取变得容易。使用Jsoup通常涉及以下几个步骤:

- 连接到一个页面。

- 解析HTML文档,生成DOM树。

- 使用选择器来定位特定的节点。

- 操作这些节点,例如读取、修改或删除。

// 示例代码段:使用Jsoup连接到一个页面并解析HTML

String url = "***";

Document doc = Jsoup.connect(url).get();

在上面的代码段中,我们通过 Jsoup.connect(url) 方法创建了一个连接,然后调用 .get() 方法发送请求并接收响应,结果存储在 Document 对象中。现在我们就可以使用该对象来查询和操作HTML文档了。

3.2.2 实际项目中的Jsoup应用实例

在实际的项目中,我们可能会遇到需要抓取和解析具有复杂结构的网页数据。这时,Jsoup的灵活性和强大功能就显得尤为重要。以下是一个实际的例子,展示如何使用Jsoup来解析一个网页,并从中提取出特定信息。

假设我们需要从一个电商网站上抓取商品的价格、名称和描述信息。首先,我们使用Jsoup连接到网页,然后通过分析网页结构来找到正确的选择器。

// 示例代码段:解析电商网站上的商品信息

String url = "***";

Document doc = Jsoup.connect(url).get();

Elements products = doc.select(".product");

for (Element product : products) {

String name = product.select(".product-name").text();

String price = product.select(".product-price").text();

String description = product.select(".product-description").text();

System.out.println("Product Name: " + name);

System.out.println("Price: " + price);

System.out.println("Description: " + description);

}

在上述代码中,我们通过类选择器 .product 定位到了包含商品信息的容器。然后,对于每一个商品元素,我们进一步使用 .product-name 、 .product-price 和 .product-description 选择器来获取商品的名称、价格和描述信息。

通过这种方式,我们能够从一个结构复杂的网页中提取出有用的数据。在实际应用中,这种数据抽取的方法可以被用于构建商品比较网站、监控价格变动以及进行市场分析等。

4. 数据存储方法与Java API

数据是网络爬虫的核心产出,因此如何存储这些数据是决定爬虫应用好坏的关键因素之一。在本章中,我们将探讨如何利用Java的API在关系型数据库和NoSQL数据库中存储爬取的数据。

4.1 关系型数据库存储机制

4.1.1 JDBC的基本操作和连接池

JDBC(Java Database Connectivity)是Java语言中用于执行SQL语句的API,它定义了与数据库进行交互的标准Java类。利用JDBC API,Java程序可以访问各种不同的数据库。在爬虫应用中,我们需要将爬取的数据存储在数据库中,而JDBC便是实现这一过程的主要工具。

关系型数据库存储依赖于明确的数据表结构,数据表之间的关系通过外键等约束来维护。存储过程和触发器等数据库特性可用于维护数据的一致性和完整性。在使用JDBC之前,需要引入相应数据库的驱动依赖包,如下示例代码所示,展示了如何加载MySQL驱动:

try {

Class.forName("com.mysql.cj.jdbc.Driver");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

接下来,通过 DriverManager.getConnection 方法获取数据库连接。为了提升性能,通常会使用连接池来管理数据库连接。HikariCP是一个广泛使用的连接池实现,它通过减少创建和销毁数据库连接的开销来提高效率。以下是使用HikariCP的基本代码:

private static HikariDataSource createDataSource() {

HikariDataSource ds = new HikariDataSource();

ds.setJdbcUrl("jdbc:mysql://localhost:3306/mydatabase");

ds.setUsername("username");

ds.setPassword("password");

ds.addDataSourceProperty("cachePrepStmts", "true");

ds.addDataSourceProperty("prepStmtCacheSize", "250");

ds.addDataSourceProperty("prepStmtCacheSqlLimit", "2048");

return ds;

}

4.1.2 SQL语言和数据表设计

SQL(Structured Query Language)是用于访问和操作数据库的标准编程语言。爬虫程序通常需要执行插入(INSERT)、查询(SELECT)、更新(UPDATE)和删除(DELETE)等操作。

数据表的设计应该遵循关系型数据库的第三范式(3NF),以减少数据冗余和提高数据一致性。表设计时需要考虑到爬虫数据的特点,比如网站URL、页面内容、抓取时间等。一个简单的示例表结构可能包括:

CREATE TABLE `web_pages` (

`id` INT NOT NULL AUTO_INCREMENT,

`url` VARCHAR(1024) NOT NULL,

`content` MEDIUMTEXT,

`fetch_time` TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

在此基础上,编写SQL语句将爬虫获取的数据存入表中:

String sql = "INSERT INTO web_pages (url, content, fetch_time) VALUES (?, ?, ?)";

try (Connection conn = dataSource.getConnection();

PreparedStatement pstmt = conn.prepareStatement(sql)) {

pstmt.setString(1, pageUrl);

pstmt.setString(2, pageContent);

pstmt.setTimestamp(3, new Timestamp(fetchTime.getTime()));

pstmt.executeUpdate();

} catch (SQLException e) {

e.printStackTrace();

}

4.2 NoSQL数据库的选用与实践

4.2.1 NoSQL数据库的特点

NoSQL数据库被设计用来存储结构化、半结构化或非结构化数据。它们提供了不同于关系型数据库的存储模型,如键值存储、文档存储、列存储和图数据库。NoSQL数据库因其水平扩展的能力、灵活的数据模型和高效的数据访问速度而在大数据处理中变得越来越流行。

NoSQL数据库通常采用分布式架构,能够支持更高级别的并发访问和海量数据存储。并且,它们往往不需要固定的表结构,这在处理大量动态数据时非常有用。例如,MongoDB和Redis分别是文档型数据库和键值型数据库的佼佼者。

4.2.2 Redis和MongoDB的实际应用

Redis

Redis是一个开源的内存中的数据结构存储系统,它通常被用作数据库、缓存和消息中间件。它的数据类型丰富,包括字符串、列表、集合、有序集合等。在爬虫应用中,Redis可以用于缓存已爬取的URL,防止重复爬取,或者作为数据的暂存和队列管理。

以下是一个使用Redis存储爬取页面URL的示例:

Jedis jedis = new Jedis("localhost", 6379);

jedis.set("web_page_url:" + url, "visited");

// 检查URL是否已存在

String result = jedis.get("web_page_url:" + url);

if ("visited".equals(result)) {

System.out.println(url + " has been visited");

} else {

System.out.println(url + " has not been visited");

}

jedis.close();

MongoDB

MongoDB是一个面向文档的数据库,它存储的数据以BSON(类似JSON的二进制形式)格式组织。MongoDB的文档存储方式使它非常灵活,易于存储和查询复杂的数据结构。

在爬虫应用中,MongoDB可以存储结构化或半结构化的数据,如HTML内容和元数据。以下是一个使用MongoDB将爬取数据存入数据库的示例:

MongoClient mongoClient = new MongoClient("localhost");

DB database = mongoClient.getDB("spider_db");

DBCollection collection = database.getCollection("web_pages");

BasicDBObject document = new BasicDBObject();

document.put("url", pageUrl);

document.put("content", pageContent);

document.put("fetch_time", new Date(fetchTime.getTime()));

collection.insert(document);

mongoClient.close();

通过以上示例和代码展示,我们展示了如何利用Java API操作关系型数据库和NoSQL数据库进行数据存储。在实际应用中,根据数据存储需求和访问性能的不同,选择合适的数据库类型和配置是至关重要的。

5. 多线程与并发机制

5.1 Java中的多线程基础

5.1.1 创建和管理线程的方法

Java提供了多种创建和管理线程的方法。最简单的方式是通过继承Thread类,并覆盖其run方法来定义线程执行的任务。然后,可以通过创建Thread类的实例并调用其start方法来启动线程。

public class MyThread extends Thread {

@Override

public void run() {

// 执行任务的代码

}

}

// 启动线程

MyThread myThread = new MyThread();

myThread.start();

另一种方法是实现Runnable接口。这种方式更灵活,因为它允许类继续继承其他类,同时实现Runnable接口。

public class MyRunnable implements Runnable {

@Override

public void run() {

// 执行任务的代码

}

}

// 使用Runnable创建和启动线程

Thread thread = new Thread(new MyRunnable());

thread.start();

5.1.2 线程的同步与通信

在多线程环境下,线程间的同步和通信是保证数据一致性和线程安全的重要机制。Java提供了synchronized关键字来同步方法和代码块,以防止多个线程同时访问共享资源。

public class Counter {

private int count = 0;

public synchronized void increment() {

count++;

}

public synchronized int getCount() {

return count;

}

}

此外,可以使用wait(), notify(), 和 notifyAll()方法来实现线程间的通信。

public class ProducerConsumer {

private Queue<Integer> queue = new LinkedList<>();

private final int MAX_SIZE = 10;

public synchronized void produce(int item) throws InterruptedException {

while (queue.size() == MAX_SIZE) {

wait(); // 生产者等待

}

queue.add(item);

notifyAll(); // 通知消费者

}

public synchronized Integer consume() throws InterruptedException {

while (queue.isEmpty()) {

wait(); // 消费者等待

}

Integer item = queue.poll();

notifyAll(); // 通知生产者

return item;

}

}

5.2 高级并发编程技术

5.2.1 线程池的原理与使用

线程池是一种多线程处理形式,用于减少在多线程处理中频繁创建和销毁线程的开销。它可以根据需要自动创建线程,并对其进行管理。

在Java中,可以通过Executors类创建不同类型的线程池。例如,使用固定大小的线程池:

ExecutorService executor = Executors.newFixedThreadPool(10);

executor.execute(new MyRunnable());

// 关闭线程池

executor.shutdown();

5.2.2 并发工具类和原子操作

Java并发API还提供了一系列的并发工具类,如Semaphore, CyclicBarrier, CountDownLatch等,它们在解决特定并发问题时非常有用。此外,Atomic类提供了原子操作,这在多线程环境下对共享变量的无锁编程非常关键。

AtomicInteger atomicInteger = new AtomicInteger(0);

int i = atomicInteger.incrementAndGet(); // 原子自增操作

在多线程编程中,合理地使用这些工具类和原子操作能够有效地提升程序的性能和稳定性。

简介:网络爬虫是自动遍历并抓取网页信息的工具,Java因跨平台、稳定性和强大的库支持在爬虫开发中十分流行。Websphinx是Java开发的网络爬虫框架,本课程将探讨Java在网络爬虫开发中的关键知识点,包括HTTP通信、HTML解析、数据存储、多线程处理、URL管理、延迟加载与JavaScript处理、异常处理、IP代理、日志记录以及分布式爬虫的设计和实现。通过深入学习Websphinx框架,学生将掌握如何构建高效、稳定的爬虫系统,提升网络数据挖掘的能力。

453

453

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?