简介:Alvas Audio是音频开发领域的一个重要控件,提供了全面的音频处理功能,如录音、播放、编辑和转换。其9.0.4873.32999版本进一步提升了性能和稳定性,优化了多线程处理,提高了实时音频处理能力,并提供丰富的示例代码和文档支持。API设计直观易用,支持跨平台使用,是音频应用开发者的优选工具。

1. Alvas Audio概述

1.1 Alvas Audio简介

Alvas Audio是一个功能全面的音频处理库,为开发者提供了丰富的API来处理音频文件,录制声音,以及实时音频处理等。它支持多种音频格式,并且提供了简单而强大的接口,使得在.NET环境中开发音频相关的应用程序变得更加简单。

1.2 Alvas Audio的应用场景

Alvas Audio广泛应用于各种应用程序中,比如音频播放器,音频编辑器,视频编辑软件中的音频轨道处理,以及实时通信应用中的音频信号处理等。其跨平台特性也使得开发者可以轻松地为不同操作系统开发应用。

1.3 Alvas Audio的核心特点

Alvas Audio的核心特点包括: - 高度模块化的API设计,易于理解和使用。 - 提供丰富的音频处理功能,包括音效处理、音频录制、播放、编辑等。 - 良好的跨平台支持,能够在Windows、Linux、Mac、以及移动平台上运行。 - 灵活的音频格式支持,包括但不限于WAV、MP3、WMA、OGG等。

这一章的内容为读者们提供了一个Alvas Audio的初步认识,接下来章节将会详细介绍其音频处理的具体功能和实现方式。

2. 音频处理功能详解

2.1 音频录制技术

2.1.1 录音设备的接入与管理

在音频处理中,录音是一个基础且关键的功能。要实现良好的录音功能,首先需要确保录音设备(如麦克风)可以被系统正确接入并有效管理。

接入录音设备通常涉及到操作系统级别的API调用,这些API能识别并初始化连接到计算机上的音频输入设备。在Windows系统中,可以使用 waveIn 系列函数来获取录音设备信息,并开始录音。而在Linux系统中,可以通过 alsa-lib 或 pulseaudio 库来管理音频设备。

管理录音设备涉及几个核心步骤:

- 枚举系统中的录音设备。

- 根据需求选择合适的录音设备。

- 配置录音设备的采样率、位深和通道数等参数。

- 打开设备并准备录音。

- 实时捕获音频数据并进行处理。

- 录音结束后关闭设备并释放资源。

代码示例2.1展示了如何在Windows系统中使用 waveIn 函数族接入录音设备:

HWAVEIN hWaveIn = NULL;

WAVEHDR wh;

MMRESULT mmr;

// 准备wave格式结构体,定义录音格式

WAVEFORMATEX wfex;

wfex.wFormatTag = WAVE_FORMAT_PCM;

wfex.nChannels = 2;

wfex.nSamplesPerSec = 44100;

wfex.wBitsPerSample = 16;

wfex.nBlockAlign = wfex.nChannels * wfex.wBitsPerSample / 8;

wfex.nAvgBytesPerSec = wfex.nSamplesPerSec * wfex.nBlockAlign;

wfex.cbSize = 0;

// 准备waveIn设备

mmr = waveInOpen(&hWaveIn, WAVE_MAPPER, &wfex, (DWORD_PTR)waveInProc, 0, WAVE_FORMAT_DIRECT | WAVE_MAPPED);

// 初始化wave头结构体,准备录音数据块

ZeroMemory(&wh, sizeof(WAVEHDR));

wh.lpData = malloc(WAVEHDR_BLOCK_SIZE);

wh.dwBufferLength = WAVEHDR_BLOCK_SIZE;

waveInPrepareHeader(hWaveIn, &wh, sizeof(WAVEHDR));

waveInAddBuffer(hWaveIn, &wh, sizeof(WAVEHDR));

// 开始录音

waveInStart(hWaveIn);

// 录音回调函数

void CALLBACK waveInProc(HWAVEIN hwi, UINT uMsg, DWORD_PTR dwInstance, DWORD_PTR dwParam1, DWORD_PTR dwParam2) {

switch (uMsg) {

case WOM_OPEN: break;

case WOM_CLOSE: break;

case WOM_DONE:

// 当录音完成一块数据的录制时,进行处理并准备下一帧数据

waveInAddBuffer(hWaveIn, (WAVEHDR *)dwParam1, sizeof(WAVEHDR));

break;

default: break;

}

}

以上代码展示了如何通过 waveInOpen 、 waveInPrepareHeader 和 waveInAddBuffer 等函数来打开录音设备、准备和添加缓冲区,以及开始录音。需要注意的是,这只是录音过程中的一部分,实际应用中还需要包括错误处理、资源清理等步骤。

2.1.2 音频信号的捕获与存储

录音过程不仅仅是音频信号的捕获,还需要将这些信号有效地存储起来,以便后续的处理和使用。存储时,可以选择不同的文件格式,如WAV、MP3等。这里以WAV格式为例,说明音频信号捕获与存储的过程。

WAV文件是微软和IBM共同开发的一种数字音频文件格式,它记录了音频波形的真实采样数据,属于无损格式。它允许音频数据以不同的采样率和位深度进行存储,因此在捕获数据时,需要根据系统当前的设置将数据保存到WAV文件中。

捕获音频信号到WAV文件,一般包含以下步骤:

- 打开WAV文件准备写入数据。

- 根据录音设备的格式参数设置WAV文件头信息。

- 开始录音,并实时捕获音频数据。

- 将捕获的音频数据块写入到WAV文件中。

- 录音结束后,正确关闭文件并写入完整的WAV文件头。

代码示例2.2展示了如何将捕获的音频数据保存到WAV文件中:

// 假设已经获取到了音频数据块 pointersToAudioData

UINT uSize = pointersToAudioData->dwBufferLength;

// 打开WAV文件准备写入

FILE* pFile = fopen("recordedAudio.wav", "wb");

fwrite(&bf, sizeof(BITMAPFILEHEADER), 1, pFile);

fwrite(&bi, sizeof(BITMAPINFOHEADER), 1, pFile);

// 循环写入音频数据

while (uSize > 0) {

fwrite(pointersToAudioData->lpData, 1, uSize, pFile);

uSize -= WAVEHDR_BLOCK_SIZE;

// 获取下一块音频数据并继续写入

waveInAddBuffer(hWaveIn, pointersToAudioData, sizeof(WAVEHDR));

waveInGetDevCaps(hWaveIn, &Caps, sizeof(Caps));

waveInReset(hWaveIn);

}

// 清理资源并关闭文件

fclose(pFile);

需要注意的是,上面的代码例子中并没有详细展示如何设置WAV文件的头信息,这通常需要对WAV文件格式有较为深入的了解,并且需要在录音过程中维护音频数据的一些关键参数,如采样率、位深、通道数等。在实际开发中,还需要处理文件的打开、关闭、异常处理等更多的细节。

2.2 音频播放机制

2.2.1 媒体播放器核心组件解析

媒体播放器是一个复杂的系统,它包括用户界面、播放控制、解码器、音频输出等多个核心组件。要深入理解音频播放机制,需要对这些组件的作用和工作方式进行解析。

核心组件解析主要包含以下几个方面:

- 用户界面(UI):负责向用户提供操作播放器的界面,如播放、暂停、停止、前进、后退等按钮。

- 播放控制:负责处理用户的播放控制指令,并将这些指令传递给其他组件。

- 音频解码器:负责将存储在媒体文件中的压缩音频数据解码成可播放的PCM数据。

- 音频输出:负责将解码后的PCM数据输出到播放设备,如扬声器或耳机。

媒体播放器的设计和实现涉及到多种技术的选择和应用,如对于不同的音频格式,需要选择合适的解码器。例如,对于MP3格式,可以使用开源库如 libmpg123 或 ffmpeg ;而对于WAV格式,则可以直接使用操作系统提供的API进行播放。

2.2.2 音频流的输出与控制

音频流的输出与控制是播放器中最为关键的功能之一。音频流的输出通常依赖于音频输出组件,这部分组件负责将PCM数据转换成实际的物理声音输出到音频设备。

在输出音频流之前,需要初始化音频输出设备,包括设置音频格式(采样率、位深、声道数等)、缓冲区大小等。接着,音频数据会被放置到一个或多个缓冲区中,并根据音频输出设备的反馈进行数据的读取和播放。

音频流的控制涉及到音频的播放速度、音量调节、跳转等,这些控制功能需要根据用户的指令来调整音频输出组件的行为。例如,当用户拖动进度条时,播放器需要根据进度条的位置来决定从哪一部分开始播放音频流。

控制音频输出流的代码示例如下:

// 设置音频格式和缓冲区大小

WAVEFORMATEX wfx;

memset(&wfx, 0, sizeof(WAVEFORMATEX));

wfx.cbSize = 0;

wfx.wFormatTag = WAVE_FORMAT_PCM;

wfx.nChannels = 2;

wfx.nSamplesPerSec = 44100;

wfx.wBitsPerSample = 16;

wfx.nBlockAlign = wfx.nChannels * wfx.wBitsPerSample / 8;

wfx.nAvgBytesPerSec = wfx.nSamplesPerSec * wfx.nBlockAlign;

// 打开音频设备

HWAVEOUT hwo;

mmr = waveOutOpen(&hwo, WAVE_MAPPER, &wfx, (DWORD_PTR)waveOutProc, 0, CALLBACK_FUNCTION);

// 开始播放音频流

waveOutPrepareHeader(hwo, &wh, sizeof(WAVEHDR));

waveOutWrite(hwo, &wh, sizeof(WAVEHDR));

// 播放控制回调函数

void CALLBACK waveOutProc(HWAVEOUT hwo, UINT uMsg, DWORD_PTR dwInstance, DWORD_PTR dwParam1, DWORD_PTR dwParam2) {

switch (uMsg) {

case WOM_OPEN: // 设备打开

break;

case WOM_DONE: // 音频缓冲区播放完毕

// 将新的音频数据加载到缓冲区并继续播放

break;

case WOM_CLOSE: // 设备关闭

break;

default: break;

}

}

以上代码展示了如何初始化音频格式,打开音频设备,并开始播放音频流。同时提供了回调函数来处理设备打开、音频缓冲区播放完毕以及设备关闭的情况。在实际应用中,还需要根据用户的播放指令来调整播放行为,如暂停、快进、快退等,并且需要合理管理内存和资源,避免资源泄露。

2.3 音频编辑处理

音频编辑处理是音频应用中的一个高级功能,它允许用户对录制或导入的音频内容进行各种操作,如剪切、合并、淡入淡出等,甚至还能进行更复杂的处理,比如噪声消除与音量标准化。

2.3.1 基本编辑功能:剪切、合并与淡入淡出

基本编辑功能是用户最常使用的功能之一。剪切功能允许用户选择音频中的一个特定片段进行删除;合并功能则可以将两个或多个音频文件连接在一起;而淡入淡出处理则可以让音频的开始和结束部分变得更加平滑自然,避免了突然中断的不和谐感。

基本编辑功能的实现通常涉及到对PCM数据的直接操作。对于剪切和合并功能,需要对原始PCM数据进行读取、修改和写入。淡入淡出处理则需要对选定的音频片段应用一个逐渐变化的增益因子,来实现平滑过渡的效果。

2.3.2 高级编辑技术:噪声消除与音量标准化

高级编辑技术如噪声消除与音量标准化需要更复杂的算法和处理。噪声消除功能需要能够识别出音频中的非语音部分,并对其进行消除或抑制。而音量标准化则需要对音频文件的总体音量进行分析,然后调整到一个预定的音量水平,以确保音量的一致性。

噪声消除技术的例子代码如下:

// 噪声消除处理函数

void denoiseAudio(char* audioData, int length) {

// 噪声样本的计算和噪声模式的建立等

// 对音频数据进行处理,去除噪声部分

}

// 使用函数对音频数据进行噪声消除处理

denoiseAudio(audioData, audioLength);

噪声消除通常涉及到音频信号处理的算法,如傅里叶变换、小波变换等,来识别和分离噪声部分。这一过程往往计算量较大,对处理速度有一定要求。

音量标准化处理代码示例:

// 音量标准化处理函数

void normalizeVolume(char* audioData, int length, float targetVolume) {

// 计算音频文件当前的平均音量

// 根据目标音量调整音频数据的增益

}

// 使用函数对音频数据进行音量标准化处理

normalizeVolume(audioData, audioLength, targetVolume);

音量标准化过程中,首先要计算出音频文件的当前音量水平,然后根据目标音量调整整个音频文件的增益。这可能涉及到对音频数据进行逐样本的乘法运算。

2.4 音频格式转换方法

音频格式转换是音频处理中的一项重要技术,它允许用户将音频文件从一种格式转换为另一种格式,从而兼容不同的设备和应用需求。

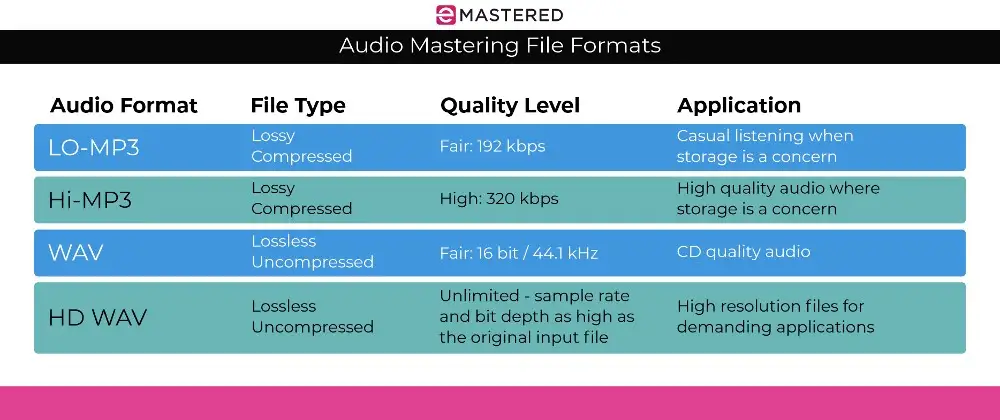

2.4.1 常见音频格式对比与选择

在进行音频格式转换之前,首先需要了解并对比常见的音频格式的特点。例如:

- WAV格式:无损的音频格式,体积较大,兼容性好。

- MP3格式:有损的音频格式,体积较小,音质损失相对较少,广泛使用。

- OGG格式:开源的有损音频格式,音质和压缩比优于MP3,在开源领域较为流行。

- AAC格式:高级音频编码,音质好,压缩比高,常用于数字媒体服务。

音频格式的选择取决于用户的具体需求,例如,是否需要保持音质的最高无损状态,是否需要减小文件大小以便于网络传输,或者是特定设备对某些格式的支持等。

2.4.2 转换过程中的参数设置与优化

音频格式转换过程中的参数设置和优化是保证转换质量和效率的关键。这包括:

- 采样率:转换过程中需要保证采样率的一致性,或者根据目标格式调整采样率。

- 位深:决定音频数据的动态范围和细节,转换时需要处理好位深的转换。

- 声道数:音频通道数的处理也是转换时需要注意的问题,例如立体声转换为单声道。

- 压缩编码:涉及到音频数据的编码方式,比如MP3、AAC等编码器的选择和配置。

优化转换过程不仅包括对这些参数的合理设置,还需要考虑解码和编码的效率,以及错误处理机制的建立。例如,使用 ffmpeg 库进行转换时,可以通过命令行设置各种参数来控制转换过程,以达到预期的效果。

音频格式转换过程的代码示例(使用 ffmpeg ):

# 命令行参数说明

# -i 输入文件

# -acodec 指定音频编码器

# -ab 音频比特率

# -ac 声道数

ffmpeg -i input.wav -acodec libmp3lame -ab 128k -ac 2 output.mp3

上述命令使用 ffmpeg 将WAV格式的音频文件转换为MP3格式,同时设置了音频编码器、比特率和声道数等参数。这种方式不仅可以用于命令行工具,也可以在应用程序中通过编程方式调用 ffmpeg 库来实现音频格式的转换。

以上介绍了音频录制技术、音频播放机制、音频编辑处理、以及音频格式转换方法的相关知识。接下来的章节将详细讲解Alvas Audio支持的音频格式,性能优化与稳定性提升,多线程处理与实时音频处理,以及示例代码、文档与跨平台能力等内容。

3. Alvas Audio支持的音频格式

3.1 WAV格式解析

3.1.1 WAV格式的特点与应用场景

WAV格式,即波形音频文件格式,是由Microsoft和IBM开发的一种标准数字音频文件格式。它是一种无损音频格式,能够保存音频流的精确副本,没有压缩或丢失任何信息。因此,WAV文件通常用于高质量音频的录音和编辑。

由于WAV文件是未经压缩的,这意味着它们通常占用的空间要比同样质量的压缩格式文件大得多。例如,一个一分钟的立体声WAV文件可能高达10MB,而同样时间的MP3文件可能只有1MB。这使得WAV在专业音频制作中非常受欢迎,同时也适用于需要最高质量音频的应用,如音轨的母带处理。

3.1.2 WAV文件的读取与写入操作

WAV文件遵循RIFF(Resource Interchange File Format)标准,这是一种通用的文件结构,用于存储音频、视频等不同类型的数据。WAV文件以"RIFF"标识开始,后跟文件大小、文件类型("WAVE")以及一系列包含格式信息和实际音频数据的子块。

以下是一个简单的C#代码示例,演示如何使用Alvas Audio库读取和写入WAV文件:

using AlvasSound;

using System.IO;

public class WaveIO

{

public void ReadWaveFile(string filePath)

{

using (var stream = new FileStream(filePath, FileMode.Open, FileAccess.Read))

using (var waveFile = new WaveFile(stream))

{

// 获取文件信息

Console.WriteLine($"Sample Rate: {waveFile.SampleRate}");

Console.WriteLine($"Channels: {waveFile.Channels}");

Console.WriteLine($"Bits Per Sample: {waveFile.BitsPerSample}");

// 读取音频数据

waveFile.Read();

}

}

public void WriteWaveFile(string filePath, int sampleRate, int channels, int bitsPerSample, byte[] audioData)

{

using (var stream = new FileStream(filePath, FileMode.Create, FileAccess.Write))

using (var waveFile = new WaveFile(sampleRate, channels, bitsPerSample, audioData, stream))

{

// 写入音频数据

waveFile.Write();

}

}

}

在这个示例中,我们首先使用 FileStream 打开一个WAV文件,然后创建一个 WaveFile 对象来读取文件内容。 WaveFile 类封装了所有与WAV文件相关的操作,包括获取采样率、通道数、每个样本的位数等。对于写入操作,我们创建一个 WaveFile 对象,并提供必要的参数,如采样率、通道数、每个样本的位数以及要写入的音频数据。最后,调用 Write 方法将数据写入文件。

3.2 MP3格式支持

3.2.1 MP3编码技术的原理

MP3(MPEG Audio Layer III)是一种音频压缩格式,它能够在一定程度上减小音频文件的大小而不显著降低音质。MP3使用了心理声学原理,通过去除人类耳朵听不到的声音信息来实现压缩。

MP3编码过程涉及复杂的数学和信号处理算法,其中最核心的部分包括将音频信号从时域转换为频域,应用掩蔽效应,以及使用量化和哈夫曼编码来压缩数据。这些步骤共同作用以达到压缩音频的目的。

3.2.2 MP3文件的压缩与解压操作

压缩MP3文件通常涉及以下步骤:

- 将音频信号分割成小的帧,通常每帧持续约26毫秒。

- 对每一帧使用MDCT(Modified Discrete Cosine Transform)转换到频域。

- 应用心理声学模型,该模型可以确定哪些频率分量是可以被忽略的,因为它们对于听觉来说是“不可感知”的。

- 量化频域的数据,为每一个频率分量选择适当的位数。

- 使用哈夫曼编码对数据进行进一步压缩,最终输出MP3流。

解压缩MP3文件的过程正好相反,需要执行解码步骤来恢复原始的音频信号。

以下是使用Alvas Audio库解压MP3文件的示例代码:

using AlvasSound;

using System.IO;

public class Mp3Decoder

{

public void DecodeMp3File(string inputFilePath, string outputFilePath)

{

using (var mp3Stream = new FileStream(inputFilePath, FileMode.Open, FileAccess.Read))

using (var wavStream = new FileStream(outputFilePath, FileMode.Create, FileAccess.Write))

using (var mp3Decoder = new Mp3Decoder())

using (var waveWriter = new WaveFileWriter(wavStream))

{

// 解码MP3文件并将其写入WAV文件

mp3Decoder.Decode(mp3Stream, waveWriter);

}

}

}

这段代码首先打开MP3文件,然后创建一个 Mp3Decoder 对象进行解码操作。解码得到的音频流随后被写入一个新的WAV文件中,这个文件可以被播放器播放或者用于进一步的处理。

3.3 WMA与OGG格式特性

3.3.1 WMA与OGG格式优势分析

WMA(Windows Media Audio)和OGG Vorbis都是流行的有损压缩音频格式,它们提供了在较小文件大小下保持相对较好音质的能力。WMA格式由微软开发,主要集成在Windows Media Player和DRM(数字版权管理)系统中。OGG格式由***基金会创建,以其开源和免版税的特性而广受欢迎。

WMA格式的优势在于它在较短的时间内压缩音频的能力,同时保持了较高的音质,适合在线流媒体服务和数字媒体分发。OGG Vorbis则在压缩效率上通常略优于WMA,而没有DRM限制,使得它在开源和自由软件社区中更受欢迎。

3.3.2 WMA与OGG的读取与转换实现

由于WMA和OGG格式的专利性质,使用它们的代码示例通常需要集成相应格式的编解码器。在.NET环境中,可以使用第三方库如NAudio或NLayer来实现这些格式的读取和写入。以下是使用NAudio进行WMA文件读取的示例:

using NAudio.Wave;

using System.IO;

public class WmaReader

{

public void ReadWmaFile(string filePath)

{

using (var reader = new WmaFileReader(filePath))

{

// 获取文件信息

Console.WriteLine($"Sample Rate: {reader.WaveFormat.SampleRate}");

Console.WriteLine($"Channels: {reader.WaveFormat.Channels}");

Console.WriteLine($"Bits Per Sample: {reader.WaveFormat.BitsPerSample}");

// 读取音频数据

var buffer = new float[reader.WaveFormat.SampleRate];

int bytesRead;

while ((bytesRead = reader.Read(buffer, 0, buffer.Length)) > 0)

{

// 处理读取到的音频数据

}

}

}

}

对于OGG格式,NLayer库提供了读取和写入支持。以下示例展示了如何读取OGG文件:

using NLayer.NAudioSupport;

using System.IO;

public class OggReader

{

public void ReadOggFile(string filePath)

{

using (var stream = new FileStream(filePath, FileMode.Open, FileAccess.Read))

using (var decoder = new VorbisWaveReader(stream))

{

// 获取文件信息

Console.WriteLine($"Sample Rate: {decoder.WaveFormat.SampleRate}");

Console.WriteLine($"Channels: {decoder.WaveFormat.Channels}");

Console.WriteLine($"Bits Per Sample: {decoder.WaveFormat.BitsPerSample}");

// 读取音频数据

var buffer = new float[decoder.WaveFormat.SampleRate];

int bytesRead;

while ((bytesRead = decoder.Read(buffer, 0, buffer.Length)) > 0)

{

// 处理读取到的音频数据

}

}

}

}

请注意,实际的读取操作可能需要额外的错误处理和资源管理,这里为了保持示例的简洁,这些细节被省略了。在处理音频文件时,应当总是确保对文件的正确打开和关闭,以及错误的捕获和处理,以避免资源泄漏或其他潜在问题。

4. 性能优化与稳定性提升

4.1 性能优化策略

4.1.1 代码级性能调优方法

在音频处理软件开发中,代码级的性能调优是提升应用性能的关键因素之一。通过优化代码结构,减少不必要的计算和内存使用,可以显著提高软件的运行效率。例如,循环优化是常见的性能提升手段。通过减少循环内部的操作,可以显著减少CPU的负载。此外,合理利用缓存,减少内存的读写操作,也是提高程序性能的重要方法。

以下是一个示例代码,展示了如何在音频处理中减少循环内部的计算操作:

// 未优化的循环

for (int i = 0; i < audioData.Length; i++)

{

// 复杂的计算操作

float processedSample = ProcessSample(audioData[i]);

audioData[i] = processedSample;

}

// 优化后的循环

float[] processedSamples = new float[audioData.Length];

for (int i = 0; i < audioData.Length; i++)

{

// 将复杂操作移至循环外

processedSamples[i] = ProcessSample(audioData[i]);

}

for (int i = 0; i < audioData.Length; i++)

{

audioData[i] = processedSamples[i];

}

在上述代码中,通过将复杂的计算操作移出循环体,并将结果存储在临时数组中,减少了循环内部的计算量,从而降低了CPU的负载。

4.1.2 系统级资源管理优化

除了代码级优化之外,系统级资源管理的优化同样重要。合理配置软件运行时的系统资源,如内存、处理器和IO等,可以有效提升软件的运行效率。例如,合理安排音频数据的加载和卸载,可以有效减少内存的使用,提高系统的响应速度。

在音频处理应用中,可以通过优先级管理来调整不同音频流的处理顺序,确保关键任务得到优先处理。例如,实时音频处理任务应该被分配更高的优先级,以减少延迟和提高响应速度。

4.2 稳定性提升措施

4.2.1 稳定性测试与监控机制

在音频处理软件中,稳定性测试是确保软件质量和用户满意度的关键步骤。通过模拟不同的使用场景和异常环境,可以发现并修复潜在的稳定性问题。例如,可以通过长时间运行测试来模拟软件在连续使用情况下的稳定性表现。

为了持续监控软件运行状态,可以实现一个监控机制,定期检查系统的健康状况。以下是一个简单的监控机制实现的伪代码:

class StabilityMonitor

{

private DateTime lastCheck = DateTime.Now;

private const int CheckInterval = 60000; // 检查间隔时间为60秒

public void StartMonitoring()

{

while (true)

{

Thread.Sleep(CheckInterval);

if ((DateTime.Now - lastCheck).TotalMilliseconds > CheckInterval)

{

lastCheck = DateTime.Now;

CheckSystemHealth();

}

}

}

private void CheckSystemHealth()

{

// 检查各个组件的状态,例如内存使用量、处理器负载等

// 如果发现问题,执行相应的错误处理程序

}

}

4.2.2 常见错误处理与预防措施

在软件运行过程中,不可避免会遇到各种错误和异常。建立一套完善的错误处理机制和预防措施,可以有效减少错误对用户造成的影响。例如,可以实现日志记录机制,详细记录软件运行过程中的所有错误信息,便于后续问题的追踪和分析。

以下是一个错误处理逻辑的示例代码:

try

{

// 尝试执行可能引发异常的代码

}

catch (Exception ex)

{

// 记录异常信息到日志文件

LogError(ex.ToString());

// 向用户显示错误提示

ShowErrorToUser("发生错误,请联系技术支持。");

// 可能需要执行的其他错误处理逻辑...

}

此外,通过预防性编程,可以在代码中提前检查可能引发错误的条件,例如检查传入函数的参数是否合法,从而避免在运行时发生错误。这不仅可以提升软件的稳定性,还可以提高软件的用户体验。

public void ProcessAudioData(float[] audioData)

{

if (audioData == null)

{

throw new ArgumentNullException(nameof(audioData), "音频数据不能为空。");

}

// 正常处理音频数据

}

通过这种方式,我们可以确保软件在遇到错误输入时能够立即给出反馈,而不是在处理过程中突然崩溃。

5. 多线程处理与实时音频处理

随着软件应用对性能要求的不断提高,多线程编程已经成为现代软件开发中不可或缺的一部分。特别是在音频处理领域,实时性和高效率是两个至关重要的因素。在本章节中,我们将深入探讨多线程编程的基础知识,以及如何在音频处理中有效地应用多线程技术来提升性能和实时处理能力。

5.1 多线程编程基础

5.1.1 线程创建与同步机制

线程是操作系统能够进行运算调度的最小单位。它被包含在进程之中,是进程中的实际运作单位。在多线程环境中,线程同步是保证数据一致性、避免竞态条件和死锁的关键。

代码块与逻辑分析

using System;

using System.Threading;

public class ThreadExample {

public static void Main() {

// 创建并启动线程

Thread newThread = new Thread(WriteY);

newThread.Start();

// 主线程写入X

for (int i = 0; i < 5; i++) {

Console.Write("X");

}

}

public static void WriteY() {

// 线程Y写入Y

for (int i = 0; i < 5; i++) {

Console.Write("Y");

}

}

}

在上述示例中,我们创建了一个新线程来执行 WriteY 方法,同时主线程继续执行并写入字符 X 。通过线程同步机制,如锁(Locks)或信号量(Semaphores),可以控制对共享资源的访问,确保线程安全。

5.1.2 多线程在音频处理中的应用实例

在音频处理中,多线程可以用来分离音频信号的处理任务,例如,一个线程用于解码音频数据,另一个线程则负责音频的输出。

代码块与逻辑分析

using System;

using System.Threading;

using Alvas.Audio;

public class AudioProcessing {

private AudioFileReader _audioReader;

private WaveOutEvent _waveOut;

public AudioProcessing(string audioFilePath) {

_audioReader = new AudioFileReader(audioFilePath);

_waveOut = new WaveOutEvent();

_waveOut.Init(_audioReader);

_waveOut.Play();

}

public void ProcessAudio() {

// 创建解码和播放线程

Thread decoderThread = new Thread(DecodeAudio);

Thread playerThread = new Thread(PlayAudio);

decoderThread.Start();

playerThread.Start();

}

private void DecodeAudio() {

// 解码逻辑

}

private void PlayAudio() {

// 播放逻辑

}

}

在这个示例中,我们创建了两个线程,一个用于音频解码,另一个用于音频播放。通过合理设计,可以确保音频处理任务的高效完成。

5.2 实时音频处理技术

5.2.1 实时混音的实现与调优

实时混音是音频处理中的一个关键功能,它允许同时处理多个音频流并输出为单一混音流。在多线程环境下,合理分配资源和任务对于保持实时性至关重要。

代码块与逻辑分析

using System;

using NAudio.Wave;

using System.Threading;

public class RealTimeMixing {

private WaveMixerStream32 _mixer;

public RealTimeMixing(int numberOfInputs) {

_mixer = new WaveMixerStream32(numberOfInputs);

// 初始化输入流并添加到混音器

for (int i = 0; i < numberOfInputs; i++) {

_mixer.AddInputStream(CreateInputStream());

}

}

private WaveStream CreateInputStream() {

// 创建单个音频流

return new AudioFileReader("path_to_audio_file.wav");

}

public void StartMixing() {

// 启动混音线程

Thread mixingThread = new Thread(MixAudio);

mixingThread.Start();

}

private void MixAudio() {

_mixer.Play();

}

}

在上述代码中,我们使用了NAudio库中的 WaveMixerStream32 类来创建混音器,它负责接收多个输入流并实时进行混音。

5.2.2 均衡器与动态效果处理详解

音频效果处理,如均衡器和动态效果(压缩、扩展等)的实时应用,是增强音频体验的重要环节。多线程能够使得这些复杂的音频处理实时执行而不会影响到音频的播放。

代码块与逻辑分析

using System;

using NAudio.Effects;

using System.Threading;

public class AudioEffects {

private Equalizer _equalizer;

private Compressor _compressor;

public AudioEffects() {

// 初始化均衡器和压缩器

_equalizer = new Equalizer();

_compressor = new Compressor();

// 配置均衡器参数

_equalizer.Bandwidths = new float[10];

for (int i = 0; i < 10; i++) {

_equalizer.Bandwidths[i] = 1.0f;

}

_equalizer.Gains = new float[10];

_equalizer.Gains[0] = 12.0f;

_compressor.Threshold = -20;

_compresser.Ratio = 5.0f;

}

public void ApplyEffects(WaveStream input) {

// 应用效果到输入流

_equalizer.InputStream = input;

_compressor.InputStream = _equalizer.OutputStream;

// 创建效果处理线程

Thread effectThread = new Thread(Apply);

effectThread.Start();

}

private void Apply() {

// 启动效果处理

_compressor.Play();

}

}

在这段代码中,我们创建了一个音频效果处理器,通过多线程来应用均衡器和压缩器效果,同时保持实时的音频播放。

通过本章节的介绍,我们可以看到多线程在音频处理中的重要性,以及如何在实际应用中通过合理的线程管理来实现音频处理的高性能和实时性。

6. 示例代码、文档与跨平台能力

6.1 示例代码与文档资源

6.1.1 编程示例与快速上手指南

在利用Alvas Audio进行音频处理的场景中,编程示例和快速上手指南对于初学者至关重要。以下是一个简单的C#代码示例,用于演示如何使用Alvas Audio库进行基本的音频播放操作:

using AlvasSound;

using System;

public class AudioPlayerExample

{

public static void Main()

{

// 创建音频播放器实例

Player player = new Player();

// 设置音频文件路径

string audioFilePath = @"C:\path\to\your\audiofile.wav";

// 打开并播放音频文件

player.Open(audioFilePath);

player.Play();

// 等待音频播放结束

while(player.Status == Player.PlayerStatus.Playing)

{

Console.WriteLine("Playing...");

System.Threading.Thread.Sleep(1000);

}

// 释放资源

player.Close();

}

}

这段代码首先引入了必要的命名空间 AlvasSound ,随后创建了一个音频播放器实例 Player 。通过指定本地路径,代码打开并播放了一个音频文件。程序会等待音频播放完成,并在完成后释放资源。

6.1.2 API文档结构与使用方法

Alvas Audio的API文档是理解和使用库功能的另一个关键资源。文档详细介绍了每个API的功能、参数和返回值。文档通常按照以下结构组织:

- 类和接口说明:描述每个类或接口的作用和重要成员。

- 方法参考:列出所有可用的方法,包括参数类型、参数说明和返回值。

- 示例代码:提供简短的代码段来演示方法的使用。

- 常见问题解答(FAQ):解答开发者在使用过程中可能遇到的问题。

开发者在使用Alvas Audio时应仔细阅读API文档,以正确使用库的功能。同时,可以通过搜索文档来快速定位问题解决方法。

6.2 跨平台开发能力

6.2.1 Windows平台下的集成与部署

Alvas Audio库同样支持在Windows平台下进行集成和部署。开发者可以使用如Visual Studio等IDE来构建Windows应用程序,集成Alvas Audio。以下是在Windows平台上进行集成和部署的步骤:

- 在项目中添加Alvas Audio库的引用。

- 配置项目文件,确保库文件的路径被正确引用。

- 撰写代码实现所需的音频处理功能。

- 编译并运行程序,验证功能的实现。

- 打包应用程序为可执行文件。

使用Alvas Audio库时,开发者可以利用其强大的跨平台特性,在Windows平台上实现丰富多样的音频处理功能。

6.2.2 Linux与移动平台的适配策略

Alvas Audio提供的跨平台特性使得它能够在Linux和移动平台上使用。适配这些平台的策略包括:

- 使用Mono框架来支持Linux平台。Mono支持.NET框架,并且可以让开发者使用C#语言在Linux环境下编写和运行应用程序。

- 对于移动平台,Alvas Audio支持使用Xamarin等工具,通过这些工具可以将C#代码编译成iOS或Android平台的应用程序。

- 确保音频处理逻辑与平台无关,尽可能使用库提供的抽象层来处理不同平台的差异。

- 在部署前,对目标平台进行充分的测试,以确保音频功能的稳定运行。

通过上述策略,开发者可以轻松地将Alvas Audio集成到不同的平台中,为用户创建跨平台的音频处理应用程序。

这些详细的步骤和示例代码将帮助开发者更加容易地掌握如何使用Alvas Audio,并在多个平台上部署音频处理应用程序。

简介:Alvas Audio是音频开发领域的一个重要控件,提供了全面的音频处理功能,如录音、播放、编辑和转换。其9.0.4873.32999版本进一步提升了性能和稳定性,优化了多线程处理,提高了实时音频处理能力,并提供丰富的示例代码和文档支持。API设计直观易用,支持跨平台使用,是音频应用开发者的优选工具。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?