背景:女票快毕业了(没错!我是有女票的!!!),写论文,主题是儿童性教育,查看儿童性教育绘本数据死活找不到,没办法,就去当当网查询下数据,但是数据怎么弄下来呢,首先想到用Python,但是不会!!百度一番,最终决定还是用java大法爬虫,毕竟java熟悉点,话不多说,开工!:

实现:

首先搭建框架,创建一个maven项目,使用框架是springboot和mybatis,开发工具是idea,pom.xml如下:

4.0.0

org.springframework.boot

spring-boot-starter-parent

2.1.4.RELEASE

cn.com.boco

demo

0.0.1-SNAPSHOT

demo

Demo project for Spring Boot

1.8

org.springframework.boot

spring-boot-starter-data-jpa

org.springframework.boot

spring-boot-starter-jdbc

org.springframework.boot

spring-boot-starter-web

org.mybatis.spring.boot

mybatis-spring-boot-starter

2.0.1

mysql

mysql-connector-java

runtime

org.springframework.boot

spring-boot-starter-test

test

com.oracle

ojdbc6

11.2.0

org.apache.httpcomponents

httpclient

4.5.5

org.jsoup

jsoup

1.11.3

com.alibaba

fastjson

1.2.45

org.springframework.boot

spring-boot-maven-plugin

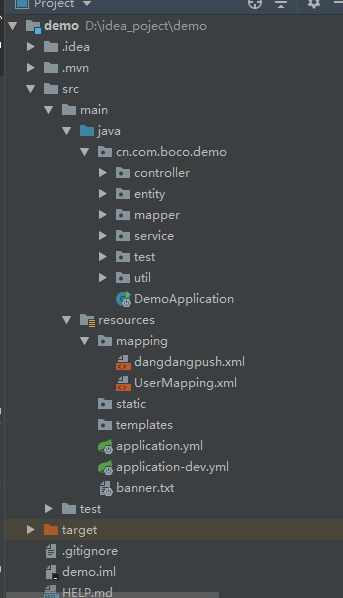

目录结构如下:

连接的数据库是oracle本地的数据库,配置文件如下

注意:application.yml文件中

spring:

profiles:

active:dev

指定的就是application_dev.yml文件,就是配置文件用的这个,在实际开发中,可以通过这种方式配置几份配置环境,这样发布的时候切换active属性就行,不用修改配置文件了

application_dev.yml配置文件:

server:

port: 8084

spring:

datasource:

username: system

password: 123456

url: jdbc:oracle:thin:@localhost

driver-class-name: oracle.jdbc.driver.OracleDriver

mybatis:

mapper-locations: classpath*:mapping/*.xml

type-aliases-package: cn.com.boc

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5240

5240

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?