简介:支持向量机(SVM)是一种在二分类问题上表现优秀的监督学习算法,通过找到最优超平面来实现最佳分类效果。本压缩包提供SVM的完整实现,包括svm.cpp、main.cpp和svm.h三个文件,涵盖了核函数的选择、训练和性能评估。通过ROC曲线和AUC值评估分类器性能,为模型优化提供定量和图形化的反馈。

1. 支持向量机(SVM)介绍和应用

1.1 SVM的定义及其在数据分类中的角色

支持向量机(Support Vector Machine, SVM)是一种强大的监督学习模型,主要用于分类问题。它通过在高维特征空间中寻找最大间隔的超平面,将不同类别的数据有效分隔开。SVM以其卓越的泛化能力,在图像识别、文本分类、生物信息学以及金融分析等多个领域都有着广泛的应用。

1.2 SVM的工作原理简介

SVM的核心思想在于找到一个最能代表两个类别数据分布的决策边界。在实际操作中,通过优化目标函数,求解得到支持向量,这些支持向量恰好位于决策边界上,从而定义了最优超平面。一旦超平面确定,新数据点就可以被分类,预测其属于哪一个类别。

1.3 SVM与其他分类算法的比较

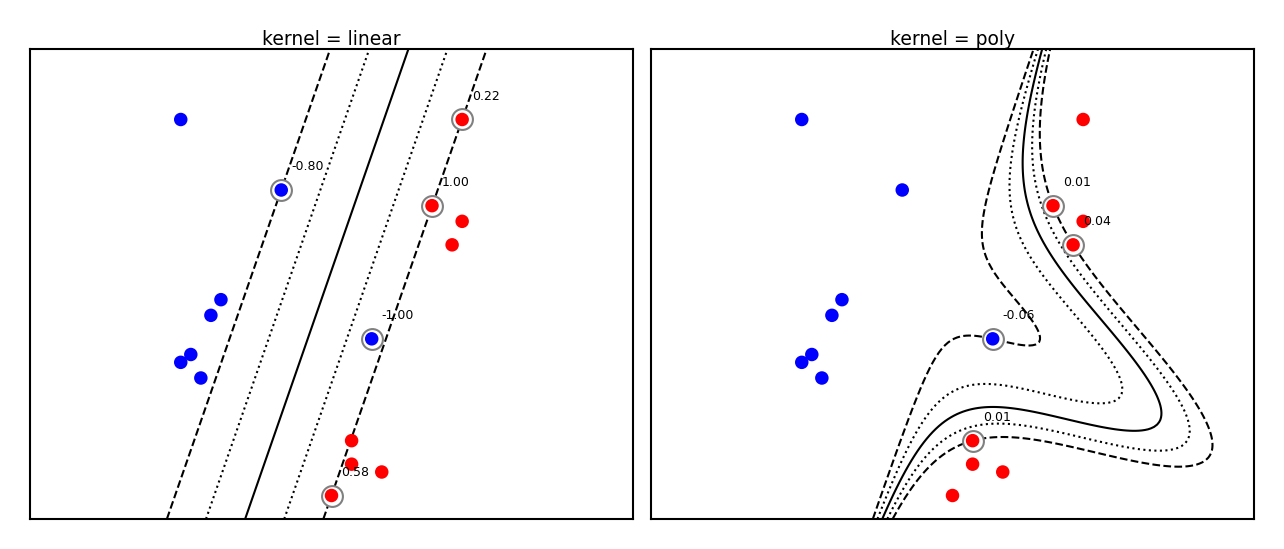

与其他分类算法相比,SVM具有良好的稳定性,且在样本数量较少的情况下也能表现良好。它的核心优势在于其核技巧,能够通过映射到高维空间中,解决线性不可分问题。然而,选择合适的核函数和调整模型参数是使用SVM时的关键挑战。

graph LR

A[数据集] --> B[预处理]

B --> C[SVM模型训练]

C --> D[模型评估]

D --> E{是否优化}

E -->|是| B

E -->|否| F[模型部署]

上面的Mermaid流程图概括了使用SVM的基本步骤,从数据预处理到模型评估,再到优化和最终模型部署,体现了一个完整的机器学习工作流程。

2. 最优超平面概念和SVM分类原理

2.1 最优超平面的定义和特性

2.1.1 超平面的概念

在SVM中,超平面是将特征空间划分为两个不同类别的决策边界的n维平面。对于二维空间,超平面可以简单理解为一条直线;在三维空间中则是一个平面;而在高维空间中,超平面无法直观描绘,但数学上可以定义。SVM的核心目标是找到一个能准确分隔不同类别数据点,并且具有最大分类间隔的超平面,这样的超平面被称为最优超平面。

2.1.2 线性可分和非线性可分的最优超平面

在理想情况下,如果数据是线性可分的,即通过一个线性函数可以完美地将数据分为两类,那么最优超平面就是能够实现这一完美划分的超平面。然而,现实世界中的很多数据集是线性不可分的,此时就需要借助核函数将原始特征映射到更高维空间,在那里实现线性可分,进而找到最优超平面。SVM通过引入软间隔和核函数等概念,能够处理非线性可分的情况。

2.2 SVM分类原理详解

2.2.1 SVM的基本原理

支持向量机(SVM)是一种监督学习模型,用于分类和回归分析。其基本原理是:首先在特征空间中找到一个超平面,使得两类数据被这个超平面分开,并且使得两个类别之间的间隔最大化。这个间隔被称为分类间隔。最大化间隔可以提高模型的泛化能力,减少过拟合的风险。

2.2.2 边界和支持向量的重要性

在SVM中,边界指的是距离超平面最近的数据点到超平面的距离。支持向量是那些恰好位于边界上的数据点。只有支持向量才能对超平面的位置产生影响,其他的数据点即使被移除,也不影响超平面的位置。这就意味着,SVM的决策规则仅依赖于支持向量,这也是SVM这一名称的由来。

2.2.3 损失函数和正则化项

为了找到最优超平面,SVM使用特定的损失函数和正则化项来处理不同的分类问题。对于线性可分的问题,SVM采用硬间隔最大化策略,此时的损失函数是0-1损失。但对于非线性问题,硬间隔最大化不再适用,因此引入了软间隔和松弛变量来允许一些点违反间隔约束,并引入正则化项,如L1和L2范数,以防止过拟合。软间隔最大化的目标是寻找一个超平面,使得大部分数据点被正确分类,同时最大化分类间隔。

为了更好地理解SVM的核心原理,我们可以以一个简单的一维数据集为例,尝试通过数学公式推导出SVM的最优化问题。以下是SVM在简单线性情况下的最优化问题:

假设数据集为 { (x_i, y_i) | i = 1, ..., n },其中 x_i 表示输入特征向量,y_i ∈ { -1, 1 } 表示类别标签。我们的目标是找到一个超平面 w^T x + b = 0,使得所有数据点满足以下条件:

- 对于 y_i = +1 的数据点,我们希望 w^T x_i + b ≥ 1

- 对于 y_i = -1 的数据点,我们希望 w^T x_i + b ≤ -1

其中 w 是超平面的法向量,b 是偏置项。为了最大化间隔,我们希望找到最小的 ||w||,即最小的 ||w||^2。因此,原始的最优化问题可以表示为以下形式:

min 1/2 ||w||^2

s.t. y_i (w^T x_i + b) - 1 ≥ 0, i = 1, ..., n

这个问题是一个二次规划问题,通常通过拉格朗日乘数法来解决。引入拉格朗日乘数 α_i ≥ 0,我们可以得到拉格朗日函数:

L(w, b, α) = 1/2 ||w||^2 - Σ α_i [y_i (w^T x_i + b) - 1]

对于每个数据点,如果 α_i > 0,则称该数据点为支持向量。通过求解这个对偶问题,我们可以找到最优的 w 和 b,从而得到最优超平面的参数。这个过程是SVM分类器训练的核心。

3. 核函数的作用及高维空间映射

在支持向量机(SVM)模型中,核函数是其核心概念之一,它允许我们在高维空间中使用低维数据来进行计算,而无需显式地映射数据点。核函数的引入极大地扩展了SVM的应用范围,并且使其在处理非线性可分数据时变得高效。下面将深入探讨核函数的作用、类型,以及高维空间映射的数学原理。

3.1 核函数的引入和类型

3.1.1 核函数的作用和意义

核函数的作用是使得在高维特征空间中的计算可以通过低维输入空间中的函数计算来完成。这在计算上具有极大的优势,尤其是在特征维度非常高时,直接计算高维空间中的点积将变得不切实际。

核函数允许我们将原始数据映射到一个更高维的空间,在这个空间中,原本线性不可分的数据可能变得线性可分。SVM利用核函数的这一特性,通过核技巧隐式地完成数据映射,从而构建出一个在原始输入空间中无法实现的最优超平面。

3.1.2 常见核函数对比

核函数有多种形式,每种核函数都有其特定的数学形式和适用场景。下面简要介绍几种常见的核函数:

-

线性核(Linear Kernel): $$ k(\mathbf{x}_i, \mathbf{x}_j) = \mathbf{x}_i^T \mathbf{x}_j $$ 线性核是最简单的核函数,它不涉及高维空间的映射,适用于线性可分数据。

-

多项式核(Polynomial Kernel): $$ k(\mathbf{x}_i, \mathbf{x}_j) = (\gamma \mathbf{x}_i^T \mathbf{x}_j + r)^d $$ 其中,$\gamma$、$r$ 和 $d$ 是多项式核的参数。多项式核可以创建非线性决策边界。

-

径向基函数核(Radial Basis Function,RBF): $$ k(\mathbf{x}_i, \mathbf{x}_j) = \exp(-\gamma \|\mathbf{x}_i - \mathbf{x}_j\|^2) $$ RBF核是一种常用的核函数,它的参数 $\gamma$ 决定了数据映射到高维空间后的分布密度。RBF核能够处理复杂数学关系的数据。

-

Sigmoid核: $$ k(\mathbf{x}_i, \mathbf{x}_j) = \tanh(\gamma \mathbf{x}_i^T \mathbf{x}_j + r) $$ Sigmoid核函数的行为类似于双层神经网络中的激活函数,但是它的使用并不常见,因为它并不总是满足核函数的必要条件,有时可能导致优化问题。

在选择核函数时,需要根据具体的数据集和问题进行考量。不同的核函数对于模型的性能和计算效率有着直接影响。

3.2 高维空间映射的数学原理

3.2.1 从低维到高维的映射过程

考虑一个简单的线性可分问题,数据集在二维平面上可以被一条直线清晰地分割开。然而,对于非线性问题,往往不存在这样的直线。为了处理这类问题,可以使用映射函数将数据映射到更高维的空间中,其中数据点可能变得线性可分。

例如,假设我们有二维空间中的数据点 $\mathbf{x} = [x_1, x_2]^T$,我们可以定义一个映射函数 $\phi$,将二维数据映射到三维空间中:

$$ \phi(\mathbf{x}) = [x_1^2, \sqrt{2}x_1x_2, x_2^2]^T $$

映射后的数据点将位于三维空间中的一个抛物面内。在新的空间中,我们可以使用简单的线性方法来找到一个超平面,使其能够正确地分类原始数据。

3.2.2 核技巧在SVM中的应用

核技巧的核心思想是利用核函数直接计算映射后的特征空间中的点积,而无需实际进行映射。这意味着我们无需知道映射后的具体特征,也能够计算出支持向量机需要的点积值。

核技巧的数学表达式可以表示为:

$$ K(\mathbf{x}_i, \mathbf{x}_j) = \phi(\mathbf{x}_i)^T \phi(\mathbf{x}_j) $$

其中 $K$ 为核函数,$\phi$ 为映射函数,$\mathbf{x}_i$ 和 $\mathbf{x}_j$ 为原始空间中的两个数据点。核函数的选择决定了映射函数 $\phi$ 的形式,但核函数本身并不需要知道 $\phi$ 的具体表达式。

核技巧在SVM中的实际应用涉及优化问题的求解,需要构建一个二次规划问题,其拉格朗日乘子法的求解过程涉及核函数的计算。通过这种方式,SVM能够高效地处理高维空间中的非线性可分问题。

结语

核函数的引入是支持向量机得以广泛应用的关键技术之一。它不仅简化了高维空间的计算,还使得SVM能够在多种复杂的实际问题中表现优异。不同类型的核函数针对不同性质的数据集有着不同的表现。理解核函数的工作原理和选择合适的核函数对于构建一个高性能的SVM模型至关重要。在下一章节中,我们将深入探讨ROC曲线和AUC值的计算及其在模型评估中的意义。

4. ROC曲线和AUC值的计算与意义

4.1 ROC曲线的定义和绘制

4.1.1 真正例率(TPR)和假正例率(FPR)

ROC(Receiver Operating Characteristic)曲线是评估分类模型性能的一种常用工具,尤其在数据不平衡问题中表现突出。它通过可视化的方式表示了分类器在不同阈值下的性能。ROC曲线的横轴是假正例率(FPR),纵轴是真正例率(TPR)。

TPR(True Positive Rate),也就是真正例率,是指模型正确预测正样本的能力,计算公式为TPR = TP / (TP + FN),其中TP是真正例的数量,FN是假负例的数量。

FPR(False Positive Rate),也就是假正例率,是指模型错误预测负样本为正样本的比例,计算公式为FPR = FP / (FP + TN),其中FP是假正例的数量,TN是真负例的数量。

4.1.2 ROC曲线的绘制方法

绘制ROC曲线的步骤可以分为以下几个步骤:

- 确定一系列的候选阈值。

- 对于每一个阈值,计算其TPR和FPR。

- 在坐标图上绘制对应的点 (FPR, TPR)。

- 将这些点用线连接起来,得到ROC曲线。

在实际操作中,通常通过改变分类阈值来计算不同的TPR和FPR,然后将这些点绘制在图上,通过平滑曲线连接这些点即可得到ROC曲线。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.metrics import roc_curve, auc

# 假设y_true是真实的标签,y_scores是预测的概率

y_true = np.array([1, 1, 1, 0, 0, 0])

y_scores = np.array([0.9, 0.8, 0.65, 0.4, 0.35, 0.1])

# 计算FPR, TPR和阈值

fpr, tpr, thresholds = roc_curve(y_true, y_scores)

# 计算AUC值

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

lw = 2

plt.plot(fpr, tpr, color='darkorange',

lw=lw, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=lw, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic Example')

plt.legend(loc="lower right")

plt.show()

4.2 AUC值的计算和解读

4.2.1 AUC值的意义和计算方法

AUC(Area Under Curve)值是ROC曲线下面积的缩写,它的值介于0和1之间。AUC值越大,表示模型的分类性能越好。一个随机猜测的分类器的AUC值大约为0.5,而一个完美分类器的AUC值为1.0。

AUC值可以通过积分ROC曲线下面积来计算,也可以使用统计方法直接计算。其中,ROC曲线下的面积可以通过梯形法则来近似计算,而sklearn库中的 auc 函数就是采用这一方法。

4.2.2 AUC在模型评估中的作用

AUC值的一个重要作用是它对不同类别分布情况下的分类器性能给出了一个单一的数值评价。尤其在数据集不平衡的情况下,传统的准确度评价指标(如准确率、精确率和召回率)可能会因为数据不平衡而产生误导。相比之下,AUC值不依赖于样本的分布情况,可以更好地衡量分类器的性能。

在模型选择过程中,如果存在多个模型,AUC值可以辅助决策者选择一个总体性能最优的模型。同时,AUC值也可以与交叉验证等方法结合使用,以评估模型的稳定性和泛化能力。

from sklearn.metrics import roc_auc_score

# 使用roc_auc_score直接计算AUC值

auc_score = roc_auc_score(y_true, y_scores)

print(f'AUC Value: {auc_score}')

在上述代码中,我们使用 roc_auc_score 函数直接计算了预测结果的AUC值,这是一种更简便的方法。然而,在进行更深入的分析时,绘制ROC曲线并手动计算AUC值仍然具有重要的教育意义和研究价值。

5. svm.cpp、main.cpp和svm.h代码文件功能

5.1 svm.cpp核心功能解析

5.1.1 代码结构和主要函数

在 svm.cpp 中,核心功能的实现是通过一系列精心设计的函数完成的。这些函数共同作用,实现了支持向量机的训练、预测以及超参数优化等关键步骤。下面列出了svm.cpp中几个关键的函数及其简要说明:

-

trainSVM(): 这个函数是整个训练过程的核心。它接收训练数据集、类别标签和相关参数,然后使用SVM算法对数据进行学习,最终得到一个训练好的模型。 -

predictSVM(): 一旦模型训练完成,此函数用于对新的数据实例进行分类预测。它通常接收一个数据实例和训练好的模型作为输入,并输出预测结果。 -

crossValidate(): 进行交叉验证以评估模型在未见过的数据上的表现。它有助于防止过拟合并选择最佳的超参数设置。

svm.cpp 的代码结构通常遵循一种面向对象的设计原则,其中包含类和方法来封装数据和操作。例如,可以有一个 SVM 类,其成员函数就包括 train() , predict() , 和 crossValidate() 等。

5.1.2 支持向量机的训练过程

支持向量机的训练过程是通过 trainSVM() 函数实现的。在这个函数中,SVM的核心算法被调用,它通过优化目标函数来找到最优的超平面。该过程通常包括以下几个步骤:

- 初始化:设置SVM的学习算法参数,包括正则化参数、核函数类型等。

- 选择优化算法:根据问题的类型和数据的特点,选择合适的优化算法,例如序列最小优化(SMO)算法。

- 对偶问题求解:将原始的优化问题转化为对偶问题,并利用拉格朗日乘子法进行求解。

- 得到最优解:通过优化算法迭代,最终得到支持向量以及相应的拉格朗日乘子,这构成了最优超平面的参数。

下面是一段简化的 trainSVM() 的伪代码示例:

void trainSVM(DataSet trainData, Labels labels, SVMParameters params) {

// 1. 初始化参数

initializeParameters(params);

// 2. 选择优化算法,如SMO

SMOAlgorithm smo;

// 3. 求解对偶问题

DualProblem dualProblem = smo.optimize(trainData, labels, params);

// 4. 保存最优解

optimalAlphas = dualProblem.alphas;

supportVectors = dualProblem.supportVectors;

// ...其他相关计算...

}

这段代码中省略了细节的实现,如 initializeParameters() , optimize() 等函数的具体内容。但这里可以看出,SVM的训练过程涉及了参数初始化、优化算法选择、对偶问题求解和最优解的保存几个关键步骤。

5.2 main.cpp程序流程概述

5.2.1 主程序的组织和执行流程

main.cpp 通常是程序的入口点,负责组织整个程序的执行流程。它决定了程序如何接收输入,执行主要的逻辑,并输出结果。 main.cpp 中可能包含的步骤如下:

- 初始化 : 包括设置程序运行环境、导入必要的库文件、定义全局变量等。

- 参数解析 : 程序通过命令行参数或者配置文件接收输入,并进行解析。

- 数据加载 : 从文件中读取训练和测试数据集。

- 模型训练 : 调用

svm.cpp中的trainSVM()函数进行模型训练。 - 模型评估 : 使用交叉验证评估模型的性能。

- 预测和结果输出 : 使用训练好的模型对测试数据进行预测,并将结果输出到文件或控制台。

下面是一段 main.cpp 的伪代码,展示了上述流程:

int main(int argc, char** argv) {

// 1. 初始化

initializeApp(argc, argv);

// 2. 参数解析

Parameters params = parseArgs(argc, argv);

// 3. 数据加载

DataSet trainData = loadData(params.trainDataPath);

Labels labels = loadData(params.labelsPath);

// 4. 模型训练

SVMModel model = trainSVM(trainData, labels, params);

// 5. 模型评估

double accuracy = evaluateModel(model, trainData, labels);

// 6. 预测和结果输出

Labels predictions = predictModel(model, testData);

outputResults(predictions, testData);

return 0;

}

5.2.2 参数解析和模型调用

在 main.cpp 中,参数解析是至关重要的一步。它允许用户通过命令行参数或配置文件传递自定义设置,从而影响程序的行为。参数通常包括模型的超参数、数据集路径以及输出格式等。

为了实现参数解析,可以使用专门的库如 getopt 或者 Boost.Program_options 。以下是一个使用 getopt 解析参数的示例:

int main(int argc, char** argv) {

int c;

char* configFile = nullptr;

while ((c = getopt(argc, argv, "c:")) != -1) {

switch (c) {

case 'c':

configFile = optarg;

break;

case '?':

if (optopt == 'c') {

fprintf(stderr, "Option -%c requires an argument.\n", optopt);

}

fprintf(stderr, "Usage: %s [-c config_file]\n", argv[0]);

exit(EXIT_FAILURE);

}

}

// ...后续代码,加载配置文件...

return 0;

}

在这个例子中, -c 标志用来指定配置文件的位置。程序遍历 optarg 来读取对应的参数值。

模型的调用通常包括从 svm.cpp 中实例化SVM类,并调用其 train() 和 predict() 方法,如前面所述。在 main.cpp 中,通常会定义一个 SVMModel 结构体来封装训练好的模型。之后,该模型会被传递到不同的函数中进行预测和评估。

5.3 svm.h头文件的作用

5.3.1 定义数据结构和常量

svm.h 是程序中的头文件,其主要职责是声明程序中使用到的数据结构、常量和函数原型。在支持向量机程序中, svm.h 可能包含以下几个部分:

- 数据结构定义 : 包括数据点、类别标签、SVM模型的参数、模型超平面等。

- 常量定义 : 如数值精度、最大迭代次数、优化算法的收敛条件等。

- 函数原型声明 : 包括

trainSVM(),predictSVM(), 和crossValidate()等函数的原型声明。

例如, svm.h 中可能有如下内容:

// svm.h

#ifndef SVM_H

#define SVM_H

// 数据结构定义

struct Point {

vector<double> features;

double label;

};

struct SVMModel {

vector<double> weights;

vector<Point> supportVectors;

double bias;

};

// 常量定义

#define MAX_ITERATIONS 1000

#define EPSILON 1e-6

// 函数原型声明

SVMModel trainSVM(const vector<Point>& trainData, const vector<double>& labels, SVMParameters params);

vector<double> predictSVM(const SVMModel& model, const vector<Point>& testData);

double crossValidate(const vector<Point>& trainData, const vector<double>& labels, SVMParameters params);

#endif // SVM_H

5.3.2 函数声明和模块接口

在头文件 svm.h 中,函数声明定义了模块的接口。它告诉其他文件哪些函数是可用的,这些函数需要在实现文件(如 svm.cpp )中定义。这使得代码模块化和分层,便于理解和维护。通过这种方式,主程序(如 main.cpp )不需要知道具体的实现细节,只需调用声明的接口即可。

函数声明中通常包含函数名称、参数类型以及返回类型。例如:

// svm.h

SVMModel trainSVM(const vector<Point>& trainData, const vector<double>& labels, SVMParameters params);

这条声明表示 trainSVM 函数接受训练数据、类别标签和参数作为输入,并返回一个 SVMModel 类型的数据结构。

确保每个函数声明的参数和返回类型明确无误,有助于程序的健壮性和可维护性。当其他代码尝试调用不存在或签名不匹配的函数时,编译器会发出错误,这避免了运行时错误。

6. ROC图像和AUC值的生成及模型性能评估

ROC(Receiver Operating Characteristic)曲线和AUC(Area Under Curve)值是评估二分类问题模型性能的关键工具,它们可以提供模型在不同阈值下的分类能力的直观视图。本章将详细介绍如何生成ROC图像,并计算AUC值,以及如何利用这些工具对机器学习模型进行性能评估。

6.1 ROC图像的生成方法

ROC曲线通过描绘真正例率(True Positive Rate, TPR)和假正例率(False Positive Rate, FPR)在不同阈值下的关系,来展示分类器的性能。TPR是指模型正确识别正样本的能力,而FPR是指模型错误地将负样本判定为正样本的比例。

6.1.1 使用Python绘制ROC曲线

在Python中,我们可以使用 sklearn 库中的 roc_curve 和 matplotlib 库来绘制ROC曲线。以下是一个简单的示例代码:

import matplotlib.pyplot as plt

from sklearn.metrics import roc_curve, auc

# 假设 y_true 是真实的标签,y_scores 是模型预测的概率

y_true = [0, 1, 1, 0, 1]

y_scores = [0.1, 0.4, 0.35, 0.8, 0.7]

# 计算FPR和TPR

fpr, tpr, thresholds = roc_curve(y_true, y_scores)

# 计算AUC值

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

lw = 2

plt.plot(fpr, tpr, color='darkorange', lw=lw, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=lw, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

6.1.2 图像保存和导出技巧

绘制完ROC图像后,我们经常需要将图像保存为文件以便进行报告或演示。可以使用 matplotlib 库的 savefig 函数来实现:

plt.savefig('roc_curve.png')

此外,为了保持图像的质量,可能需要调整图像的分辨率和格式。例如,保存为PDF格式,并设置300 dpi的分辨率:

plt.savefig('roc_curve.pdf', format='pdf', dpi=300)

6.2 AUC值的计算和软件实现

AUC值是ROC曲线下方的面积,它提供了一个单一的数值来量化分类器性能的优劣。AUC值的范围从0到1,值越高,表示模型的分类能力越好。

6.2.1 AUC值的软件计算方法

在上面的代码示例中,我们已经使用 auc 函数计算了AUC值。实际上, roc_curve 函数返回的三个值中, fpr 和 tpr 是ROC曲线上的点,而 auc 函数则根据这些点计算出曲线下方的面积。

6.2.2 分析结果和性能评估

计算得到AUC值后,我们可以根据AUC值的大小来评估模型性能。通常,AUC值大于0.9表示模型性能很好;AUC值在0.7到0.9之间表示模型性能一般;AUC值小于0.7则表示模型性能较差。AUC值是对模型进行比较时非常有用的指标,尤其是当数据集中的正负样本比例不平衡时。

在实际应用中,通常会与其他性能指标(如精确率、召回率、F1分数等)综合使用,以获得更加全面的模型性能评估。

本章介绍了ROC曲线和AUC值的计算方法,以及如何利用这些工具来评估模型性能。通过生成ROC图像和计算AUC值,可以直观地理解模型在不同阈值下的分类能力,并根据AUC值对模型进行定量评估。这些工具在机器学习模型的选择和优化过程中起着至关重要的作用。

简介:支持向量机(SVM)是一种在二分类问题上表现优秀的监督学习算法,通过找到最优超平面来实现最佳分类效果。本压缩包提供SVM的完整实现,包括svm.cpp、main.cpp和svm.h三个文件,涵盖了核函数的选择、训练和性能评估。通过ROC曲线和AUC值评估分类器性能,为模型优化提供定量和图形化的反馈。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?