在仅使用2块 GPU 的情况下,在预训练好的模型上仅花费约18分钟便完成布局任务

《GPT4读ChiPFormer后作》

离线之强化学习,芯片布局策略新。

决策Transformer为基, 未见芯片尽迁移。

在线学习曾宠辱,GraphPlace、DeepPR、MaskPlace并立。

ChiPFormer崛起兮,布局时效悉优良。

样本效率显卓越,布局质量倍攀高。

秒画根据GPT4的诗创作的绘画作品

动画视频 (b 站):https://www.bilibili.com/video/BV1bV411K7ai/

动画视频 (YouTube):https://youtu.be/9-EQmDjRLHQ

相关论文:

- ChiPFormer: Transferable Chip Placement via Offline Decision Transformer, ICML 2023, https://arxiv.org/abs/2306.14744

- MaskPlace: Fast Chip Placement via Reinforced Visual Representation Learning, NeurIPS 2022,https://arxiv.org/abs/2211.13382

芯片数据:

https://drive.google.com/drive/folders/1F7075SvjccYk97i2UWhahN_9krBvDCmr

海报和 Virtual Chat:https://icml.cc/virtual/2023/poster/25027

项目地址:https://sites.google.com/view/chipformer

芯片设计这门艺术,在现代科技的世界里,显得愈发重要。布局,这一环节,关乎着芯片中的电路模块如何摆放,决定着它们的速度与能耗。随着芯片规模的不断壮大,布局问题也成为了一道难解之谜。

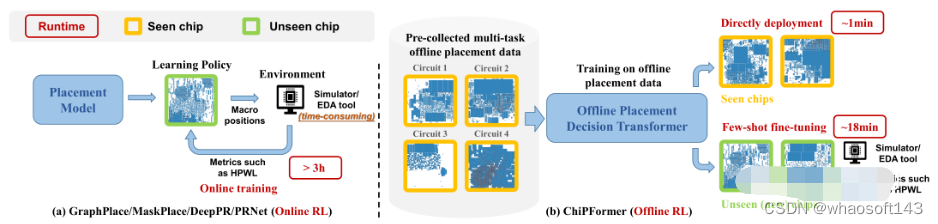

人们在寻求解决之道,而在ICML 2023所提出的ChiPFormer,给了一份答卷。这一方法,首次采用了离线强化学习,与Decision Transformer模型相结合,是芯片布局的新契机。ChiPFormer从人类专家们的布局作品中汲取智慧,学习到了可迁移的布局策略。这一策略,能在未曾谋面的芯片设计中,短短几分钟内完成布局。

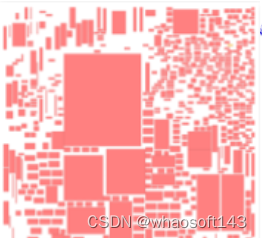

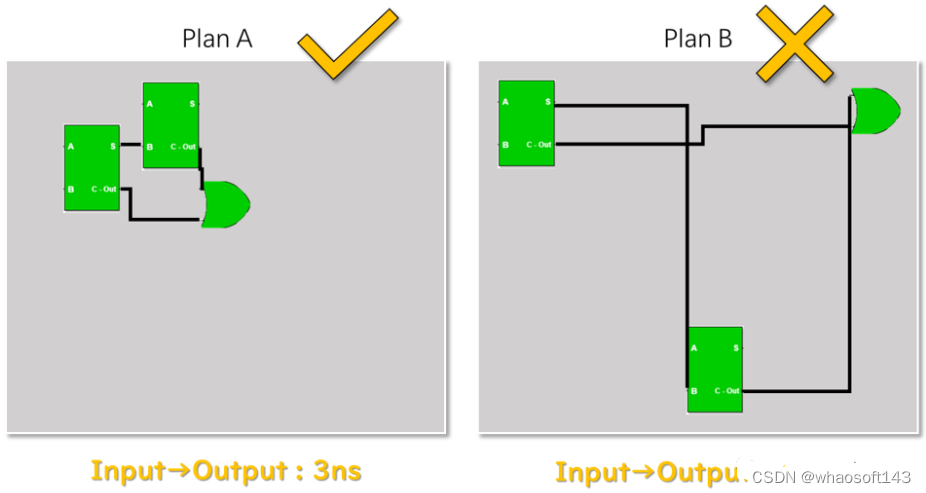

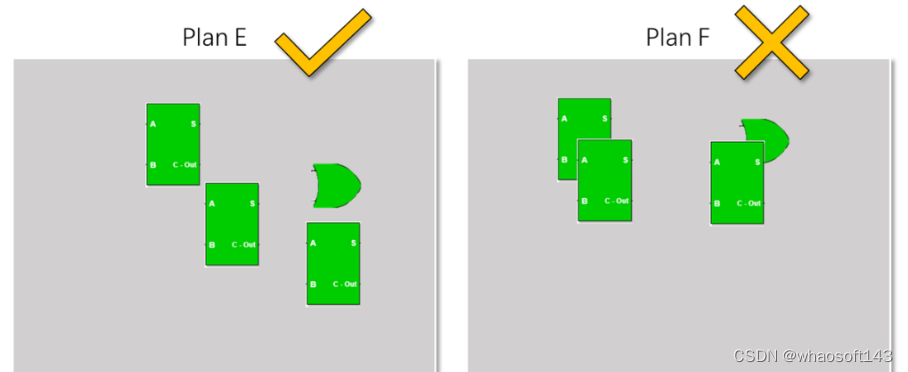

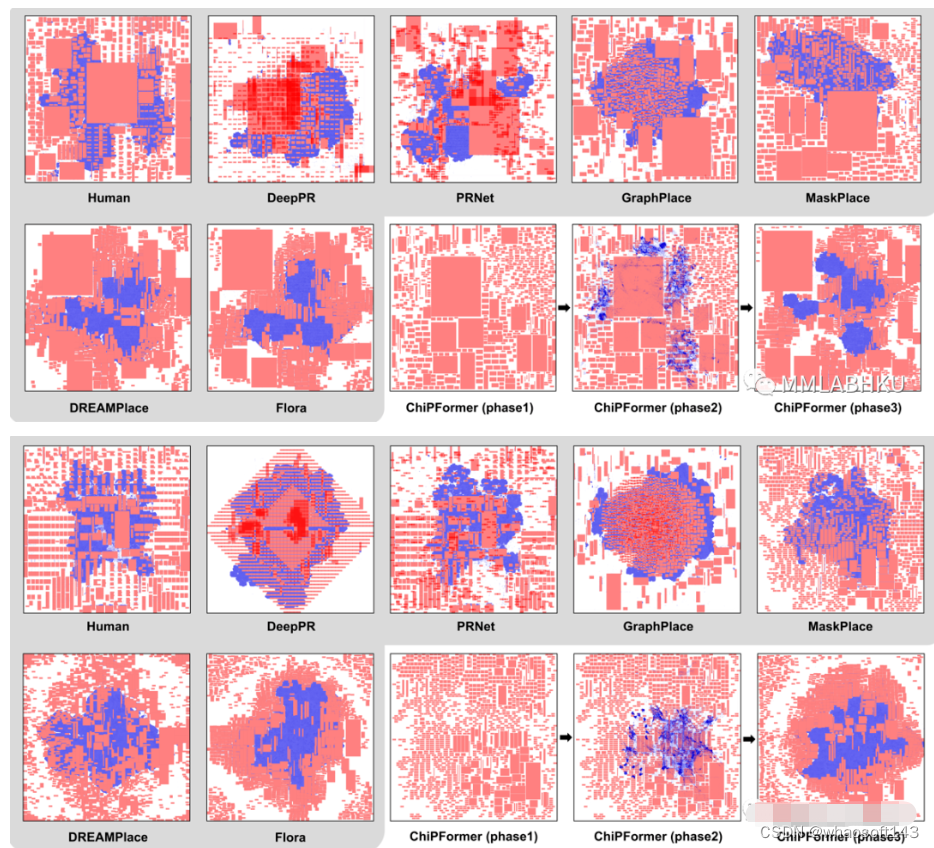

回顾过往,我们所使用在线强化学习方法,如GraphPlace、DeepPR、MaskPlace等,虽为芯片布局领域作出了贡献,但与ChiPFormer相比,时间和样本效率上仍相差甚远。ChiPFormer的出现,为芯片布局领域带来了一丝曙光,也为未来的相关研究奠定了基础。ChiPFormer布局示例如下。

第一阶段:Macro布局 第二阶段:Cell局宏 第三阶段:Macro+Cell混合局宏

芯片布局问题,不同企业有不同评价指标,多达十数种。一般容易理解的评价指标有三种:线长,拥塞和覆盖。

线长是指连接模块之间的导线长度越短越好,根据电路理论,信号的延时和导线长度的平方成正比。

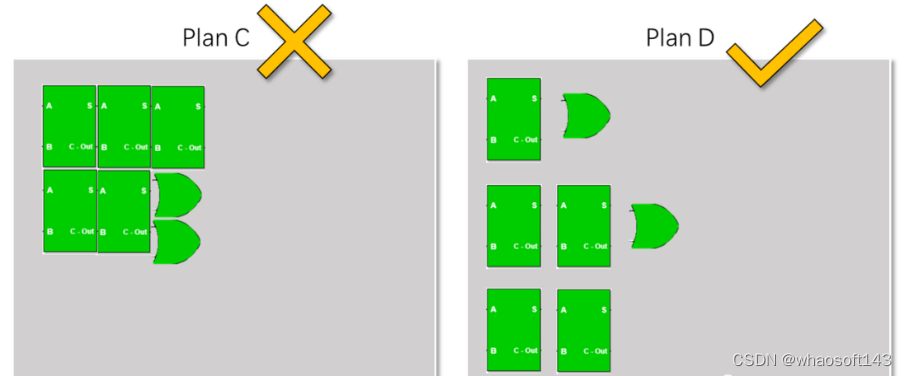

拥塞是指模块之间的拥挤程度,模块不能摆放过于密闭,否则会在布线阶段导致信息的传输受阻。

覆盖是指芯片制造规定任何两个模块之间相互不能有重叠。

近年来,芯片布局领域涌现出许多采用强化学习方法的研究。譬如谷歌在21年发表于《自然》杂志的《基于图的快速芯片设计》(A Graph Placement Methodology for Fast Chip Design),该研究提出的强化学习算法使得芯片布局的成果已能超越人类专家的眼界。

然而,目前这一系列的研究大多依赖在线强化学习方法,通常需要耗费漫长的时间来训练模型,以不断尝试和优化布局。以谷歌的这篇论文为例,它需在16块V100 GPUs上进行48小时的预训练以及6小时的微调。而近期的研究如MaskPlace (NeurIPS’22),同样需要在一块GPU上花费3小时以上的时间进行训练。此外,这些方法在处理未曾见过的芯片电路时,迁移能力欠佳,往往需要重新训练模型来适应新的芯片设计。

本篇论文所提出的 ChiPFormer,能在仅使用2块 GPU 的情况下,在预训练好的模型上仅花费约18分钟便完成布局任务。这一成果无疑为芯片布局领域揭示了新的可能性。

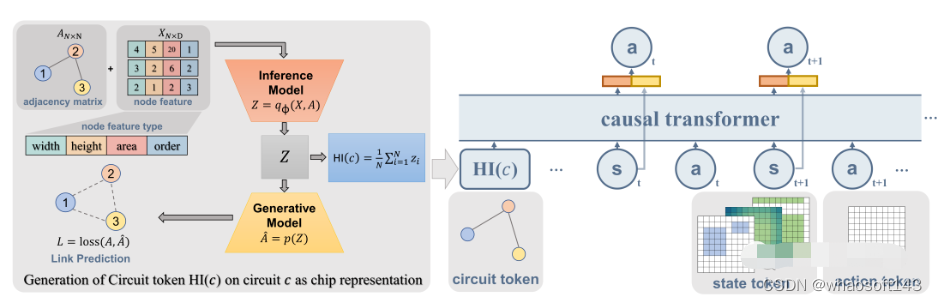

本文将芯片布局建模为一个离线强化学习问题,并提出了ChiPFormer模型。首次采用离线强化学习进行快速的可迁移布局策略学习。收集了包含12个芯片电路的多任务离线布局数据,并发布以促进相关研究。ChiPFormer是迄今为止第一个用于芯片布局的Transformer模型。它通过设定多任务机制可以学习到可迁移的策略,多任务即为不同芯片的布局任务。

创新

ChiPFormer 包含两个阶段:宏模块布局和混合模块布局(包含宏模块和标准单元模块)。

在宏单元布局阶段,ChiPFormer 在多任务离线数据上进行预训练,从而学习通用的布局策略。然后可以直接用于已见过的芯片的布局任务,或者用少量在线交互来微调迁移到未见过的芯片。

ChiPFormer 使用 Transformer 结构, 输入包括状态 token、动作 token 和电路 token。电路 token 通过图神经网络编码电路拓扑结构, 弥补状态和动作 token 中对结构信息的忽略。使得相似芯片可以使用相似的布局策略。

在混合尺寸布局阶段,ChiPFormer 的宏单元布局结果被用作初始布局,然后使用优化方法完成标准单元的布局。

结果

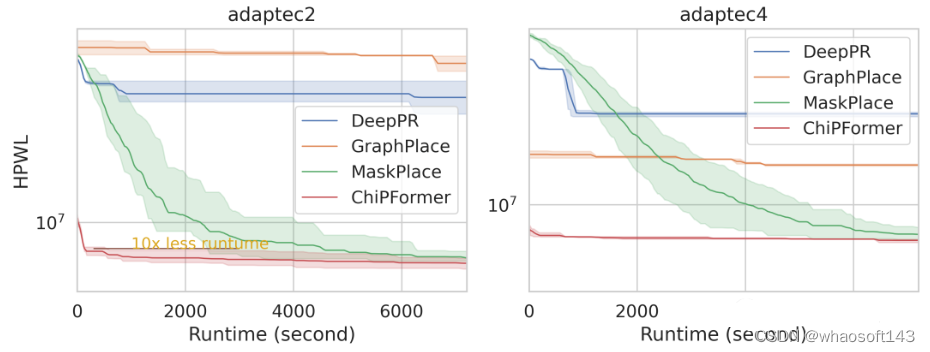

在32个公共和真实工业芯片电路测试集上,ChiPFormer可以将布局时间缩短10~30倍,同时相比其它方法提升布局质量。例如在12个未见过的芯片上,平均布局时间只需18分钟,相比GraphPlace方法缩短了97%的时间且最大可以使得线长缩短65%。对于混合尺寸的芯片布局,相比其他方法,同样可以达到最佳的布局结果。

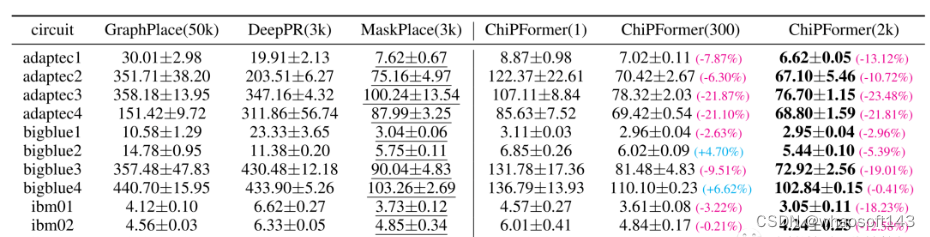

以下是宏模块芯片布局的实验结果:

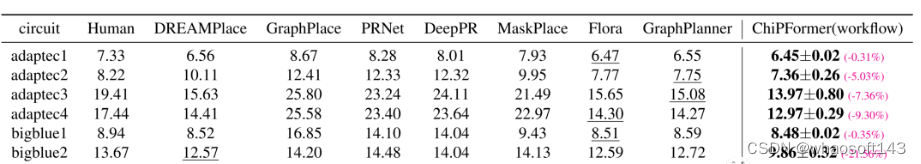

以下是混合尺寸芯片布局的实验结果:

芯片布局效率的实验结果:

以下是 ChiPFormer 方法和 baseline 方法的可视化结果:

展望

ChiPFormer 可用于快速高质量的芯片布局, 并设计了混合尺寸布局流程。可以从现有布局数据中进行预训练, 显著提升时间和样本效率。也可以取得强大的 Zero-Shot 迁移能力,在没有见过的新芯片上快速微调。在多个芯片设计任务中都优于当前最先进的方法。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?