Offset explorer连接Kerberos认证的Kafka

环境信息

系统环境:windows 10

Offset explorer版本:2.0

Kafka版本:Kafka_2.11-2.1.0

配置准备

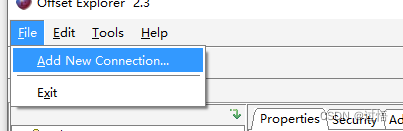

添加连接

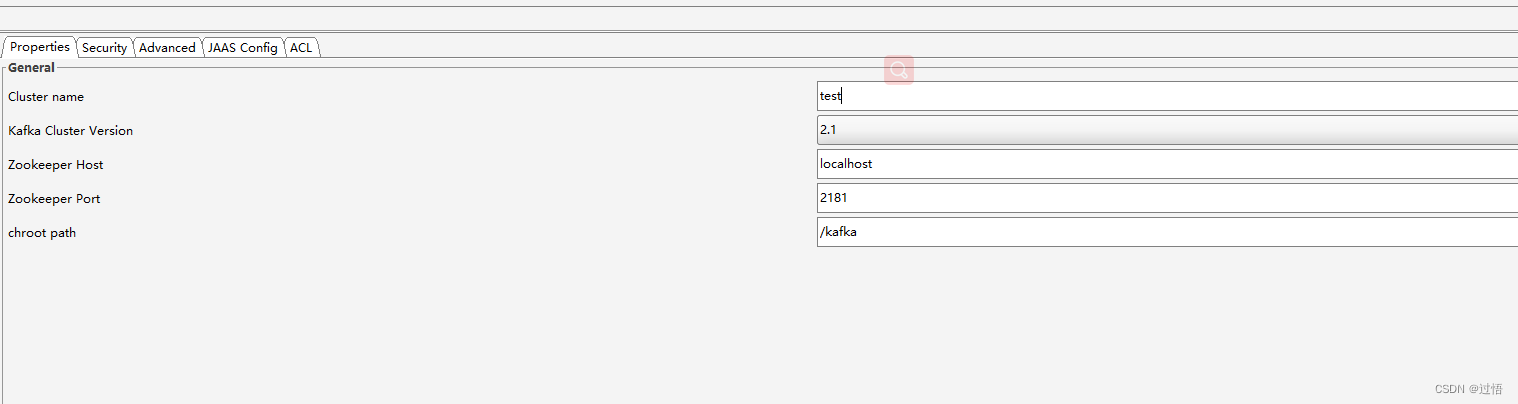

填写连接信息

Cluster name 随便填

Kafka Cluster Version根据自己的Kafka版本选择

Zookeeper Host 填写自己zk集群某台的ip地址

Zookeeper Port填写集群端口号(默认2181)

Chroot path Kafka使用zk中的目录地址

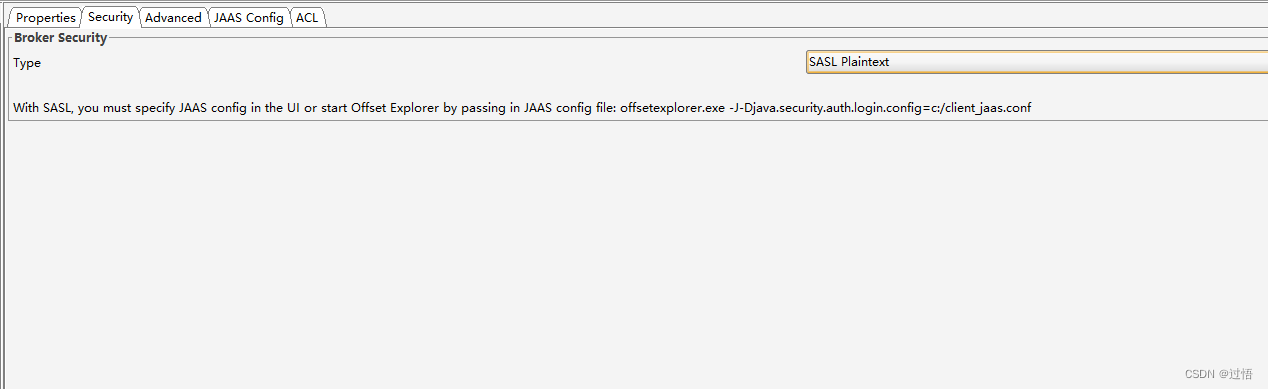

配置安全项

根据自己环境选择选择,我的环境是SASL_PLAINTEXT,下面选择SASL_PLAINTEXT即可。

SASL_PLAINTEXT:使用SASL框架来做认证和数据加密,使用明文传输数据

SASL_SSL:使用SASL框架来做认证和数据加密,使用SSL加密传输数据

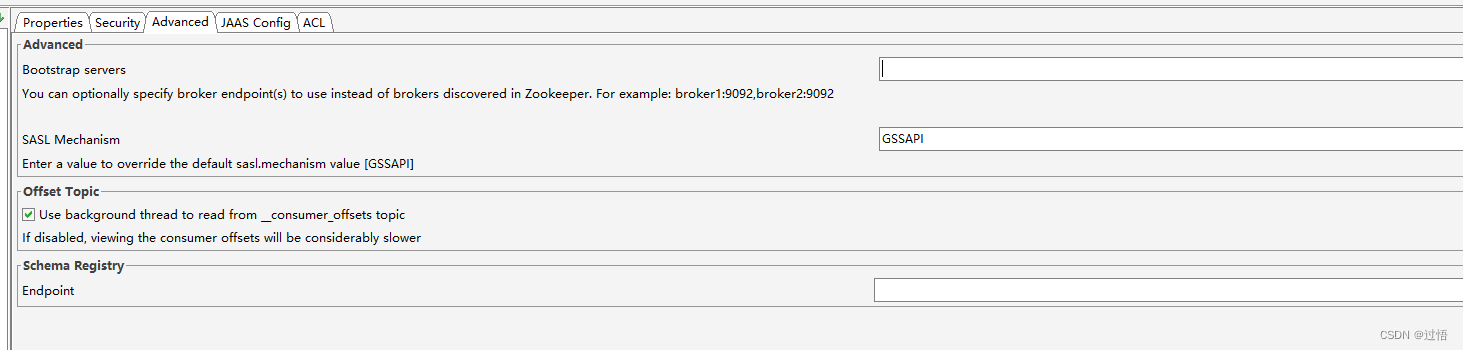

进一步设置

Bootstrap servers:配置自己的kafka的broker地址

SASL Mechanism: 填写GSSAPI(这里表示SASL的实现,GSSAPI是一套接口,现在只有Kerberos v5实现了这个接口;这里实际就是指的是Kerberos)

最后配置JAAS

如果不是使用GSSAPI可以参考官网;否则有两种方法,第一种命令行启动添加配置,第二种修改配置文件;

命令行启动

-

进入windows命令行界面

-

cd到offset explorer安装目录

-

输入如下启动命令(注意两个文件需要修改为自己的文件地址)

offsetexplorer.exe -J-Djava.security.auth.login.config=c:/client_jaas.conf -J-Djava.security.krb5.conf=c:/client.keytab

修改配置文件

找到offset explorer安装目录,然后打开offsetexplorer.vmoptions文件,在末尾添加如下信息(保存关闭,以后每次启动都会生效,如果访问其他KDC集群,请修改配置然后重启):

-Djava.security.auth.login.config=c:/client_jaas

-Djava.security.krb5.conf=c:/client.keytab

注意事项

java.security.krb5.conf=c:/client.keytab务必使用/分隔符

最后

如果有解决你的问题,记得点赞哦;谢谢~~~

2170

2170

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?