Interactive Hand Pose Estimation using a Stretch-Sensing Soft Glove是在2019年SIGGRAPH大会上得到展示的一种交互式数据手套,交互式数据手套是一种传感设备,可以充当虚拟手与VR系统进行交互。通过将这类数据手套戴在手上,可以在虚拟世界中抓取、移动和操控各种物体。交互手套在游戏、机器人,生物力学分析等领域都有很重要的应用,虚拟现实和增强现实也依赖于这种交互手套来恢复手部的姿态。

3.1 Introduction

手部姿态估计大致可以分为两类,分别是有标记和无标记两类,有标记的方案一般就是通过光学式动作捕捉系统比如Vicon等实现。而无标记的方式一般也分为两种,分别是基于视觉的光学式和基于传感器两种类型。基于视觉的方案一般都是基于多个摄像机或者单深度相机或者单眼相机等。也都是需要用到相机来捕获手部运动的。因此这种基于视觉的方法在遮挡等比较复杂的环境下捕获手部姿态的能力会变差。而基于传感器类型的解决方案是将传感器直接安装在用户的手上,消除了直接视线的需要,可以提高捕捉的鲁棒性和可靠性。

基于传感器的方案最普遍的一种是基于IMU惯性测量单元的交互式手套,这类解决方案早已被提出并且已经实现商用了,例如Preception Neuron 2的用来捕获手部姿态的数据手套以及ManusVR Glove。基于IMU的交互式手套准确性并不是很高,由于空间的限制,在手套上放置足够数量的传感元件以获取手部的所有自由度是一个挑战。因此,大多数现有的解决方案使用的传感器比人手的自由度要少。这本质上限制了手部姿态重建的保真度。人的手一般来说至少有25个自由度,而不可能在数据手套上放那么多的惯性测量单元,会很影响用户手部的输入。

而论文中提出的交互式手套不需要外部感应,手套很薄,手套很薄意味着易于穿戴和脱下并且易于手部活动同时该数据手套柔软性好并且可拉伸,这要归功于用硅树脂生产的柔软的、可拉伸的传感器阵列,所以该交互式手套穿戴舒适,还有这个交互式手套在不使用光学装置的情况下也能精确地重建手的姿态,重建精度相比于商用的交互式数据手套提高了大概35%。同时这个手套只需要最小的校准。以上的特点就是作者提出的交互式手套的优势。

基于交互手套的手部跟踪解决方案一般都要满足三方面的需求,分别是Real-time实时性,Comfortable舒适性和Working in a variety of environments and settings能够在各种严峻的环境比如说严重的遮挡或者光照环境下工作。图1是该拉伸感应手套在录制的实时会话中的帧,从图中可以看出,它的实时性很好,并且精度也很高,在面对严重的遮挡比如植物遮挡下,也不影响他的捕获效果,所以说这个拉伸感应手套的抗干扰性也比较强。

3.2 Composite Capacitive Glove

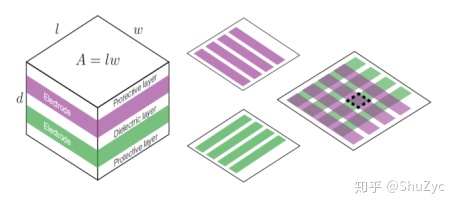

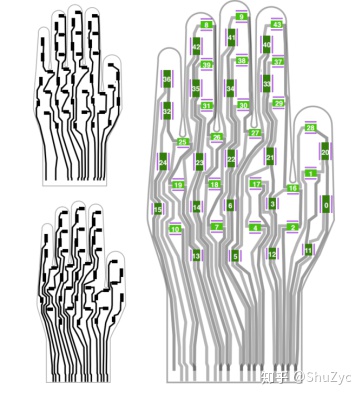

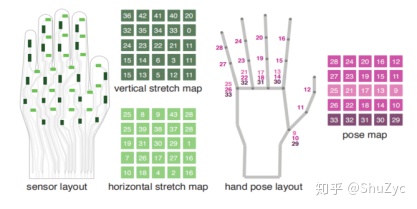

这一小节主要介绍的是该数据手套的基于硅树脂的可拉伸传感器阵列的设计。论文中的数据手套的核心就是基于硅树脂的拉伸传感器阵列,专门设计用于重建灵巧的手关节。设计特点是44个独立的拉伸传感器在一个手形硅胶传感器阵列上,再连接到一个弹性纺织品形成一个薄的形状因子手套。手套的总重量只有50克,而厚度只有1.2毫米,即使长时间使用也很舒适。并且手套也可以很好地适应一系列的手大小和形状。该传感器是一种复合材料,由纺织层与导电和非导电硅胶层组合而成。而下图2电容式硅树脂的可拉伸传感器以及关于传感器单元的设计。是由5层组成。电容器由两块导电板组成,两块导电板有重叠区域A。而传感器单元的设计是由洋红色和绿色两种导电条重叠后形成的局部电容而成。图中虚线标注的就是一个传感器单元。每对导电条最多重叠一次。图中的这种网格结构是为了增加放置在某个区域的传感器的数量而设计的。最终作者通过这种传感器设计的方式用27根导线完成了手套上的44个传感器的设计。

而图3是关于传感器的布局Sensor layout,图中的左边部分是同一只手套两个导电层的图案,而右边部分是当两层导电层重叠时,形成的局部电容用绿色标记,用来充当局部可拉伸传感器。

传感器的布局是通过分阶段添加传感器手工设计而成的,分为4个阶段,第一阶段是较长的传感器直接对应的主要关节手指(21 - 24,32-36 40-42)和拇指(0, 20),第二阶段是手指间的外展传感器16以及25 -27,第三阶段是垂直于手指上的传感器(8-9,29-31,37-39,43)以及拇指1和28,第四阶段是水平的规则网格(2, 4 ,7,10, 17-19)以及手背上的垂直(3,5,6,11 -15)传感器。由这四个阶段最终实现了该数据手套的基于硅树脂的可拉伸传感器阵列的设计,图3中右边部分的用紫色标记的传感器两侧的细切口是通过激光切割而成的,一方面可以提高穿着舒适度,另一方面由于该设计降低了拉伸力阻力,从而使传感器对平行于切口的拉伸更加敏感,对读数有轻微的积极影响。

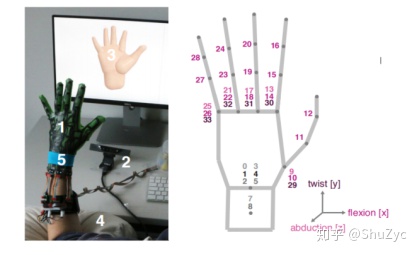

3.3 Data-Driven Hand Pose Estimation

该小节是对数据驱动的手部姿态估计部分的概述,作者指出由于手的几何形状不同,传感器的读数也会因人而异。所以作者提出了使用了这种Data-Driven的方法来学习跨不同会话和用户的高度非线性映射。主要通过数据采集、数据处理并将采集的数据再神经网络中进行训练这几部分组成。当用户带上手套进行训练后,不再需要深度相机就可以准确的捕捉手部的姿态。图4是训练数据捕获设置以及手姿态参数,图4的左半部分是训练数据捕获设置,分别由手和手套、深度相机、计算机、舒适的枕头以及蓝色的这个分割腕带一共5个部分组成的。其中这个蓝色的这个分割腕带是用于深度分割的,首先通过深度相机捕获到带有深度信息的帧,然后将深度帧输入到已有的算法进行校准和训练数据的捕获。而图4的右半部分是34个手姿态参数,论文中的手套可以捕获25个自由度,能捕获的25个自由度是用紫色的颜色表示的,而灰色的自由度代表的是手的全局平移和旋转以及手腕的旋转,仅用拉伸传感器是无法获得这些代表全局位姿参数的灰色自由度的。

图5是数据表示即输入和输出的一种几何对应。输入有44个传感器,根据44个传感器的数据表示可以得到25个自由度的手部姿态估计。输入部分的数据表示是由两个5*5的网格组成的,分别代表的是测量水平拉伸的传感器输入数据和测量垂直拉伸的传感器输入数据。而输出数据也是有一个5*5的网格表示的,代表的是25个自由度的参数数据。

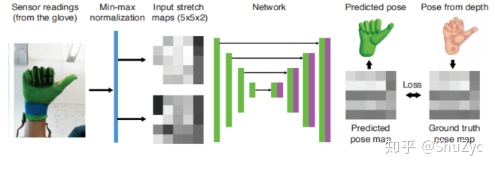

图6是输入输出的训练流程图,首先是去除异常值和使用最小-最大归一化方法进行校准,可以提高数据质量,得到两个5x5的Input stretch maps。然后是使用U-Net网络架构将组织好的传感器读数转换为手部姿态参数。U-Net是一个Encoder-Decoder的结构,最后平方损失函数就是预测的姿态图和ground truth pose之间的L2-范数差。

3.4 Result

作者分别测试了10个不同的人在该手套的不同条件下的平均姿态角度误差。如表1所示,分别是personalized个性化模型,Generic通用模型以及Fine-tuned模型三种不同的模式,个性化模型是指用户需要利用外部硬件深度相机来训练这个交互式手套并拿来测试,因此花费的时间较长但是误差最小。而intra和inter的区别是训练模型的形式不同,intra是指同一会话内进行训练和测试,inter是指在不同的会话间进行训练和测试。Generic通用性模型是指所有参与者的数据进行训练后的模型,然后没有经过训练的人拿来直接测试的。有未经过校准和经过校准两种方式,经过个性化校准的手套的平均姿态角度误差是7.6°,因为他这是一个微校准,花费的时间也比较短,相比于未经过校准的8.3度好了很多。而第五种模式是一种微调整的模式,只获取5分钟的个人训练数据,再对通用模型进行大约15分钟的微调。能得到比模式4更好的结果,相比于模式2的2.5小时,模式5的性能也没有差很多。现如今两种较好的商用型数据手套ManusVR和CyberGlove的测试平均姿态角度误差分别为11.9和10.5。

图7是不同的模型进行的可视化比较。分别是模式2个性化模型,模式4通用模型和模式5微调整模型。个性化模型2的表现是最好的,与真实的输出手势是最接近的,而模式5微调整模型的表现次之,通用模型4的表现最差一些,但这三种模式都很好的捕捉了这些手势,只是精度方面的差别。但是对精度的要求越高也意味着花费更多的时间在训练和数据调整上。

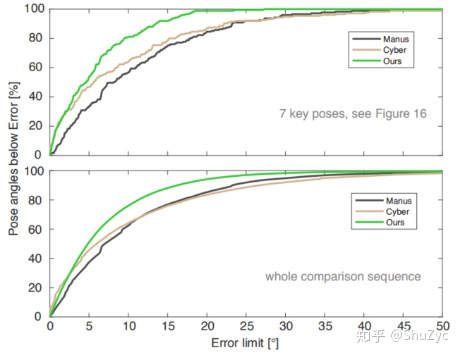

图8是论文中交互式手套和两种商用类型的手套ManusVR和CyberGlove的累计误差比较。ManusVR手套是一种基于弯曲传感器和惯性测量单元的数据手套,而CyberGlove是一种基于Flex传感器的数据手套。图8中上半部分是关键手势的累积误差图,比较这三种不同的手套。在关键姿势上,论文中的这个方案能预测出误差在15度以下的92%的角度。而CyberGlove只能预测出其中79%的角度,而ManusVR只能预测出其中72%的角度。图8中的下半部分所有手势的累积误差图。显然论文中提出的手套在捕捉精度上超过了这两种商用的交互式数据手套。

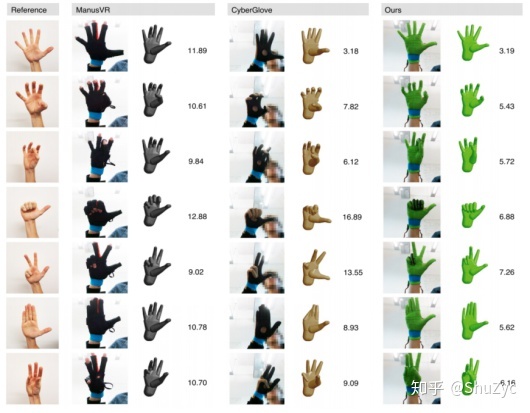

而图9是三种手套在7种不同的关键姿势下的可视化比较。就视觉效果而言,论文中的方案要优于CyberGlove和ManusVR。

3142

3142

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?