python逻辑回归分类算法:

逻辑回归不是回归算法,是分类算法,本身就是一个二分分类的算法。

二分分类:分类结果标签只有两个。

机器算法输入的标签是数值型。

与线性回归算法的区别:

线性回归预测的结果y是连续的数值。

逻辑回归预测的结果y是离散型数值。

逻辑回归的原因是逻辑函数参数z是一个回归函数。

逻辑函数:

可以将y值控制在0-1之间。

逻辑函数值表示分类结果为某一个标签值时的概率值,通过映射关系到标签值上面。

将训练数据的值的特征和标签转换成一个决策面。

python实现方法:sklearn实现逻辑回归。

步骤:

1.提取特征和标签。

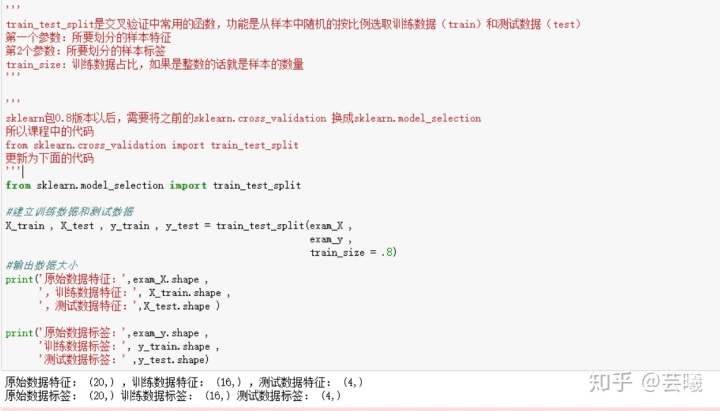

2.建立训练数据,测试数据。

3.训练模型

导入逻辑回归函数,创建逻辑回归模型,训练数据用fit函数。

4.评估模型准确率。

测试数据导入到模型,是X_test,y_test导入,结果是准确率。

5.通过考试的概率值的函数:model.predict_proba()

总结:

1.线性回归适合连续型特征和标签的数据。

逻辑回归适合离散型特征和标签的数据。

2.逻辑回归是逻辑函数里面套用了回归函数。

3.线性回归重点是得出最佳拟合线。

逻辑回归重点是得出决策面。

4.线性回归是通过决定系统R平方确定准确率。

逻辑回归是通过正确率决定模型是否准确。

5.逻辑回归可以预测通过考试的概率值。

3323

3323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?