hadoop单机搭建

这几天准备开始学习hadoop,网上很多教程说的是用虚拟机搭建分布式、伪分布式hadoop集群,整了几天也没弄好。上次偶遇一位高人,指点迷津说你为啥不搭一个单机版的hadoop。遂茅塞顿开,一个小时不到就搞定了。

首先,由于hadoop是用java写的,所以在安装hadoop之前呢,需要先把jdk环境装好。

jdk的安装在此就不赘述了,无非就是先下载,解压,环境变量配置啥的~

hadoop安装

- 首先你得去官网把下载地址搞到手:http://hadoop.apache.org/

- 点击Download按钮去下载页面:

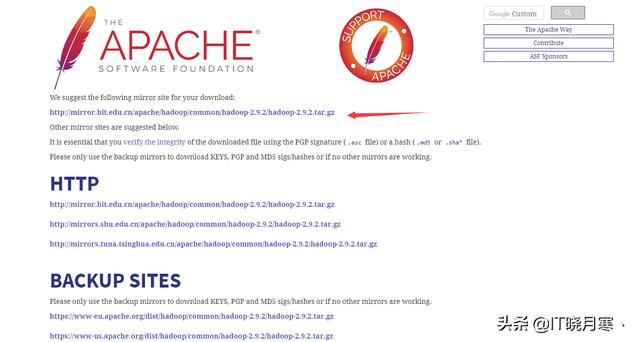

在这个页面,选择你喜欢的版本Binary download,反正我选的是2.9.2。

- 点击binary标签,进入下载地址页面:

复制这个地址,这是hadoop建议你下载的地址。

- 如果有防火墙啥的关一关,如果是云服务器的话需要配置安全组,开通两个端口:8088和50070.

- 下载:

- 使用wget下载就行了,在你喜欢的地方使用命令:

- wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz

- 解压:

- tar -xvf hadoop-*.tar.gz

- 修改环境变量:

- vim /etc/profile

- 以下是我的环境变量配置文件:

JAVA_HOME=/usr/java/jdk1.8.0_161MAVEN_HOME=/usr/local/apache-maven-3.6.0HADOOP_HOME=/my/hadoop/hadoop-2.9.2HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/nativeHADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"PATH=$JAVA_HOME/bin:$MAVEN_HOME/bin:$HADOOP_HOME/bin:$PATHCLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport JAVA_HOMEexport PATHexport CLASSPATH- 路径需要按照你自己配置的路径去修改。

- 使环境变量生效:

- source /etc/profile

- 新建一些文件夹供hadoop使用:

mkdir /root/hadoop mkdir /root/hadoop/tmp mkdir /root/hadoop/var mkdir /root/hadoop/dfs mkdir /root/hadoop/dfs/name mkdir /root/hadoop/dfs/data- 进入hadoop目录下:

- cd /my/hadoop/hadoop-2.9.2/etc/hadoop/

- 修改core-site.xml

hadoop.tmp.dir/root/hadoop/tmpAbase for other temporary directories.fs.default.namehdfs://your ip:9000- 修改 hadoop-env.sh

export JAVA_HOME=${JAVA_HOME}- 修改为

export JAVA_HOME=/usr/java/jdk1.8.0_161- 修改hdfs-site.xml

dfs.name.dir/root/hadoop/dfs/namePath on the local filesystem where theNameNode stores the namespace and transactions logs persistently.dfs.data.dir/root/hadoop/dfs/dataComma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.dfs.replication2dfs.permissionsfalseneed not permissions- 修改mapred-site.xml

mapred.job.trackertest1:9001mapred.local.dir/root/hadoop/varmapreduce.framework.nameyarn- 如果没有这个文件的话,把mapred-site.xml.template复制一份改个名字。

- 启动Hadoop

- 第一次启动需要初始化一下,在hadoop的bin目录下执行命令:

- ./hadoop namenode -format

- 启动命令:

- ./start-dfs.sh

- 在这之后会需要你多次输入密码,然后输入yes

- 启动YARN:

- ./start-yarn.sh

- 浏览器中输入地址:http://your ip:8088/cluster

- 至此单机版hadoop安装完成。

1800

1800

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?