论文标题:PaLM-E: An Embodied Multimodal Language Model

论文作者:Danny Driess, Fei Xia, Mehdi S. M. Sajjadi, Corey Lynch, Aakanksha Chowdhery, Brian Ichter, Ayzaan Wahid, Jonathan Tompson, Quan Vuong, Tianhe Yu, Wenlong Huang, Yevgen Chebotar, Pierre Sermanet, Daniel Duckworth, Sergey Levine, Vincent Vanhoucke, Karol Hausman, Marc Toussaint, Klaus Greff, Andy Zeng, Igor Mordatch, Pete Florence

作者单位:Robotics at Google,TU Berlin,Google Research

论文原文:https://arxiv.org/abs/2303.03378

论文出处:ICML 2023

论文被引:247(2023/10/15)

论文代码:https://palm-e.github.io

Abstract

LLMs 已被证明可以执行复杂的任务。然而,要在现实世界中实现通用推理,例如解决机器人问题,就需要解决 grounding 挑战。本文提出了具身语言模型(embodied language models),将真实世界的连续的传感器模态直接纳入语言模型,从而建立词语与感知之间的联系。具身语言模型的输入是多模态句子,这些句子交错了视觉,连续状态估计和文本输入编码。结合预先训练好的LLMs,对这些编码进行端到端训练,以完成多个具身任务,包括顺序机器人操作规划(sequential robotic manipulation planning),VQA和描述(captioning)。评估结果表明,PaLM-E 作为一个单一的大型多模态模型,可以在多个模态上通过多种观测模态完成各种模态推理任务,而且还表现出积极的迁移性:该模型受益于跨互联网规模语言,视觉和视觉语言领域的不同联合训练。最大的模型是 PaLM-E-562B,除了在机器人任务上接受过训练外,还是一个视觉语言通才(visual-language generalist),在 OK-VQA 上的表现达到了最先进水平,并且随着规模的扩大还能保持通才语言能力。

Summary

研究背景

LLMs在现实世界中推理的局限性在于Grounding:虽然在海量文本数据上训练 LLM 可能会产生与物理世界相关的表征,但将这些表征与现实世界中的视觉和物理传感器模态连接起来,对于解决计算机视觉和机器人学中更广泛的基础现实世界问题至关重要。

SayCan 将 LLM 的输出与学习到的机器人策略(robotic policies)和可供性函数(affordance functions)连接起来以做出决策,但其局限性在于 LLM 本身只提供文本输入,这对于许多场景的几何配置非常重要的任务来说是不够的。

最先进的视觉语言模型是在典型的视觉语言任务(如 VQA)中训练出来的,无法直接解决机器人推理任务。

方法介绍

提出了具身语言模型 PaLM-E,直接纳入了来自具身智能体(embodied agent)的传感器模态的连续输入,从而使语言模型本身能够在现实世界中为顺序决策做出更有依据的推断。

- 图像和状态估计等输入信息被嵌入到与语言标记相同的潜在嵌入中,并由基于Transformer的 LLM 的自注意力层以与文本相同的方式进行处理。

- 从预先训练好的 LLM 开始,通过编码器注入连续输入。这些编码器经过端到端训练,以自然文本的形式输出连续的决策,而这些文本可以通过调节低层次策略的方式由具身智能体(embodied agent)进行解释,或者给出具身问题的答案。

本文贡献: - 1)提出并证明了可以通过在多模态大型语言模型的训练中混合具身数据来训练通用的,迁移学习的,多具身决策智能体(multi-embodiment decision-making agent)。

- 2)证明了虽然目前最先进的通用视觉语言模型开箱即用(zero-shot),但并不能很好地解决具身推理问题,而本文的 PaLM-E 是高效具身推理器的通用视觉语言模型。

- 3)在研究如何以最佳方式训练此类模型时,引入了新颖的架构理念,如神经场景表征(neural scene representations)和实体标签多模态标记(entity-labeling multimodal tokens)。

- 4)PaLM-E 作为一种具身推理器(embodied reasoner),也是一种具有定量能力的视觉和语言通才。

- 5)证明了语言模型大小的缩放可实现多模态微调,减少灾难性遗忘(catastrophic forgetting)。

相关工作

1)通用视觉语言建模:整合图像的方法各不相同

- Flamingo 通过一种直接关注单个上下文图像的机制来增强预训练语言模型

- Frozen 通过冻结 LLM 的反向传播来优化视觉编码器参数

- PaLI: A Jointly-Scaled Multilingual Language-Image Model

2)动作输出模型:将视觉和语言输入结合在一起,以实现直接行动预测的目标。下述研究中,语言的作用被描述为任务规范。

- Instruction-driven history-aware policies for robotic manipulations,2022

- Perceiver-Actor: A Multi-Task Transformer for Robotic Manipulation,2022

- BC-Z: Zero-Shot Task Generalization with Robotic Imitation Learning,2022

- Learning Language-Conditioned Robot Behavior from Offline Data and Crowd-Sourced Annotation,2022

- Interactive Language: Talking to Robots in Real Time,2022

- RT-1: Robotics Transformer for Real-World Control at Scale,2022

- VIMA: General Robot Manipulation with Multimodal Prompts,2023

- Gato: A Generalist Agent,2022

3)具身任务规划:以往的研究侧重于理解自然语言目标,而PalLM-E是将自然语言作为规划(planning)表征。LLMs 包含大量关于世界的内化知识,但如果没有 grounding,规划可能无法执行。PaLM-E 经过训练后可直接生成规划,而无需依赖辅助模型进行 grounding。

- 利用 LLM 生成的指令与符合条件的指令集之间的语义相似性:Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents (2022b)

- affordance functions:Do As I Can, Not As I Say: Grounding Language in Robotic Affordances (2022)

- visual feedback:Inner Monologue: Embodied Reasoning through Planning with Language Models (2022)

- generating world models:

- Do embodied agents dream of pixelated sheep?: Embodied decision making using language guided world modelling (2023)

- PIGLeT: Language Grounding Through Neuro-Symbolic Interaction in a 3D World (2021)

- 通过Graph和Map进行规划:

- LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action (2022)

- Visual Language Maps for Robot Navigation (2022)

- 视觉解释:Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents (2023)

- 程序生成:

- Code as Policies: Language Model Programs for Embodied Control (2022)

- ProgPrompt: Generating Situated Robot Task Plans using Large Language Models (2022)

- 向提示注入信息(injecting information into the prompt):Socratic Models: Composing Zero-Shot Multimodal Reasoning with Language (2022)

PaLM-E 以文本形式生成高层次指令,模型能自然而然地以自身预测为条件,并直接利用其参数中蕴含的世界知识。这不仅能实现具身推理,还能实现问题解答。

模型架构

PaLM-E 使用 PaLM (2022) 作为预训练语言模型,并将其应用于具身(Embodied)任务。

PaLM-E 的主要架构思想是将连续,机器人观测信息(如图像,状态估计或其他传感器模态)注入预训练语言模型的语言嵌入空间。具体做法是将连续观察结果编码成一串向量,其维度与语言标记的嵌入空间相同。因此,连续信息将以类似于语言标记的方式注入语言模型。

PaLM-E 是一种仅用于解码器的 LLM,它能根据前缀(prefix)或提示(prompt)自回归地生成文本补全。PaLM-E 是一个生成模型,以多模态句子为输入,生成文本。如果任务只需输出文本即可完成,例如在具身问答或场景描述任务中,那么模型的输出就直接被视为任务的解决方案。如果 PaLM-E 被用来解决一个具身的规划或控制任务,它就会生成为低层次命令(command)创造条件的文本。

PaLM-E 的输入:由文本和(多个)连续观察结果组成。与这些观察结果相对应的多模态标记与文本交错在一起,形成多模态句子(multi-modal sentences)。这种多模态句子的一个例子是:Q: What happened between <img 1> and <img 2>? 其中 <img i> 表示图像的嵌入。

PaLM-E 的输出:由模型自动递归生成的文本,可以是问题的答案,也可以是 PaLM-E 以文本形式生成的,应由机器人执行的决策序列。当PaLM-E受命生成决策或计划时,我们假设存在一个低层次的策略或计划器,可以将这些决策转化为低层次的行动。

PaLM-E 被集成到一个控制环中,机器人通过低层次策略执行其预测决策,从而产生新的观察结果,PaLM-E 能够根据这些观察结果在必要时重新规划。

1)Prefix-decoder-only LLMs

前缀或提示 w1:n 为 LLM 继续预测后续标记 wn+1:L(输入的文本数据)提供了上下文。这通常用于推理,以引导模型的预测。例如,提示可以包含对 LLM 应解决的任务的描述,或类似任务的所需文本补全示例。这里的前缀或提示部分不参与损失函数计算。

2)Token embedding space

标记 wi 是固定词汇(fixed vocabulary) W 的元素,词汇 W 是一个离散的有限集合,它对应于自然语言中的(子)词。在内部,LLM 通过 γ : W → X 将 wi 嵌入一个词标记嵌入空间 X ⊂ Rk,即 pLM(wl|x1:l-1),xi = γ(wi) ∈ Rk。映射 γ 通常表示为大小为 k × |W| 的大型嵌入矩阵,并进行端到端训练。

3)Multi-modal sentences: injection of continuous observations

通过跳过离散标记层,直接将连续观察结果映射到语言嵌入空间 X,可以将图像观察结果等多模态信息注入 LLM。为此,训练一个编码器 φ : O → X q φ : O → \mathcal{X}^q φ:O→Xq,将(连续)观测空间 O 映射到 X 中的 q 多向量序列。然后,这些向量与正常嵌入的文本标记交错(interleaved),形成 LLM 的前缀。这意味着前缀中的每个向量 xi 都是由单词标记嵌入器(word token embedder) γ 或编码器 φi 形成的:

一个观测值 Oj 通常会被编码成多个嵌入向量。可以在前缀的不同位置交错使用不同的编码器 φi,以组合来自不同观测空间的信息等。

4)Input & Scene Representations for Different Sensor Modalities

不同模态到语言空间的映射:为每个编码器 φ : O → X φ : \mathcal{O} → \mathcal{X} φ:O→X 提出了不同的架构选择,以便将相应的模态映射到语言嵌入空间。OSRT(Object Scene Representation Transformer, 2022)是一种不需要真实标签(ground-truth)分割的替代方法:它不依赖关于目标的外部知识,而是通过架构中的归纳偏差以无监督的方式发现目标。

实体参考(Entity Referrals):在很多情况下,场景中的目标都可以通过自然语言的一些独特属性识别出来。但是,也有一些场景中的目标不容易用几个词就能用语言识别出来,例如,如果桌子上有多个颜色相同,位置不同的积木块。对于以目标为中心的表征(OSRT),会对输入提示中与目标相对应的多模态标记(tokens)进行如下标注:Object 1 is <obj_1>... Object j is <obj_j>。这样,PaLM-E 就能在生成的输出句子中通过 obj_1 形式的特殊标记来引用对象。

实验设计

PaLM-E 大多数架构都由三部分组成:编码器

φ

~

\tilde{φ}

φ~,投影器

ψ

ψ

ψ 和 LLM

p

L

M

p_{LM}

pLM。

考虑了三种不同机器人的各种机器人(移动)操纵任务,包括仿真机器人和两个不同的真实机器人。探讨了不同输入表示法的性能,泛化和数据效率。

三个机器人环境(图 1):机器人必须操纵(抓取(grasp)和堆叠(stack))物体的

- 任务和动作规划域(Task and Motion Planning domain,TAMP)

- 桌面操作环境(table-top pushing environment)

- 移动操作域(mobile manipulation domain)

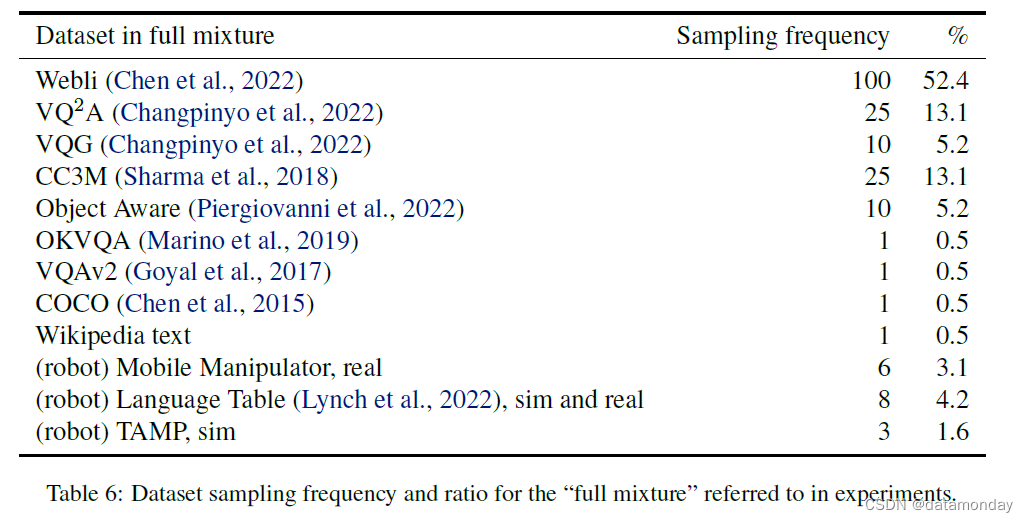

训练数据:研究了在各种不同数据上对模型进行联合训练的效果。“full mixture”,见附录 A,主要由来自不同任务的各种互联网规模的视觉和语言数据组成。采样频率的设置使得full mixture 中只有 8.9% 是具身数据,而且每个具身数据都有多个任务。

模型基线:

- PaLI

- SayCan

实验结果

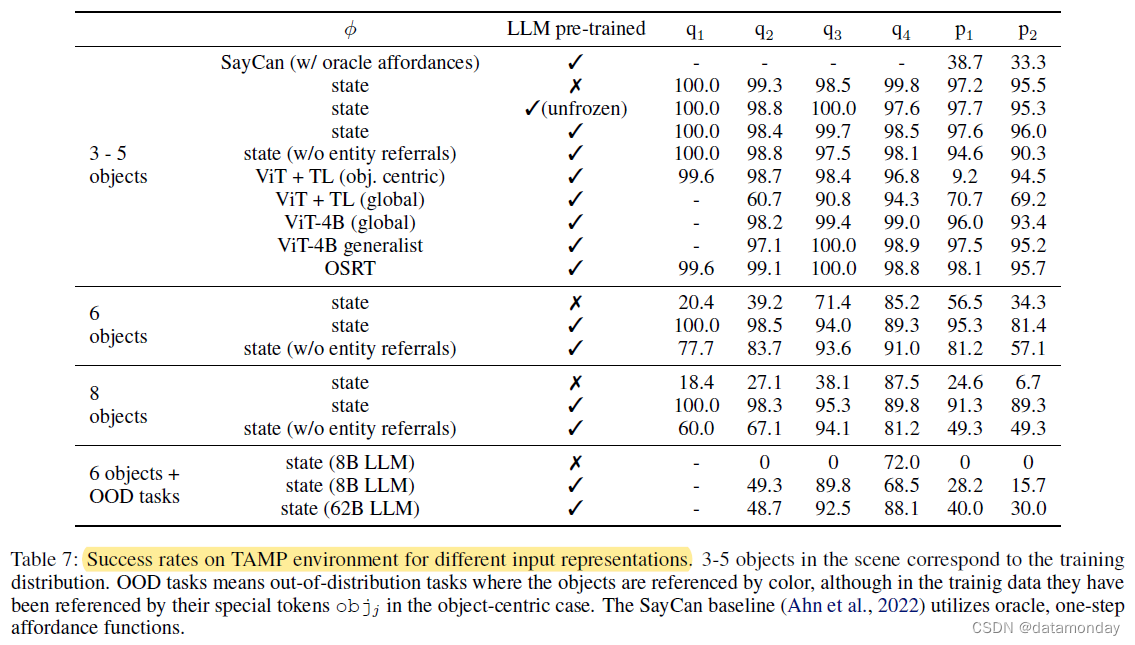

表 7 中的 state 表示状态估计的编码器,本文中使用的是一个 MLP。state(w/o entity referrals) 表示状态估计的编码器,但不使用 Entity Referral 技术。

对于场景中的 3-5 个物体(与训练集中的物体数量相同),大多数输入表征的表现都差不多。然而,当目标数量增加时,使用预先训练好的 LLM 会大大提高性能,尤其是 entity referrals。SayCan 使用的是 affordance functions,在解决这种环境问题时遇到了困难,因为 affordance function 只能限制当前可能发生的事情,但信息量不足以让 LLM 在 TAMP 环境中构建长期计划。

使用 OSRT 作为输入表示法可以获得最佳性能,这证明了三维感知物体表示法的优势。

对互联网尺度的视觉和语言进行联合训练,能为机器人规划提供更有效的模型,尤其是在每个任务只有 10 个演示的小样本情况下。

In the global version, three VQA tasks:

two planning tasks

表 8 报告了 PaLM-E 在自然语言理解(NLU)和自然语言生成(NLG)任务的 21 个通用语言基准上的平均性能。随着模型规模的扩大,语言能力的灾难性遗忘会大大减少。如图 6 所示,最小的模型(PaLM-E-12B)在多模态训练期间有 87.3% 的 NLG 性能(相对值)下降,而最大的模型(PaLM-E-562B)仅有 3.9% 的性能下降。

开放讨论:

在多模态训练过程中保留模型语言能力的两种途径:

- 冻结 LLM,只训练输入编码器,这是建立具身语言模型的可行途径,尽管这种方法在机器人任务中偶尔会遇到困难

- 对整个模型进行端到端训练,随着模型规模的扩大,模型的原始语言性能会得到显著提高

实验结论

- 建议将图像等多模态信息注入预先训练好的 LLM 的嵌入空间,从而建立一个具身语言模型。

- PaLM-E 是一种能够在模拟和现实世界中控制不同机器人的单一模型,同时还能定量地胜任一般的 VQA 和图像描述任务。特别是将神经场景表征( OSRT)纳入模型的新颖架构理念,即使没有大规模数据,也特别有效。

- PaLM-E 是在多种机器人的不同任务以及一般视觉语言任务的混合物上进行训练的。这种多样化的训练可以将视觉语言领域的知识迁移到具身决策中,从而使机器人规划任务能够高效地实现

- 冻结语言模型是实现完全保留语言能力的通用型多模态模型的可行途径,另一条使用非冻结模型的途径:扩大语言模型的规模可显著减少灾难性遗忘

- PaLM-E-562B 展示了新出现的能力,如多模态思维链推理,以及对多幅图像进行推理的能力,尽管它只接受过单图像提示的训练

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?