前言:

这些天接触到了Seq2seq模型,然后遇到了一个国外的大神讲解这个模型,十分的通俗易懂,特意分享给大家,也会添加一些个人见解。

简介:

Seq2seq模型现在已经在机器翻译、文本摘要和图像解释方面取得了很大的成功。谷歌翻译在2016年使用这个模型。Seq2seq模型的输入是序列化数据(比如单词、信件内容、图片特征等),输出也是序列化数据。

模型训练过程如下所示:

知乎视频www.zhihu.com在机器翻译的网络中,输入序列是一串单词,一个接着一个进行输入,输出也是一系列单词,过程如下:

知乎视频www.zhihu.com揭秘Seq2seq内部

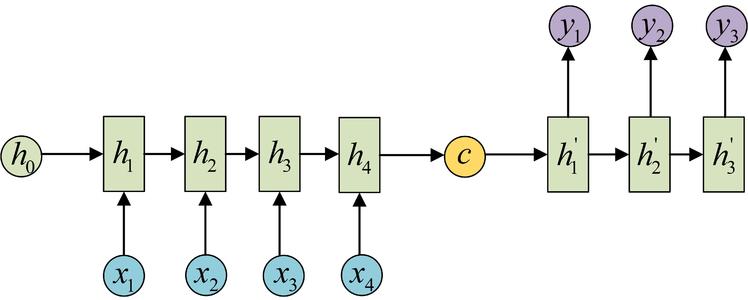

Seq2seq是由 encoder和decoder两个部分组成。

encoder对输入的内容进行处理,然后输出成一个向量,称为context, 在经过encoder之后生成的contenxt会被送到decoder部分,decoder会接收context然后产生输出序列。整体过

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1077

1077

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?