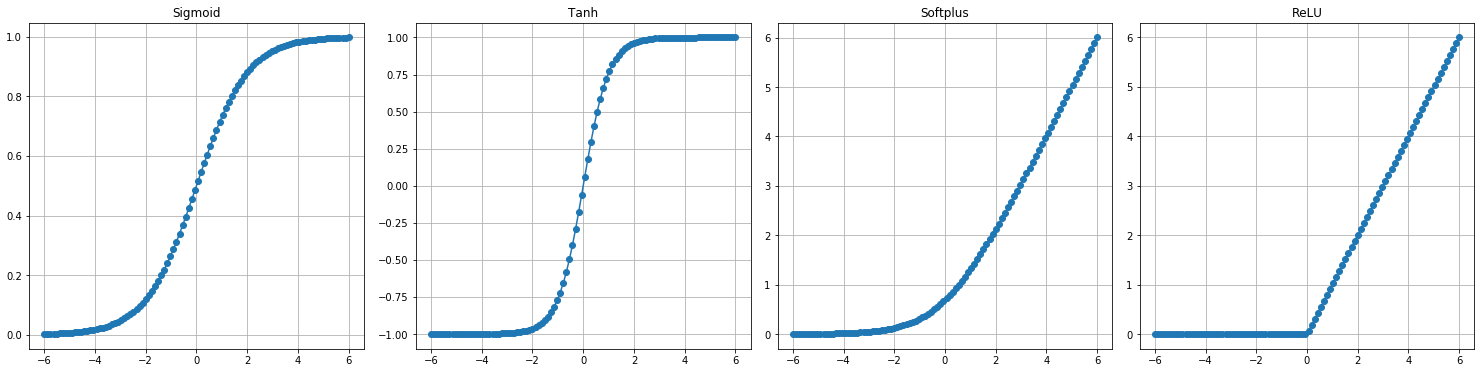

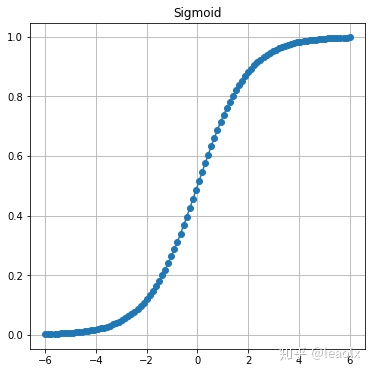

Sigmoid() function:

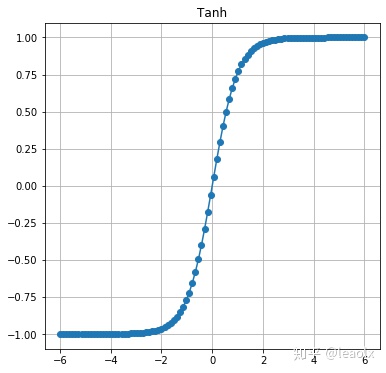

Tanh() function:

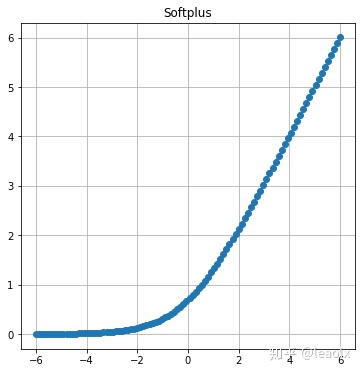

Softplus() function:

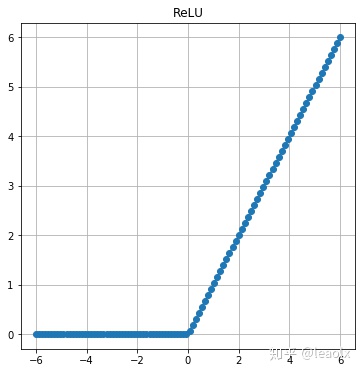

ReLU() function:

# -*- coding: utf-8 -*-

"""

Created on Fri Jul 10 11:27:42 2020

@author: Leao

"""

import torch

import matplotlib.pyplot as plt

#%%

# Sigmoid() 函数

x = torch.linspace(-6, 6, 100)

sigmoid = nn.Sigmoid() # 从nn模块中调入Sigmoid()层,在nn.functional中有对应的函数

y_sigmoid = sigmoid(x)

# Visualize

plt.figure(figsize=(6, 6))

plt.plot(x.data.numpy(), y_sigmoid.data.numpy(), "o-")

plt.title("Sigmoid")

plt.grid()

#%%

# Tanh() 函数

x = torch.linspace(-6, 6, 100)

tanh = nn.Tanh() # 从nn模块中调入Tanh()层,在nn.functional中有对应的函数

y_Tanh = tanh(x)

# Visualize

plt.figure(figsize=(6, 6))

plt.plot(x.data.numpy(), y_Tanh.data.numpy(), "o-")

plt.title("Tanh")

plt.grid()

#%%

# Softplus() 函数

x = torch.linspace(-6, 6, 100)

softplus = nn.Softplus() # 从nn模块中调入Tanh()层,在nn.functional中有对应的函数

y_softplus = softplus(x)

# Visualize

plt.figure(figsize=(6, 6))

plt.plot(x.data.numpy(), y_softplus.data.numpy(), "o-")

plt.title("Softplus")

plt.grid()

#%%

# ReLU() 函数

x = torch.linspace(-6, 6, 100)

relu = nn.ReLU() # 从nn模块中调入Tanh()层,在nn.functional中有对应的函数

y_relu = relu(x)

# Visualize

plt.figure(figsize=(6, 6))

plt.plot(x.data.numpy(), y_relu.data.numpy(), "o-")

plt.title("ReLU")

plt.grid()

2799

2799

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?