<think>好的,我现在需要解决用户的问题:如何基于给定的语料库使用bigram模型计算语言序列“ababb”的概率。首先,我得回忆一下bigram模型的基本概念。Bigram模型是基于马尔可夫假设,认为一个词的出现概率只依赖于前一个词,所以计算整个序列的概率需要将各个相邻二元组的条件概率相乘。

接下来,用户需要的是具体步骤,所以我要分步骤解释。首先,应该处理语料库,统计所有bigram的出现次数以及每个词的单现次数。然后,根据这些统计结果计算每个bigram的条件概率,也就是P(w_i | w_{i-1}) = count(w_{i-1}, w_i) / count(w_{i-1})。

但是这里用户给的序列是“ababb”,看起来像是字符级别的bigram,而不是词语级别的。因此,我需要确认处理的是字符序列,每个字符作为单位。例如,序列分解成bigrams就是:a→b, b→a, a→b, b→b。

然后,我需要确保用户提供的语料库中包含这些bigram的信息。假设用户有一个语料库,比如一段文本,里面包含了这些字符的出现情况。例如,如果语料库中有多次出现a后面跟b的情况,那么对应的条件概率就会高。

不过,用户没有给出具体的语料库内容,所以在回答时需要说明,计算过程依赖于语料库中的统计结果。可能需要用户自己统计或者假设存在某个语料库。

另外,需要注意起始和结束符号的处理。通常在自然语言处理中,会在句子的开头添加<s>,结尾添加</s>,但对于字符级别的模型,可能不需要,或者根据具体情况处理。这里用户的问题中没有提到,可能不需要添加,直接处理原始序列即可。

然后,具体到计算序列“ababb”的概率,需要分解成各个bigram。起始是第一个字符a,作为初始状态,可能需要考虑其单独出现的概率,或者假设有一个起始符号。但如果没有的话,可能只需要从第一个字符开始计算后面的条件概率。例如,序列分解为:a, b, a, b, b。对应的bigrams是(a,b), (b,a), (a,b), (b,b)。所以整个序列的概率是P(a) * P(b|a) * P(a|b) * P(b|a) * P(b|b)。不过,通常计算序列概率时,如果是从第一个词开始,可能需要起始概率,比如P(a)乘以后续的条件概率。或者,在bigram模型中,有时会假设有一个起始符号,所以整个序列的概率是P(a|<s>) * P(b|a) * P(a|b) * P(b|a) * P(b|b)。但这里用户的问题可能没有考虑起始符号,所以需要确认。

不过,根据常见的bigram模型处理方式,起始符号会影响第一个元素的概率。例如,序列的开始可以视为有一个起始符号,那么第一个元素的条件概率是基于起始符号的。但如果是字符级别的,可能不需要,特别是如果语料库中没有这样的标记的话。这种情况下,可能需要使用单个字符的概率作为初始概率。比如,P(a)作为第一个字符的概率,然后后续的条件概率依次相乘。但严格来说,bigram模型通常是条件概率的连乘,即从第二个字符开始每个字符的条件概率。例如,对于序列w1, w2, w3, ..., wn,概率是P(w1) * P(w2|w1) * P(w3|w2) * ... * P(wn|wn-1)。但有时候,如果模型考虑了起始符号,那么P(w1)会被视为P(w1|<s>),而起始符号的出现概率可能被视为1,或者需要单独处理。

不过,在用户的问题中,可能需要简化处理,即假设序列的起始没有特殊符号,所以整个概率是各个bigram条件概率的乘积,其中第一个bigram是起始字符到第二个字符的条件概率,但起始字符的单现概率可能需要单独计算。这里可能存在不同的处理方式,容易混淆。例如,对于序列长度为n,会有n-1个bigrams。因此,对于“ababb”这个长度为5的序列,分解成四个bigrams:a→b, b→a, a→b, b→b。所以概率应该是P(a) * P(b|a) * P(a|b) * P(b|a) * P(b|b)?或者是不是?这里可能需要澄清:通常,bigram模型的概率计算是从第二个字符开始的条件概率,所以对于序列w1, w2, w3, w4, w5,概率是P(w1) * P(w2|w1) * P(w3|w2) * P(w4|w3) * P(w5|w4)。但这样的话,如果起始概率P(w1)是作为单独的单现概率,而后续的条件概率是每个bigram的条件概率。例如,对于序列a b a b b,总概率是P(a) × P(b|a) × P(a|b) × P(b|a) × P(b|b)。但这样的话,序列长度为5,需要四个bigram条件概率,但这里怎么有五个因子?这可能有问题。或者,正确的处理方式应该是,对于长度为n的序列,有n-1个条件概率,因此总概率是P(w1) × P(w2|w1) × P(w3|w2) × ... × P(wn|w_{n-1})。例如,对于五个字符,总共有四个条件概率,所以总概率是四个条件概率乘以第一个字符的概率?或者,是否第一个字符的概率也被视为条件概率?

这里可能存在不同的定义方式。例如,有些资料中,bigram模型计算序列的概率是从第一个词开始的,即P(w1)是初始概率,然后每个后续词的条件概率。例如,在Jurafsky的《Speech and Language Processing》中,bigram模型的计算方式是:

P(w1, w2, ..., wn) = P(w1) × P(w2|w1) × P(w3|w2) × ... × P(wn|w_{n-1})

因此,对于长度为n的序列,总共有n项相乘,其中第一个是单现概率,后面n-1个是条件概率。因此,对于“ababb”这个五个字符的序列,分解为:

P(a) × P(b|a) × P(a|b) × P(b|a) × P(b|b)

所以总共有五个因子,其中第一个是单现概率,后面四个是条件概率。

但另一种情况是,当在序列的开始添加一个起始符号<s>,此时整个概率的计算变成:

P(a|<s>) × P(b|a) × P(a|b) × P(b|a) × P(b|b)

这种情况下,起始符号的条件概率被包含进来,而无需单独计算P(a)。所以具体处理方式取决于是否添加起始符号。

用户的问题中没有提到起始符号,所以可能需要假设不使用起始符号,直接计算P(a)作为初始概率,然后后面的条件概率。因此,正确的步骤是:

1. 统计语料库中每个字符的出现次数,以及每个bigram的出现次数。

例如,假设语料库中的内容为某个文本,统计所有字符的单现次数,以及每两个连续字符的出现次数。

2. 计算每个字符的概率P(w_i),即该字符的出现次数除以语料库总字符数。

不过,在bigram模型中,通常处理的是条件概率,而初始的P(w1)可能需要根据整个语料库来计算,或者如果有起始符号则处理为条件概率。但如果没有起始符号,那么可能需要计算第一个字符的单现概率,例如P(a) = count(a) / total_characters。

不过,在大多数情况下,bigram模型的条件概率是从第二个字符开始的,因此初始概率可能需要单独处理。例如,如果序列是“ababb”,那么第一个字符a的概率是P(a) = count(a) / total_chars_in_corpus,而后续的每个条件概率是count(prev, current) / count(prev)。

因此,整个序列的概率是:

P(a) × P(b|a) × P(a|b) × P(b|a) × P(b|b)

现在,需要将这些具体的数值代入,但用户没有给出具体的语料库,所以只能给出计算的步骤。因此,回答需要详细说明每一步怎么做,并给出公式,例如使用LaTeX表示。

接下来,还要考虑数据平滑的问题,比如遇到未登录词或bigram的情况如何处理。如果语料库中没有某个bigram,比如(b,b),那么概率可能为零,导致整个序列的概率为零。因此,可能需要使用平滑方法,如拉普拉斯平滑。但用户的问题可能希望基于最大似然估计,即不进行平滑,直接使用观察到的频率。但需要指出这一点,如果语料库中存在零概率的bigram,如何处理。

不过,用户的问题可能希望按照最大似然估计来计算,所以步骤中不需要考虑平滑,但需要提醒用户注意这一点。

总结步骤:

1. 预处理语料库,统计每个字符的出现次数和每个bigram的出现次数。

2. 计算每个字符的概率:P(char) = count(char) / total_chars。

3. 计算每个bigram的条件概率:P(current | previous) = count(previous, current) / count(previous)。

4. 将序列分解为字符和对应的bigrams。

5. 将对应的概率相乘得到整个序列的概率。

例如,对于序列“ababb”:

分解为字符:a, b, a, b, b

对应的bigrams:a→b, b→a, a→b, b→b

初始概率:P(a)

然后条件概率依次为:P(b|a), P(a|b), P(b|a), P(b|b)

总概率 = P(a) × P(b|a) × P(a|b) × P(b|a) × P(b|b)

但需要确认是否应该包括初始的P(a)。例如,在有些情况下,整个序列的概率只计算条件概率的乘积,但起始词的概率可能需要视为基于某个起始状态。不过,根据常见的bigram模型定义,起始词的概率可能也需要被单独计算,尤其是当模型没有起始符号时。

例如,在自然语言处理中,通常句子有起始符号,所以第一个词的概率是P(w1|<s>),而如果没有,则可能直接计算P(w1)作为初始概率。因此,在用户的问题中,假设没有起始符号,所以序列的概率是初始字符的单现概率乘以之后每个条件概率。

另外,如果用户的问题是字符级别的,比如字母a、b组成的序列,那么语料库可能由这些字符构成,需要统计每个字符和bigram的出现次数。

例如,假设语料库中的内容为“ababba”,那么分解字符和bigrams:

字符:a, b, a, b, b, a

bigrams: a→b, b→a, a→b, b→b, b→a

此时,单现次数:

a出现了3次,b出现了3次,总字符数6次。

bigram次数:

a→b出现2次(因为a后面跟b在第1和第3位)

b→a出现2次(第2和第5位)

b→b出现1次(第4位)

然后,计算各个概率:

P(a) = 3/6 = 0.5

P(b|a) = count(a,b)/count(a) = 2/3

P(a|b) = count(b,a)/count(b) = 2/3 (因为count(b)是3次,因为b出现在位置1、3、4,所以当计算count(b)作为前一个词时,是三次吗?比如,在序列中,每个位置作为前一个词的话,前五个bigrams的前词是位置1到5的字符,所以总共有5个前词。例如,在“ababba”中,前词是 a, b, a, b, b,因此count(b)作为前词出现的次数是3次(位置2、4、5?或者原序列是长度6,所以bigrams是5个:1-2, 2-3, 3-4, 4-5, 5-6。那么前词是位置1到5的字符。例如,前词是a(位置1)、b(位置2)、a(位置3)、b(位置4)、b(位置5)。因此,count(b)作为前词出现的次数是3次(位置2、4、5)。在bigrams中,前词为b的情况有3次,对应的bigrams是 b→a(位置2)、b→b(位置4)、b→a(位置5)。所以count(b)作为前词的总次数是3次,而其中count(b→a)是2次,count(b→b)是1次。因此,P(a|b)= count(b,a)/count(b) = 2/3,P(b|b)=1/3。

假设用户提供的语料库如上,那么对于序列“ababb”,分解为:

a → b → a → b → b

对应的bigrams:a→b, b→a, a→b, b→b

初始字符a的概率是P(a)=3/6=0.5

然后:

P(b|a)=2/3

P(a|b)=2/3

P(b|a)=2/3

P(b|b)=1/3

所以总概率=0.5 × (2/3) × (2/3) × (2/3) × (1/3) = 0.5 × (8/81) = 4/81 ≈0.0494

不过,这只是一个例子,用户的实际结果取决于他们的语料库统计数据。

最后,在回答中需要指出,具体数值需要根据实际语料库的统计结果计算,并给出公式化的步骤,以及可能的例子。同时,提醒用户注意未登录词的问题,可能需要平滑处理。</think>要基于给定语料库使用 bigram 模型计算序列“ababb”的概率,需按以下步骤操作:

---

### 1. **语料库预处理**

统计语料库中:

- 所有**单字符出现次数**:记 $C(w_i)$ 为字符 $w_i$ 的总出现次数

- 所有**bigram 出现次数**:记 $C(w_{i-1}, w_i)$ 为连续字符对 $(w_{i-1}, w_i)$ 的总出现次数

例如,若语料库为 `ababba`,则统计结果如下:

- 单字符:$C(a)=3$, $C(b)=3$

- bigram:$C(a,b)=2$, $C(b,a)=2$, $C(b,b)=1$[^1]

---

### 2. **计算条件概率**

Bigram 条件概率公式为:

$$ P(w_i | w_{i-1}) = \frac{C(w_{i-1}, w_i)}{C(w_{i-1})} $$

以上述语料库为例:

- $P(b|a) = \frac{C(a,b)}{C(a)} = \frac{2}{3}$

- $P(a|b) = \frac{C(b,a)}{C(b)} = \frac{2}{3}$

- $P(b|b) = \frac{C(b,b)}{C(b)} = \frac{1}{3}$

---

### 3. **分解目标序列**

将序列“ababb”分解为字符和对应的 bigram:

- 字符序列:$a \rightarrow b \rightarrow a \rightarrow b \rightarrow b$

- Bigram 序列:$(a,b)$, $(b,a)$, $(a,b)$, $(b,b)$

---

### 4. **计算序列概率**

序列概率公式为:

$$ P(a,b,a,b,b) = P(a) \cdot P(b|a) \cdot P(a|b) \cdot P(b|a) \cdot P(b|b) $$

代入示例语料库的统计结果:

$$ P(a,b,a,b,b) = \frac{3}{6} \cdot \frac{2}{3} \cdot \frac{2}{3} \cdot \frac{2}{3} \cdot \frac{1}{3} = \frac{4}{81} \approx 0.0494 $$

---

### 5. **处理未登录词/未登录 bigram**

若语料库中未出现某些字符或 bigram(如 $C(w_{i-1})=0$),需使用**平滑技术**(如拉普拉斯平滑):

$$ P(w_i | w_{i-1}) = \frac{C(w_{i-1}, w_i) + 1}{C(w_{i-1}) + V} $$

其中 $V$ 为语料库的字符表大小[^1]。

---

小学写字课课练

小学写字课课练

”哟

”哟

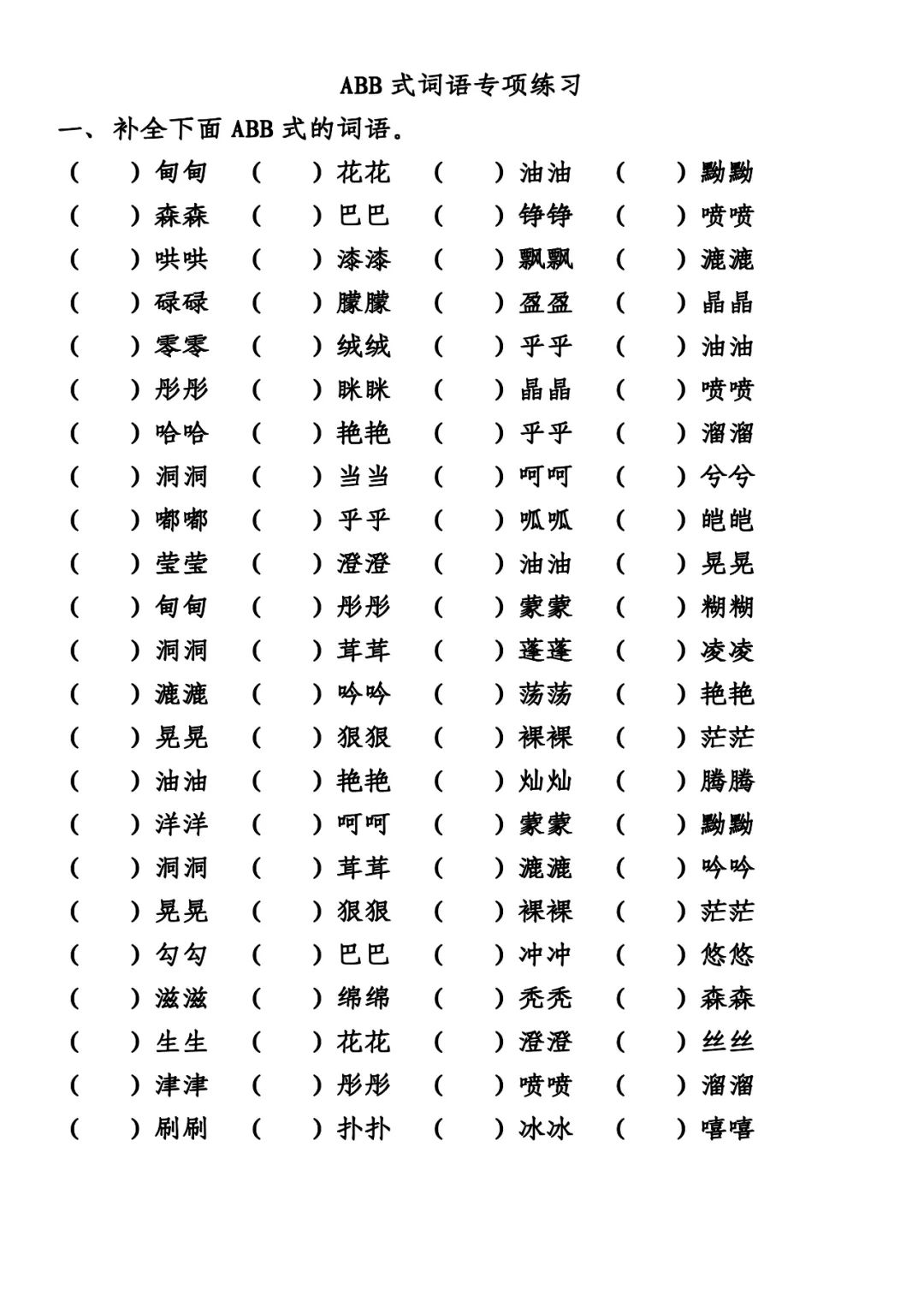

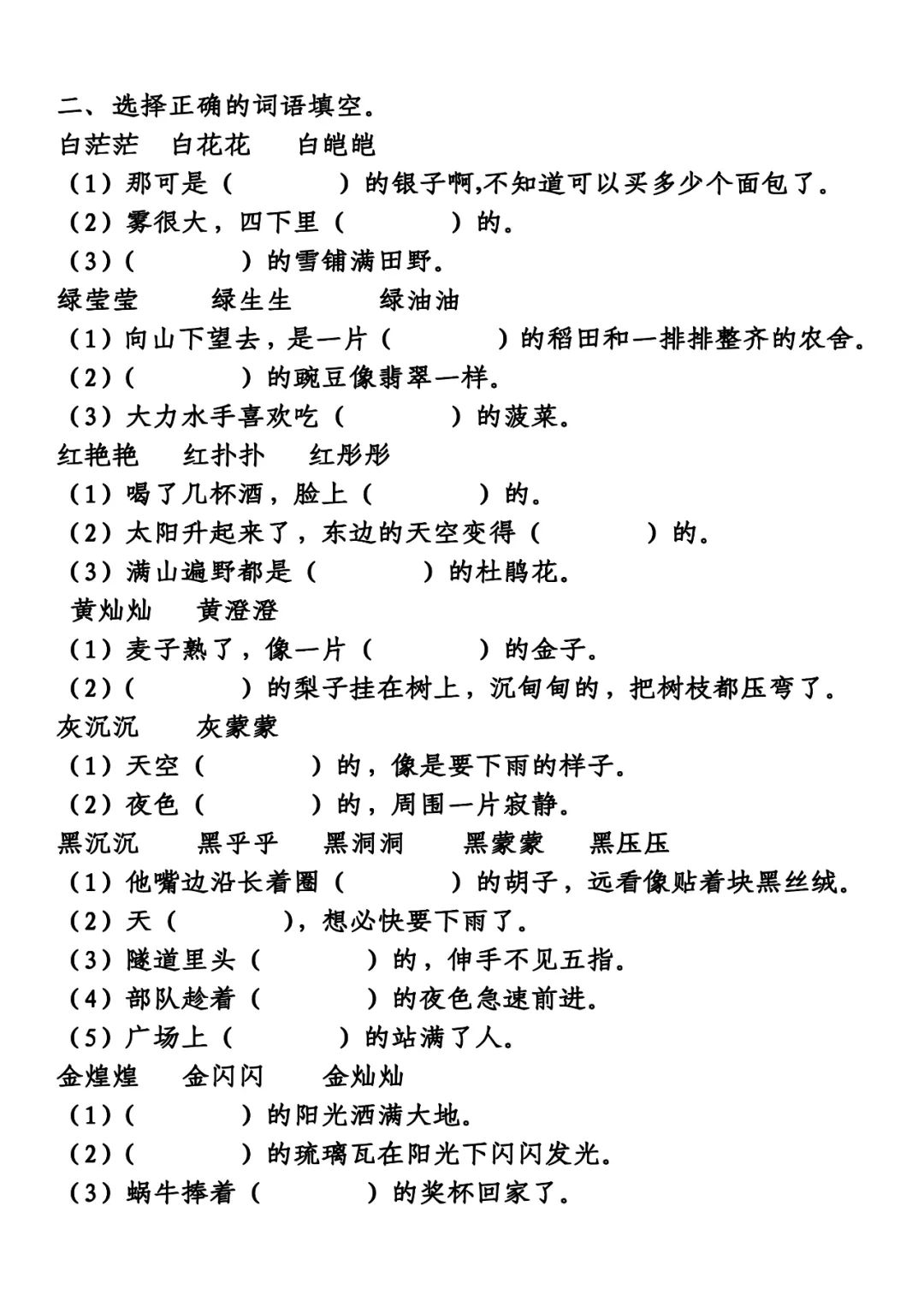

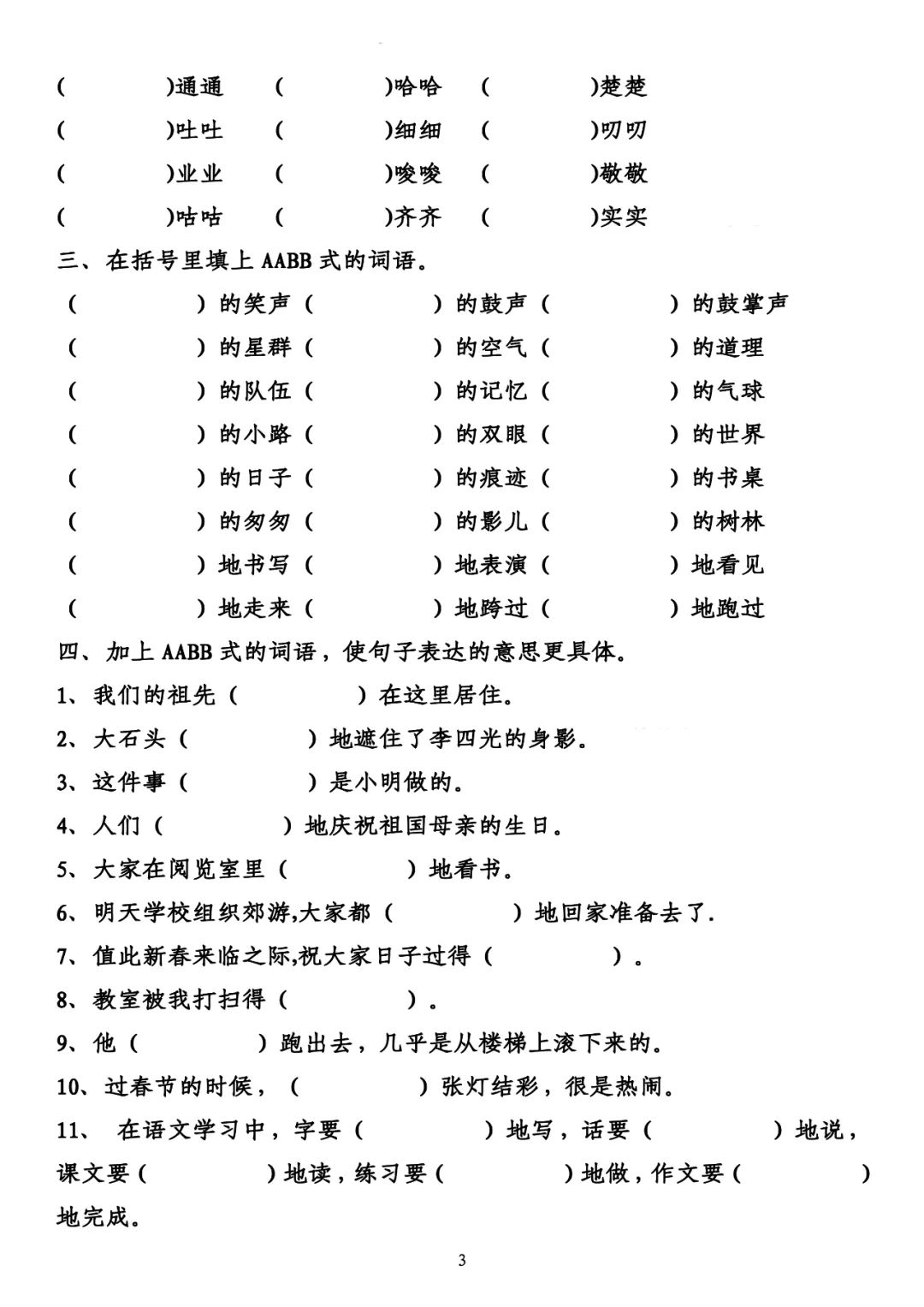

为帮助孩子掌握ABB式词语,本文提供了专项练习题,包括理解词语、运用修饰和造句,适合一年级学生。可下载电子版及答案,助力孩子的语文学习。

为帮助孩子掌握ABB式词语,本文提供了专项练习题,包括理解词语、运用修饰和造句,适合一年级学生。可下载电子版及答案,助力孩子的语文学习。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?